现有的方法通过利用视觉-语言模型(

VLMs)(如CLIP)强大的开放词汇识别能力来增强开放词汇目标检测,然而出现了两个主要挑战:(1)概念表示不足,CLIP文本空间中的类别名称缺乏文本和视觉知识。(2)对基础类别的过拟合倾向,在从VLMs到检测器的转移过程中,开放词汇知识偏向于基础类别。为了解决这些挑战,论文提出了语言模型指令(

LaMI)策略,该策略利用视觉概念之间的关系,并将其应用于一种简单而有效的类似DETR的检测器,称为LaMI-DETR。LaMI利用GPT构建视觉概念,并使用T5研究类别之间的视觉相似性。类别之间的这些关系改善了概念表示,避免了对基础类别的过拟合。全面的实验验证了该方法在相同严格设置下的优越性能,不依赖于外部训练资源。来源:晓飞的算法工程笔记 公众号,转载请注明出处

论文: LaMI-DETR: Open-Vocabulary Detection with Language Model Instruction

Introduction

开放词汇目标检测(OVOD)旨在识别和定位来自广泛类别的物体,包括在推理过程中的基础类别和新类别,即使仅在有限的基础类别上进行训练。现有的开放词汇目标检测研究主要集中在检测器内部复杂模块的开发,这些模块旨在有效地将视觉-语言模型(VLMs)固有的零样本和少样本学习能力用于目标检测的上下文。

然而,大多数现有方法中存在两个挑战:(1)概念表示。大多数现有方法使用来自CLIP文本编码器的名称嵌入来表示概念。然而,这种概念表示方法在捕捉类别之间的文本和视觉语义相似性方面存在局限性,这种相似性有助于区分视觉上容易混淆的类别并探索潜在的新对象;(2)对基础类别的过拟合。尽管VLMs在新类别上表现良好,但开放词汇检测器的优化仅使用基础检测数据,导致检测器对基础类别的过拟合。因此,新对象容易被视为背景或基础类别。

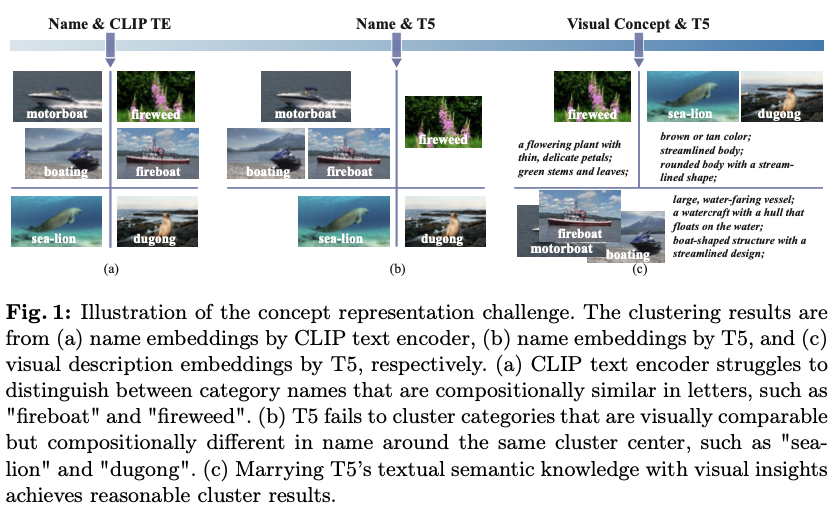

首先,是概念表示的问题。CLIP文本空间中的类别名称在文本深度和视觉信息方面都存在不足。(1) 与语言模型相比,VLM的文本编码器缺乏文本语义知识。如图1a所示,仅依赖于来自CLIP的名称表示会集中于字母组成的相似性,忽视了语言背后的层次性和常识理解。这种方法对分类聚类不利,因为它未能考虑类别之间的概念关系。(2) 基于抽象类别名称或定义的现有概念表示未能考虑视觉特征。图1b展示了这个问题,尽管海狮和儒艮在视觉上相似,但它们被分配到了不同的聚类中。仅用类别名称表示概念忽视了语言所提供的丰富视觉语境,这可能有助于发现潜在的新对象。

其次,是对基础类别的过拟合问题。为充分利用VLM的开放词汇能力,采用一个冻结的CLIP图像编码器作为主干网络,并利用来自CLIP文本编码器的类别嵌入作为分类权重。论文认为,检测器训练应发挥两个主要功能:首先,区分前景和背景;其次,保持CLIP的开放词汇分类能力。然而,仅在基础类别注释上进行训练,而不结合额外策略,往往导致过拟合:新对象常常被错误分类为背景或基础类别。

探索类别之间关系是解决上述挑战的关键。通过培养对这些关系的细致理解,可以开发一种结合文本和视觉语义的概念表示方法。这种方法还可以识别视觉上相似的类别,引导模型更专注于学习通用的前景特征,从而防止对基础类别的过拟合。因此,论文提出了LaMI-DETR(Frozen CLIP-based DETR with Language Model Instruction),这是一种简单但有效的基于DETR的检测器,利用语言模型的见解提取类别间关系来解决上述挑战。

为了解决概念表示的问题,首先采用Instructor Embedding,一种T5语言模型,重新评估类别的相似性。与CLIP文本编码器相比,语言模型展现出更为细致的语义空间。如图1b所示,“fireweed”(火绒草)和“fireboat”(消防船)被分类到不同的簇中,更加贴近人类的识别方式。接下来,引入GPT-3.5为每个类别生成视觉描述。这包括对形状、颜色和大小等方面的详细描述,有效地将这些类别转换为视觉概念。图1c显示,在相似的视觉描述下,海狮和儒艮现在被归为同一簇。

为了减轻过拟合问题,根据T5的视觉描述嵌入将视觉概念聚类成组。这个聚类结果使得在每次迭代中能够识别和抽样与真实类别在视觉上不同的负类。这放宽了分类的优化,集中模型的注意力于推导更为通用的前景特征,而不是过拟合到基础类别。因此,这种方法通过减少对基础类别的过训练增强了模型的泛化能力,同时保留了CLIP图像骨干的分类能力。

总之,论文提出了一种新颖的方法LaMI,以增强OVOD中的基础到新类别的泛化能力。LaMI利用大型语言模型提取类别之间的关系,并利用这些信息抽样简单的负类,以避免对基础类别的过拟合,同时优化概念表示,以实现视觉上相似类别之间的有效分类。论文提出了一个简单但有效的端到端LaMI-DETR框架,能够有效地将开放词汇知识从预训练的VLM转移到检测器上。通过在大词汇OVOD基准上进行严格测试,展示了LaMI-DETR框架的优越性,包括在OV-LVIS上提升 + 7.8 +7.8 +7.8 AP r _\textrm{r} r 和在VG-dedup上提升 + 2.9 +2.9 +2.9 AP r _\textrm{r} r (与OWL进行公平比较)。

Method

Preliminaries

给定一个输入的图像 I ∈ R H × W × 3 \mathbf{I} \in \mathbb{R}^{H \times W \times 3} I∈RH×W×3 到开放词汇对象检测器,通常会生成两个主要输出:(1)分类,其中为图像中第 j th j^{\text{th}} jth 预测对象分配一个类别标签 c j ∈ C test c_j \in \mathcal{C}_{\text{test}} cj∈Ctest , C test \mathcal{C}_{\text{test}} Ctest 表示在推理过程中针对的类别集合。(2)定位,包括确定边界框坐标 b j ∈ R 4 \mathbf{b}_j \in \mathbb{R}^4 bj∈R4 ,以识别第 j th j^{\text{th}} jth 预测对象的位置。遵循OVR-CNN建立的框架,定义了一个检测数据集 D det \mathcal{D}_{\text{det}} Ddet ,该数据集包含边界框坐标、类别标签及对应的图像,用于处理类别词汇 C det \mathcal{C}_{\text{det}} Cdet 。

遵循OVOD的惯例,将 C test \mathcal{C}_{\text{test}} Ctest 和 C det \mathcal{C}_{\text{det}} Cdet 的类别空间分别表示为 C \mathcal{C} C 和 C B \mathcal{C}_{\text{B}} CB 。通常情况下, C B ⊂ C \mathcal{C}_{\text{B}} \subset \mathcal{C} CB⊂C 。 C B \mathcal{C}_{\text{B}} CB 中的类别被称为基础类别,而仅出现在 C test \mathcal{C}_{\text{test}} Ctest 中的类别则被称为新类别。新类别的集合表示为 C N = C ∖ C B ≠ ∅ \mathcal{C}_{\text{N}} = \mathcal{C} \setminus \mathcal{C}_{\text{B}} \neq \varnothing CN=C∖CB

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

75

75

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?