基于自编码器的数据异常检测技术详解

引言

在现代数据分析领域,异常检测是一项至关重要的任务,特别是在处理高维度数据时。本文将详细介绍一种基于深度学习的异常检测方法——自编码器(Autoencoder)及其在数据分析中的实际应用。自编码器凭借其强大的非线性特征提取能力,能够有效识别复杂数据集中的异常样本,为各类分析应用提供了可靠的数据质量保障机制。

自编码器原理

自编码器是一种无监督学习神经网络,其核心思想是通过学习将输入数据压缩(编码)后再重建(解码),使重建后的输出尽可能接近原始输入。在这个过程中,网络被迫学习数据的最重要特征,形成一种有效的数据表示。

自编码器由两个主要部分组成:

- 编码器(Encoder):将高维输入数据压缩到低维潜在空间

- 解码器(Decoder):尝试从低维表示重建原始高维数据

当应用于异常检测时,自编码器利用了一个关键假设:异常样本的特征模式与正常样本有显著差异,因此在用主要由正常样本训练的模型进行重建时,会产生较大的重建误差。

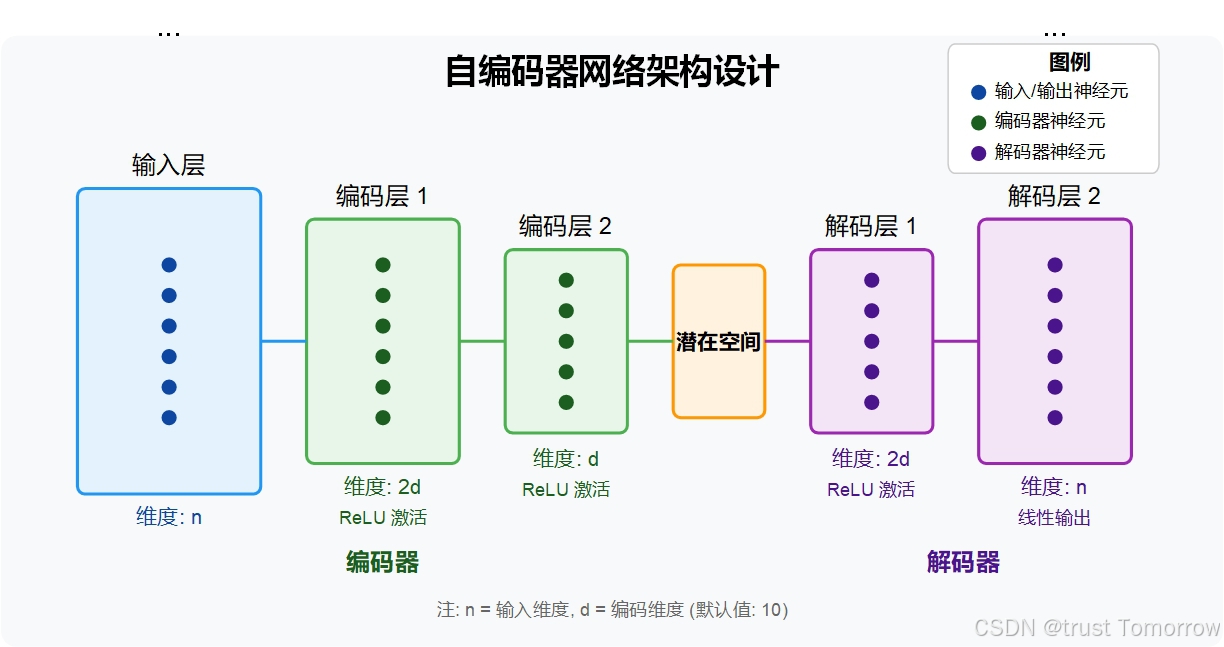

网络架构设计

我们实现的自编码器采用了对称设计,具有以下结构:

具体层次结构如下:

- 输入层:接收原始数据向量(维度根据数据而定)

- 编码器第一层:线性变换至编码维度的两倍,并应用ReLU激活函数

- 编码器第二层:将数据压缩至指定的编码维度(默认为10),并应用ReLU激活函数

- 解码器第一层:从编码维度扩展至两倍编码维度,并应用ReLU激活函数

- 输出层:重建至原始输入维度

这种对称设计使得网络既能够有效地压缩数据,又能保留足够的信息用于重建。

代码实现

以下是使用PyTorch框架实现的自编码器类:

class Autoencoder(nn.Module):

def __init__(self, input_dim, encoding_dim):

super(Autoencoder, self).__init__()

# 编码器层

self.encoder = nn.Sequential(

nn.Linear(input_dim, encoding_dim * 2),

nn.ReLU(True),

nn.Linear(encoding_dim * 2, encoding_dim),

nn.ReLU(True),

)

# 解码器层

self.decoder = nn.Sequential(

nn.Linear(encoding_dim, encoding_dim * 2),

nn.ReLU(True),

nn.Linear(encoding_dim * 2, input_dim),

)

def forward(self, x):

x = self.encoder(x)

x = self.decoder(x)

return x

这个实现具有几个关键特点:

- 使用

nn.Sequential简化了网络结构定义 - 采用

nn.Linear层进行线性变换 - 在每个中间层后使用

nn.ReLU作为激活函数,引入非线性能力 - 输出层不使用激活函数,以便能够产生与输入范围匹配的值

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1386

1386

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?