Abstract

ANN的参数在训练阶段对数据集中学习,在部署和召回阶段对新数据进行冻结和静态使用,为了适应在数据分配的改变,ANN必须重新训练全部的数据集来避免灾难性遗忘

在研究中,作者引入了智能突触将生物的复杂性带到人工智能神经网络中

避免灾难性遗忘的方法

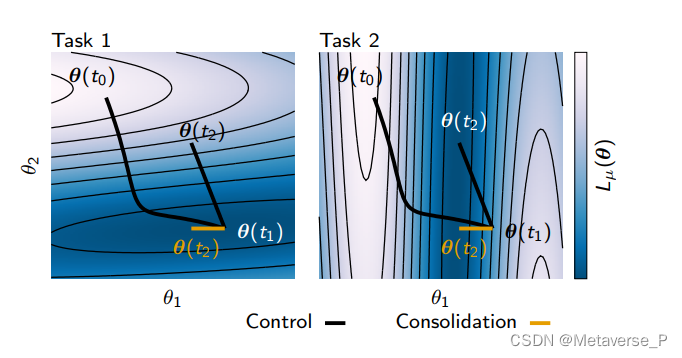

通过巩固重要的突触来预防他们在未来任务中的改变 ,因此对于新任务的学习由那些对过去不太重要的突触所介导,从而避免额对过去任务的灾难性遗忘

为了解决神经网络持续学习的问题,我们试图构建了一个结构化的正则器,它可以在线计算并在每个突触处局部实现

引进了一种在线的方法,通过整合对解决过去任务很重要的参数变化来避免灾难性遗忘,同时只允许不重要的参数学习解决新的新的任务

Conclusion

EWC 和 SI 是比较经典的计算网络参数不同重要性的方法,具体来说:

- EWC 通过估计 Fisher Information Matrix 的对角线值来计算参数重要性。

- SI 估计损失函数对于参数的敏感性来计算参数重要性。

正则化惩罚与EWC类似,不同的是,他们以现在的方法和参数空间中的整个学习轨迹计算每个突触的整合强度,而EWC是指定任务的最小损失Fisher离线计算

961

961

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?