ROC曲线(Receiver Operating Characteeristic Curve)是显示Classification模型真正率和假正率之间折中的一种图形化方法。

解读ROC图的一些概念定义::

真正(True Positive , TP)被模型预测为正的正样本

假负(False Negative , FN)被模型预测为负的正样本

假正(False Positive , FP)被模型预测为正的负样本

真负(True Negative , TN)被模型预测为负的负样本

真正率(True Positive Rate , TPR)或灵敏度(sensitivity)

TPR = TP /(TP + FN)

正样本预测结果数 / 正样本实际数

假负率(False Negative Rate , FNR)

FNR = FN /(TP + FN)

被预测为负的正样本结果数 / 正样本实际数

假正率(False Positive Rate , FPR)

FPR = FP /(FP + TN)

被预测为正的负样本结果数 /负样本实际数

真负率(True Negative Rate , TNR)或特指度(specificity)

TNR = TN /(TN + FP)

负样本预测结果数 / 负样本实际数

目标属性的被选中的那个期望值称作是“正”(positive)

ROC曲线上几个关键点的解释:

( TPR=0,FPR=0 ) 把每个实例都预测为负类的模型

( TPR=1,FPR=1 ) 把每个实例都预测为正类的模型

( TPR=1,FPR=0 ) 理想模型

一个好的分类模型应该尽可能靠近图形的左上角,而一个随机猜测模型应位于连接点(TPR=0,FPR=0)和(TPR=1,FPR=1)的主对角线上。

ROC曲线下方的面积(AUC)提供了评价模型平均性能的另一种方法。如果模型是完美的,那么它的AUG = 1,如果模型是个简单的随机猜测模型,那么它的AUG = 0.5,如果一个模型好于另一个,则它的曲线下方面积相对较大。

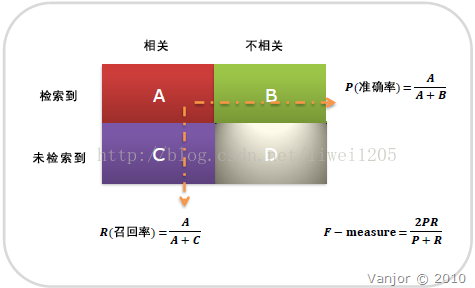

信息检索、分类、识别、翻译等领域两个最基本指标是召回率(Recall Rate)和准确率(Precision Rate),召回率也叫查全率,准确率也叫查准率,概念公式:

召回率(Recall) = 系统检索到的相关文件 / 系统所有相关的文件总数

准确率(Precision) = 系统检索到的相关文件 / 系统所有检索到的文件总数

1346

1346

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?