最近刚刚开始看斯坦福CS224n系列视频,主要讲的是自然语言处理与深度学习的结合。笔者怕自己看完视频就忘了,因此想记录下学习过程中的笔记。当然笔者发现了网上已经有人也发了一些CS224n的学习笔记。笔者主要学习了视频和参考了这篇笔记,再加上一些自己觉得难懂的地方的理解。笔者也是刚刚入门,水平有限,如有错漏,还望指出。

如何在电脑中表示一个词的意义?

用电脑表示一个词的问题

词向量的主要思路

- 通过单词和单词的上下文预测彼此。

- 两个算法:

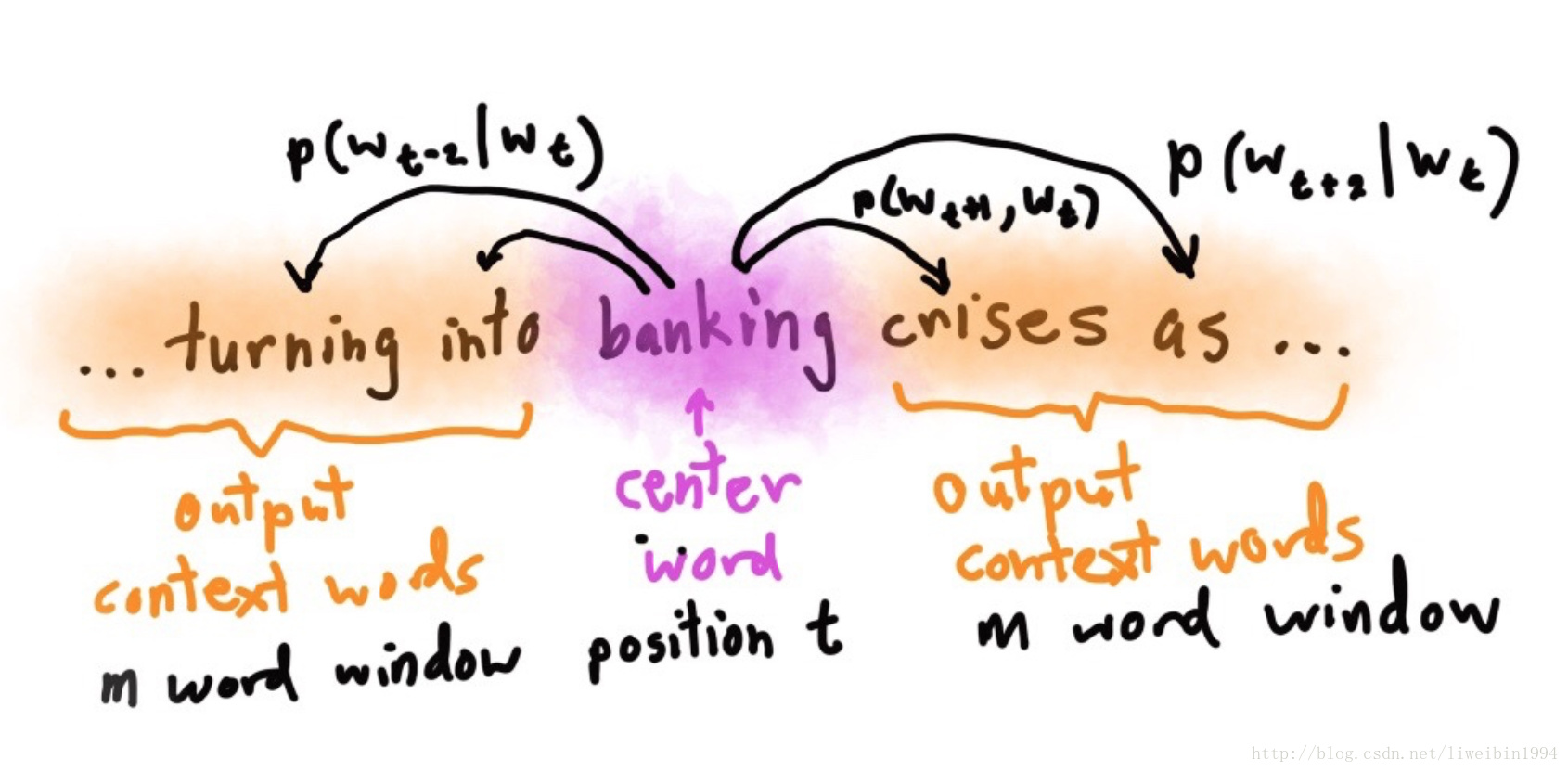

- Skip-gram:通过目标单词来预测它的上下文

- Continuous Bag of Words(CBOW):通过上下文预测目标单词

- 两种训练方法:

- Hierarchical softmax

- Negative sampling

Skip-gram模型

- 上图的意思就是在已知banking的情况下,预测turning,into,cnises,as的概率,即: P(wt+j|wt),j=−2,−1,1,2 P ( w t + j | w t ) , j = − 2 , − 1 , 1 , 2 。所以我们的目标函数就是:

J′(θ)=∏t=1T∏−m≤j≤m, j≠0P(wt+j|wt;θ) J ′ (

本文是斯坦福CS224n课程的笔记,重点介绍了如何用电脑表示词的意义,特别是词向量的概念。讲解了Skip-gram模型的原理,包括条件概率的表示、Softmax函数的应用以及训练模型时计算参数向量的梯度。文章还探讨了词向量如何通过上下文预测彼此,并提到了Hierarchical softmax和Negative sampling两种训练方法。

本文是斯坦福CS224n课程的笔记,重点介绍了如何用电脑表示词的意义,特别是词向量的概念。讲解了Skip-gram模型的原理,包括条件概率的表示、Softmax函数的应用以及训练模型时计算参数向量的梯度。文章还探讨了词向量如何通过上下文预测彼此,并提到了Hierarchical softmax和Negative sampling两种训练方法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?