简介

图上知识蒸馏怎么做?中科院计算所等最新《基于图的知识蒸馏》综述。本工作的主要贡献如下:

通过覆盖100多篇论文,首次对基于图的知识蒸馏进行了全面综述,填补了该领域的空白。从问题定义、理论分析、方法分类、实验比较、应用与展望等方面进行综述。

使用层次分类来系统地总结和分析基于图的知识蒸馏方法的最新进展,为每类方法提供见解(参见图1)。

进行了广泛的实验,比较了每类知识蒸馏方法的蒸馏效果,并进行了深入的分析。

讨论了现有的基于图的知识蒸馏的挑战,提出了未来的潜在研究方向和趋势,并为GNNs和KD领域的研究人员提供了有见地的指导。

建立了一个基于图的知识蒸馏研究的开源代码库,为该研究领域提供了有价值的参考。

题目: Graph-based Knowledge Distillation: A survey and experimental evaluation

作者:刘静,郑铜亚,张冠正,郝沁汾

单位:中科院计算机技术研究所,浙江大学,中国地质大学(北京)

论文: https://arxiv.org/abs/2302.14643

代码: https://github.com/liujing1023/Graph-based-Knowledge-Distillation

论文

图知识蒸馏方法分类

分类1-DKD:Graph-based Knowledge Distillation for Deep Neural Networks

DKD通用框架和通式

DKD方法分类总结

分类2-GKD :

GKD通用框架和通式

GKD方法分类总结

分类3-SKD :

SKD通用框架和通式

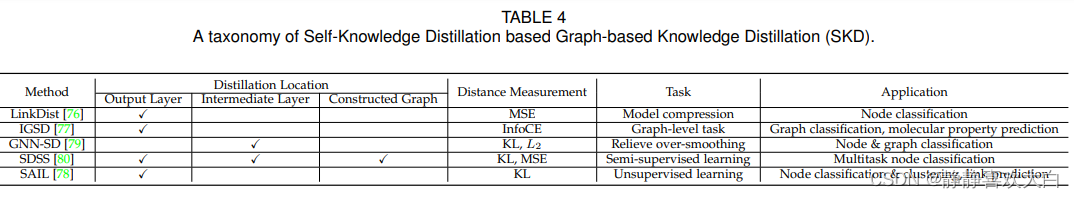

SKD方法分类总结

实验对比

第一类DKD

第二类GKD

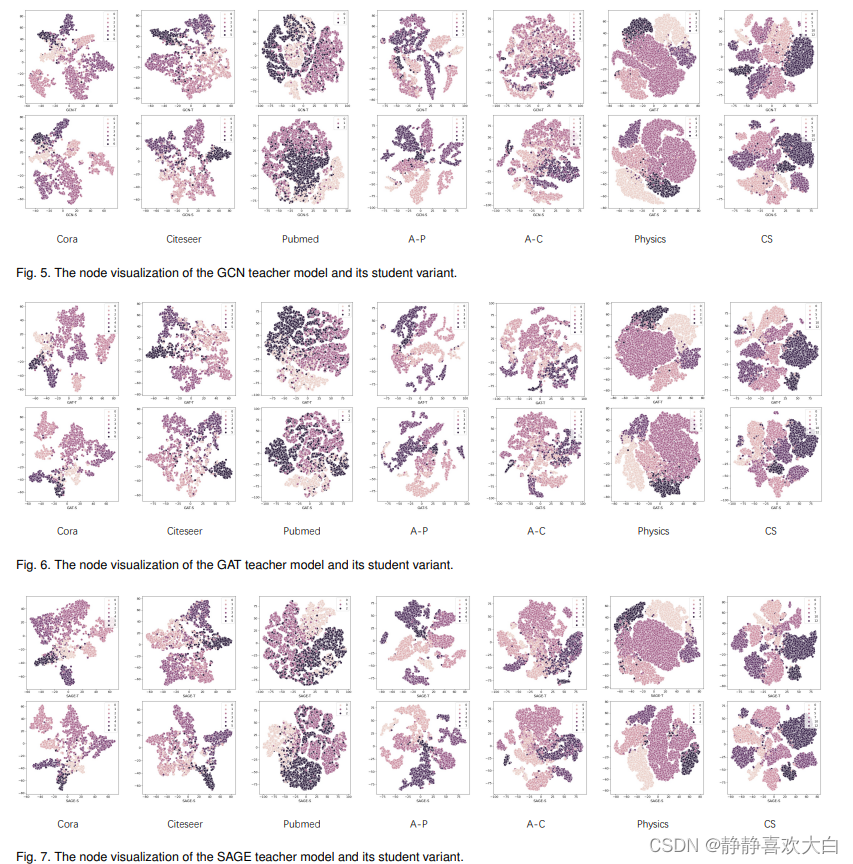

第三类SKD

应用

未来展望

具体详情讨论参见原文

Determination of distillation position

Choice of distillation mode

Selection for distillation distance measurement

Theoretical analysis of interpretability

A new paradigm of Graph-based Knowledge Distillation

参考

该综述论文全面探讨了基于图的知识蒸馏,包括其在深度学习模型压缩中的应用。通过层次分类,分析了DKD、GKD和SKD等方法,并通过实验比较了它们的效果。此外,论文还讨论了挑战与未来趋势,提供了一个开源代码库供研究者参考。

该综述论文全面探讨了基于图的知识蒸馏,包括其在深度学习模型压缩中的应用。通过层次分类,分析了DKD、GKD和SKD等方法,并通过实验比较了它们的效果。此外,论文还讨论了挑战与未来趋势,提供了一个开源代码库供研究者参考。

430

430

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?