概述

入职一家大模型领域创业公司,恶补相关知识。

概念

一些概念:

- HPC:High Performance Computing,高性能计算

- SoC:System on Chip,单片系统

- FLOPS:Floating Point Operations Per Second,每秒浮点运算次数,用于衡量硬件性能

- SM:Streaming Multiprocessor,流多处理器

- QoS:Quality of Service,服务质量

- MIG:Multi-Instance GPU,多实例GPU

- CUDA:Compute Unified Device Architecture,计算统一设备架构。描述GPU的并行计算能力,以及访问CUDA核心指令集的API

- MMA:Matrix Multiplication and Accumulation,矩阵乘法和累加计算

- TEE:Trusted Execution Environment,可信执行环境

- CC:Confidential Computing,机密计算

- TMA:Tensor Memory Accelerator,张量内存加速器

- VDI:Virtual Desktop Infrastructure,虚拟桌面基础设施

产品

- GeForce:面向游戏玩家,提供强大的图形处理能力、先进的游戏技术。

- Quadro:面向专业市场,如设计师、工程师、科学家和内容创作者。如Quadro P 系列。

- Tesla:面向数据中心和HPC市场,提供强大算力,适用于科学研究、深度学习。如V100、A100等。

- Titan:高端显卡系列,介于消费者和专业市场之间,兼具游戏和计算能力。

- RTX:包含实时光线追踪技术的显卡,适用于游戏和高性能计算。

- GTX:面向主流和高性能游戏市场。

- Clara:面向医疗成像和生命科学领域,提供 AI 和加速计算能力,用于医学影像处理和生命数据分析。

- Jetson:面向边缘计算和机器人市场,提供小型化、低功耗的AI计算模块,适合嵌入式系统和机器人应用。

- Orin:面向自动驾驶和边缘AI市场,高能效SoC,集成CPU、GPU和深度学习加速器。

系列

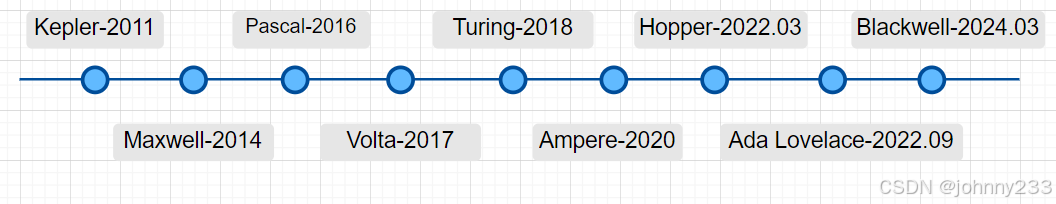

在NVIDIA GPU的命名体系中,首字母通常代表该GPU采用的微架构。微架构是GPU芯片设计的核心,决定其基本的运算方式、指令集以及内部结构。每隔几年,NVIDIA都会针对其消费级和数据中心产品线推出全新的微架构,以实现性能和能效比的显著提升。

架构序列号:

- F:Fermi,2008推出。首次采用 GPU-Direct 技术,拥有32个SM和 16 个 PolyMorph Engine 阵列,每个 SM 都拥有 1 个 PolyMorph Engine 和 64 个 CUDA 核心。该架构采用 4 颗芯片的模块化设计,拥有 32 个光栅化处理单元和 16 个纹理单元,搭配 GDDR5 显存。

- K:Kepler,2011。采用 28nm 制程,首度支持超级计算和双精度计算。Kepler GK110 具有 2880 个流处理器和高达 288GB/s 的带宽,计算能力比 Fermi 架构提高 3-4 倍。Kepler 架构的出现使 GPU 开始成为HPC的关注点。

- M:Maxwell,2014

- P:Pascal,2016

- V:Volta,2017

- T:Turing,2018

- A:Ampere,2020

- H:Hopper,2022.03

- L:Ada Lovelace,2022.09

- B:Blackwell,2024.03

性能等级(Tier):通常用数字表示,数字越大通常代表性能越强,价格越高,功耗更高。

- 4系列:入门级或低功耗级

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?