注意力机制灵感来源于人类视觉所特有的大脑信号处理机制:

人类通过快速扫描全局图像,获得需要重点关注的目标区域,然后对这一区域投入更多注意力,以获取更多所需要关注目标的细节信息,而抑制其他无用信息。人类视觉注意力机制极大地提高了视觉信息处理的效率与准确性。

目前大部分注意力机制都应用于Encoder-Decoder模型下,先来了解一下Encoder-Decoder模型:

(一)Encoder-Decoder模型

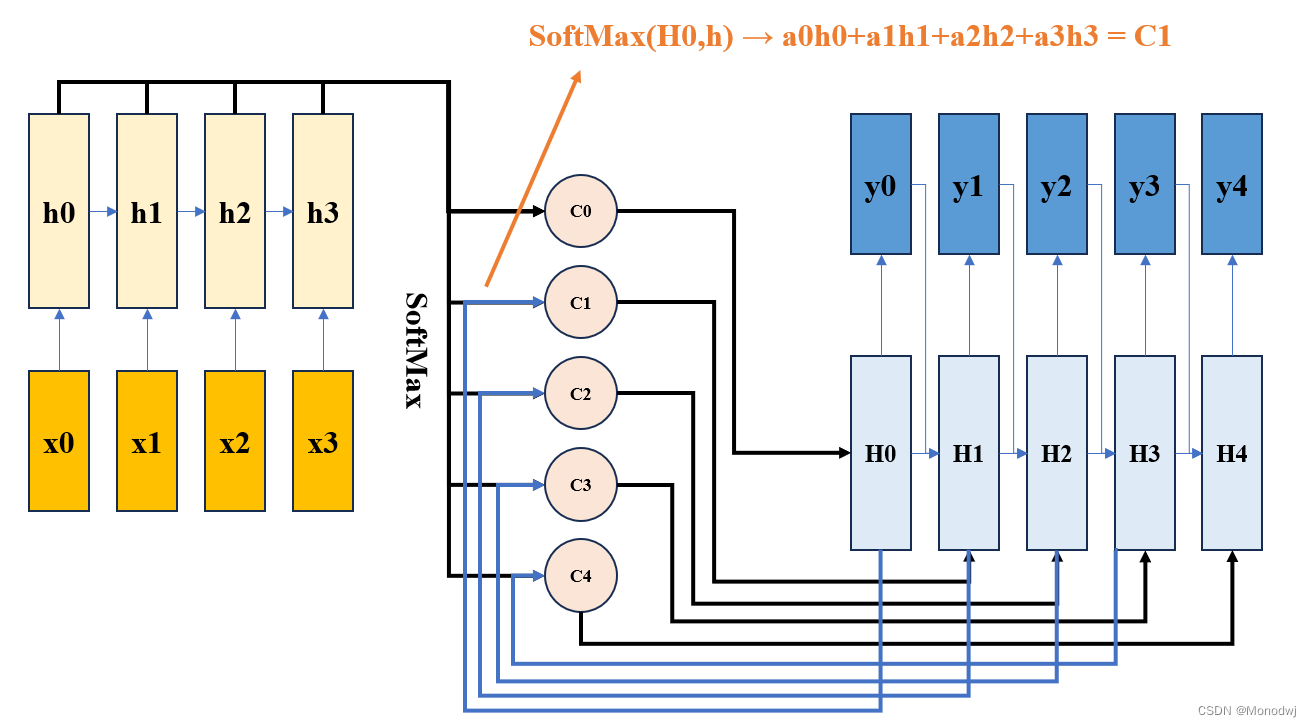

这里的Encoder-Decoder模型均以RNN网络为例,一般而言,文本处理和语音识别的Encoder部分通常采用RNN模型,图像处理的Encoder一般采用CNN模型。

输入x将被网络压缩成一个固定长度的中间编码C,编码C包含了所有的输入信息。

一方面,编码C长度有限,当语句越来越复杂时,该方法存在一定局限性;

另一方面,对于每一个输出,每一个输入的贡献度都是一样的,这显然不符合人类的注意力机制,对于每个输出,我们需要对每个输入有不同的关注程度。所以模型应该改成如下所示:

通过对齐Hi-1,通过softmax函数得到每一个hj的权重aj,并做加权求和处理,得到Ci,从而作为计算yi的输入编码。

如此,针对每一个输出yi,都会有专属的权重分配Ci(注意力分配),这也就是soft-attention机制。

(二)注意力attention机制

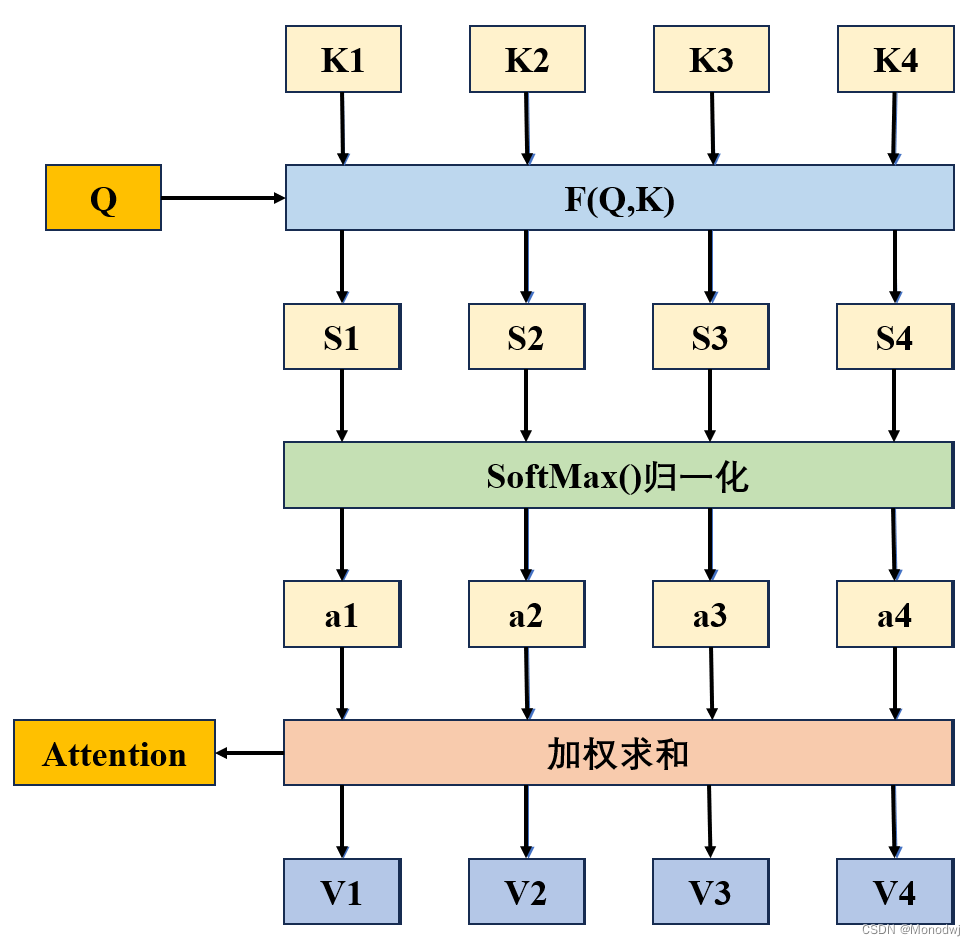

将注意力从上述Encoder-Decoder模型当中抽离出来:

以论文搜索引擎为例,其中,Q可以理解为你所需要搜索的内容,K可以理解为文库里文章的关键词,V则理解为全文的具体内容。

那么在抛出一个问题Q后,我们先计算该问题和文库里的文章关键词的相关程度,即评分S,再通过归一化得到各自的权重a,最后通过与V加权求和得到Q问题下的Attention value,也就是Encoder-Decoder模型里的Ci。

4280

4280

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?