01 。

概述

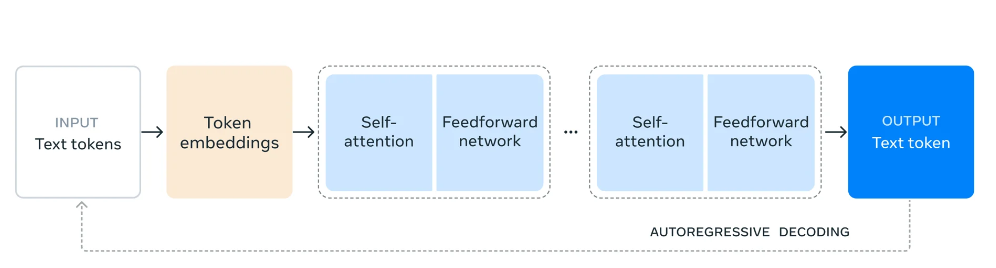

Meta公司推出了其最大的开源人工智能模型——Llama 3.1 405B,拥有4050亿个参数,与GPT-4o和Claude 3.5 Sonnet相媲美。该模型在16000个Nvidia H100 GPU上训练而成,现已在云平台上可用,并被应用于WhatsApp和Meta.ai中。它能够处理包括编码和摘要在内的八种语言任务,但仅限于文本。Llama 3.1模型拥有128000个token的上下文窗口,同时Meta还发布了更小规模的模型版本,即Llama 3.1 8B和70B。

02 。

关键信息

Meta公司推出了迄今为止最大的开源人工智能模型——Llama 3.1 405B,该模型包含4050亿个参数。虽然它并非史上最大的模型,但确实是近年来规模最大的模型之一,与OpenAI的GPT-4o和Anthropic的Claude 3.5 Sonnet等领先的专有模型形成竞争。该模型使用了16000个Nvidia H100 GPU进行训练,得益于先进的训练技术,现已可在AWS、Azure和Google Cloud等云平台上下载或使用。此外,它也被应用于WhatsApp和Meta.ai,为美国用户提供聊天机器人服务。

Llama 3.1 405B能够执行包括编程、解答数学问题和摘要文档在内的多种任务,支持八种语言。然而,它仅限于文本,无法处理基于图像的查询。Meta公司还在研发能够识别图像、视频和生成语音的多模态Llama模型,但这些模型尚未公开发布。

关键特性与性能

该模型使用相当于7500亿单词的15万亿个token的数据集进行训练。Meta公司为该模型优化了数据整理和质量保证流程。还使用了其他AI模型生成的合成数据来微调Llama 3.1 405B。然而,出于竞争和法律原因,Meta并未公开其训练数据的具体来源。

上下文窗口与工具

Llama 3.1 405B拥有128000个token的更大上下文窗口,使其能够更好地总结更长的文本,并在对话中保持更好的上下文连贯性。Meta还发布了两个较小的模型,Llama 3.1 8B和Llama 3.1 70B,它们共享相同的上下文窗口。这些模型可以使用第三方工具和API来执行回答最新事件问题、解决数学问题和验证代码等任务。

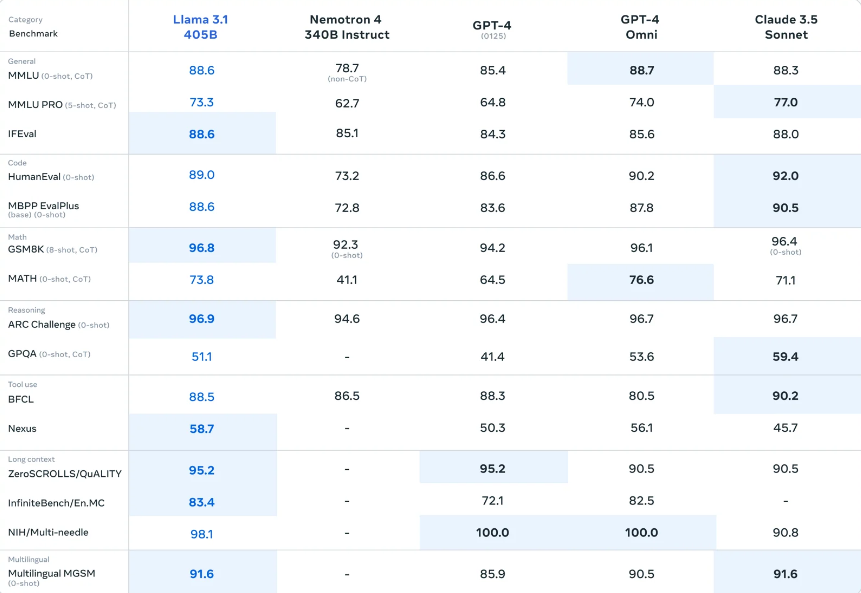

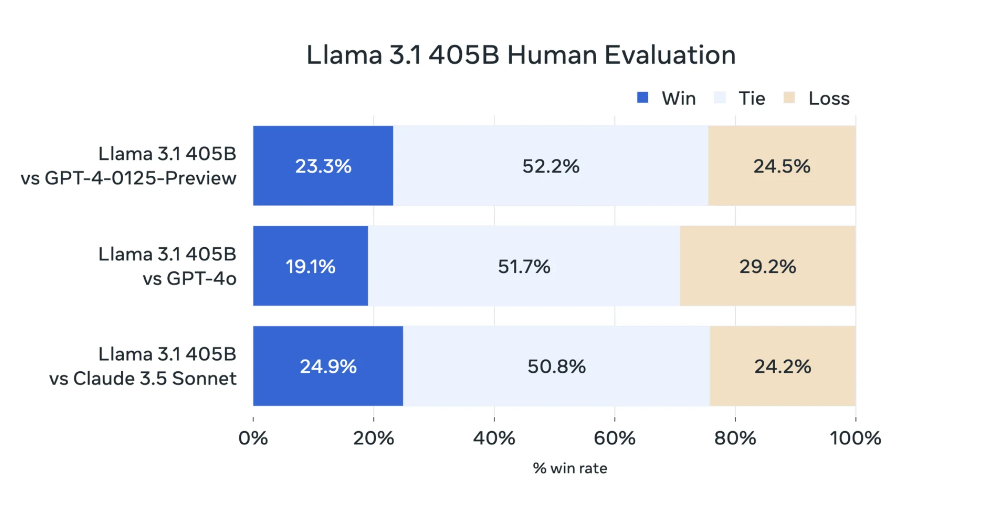

性能与许可

Llama 3.1 405B的性能与OpenAI的GPT-4相当,在与GPT-4o和Claude 3.5 Sonnet的对比中显示出混合结果。它在执行代码和生成图表方面表现优异,但在多语言能力和一般推理方面较弱。由于其规模庞大,运行该模型需要大量的硬件资源。Meta公司正在推广其较小的模型用于通用应用程序,并认为Llama 3.1 405B适合模型蒸馏和生成合成数据。

Meta已更新Llama的许可证,允许开发者使用Llama 3.1模型系列的输出来开发第三方AI模型。但是,月活跃用户超过7亿的应用开发者必须向Meta申请特殊许可。

03 。

使用

您还可以使用 Ollama 下载并使用此模型,您可以通过运行来完成此操作。

ollama run llama3.1

或者从Huggingface下载

https://huggingface.co/collections/meta-llama/llama-31-669fc079a0c406a149a5738f

创建一个程序,使用递归回溯算法或深度优先搜索算法生成完美迷宫,并具有可定制的大小和复杂性。

import random class Cell: def __init__(self, x, y): self.x = x self.y = y self.walls = [True, True, True, True] # Top, Right, Bottom, Left class Maze: def __init__(self, width, height): self.width = width self.height = height self.cells = [[Cell(x, y) for x in range(width)] for y in range(height)] def generate(self): stack = [] current_cell = self.cells[0][0] current_cell.walls[3] = False # Remove left wall to start maze generation while True: neighbors = self.get_unvisited_neighbors(current_cell) if neighbors: next_cell = random.choice(neighbors) self.remove_walls(current_cell, next_cell) stack.append(current_cell) current_cell = next_cell elif stack: current_cell = stack.pop() else: break def get_unvisited_neighbors(self, cell): x, y = cell.x, cell.y neighbors = [] if x > 0 and self.cells[y][x-1].walls[3]: neighbors.append(self.cells[y][x-1]) if y < self.height - 1 and self.cells[y+1][x].walls[2]: neighbors.append(self.cells[y+1][x]) if x < self.width - 1 and self.cells[y][x+1].walls[1]: neighbors.append(self.cells[y][x+1]) if y > 0 and self.cells[y-1][x].walls[0]: neighbors.append(self.cells[y-1][x]) return neighbors def remove_walls(self, cell1, cell2): x1, y1 = cell1.x, cell1.y x2, y2 = cell2.x, cell2.y if x1 < x2: cell1.walls[1] = False # Remove right wall of first cell cell2.walls[3] = False # Remove left wall of second cell elif x1 > x2: cell1.walls[3] = False # Remove left wall of first cell cell2.walls[1] = False # Remove right wall of second cell else: # y1 < y2 cell1.walls[0] = False # Remove top wall of first cell cell2.walls[2] = False # Remove bottom wall of second cell # Example usage: maze = Maze(21, 11) # Size must be odd for a perfect maze maze.generate() # Print the maze (binary representation) for row in maze.cells: for cell in row: print(cell.walls[0] * ' ', end='') print(cell.walls[1] * '|', end='') print(cell.walls[2] * '|', end='') print(cell.walls[3] * '-', end='') print()

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

943

943

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?