摘要

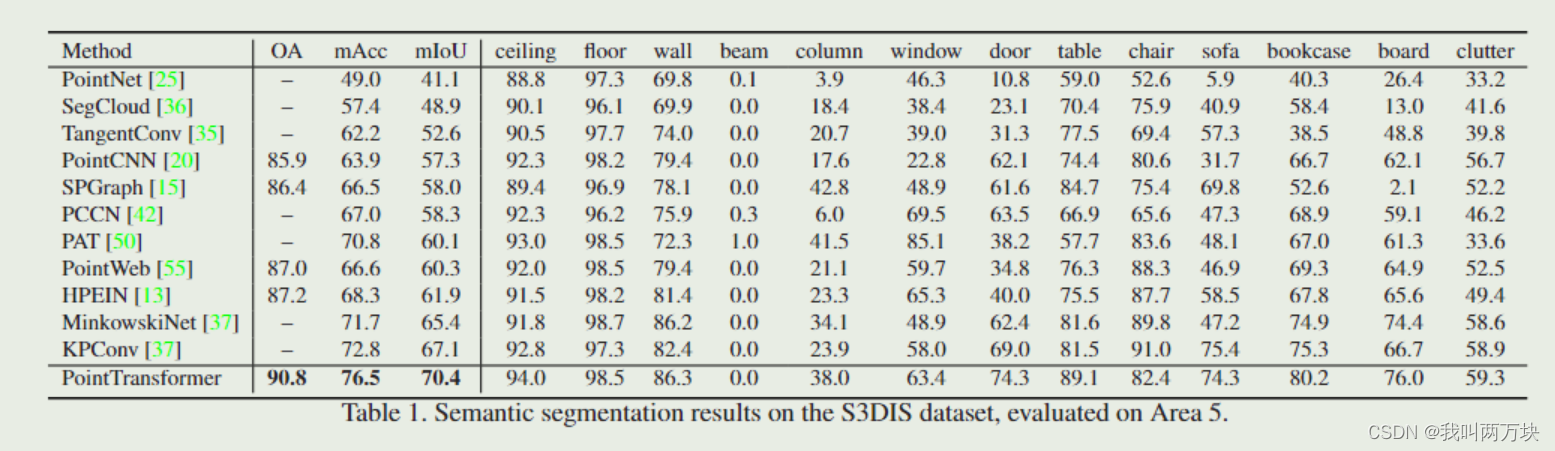

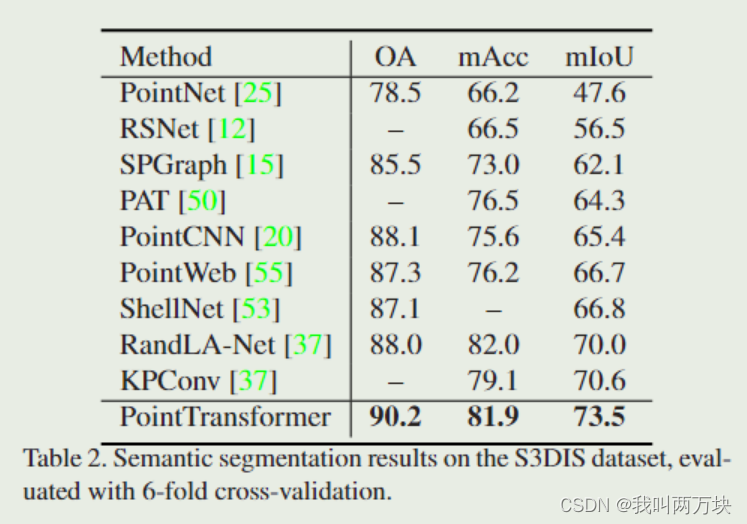

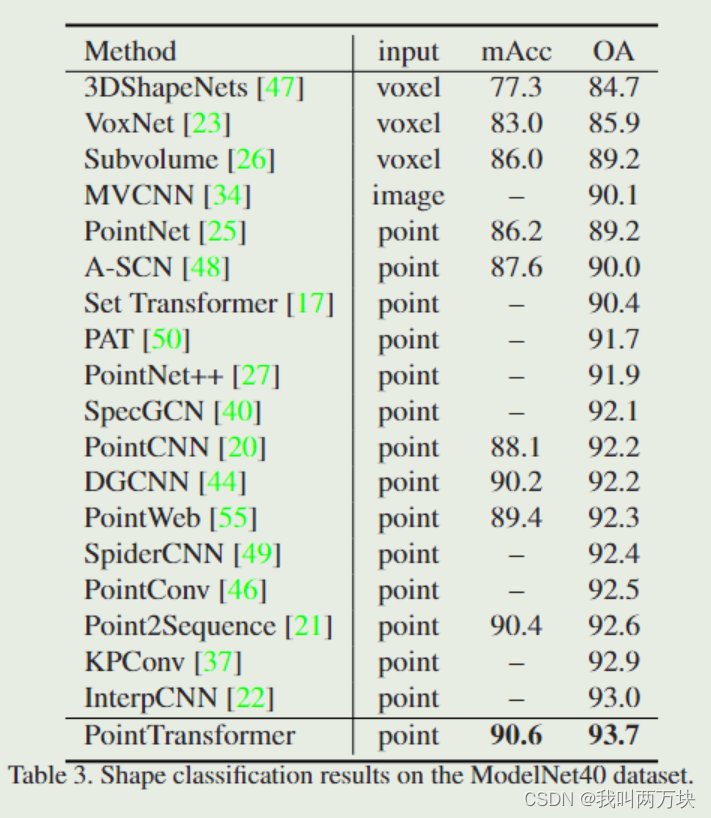

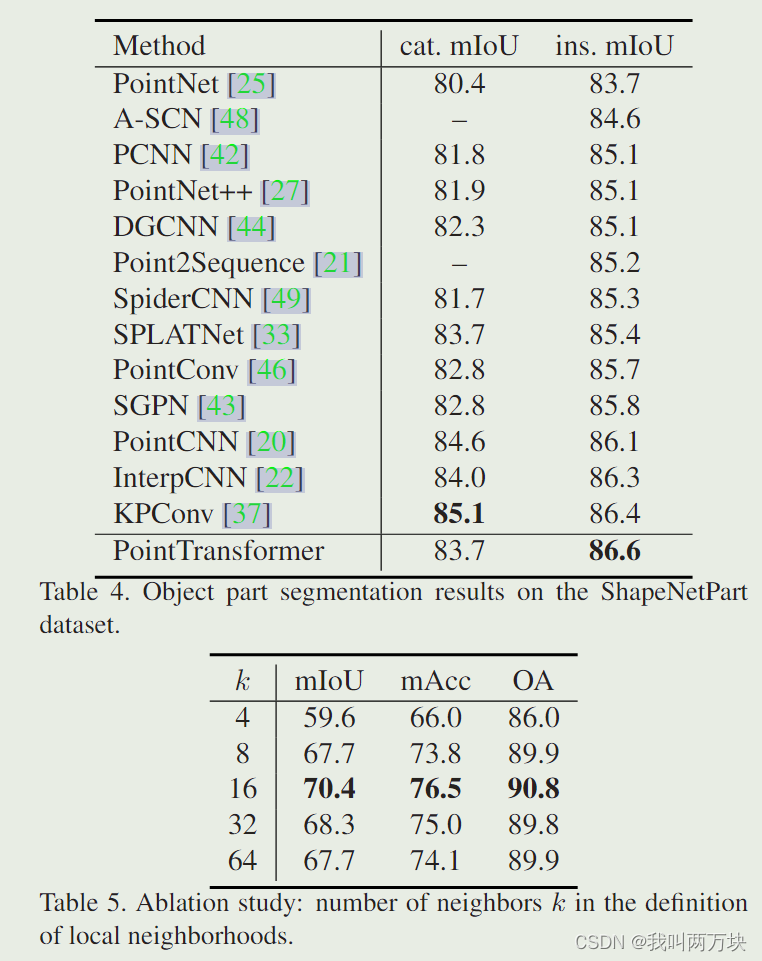

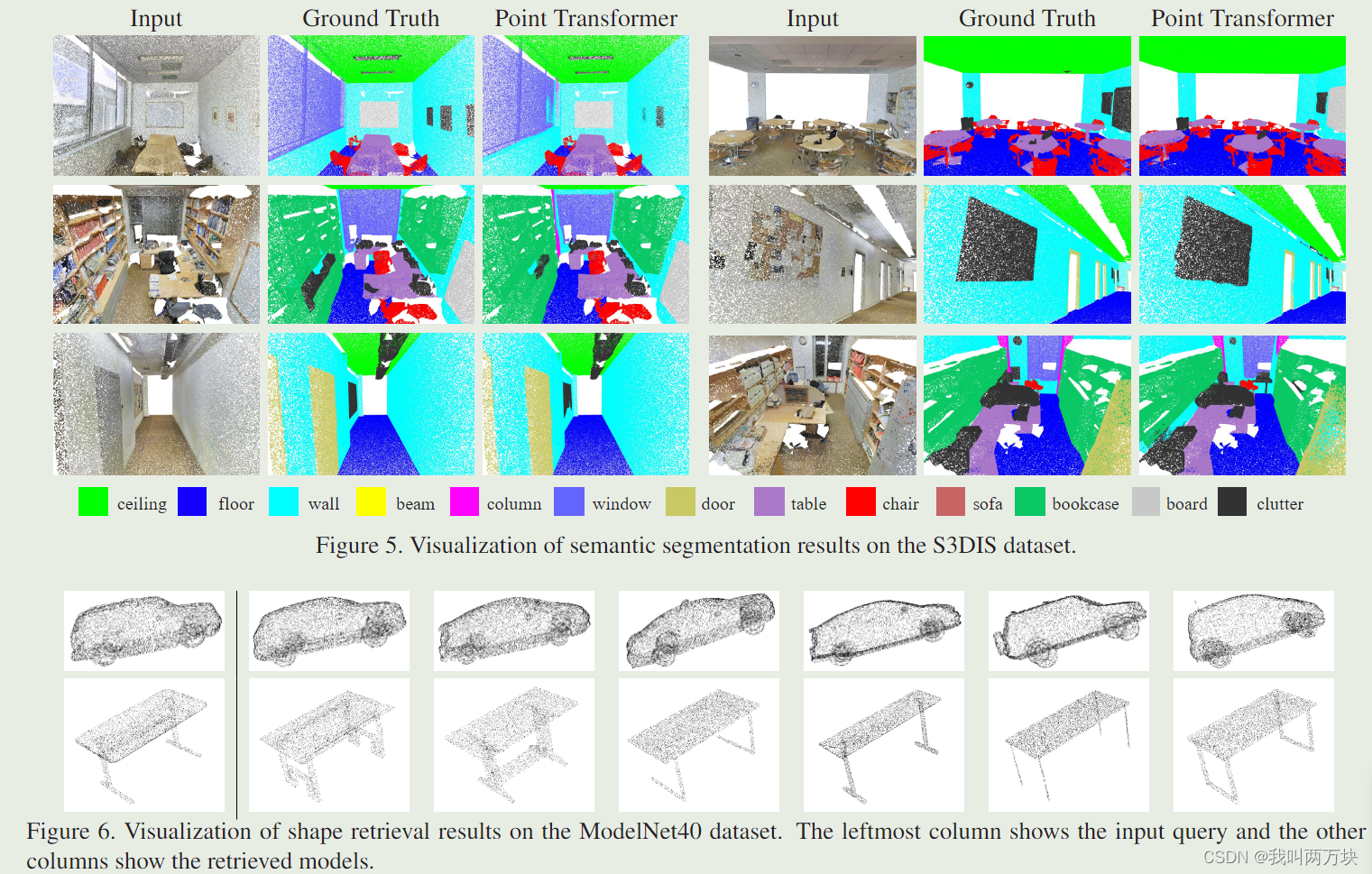

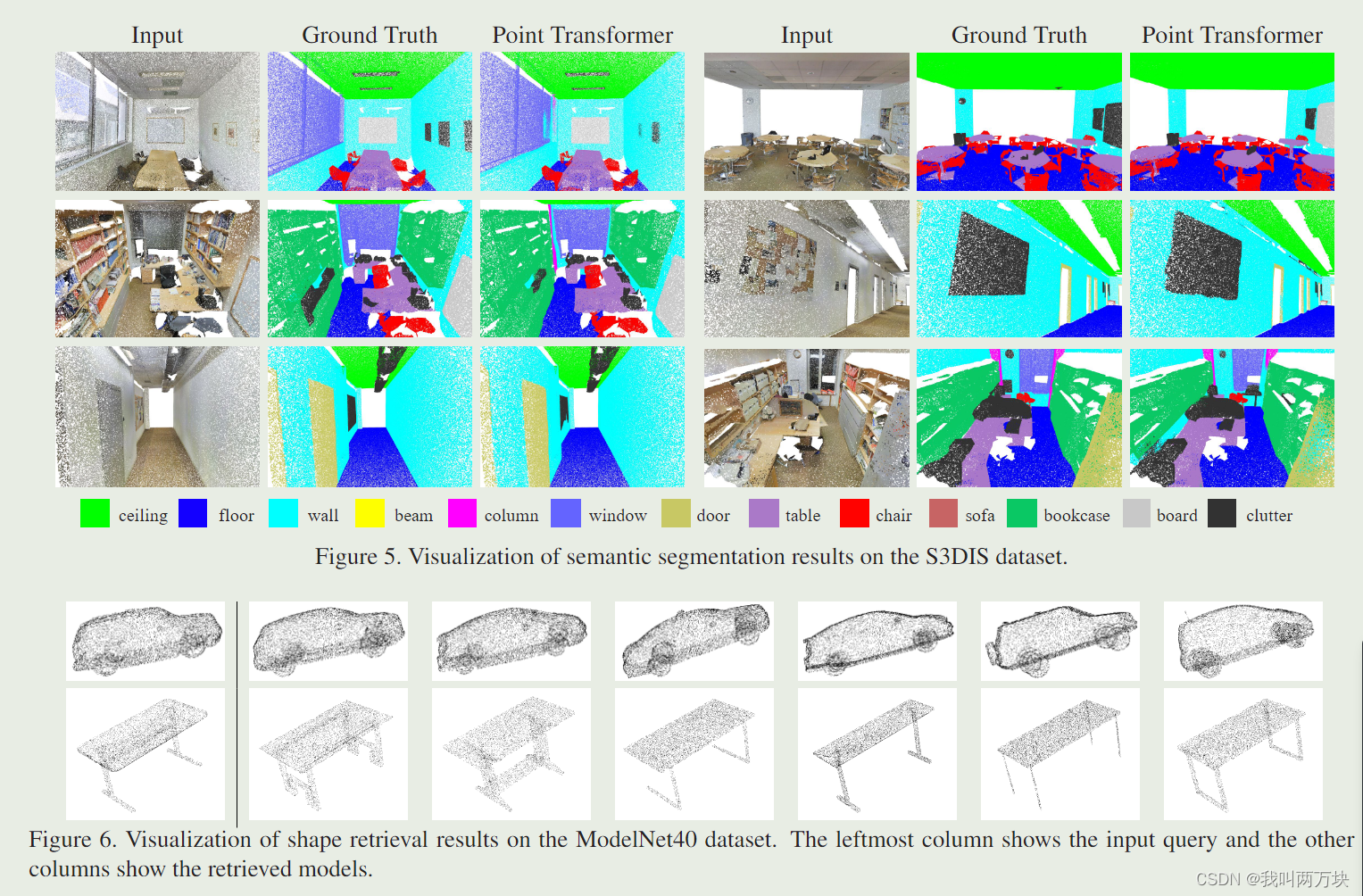

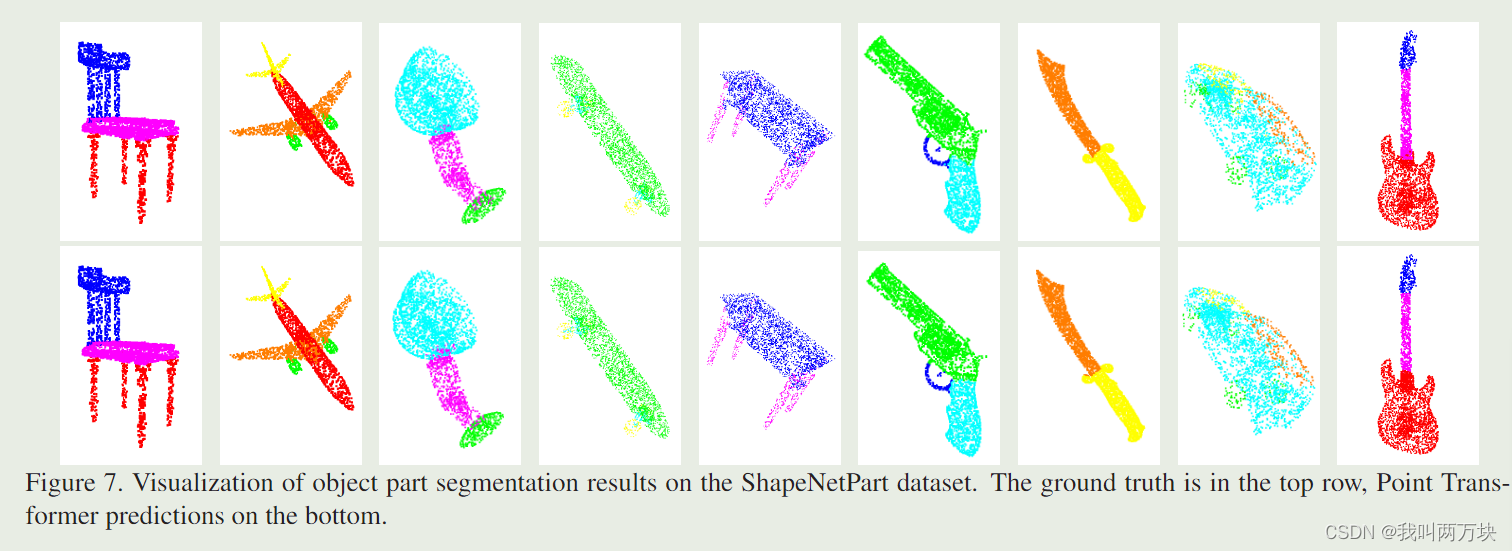

自注意网络已经彻底改变了自然语言处理,并在图像分析任务(如图像分类和对象检测)方面取得了令人印象深刻的进展。受这一成功的启发,我们研究了自注意网络在三维点云处理中的应用。我们为点云设计了自注意层,并使用这些层来构建用于语义场景分割、对象部分分割和对象分类等任务的自注意网络。我们的Point Transformer设计改进了先前跨域和任务的工作。例如,在具有挑战性的用于大规模语义场景分割的S3DIS数据集上,Point Tranformer在区域5上的mIoU达到70.4%,比最强的先验模型高3.3个绝对百分点,并首次超过70%mIoU阈值。

引言

3D数据出现在许多应用领域,如自动驾驶、增强现实和机器人。与排列在规则像素网格上的图像不同,3D点云是嵌入在连续空间中的集合。这使得3D点云在结构上与图像不同,并且阻碍了深度网络设计的立即应用,而深度网络设计已经成为计算机视觉的标准,例如基于离散卷积算子的网络。

transformer模型族特别适合于点云处理,因为自关注算子是变压器网络的核心,本质上是一个集合算子:它对输入元素的排列和基数是不变的。因此,自关注3D点云的应用是很自然的,因为点云本质上是嵌入在3D空间中的集合。

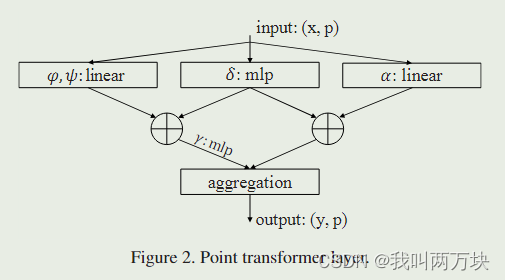

基于此,我们开发了一个用于3D点云处理的自注意力层。基于这一层,我们构建了用于各种三维理解任务的Point Transformer网络。我们研究了自注意算子的形式,自注意在每个点周围的局部邻域的应用,以及网络中位置信息的编码。由此产生的网络完全基于自我关注和点操作。

我们的贡献:

- 我们为点云处理设计了一个高表现力的点转换器层。该层不受排列和基数的影响,因此天生就适合于点云处理。

- 基于点变压器层,构建高性能点变压器网络,对点云进行分类和密集预测。这些网络可以作为3D场景理解的一般主干。

- 我们报告了在多个领域和数据集上的广泛实验。我们进行对照研究,以检查点变压器设计中的特定选择,并在多个高度竞争的基准上达到sota,优于之前的工作。

方法

自注意算子可分为两类:

-

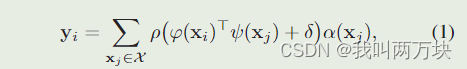

标量注意力(Scalar Attention):在标量注意力中,使用一个标量(单一的数值)来表示注意力权重。典型的标量注意力计算方式是通过将注意力分数(即输入的某个特征与上下文之间的相似度)传递给 softmax 函数,以获得标准化的权重。这个标量用于加权求和,产生最终的上下文向量。

其中yi是输出特征。φ, ψ和α是点向特征变换,如线性投影或mlp。δ是一个位置编码函数,ρ是一个归一化函数,如softmax。标量注意层计算φ和ψ变换后的特征之间的标量积,并将其输出作为对α变换后的特征进行聚合的注意权值 -

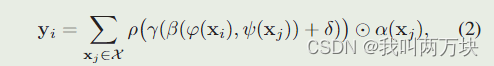

向量注意力(Vector Attention):在向量注意力中,使用一个向量来表示注意力权重,而不是标量。向量注意力通常通过对每个特征计算一个注意力权重向量,然后将这些权重向量组合成最终的上下文向量。

其中β是一个关系函数(例如,减法),γ是一个映射函数(例如,MLP),它产生用于特征聚合的注意向量。

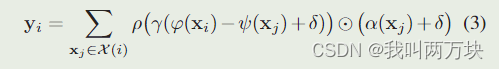

我们使用减法关系,并在注意向量γ和变换后的特征α上添加位置编码δ。

其中,子集X (i)是xi的局部邻域(即k个最近邻)中的点的集合。因此,我们采用最新的自注意网络进行图像分析,在每个数据点周围的局部邻域中应用局部自注意。映射函数γ是一个具有两个线性层和一个ReLU非线性的MLP。

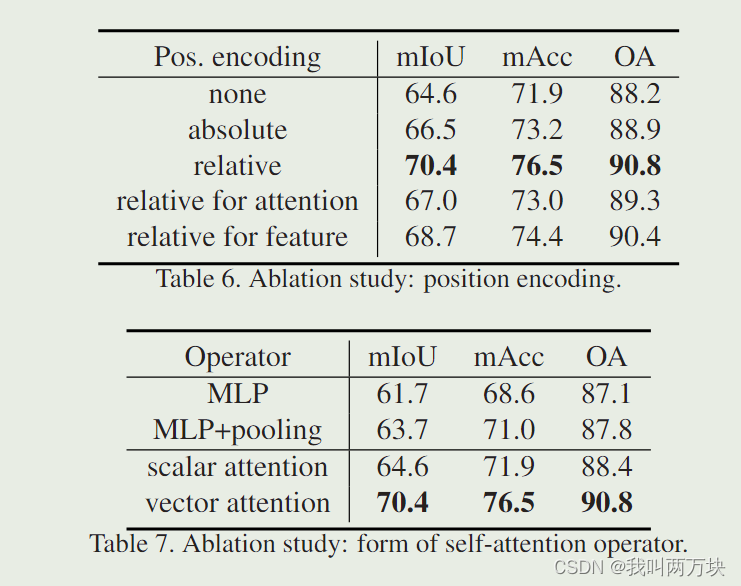

Poistion Encoding:

位置编码在自关注中起着重要的作用,使算子能够适应数据[39]中的局部结构。序列和图像网格的标准位置编码方案是手动制作的,例如基于正弦和余弦函数或归一化范围值[39,54]。在三维点云处理中,三维点坐标本身是位置编码的自然候选者。除此之外,我们还引入了可训练的参数化位置编码。我们的位置编码函数δ定义如下

其中pi和pj是点i和点j的三维点坐标。编码函数θ是一个具有两个线性层和一个ReLU非线性的MLP。值得注意的是,我们发现位置编码对注意生成分支和特征转换分支都很重要。因此,Eq. 3在两个分支中添加了可训练位置编码。位置编码θ与其他子网端到端进行训练。

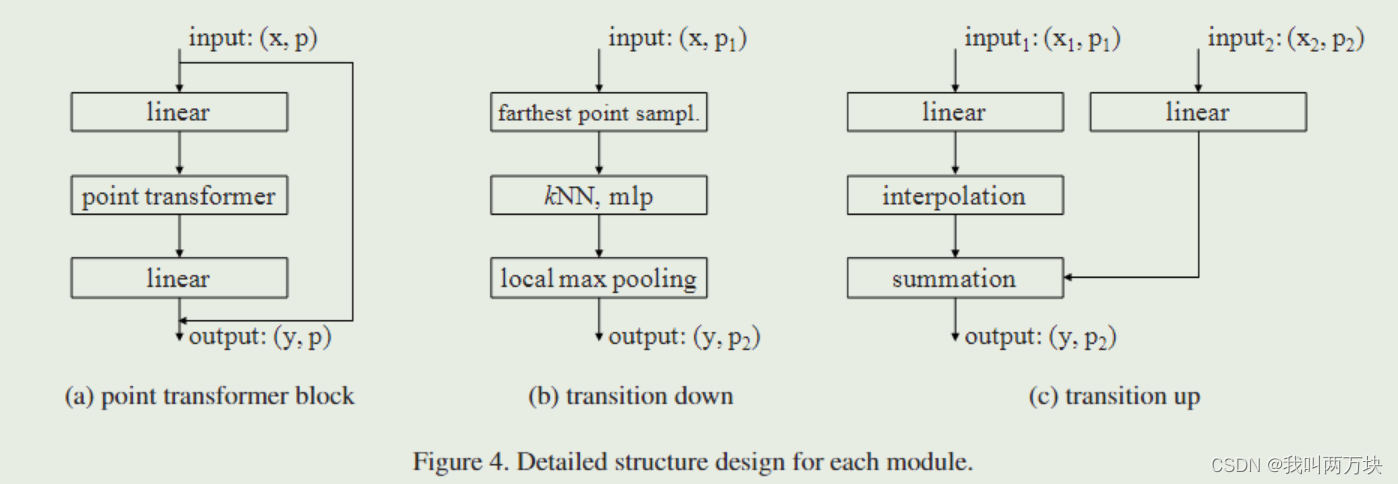

Point Transformer Block

我们构建了一个以点变压器层为核心的残余点变压器块,如图4(a)所示。

变压器块集成了自关注层,可以降低维数和加速处理的线性投影,以及残余连接。输入是一组带有相关3D坐标的特征向量x。点变换块促进了这些局部特征向量之间的信息交换,为所有数据点生成新的特征向量作为其输出。信息聚合既适应特征向量的内容,又适应特征向量在三维中的布局。

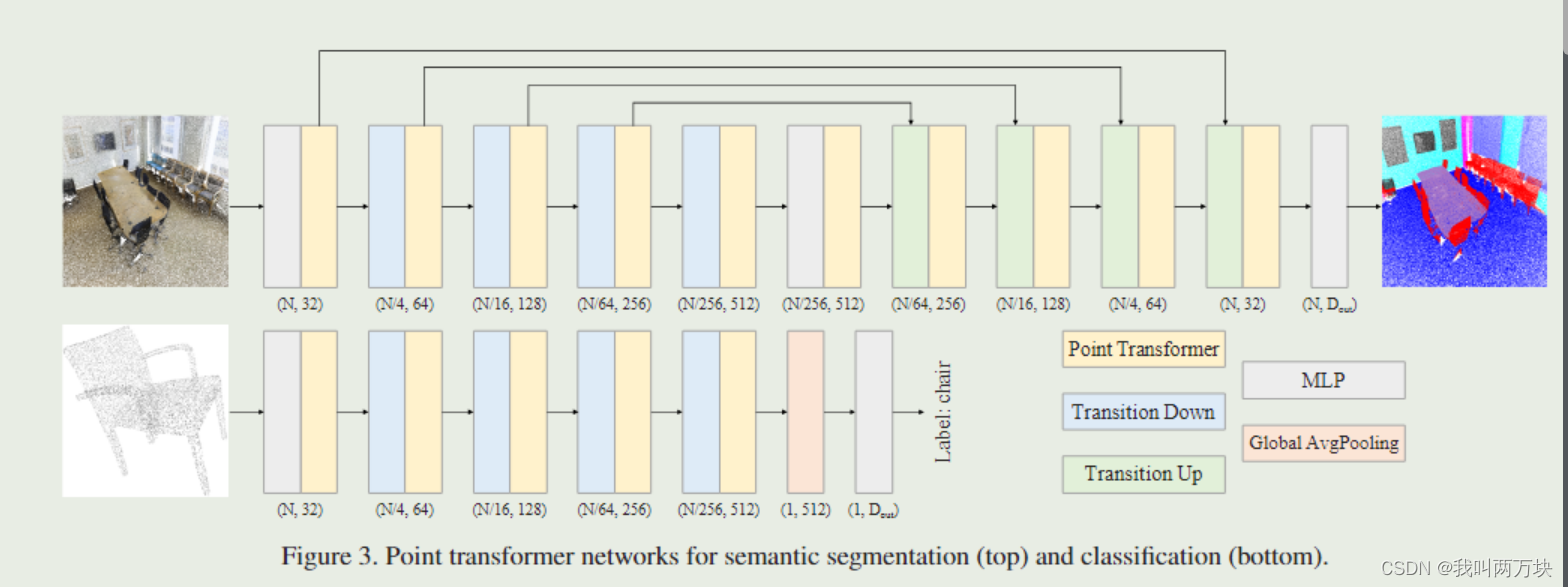

我们基于点变压器块构建了完整的三维点云理解网络。注意,点转换器是整个网络中的主要特征聚合算子。我们不使用卷积进行预处理或辅助分支:网络完全基于点转换层、点变换和池化。网络体系结构如图3所示。

实验

结论

transformer已经彻底改变了自然语言处理,并在2D图像分析方面取得了令人印象深刻的进展。受这一进展的启发,我们开发了一种用于3D点云的转换器架构。与语言或图像处理相比,transformer可能更适合点云处理,因为点云本质上是嵌入度量空间的集合,而transformer网络核心的自注意算子本质上是集合算子。我们已经证明,除了这种概念兼容性之外,转换器在点云处理方面非常有效,优于各种家族的最先进设计:基于图的模型、稀疏卷积网络、连续卷积网络等。我们希望我们的工作将启发对点变换器特性的进一步研究,新算子和网络设计的开发,以及变换器在其他任务中的应用,如3D对象检测。

7519

7519

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?