pybibx论文原文精读与对照翻译

手动反爬虫: 原博地址 https://blog.csdn.net/lys_828/article/details/133679130

知识梳理不易,请尊重劳动成果,文章仅发布在CSDN网站上,在其他网站看到该博文均属于未经作者授权的恶意爬取信息

欢迎交流

作者邮箱:xianl828@163.com

微信:lys_828

1 标题

pyBibX - 由人工智能工具支持的用于文献计量和科学计量分析的 Python 库

2 摘要与关键词

背景: 文献计量和科学计量分析为复杂的研究领域和跨不同学科的协作动态提供了宝贵的视角。目的: 本文介绍了 pyBibX,这是一个 Python 库,旨在对来自 Scopus、Web of Science 和 PubMed 的原始数据文件进行全面的文献计量和科学计量分析,将最先进的人工智能 (AI) 功能无缝集成到其核心功能中。方法: pyBibX可执行全面的探索性数据分析 (EDA),通过视觉上吸引人的图形插图呈现结果。网络功能已被巧妙地集成,包括引文、协作和相似性分析。此外,该库还整合了 AI 功能,包括嵌入向量、主题建模、文本摘要和其他通用自然语言处理任务,采用 Sentence-BERT、BerTopic、BERT、chatGPT 和 PEGASUS 等模型。结果: 作为演示,我们分析了 1984 年至 2023 年间发布的 184 份与“多标准决策分析”相关的文档。EDA 强调了人们对决策和模糊逻辑方法日益增长的兴趣。接下来,网络分析进一步强调了中心作者和洲际合作的重要性,将加拿大和中国确定为重要的合作中心。最后,AI 分析区分了两个主要主题以及 chatGPT 在文本摘要方面的卓越表现。它也被证明是解释结果不可或缺的工具,因为pyBibX使研究人员能够向 chatGPT 提出有关文献计量结果的查询。即便如此,由于数据库不一致,数据同质性仍然是一个艰巨的挑战。意义: PyBibX 是第一个集成尖端人工智能功能的应用程序,可用于分析科学出版物,使研究人员能够更有效地检查和解释这些结果。

关键词:文献计量学、科学计量学、网络分析、人工智能、chatGPT

3 引言

[1] 文献计量和科学计量分析可以分析和量化特定文献集合的特征。两种方法都使用数学和统计技术;然而,文献计量分析侧重于书籍和书面交流形式,另一种则纯粹侧重于科学研究的集合。在很大程度上,两种方法在研究对象和分析技术方面可以重叠;因此,我们可以假设这两个术语可以根据研究互换使用。

[2] 基于一个特定的文献集合,可以采取一些定量方式进行探索,如文献总数,平均引文计数,平均期刊影响因子,平均h指数,平均每个作者的出版物,研究机构的总数,以及许多其他的衡量指标。此外,科学文献中的模式和趋势可以通过引文网络,共引网络和人工智能分析来识别。

[3] 分析结果可用于评估研究人员、期刊和研究机构的生产力和影响力,并确定研究领域的优势和劣势。举一个简单的例子,这些产出可以帮助决策者确定最有影响力的研究人员或机构、趋势或特定研究领域的新趋势,以及研究人员与特定领域潜在合作者之间的合作模式。拥有这些信息的决策者可以做出资助决策,制定研究政策和战略。

[4] 不可否认的是,与任何其它技术一样,尽管这些方法的应用乍一看可能很有前途,但它们存在局限性和潜在问题。一些主要问题是:a)误用——定量分析结果可能被过度解释,导致评估不准确。B)引文数据——分析通常依赖于引文数据,这可能是存在偏见和不完整。c)选择偏差——分析的文献集合可能不代表给定领域的整个研究主体。d)引文偏差——一些研究人员可能试图通过自我引用他们的工作或参与引文卡特尔(citation cartels)来操纵定量测量。这种做法可能会提供有关研究质量或重要性的虚假信息

[5] 所有提到的问题都很严重,但是这种类型的分析所带来的好处可能超过这些问题造成的不利影响。考虑到这一点,多年来自然发展出许多研究前沿来传播和促进文献计量学的谨慎使用。这些研究前沿导致了两个连续的事件,它们构成了我们的现代文献研究场景,即科学数据库的创建和能够处理这些详细的科学文献数据的软件的开发

[6] 各种数据库应运而生;然而,由于复杂的原因,一些网站脱颖而出,例如Web of Science (WoS)、Scopus和PubMed。WoS是由Clarivirate运营的付费访问平台,提供大量科学文献的访问,涵盖科学、社会科学和人文学科等广泛学科。Scopus是爱思唯尔旗下的付费访问平台,涵盖科学、技术、医学、社会科学、人文等多个学科领域。最后,PubMed是一个由美国国立卫生研究院(NIH)运营的免费数据库,涵盖世界各地的生物医学文献

[7] 上述数据库提供了通过使用查询或搜索字符串来搜索和查找相关文章、书籍、会议记录和其他材料的可能性。最终获取的结果被编译在一个包含信息(元数据)的文件中,例如每个文档的作者姓名、机构、摘要等。当然,这些元数据在不同数据库的同一文档之间可能会发生冲突。此外,值得注意的是,每个数据库可能提供独特类型的元数据,例如文档被下载的日期和时间

[8] 许多文献计量软件被开发来处理数据库生成的文件,这些文件可能包含大量文献信息,具体取决于搜索字符串。文献计量软件的主要关注点是提供准确、可靠和透明的指标,可用于评估研究影响和生产力,需要仔细关注数据质量和方法

[9] 还值得注意的是,人工智能最近极大地帮助了包括自然语言处理(NLP)在内的许多知识领域的进步。这些进步的实现要归功于深度学习模型,或者换句话说,可以从大量数据中学习的神经网络模型。例如,人工智能和文献计量学可以结合使用来识别研究主题集群(主题建模)、总结相关概念和关系(文本摘要)以及分析许多文献计量结果(使用 chatGPT 的 NLP 任务)。这些任务之所以成为可能,是因为使用了词嵌入技术(Embeddings),这是一种在高维向量空间中表示单词、短语或其他对象的技术。这些向量旨在捕获它们所代表的对象的语义和上下文含义。将单词转换为向量,然后使用相同的向量作为深度学习模型的输入,使得开发算法来理解和生成类人语言成为可能

[10] 因此,pyBibX,一个由人工智能工具驱动的 Python 库,是对文献计量分析的又一贡献。文献计量分析是科学研究的重要工具,可以洞察研究趋势,识别重要的研究人员,并评估科学出版物的重要影响。然而,传统的文献计量分析方法通常非常耗时并且需要手动操作。使用人工智能技术可以显着提高文献计量分析的准确性和效率。随着科学出版物的指数级增长,需要更复杂的文献计量分析技术来应对生成的大量数据。人工智能技术可以快速、准确、客观地处理大量数据,使研究人员能够获得原本无法获得的见解。从文献计量分析中获得的见解可以为研究资助决策提供信息,指导战略规划,并帮助制定促进科学研究的政策。因此,创建一个利用人工智能技术进行文献计量分析的工具可以为科学界和整个社会带来巨大的好处。

[11] 全文共分为五个部分,包括引言。在第2节中,我们将讨论pyBibX的主要目标,并将其功能与其他文献计量软件进行比较分析。第3节介绍pyBibX使用的相关元数据,以及在合并来自不同数据库的信息时遇到的主要困难。在第4节中,我们将展示该库关于探索性数据分析(EDA)、网络分析和人工智能工具应用的能力。并对所得文献计量分析结果进行了讨论。最后,第5节给出了结束语。

4 相关工作

[1] 本节介绍了pyBibX的独特特性与其他著名的文献计量工具的比较评估。通过这种分析并置,我们试图确定pyBibX的相对有效性和优点,从而突出使用pyBibX的潜在优势;我们试图培养对它在塑造未来文献计量分析景观中的作用的全面理解

[2] 有许多文献计量软件可用来进行文献计量分析和可视化。表01显示了一些突出的例子。

[3] 表01比较了15种文献计量分析工具,展示了它们独特和共同的特点。该表除了名称列外,还包括以下列:数据源、环境和版本。

[4] 数据源:每个工具或库都利用特定的数据源,最流行的是PubMed、Scopus和WoS。Bibliometrix、LitStudy、metakknowledge、Publish or die和VOSviewer扩展了它们的兼容性,包括其他数据库,如PubMed、Dimensions、Cochrane等。值得注意的是,Bibexcel需要对WoS数据库进行调整。

[5] 环境:该表字段重点介绍每个工具在其上发挥作用的环境或平台。许多工具,如pyBibX和BiblioTools,作为Python库运行,而其他工具,如CiteSpace和CitNetExplorer,是基于java的应用程序。Bibexcel和Publish or die是专为Windows设计的,而Bibliometrix是一个R包。同时,Sci2 Tool、SciMat和VOSviewer为Windows、macOS和Linux提供多平台支持。环境的选择最终取决于用户首选项、可访问性和特定的项目需求。

[6] 版本:该表字段显示了每个工具的版本号和发布年份。最近更新的工具,如pyBibX (2.9.3, 16-April-2023), Bibliometrix (4.1.2, 07-March-2023), CiteSpace(6.2。R2, 2023年3月26日),更有可能包含最新的功能和增强。另一方面,像Bibexcel(1.6.4, 2017)和Tethne(0.8, 2016年6月21日)这样的老工具可能不会提供最新的改进。版本号和更新是至关重要的,因为它们表明开发人员正在积极地发布更新,以完善特性、修复bug或引入新功能,确保他们的工具与现代文献计量分析技术保持兼容。

[7] 如表01所示,文献计量工具在数据源、环境和版本列中显示了一系列的相似性和差异。尽管存在差异,这些文献计量工具迎合了不同的研究需求和偏好,为研究人员提供了广泛的文献计量分析和可视化选项,以满足他们的需求。

[8] 表02(该表格仅代表一家之言,用作参考即可) 对表01中的文献计量工具进行了深入的比较,强调了它们的EDA、网络分析和人工智能能力。EDA功能包括工具的初步数据分析能力,模式和趋势识别,以及数据可视化,使研究人员能够发现见解和制定假设。网络分析能力表明该工具在检查和可视化实体(如作者、引文和关键字)之间复杂关系方面的熟练程度,从而帮助研究人员破译数据结构和动态。人工智能能力利用深度学习技术,如主题建模、嵌入向量、文本摘要和一般NLP任务,以提高工具的有效性。

[9] 在表02中,这些工具共享的最常见的功能包括引文分析、协作分析和世界协作分析,许多工具支持相似度分析和主题建模。pyBibX和Scientopy都提供了广泛的特性,涵盖了表02中的大部分功能。CiteSpace、CitNetExplorer、CRExplorer、metakknowledge、Tethne和VOSviewer主要关注与引用相关的分析,几乎没有额外的功能 (往往会结合其它的库进行分析,功能并不局限表中提到的那些) 。Bibexcel、BiblioTools、Litstudy、Sci2 Tool和SciMat专注于数据操作和/或EDA,有些还提供引文、协作和主题分析。R- package Tool: Bibliometrix是列表中唯一的R包,它提供了各种功能,包括数据操作、EDA和各种类型的分析。然而,pyBibX以其广泛的特性集脱颖而出,包括独特的特性,如嵌入、文本摘要和chatGPT集成。另一方面,Publish or Perish以其简约的方法而闻名,主要关注 EDA。

[10] 通过对比这两个表,我们可以看出一些见解和模式:pyBibX、BiblioTools、Litstudy、metakknowledge、Scientopy和Tethne都是具有不同功能的python库。pyBibX和Scientopy是其中功能最丰富的,提供了数据操作、EDA和各种可视化和分析技术,使它们适合于研究人员在一个工具中寻找广泛的功能。Litstudy和SciMat也提供了相当多的功能,而BiblioTools和Tethne则更擅长于引文和协作分析。基于java的应用程序,如CiteSpace、CitNetExplorer和CRExplorer主要关注引用、协作和相似度分析。它们共享类似的功能,但没有一些python库那么全面。Bibexcel和Publish or Perish是基于windows的具有独特功能的工具。Bibexcel需要对WoS的纯文本进行数据适应,并依赖于Excel,而Publish or Perish支持更广泛的数据源。但是,与列表中的其他工具相比,这两个工具的功能都很有限。Bibliometrix是列表中唯一的R包。它提供了广泛的功能,包括数据操作,EDA,可视化,和各种类型的分析,使其成为熟悉r的研究人员的通用选项。此外,Bibliometrix, Litstudy, metakknowledge,和Publish or Perish扩展他们的支持到各种数据源,为研究人员使用不同的数据库提供了更多功能。Sci2 Tool、SciMat和VOSviewer在Windows、macOS和Linux平台上都是兼容的,每个平台都提供了不同范围的特性。Sci2 Tool和SciMat涵盖了多种分析和可视化技术,而VOSviewer专注于可视化,缺乏数据操作和EDA功能。

[11] 将pyBibX和chatGPT集成在文献计量学分析中,提供了一种开创性的方法,提升了整个文献计量学领域。chatGPT与pyBibX的融合简化了解释和理解复杂的文献计量结果的过程。ChatGPT的会话功能使用户能够与分析软件进行无缝交互,提出问题并获得相关的答案。这种交换促进了见解和模式的澄清,使研究人员能够很容易地理解基本信息并识别趋势,而无需进行费力的手工数据探索。

[12] 此外,chatGPT与pyBibX的整合,通过弥合文献计量学与NLP之间的差距,促进了跨学科研究。这种协同作用促进了可以进一步推进这两个领域的新方法和技术的发展。因此,研究人员可以受益于更强大和有效的文献计量工具,使他们能够解决日益复杂的研究问题。这种强大的组合将重塑研究人员采用文献计量分析的方式,推动创新,解锁新的见解。

5 科学数据库和元数据利用

[1] 最常用的三个科学数据库是WoS、Scopus和PubMed。虽然这些数据库在对科学文献的覆盖方面有相似之处,但它们也有独特的特点使它们与众不同。在医学等特定领域工作的研究人员可能会发现PubMed最相关,因为它深入地涵盖了生物医学文献。另一方面,在跨学科领域工作的研究人员可能会发现WoS或Scopus更有价值,因为它们涵盖了广泛的主题。

[2] 关于这些科学数据库提供的文档元数据,它们都是一组结构化信息,描述每个文档的内容和上下文。数据库之间的结构化信息不一样。差异可能由于各种因素而产生,包括索引方法、错误或遗漏、不同的文档版本以及数据库的范围和焦点。因此,在多个数据库中索引的文档可能呈现不同的元数据。例如,总引用数可能表示不同的总计数。表03显示了元数据项和每个元数据允许的技术。值得一提的是,除了“References”和“Times Cited”没有被收录在PubMed之外,所有的元数据项都可以从这三个数据库中获得。

[3] 表03显示了我们库使用的元数据,包括它们的定义和使用特定元数据的技术。这些技术被分成三组,EDA,网络分析和人工智能

[4] 表1(论文中并未给出表1) 中的EDA指的是各种技术和方法,这些技术和方法可用于分析文档的元数据,以揭示模式、关系和趋势。表1中列出的技术包括:

1) 作者生产率图:表示作者生产率随时间变化的图形。它有助于跟踪作者的输出,并确定研究模式。

1) 作者生产率图:表示作者生产率随时间变化的图形。它有助于跟踪作者的输出,并确定研究模式。

2)条形(柱状)图:一种用于显示分类数据的常见类型的图,在比较两个变量时特别有用。我们的库提供了许多bar plot选项,将在第3节中讨论。从本质上说,每个选项都提供了研究元数据的独特视角,可以用来洞察研究领域,如最具影响力的作者、被引用最多的文档和该领域使用的最常见的关键词。通过在柱状图上可视化这些数据点,研究人员可以更好地理解元数据中的趋势和模式,并使用这些信息来通知他们的研究工作。

3)EDA报告:提供描述性统计和元数据可视化的摘要报告。在数据分析中,洞察数据、识别模式和关系以及验证假设是至关重要的一步。该报告提供了研究的时间跨度,国家和机构的总数,以及来源和参考文献的总数。该报告还包括文档中使用的语言、文档总数、文档类型和每个作者、机构、来源和年份的平均文档数量的信息。此外,该报告还提供了作者数量、作者关键字和合作伙伴的信息。最后,报告包括本地最高h-Index和总被引次数的信息,以及每个作者、机构、文档和来源的平均被引次数。

4)演化图:这是一个术语或主题随时间变化频率的图形表示。它是可视化数据中的趋势和模式的有价值的工具,可以用来识别随着时间的推移行为或模式的变化。

5)N-Grams:一种从文本中提取单词模式的技术,将文本分割成𝑛单词的连续序列。

6)投影:一种将高维数据转换为低维空间的方法,同时保留数据点之间的结构和关系。数据投影的目的是降低高维数据的复杂性,使其更有效地可视化和可解释。可以使用两种算法,由McInnes等人(2018)开发的统一流形逼近和投影(UMAP),或截断奇异值分解(TSVD)。

7)桑基图:这个图表显示了文档在七种元素(作者、国家、机构、来源、作者的关键字、加上关键字或语言)的任意组合之间的流动。在桑基图中,线的宽度代表科研生产的流程,节点代表不同的元素。

8)词云图:这是文本中最常出现的单词的图形表示,每个单词的大小反映其出现频率。它们有助于快速识别大型文本数据语料库中最常见的主题。需要注意的是,wordcloud有其局限性,因为它们不能提供文本数据的内容或上下文的详细分析。因此,它们应该与其他文本分析技术一起使用,以便更全面地理解数据。

[5] 表1中的Network Analysis列引用了用于分析元数据中不同元素之间的关系和交互的技术,因为它们对于理解所有研究的底层结构和动态非常有用。这些技巧包括:

1)邻接分析(Adjacency Analysis):识别元数据中不同元素之间的邻近性和连接性,将得到的网络结构可视化。

2)协作分析:它用于识别元数据中共同出现的作者或机构,并可视化它们之间的协作模式。

3)世界地图协作分析:它用于绘制元数据中作者或机构的位置,并在全球范围内可视化它们之间的协作模式。

[6] 表1中的人工智能列指的是将深度学习算法应用到元数据中以生成洞察力和揭示模式的技术。这些技巧包括:

1)词嵌入:这种技术可以将单词或短语表示为高维空间中的向量,可用于识别元数据中不同元素之间的相似性和关系。

2)文本摘要:这是一种用于生成元数据中文本数据的摘要的技术,它对于快速理解文档的要点和主题非常有用。可以应用抽象摘要和提取摘要。

3)主题建模:这是一种用于识别元数据中的底层主题或主题的技术,它对于理解文档的结构和内容非常有用。

4)一般NLP任务:该特性使用chatGPT来分析文献计量结果。可以分析的结果有EDA报告、WordCloud、N-Grams、Evolution Plot、Sankey Diagram、Authors Productivity Plot、Bar Plot、引文分析、协作分析、相似度分析和世界地图协作分析。研究者可以输入任何问题,以帮助理解文献计量结果。

[7] 如前所述,关于数据库中的元数据的最后一个需要考虑的问题是合并两个或多个数据库的信息。合并来自不同来源(如Scopus、WoS和PubMed)的元数据具有挑战性,因为存在几个问题。首先,这些数据库可能使用不同的元数据格式和标准,这可能在合并数据时产生不一致和错误。第二,数据库可能有不同的覆盖范围和选择标准,导致可供分析的数据存在差异。第三,数据库的准确性和完整性可能不同,这可能会影响合并数据的质量。最后,元数据可能包含错误、重复或缺少值,从而使合并过程更加复杂。虽然我们的库允许手动编辑元数据元素,但它只能解决小规模的问题,因为纠正大量的文档被证明是一项难以理解的工作。

[8] 一种可能的解决方案是遵循特定的顺序并避免覆盖引用元数据。这种方法包括选择一个数据库(例如,PubMed),并使用它作为从其他数据库合并数据的参考。然后将较新的元数据添加到引用数据中,但只包含引用中尚未出现的新信息。此过程避免覆盖现有的元数据,并确保合并的数据集包含所有可用的信息,而没有重复。

[9] 但是,可以注意到这个合并过程的顺序保留了之前的数据库,并且合并顺序可能会影响最终的结果。例如,合并一个WoS数据集后接一个Scopus数据集将不会产生与合并一个Scopus数据集后接一个WoS数据集相同的结果(相当于左连接,以第一个数据库为为准)。从用于元数据合并过程的WoS或Scopus数据集开始,反映出研究人员对所选数据库的信心。从另一个数据库添加数据,然后补充现有的数据集。如果合并过程从WoS开始,则Scopus数据将添加到元数据中,反之亦然。

[10] 尽管如此,通过遵循这种方法,仍然可以创建高质量的、综合的数据集,该数据集利用了多个数据库的优势,同时避免了合并不一致和不完整的元数据所带来的挑战。

6. pyBibX文档集

[1] 由于我们的目标是展示python库pyBibX的强大功能,所以我们选择在演示中使用有限范围的搜索字符串。这个决定使读者更容易理解我们突出的概念。但是,需要注意的是,我们的库可以处理更复杂的搜索字符串,并为用户提供了广泛的功能来探索。我们鼓励用户访问pyBibX主页https://pypi.org/project/pyBibX,以了解更多关于库的特性和探索其功能。

[2] 为了展示功能,我们在Scopus、WoS和PubMed数据库中搜索了标题中包含以下查询的文档——“多标准决策分析”——发布时间截止到到2023年1月1日。我们已经下载了每个数据库可以提供的所有文件信息。其中,Scopus (mcda_scopus.bib)、WoS (mcda_wos.bib)和PubMed (mcda_pubmed.txt)获取的文件可以通过bit.ly/3XYK3eB访问(这个链接失效了,文件保存在github项目中的assets文件夹中)。

[3] 该搜索在Scopus中找到了234个文档,在WoS中找到了206个,在PubMed中找到了10个。但是,在WoS中只有30个文档与Scopus不同,在PubMed中只有一个文档与Scopus和WoS的联合搜索不同。根据Scopus、Wos和PubMed的合并订单进行的研究总共有265个文档。

[4] PyBibX还可以根据各种标准、文档类型、年份、来源、布拉德福德定律(Bradford’s Law, Bradford, 1934)的来源、国家、语言和抽象的存在来过滤文档。布拉德福德定律是一种书目数据的统计模式,其中少数来源对特定研究领域的文献有重要贡献。布拉德福德定律通常被表示为一个三区模型,其中核心来源(区1)贡献了最多数量的文档,其次是来自第二区相对较少的文档,最后是来自第三区的许多文档。

[5] 然后,我们有一个额外的步骤,其中筛选了265个文档,只接受分类为“Articles”、“Conference Papers”、“Meeting abstract”和“Reviews”的文档进行分析。对于这些文件的检索年份、来源或国家没有任何限制。但是,这些文件必须用英文书写,并载有摘要。这个筛选器产生了184个文档,表示我们的最终数据集,我们将在以下部分分析这些数据集。

[6] 所有184份文件都有一个从0到183的身份号码。此外,每个作者都被分配了一个ID标签“a_#”,其中#以0开头,以元素总数减1结束。类似地,每个来源被分配一个ID标签“j_#”,而机构被分配一个标签“i_#”。每个国家都有“c_#”的标签。每个作者的关键字被标为“k_#”,每个关键字的加号被标为“p_#”。此外,每个文档中引用的每个引用都会收到一个“r_#”标签(如果可用);唯一的例外是当引用是184个文档之一时,因此它的原始标签仍然保留。这个标签系统有助于以一种不那么复杂的方式识别和可视化不同的元数据元素。

[7] 以下部分包括EDA、网络分析和人工智能技术,以进一步分析元数据元素并产生见解。这些步骤可以通过bit.ly/3mcP2eb访问,它为进行这些分析和更详细地探索数据提供了一个用户友好的在线界面(该链接也失效,可以借助提供的测试文件进行)。

6.1 探索性数据分析

[1] 在本节中,我们将对合并的数据集执行EDA。数据分析中的这个重要步骤帮助我们理解数据的底层结构、模式和关系。此外,此步骤还提供了合并数据集的全面概述,并使我们能够识别可能为进一步分析提供信息的关键特性和趋势。初步统计报告见表04。

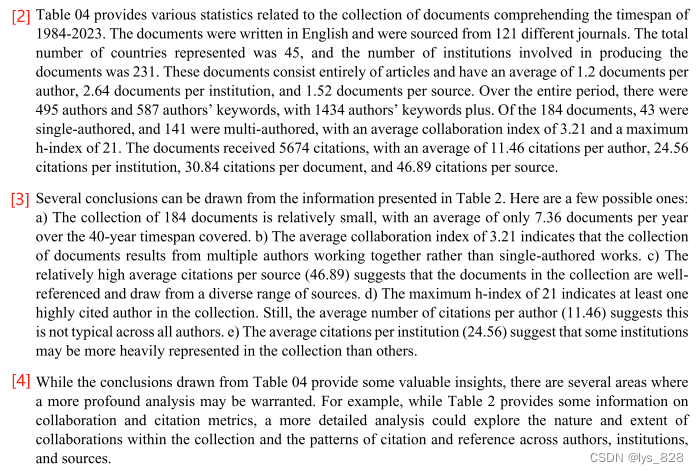

[2] 表04提供了1984-2023年期间文件收集的各种统计数据。这些文件是用英文写的,来自121种不同的期刊。所代表的国家总数为45个,参与编制文件的机构数目为231个。这些文件完全由文章组成,平均每个作者有1.2个文件,每个机构有2.64个文件,每个来源有1.52个文件。在整个期间,共有495位作者和587位作者的关键字,其中1434位作者的关键字plus。184篇文献中,单作者43篇,多作者141篇,平均协作指数为3.21,h指数最大值为21。文献被引5674次,平均每位作者被引11.46次,平均每家机构被引24.56次,平均每篇文献被引30.84次,平均每家文献被引46.89次。

[3] 从表2中 (论文中未给出) 提供的信息可以得出几个结论。a)收集文献184篇,相对较少,40年的时间跨度平均每年只有7.36篇。b)平均协作指数为3.21,说明文档的集合是由多个作者共同工作的结果,而不是由单个作者共同工作的结果。c)相对较高的平均被引次数(46.89次)表明,该合集中的文献被充分引用,来源广泛。d) h-index最大值为21,表示文集中至少有一位高被引作者。尽管如此,每位作者的平均被引用次数(11.46次)表明,这并不是所有作者的典型情况。e)每个机构的平均被引次数(24.56)表明,一些机构可能比其他机构在馆藏中出现的次数更多。

[4] 虽然从表04得出的结论提供了一些有价值的见解,但有几个领域可能需要进行更深刻的分析。例如,虽然表2提供了一些关于合作和引用指标的信息,但更详细的分析可以探索集合内合作的性质和范围,以及作者、机构和来源之间的引用和引用模式。

[5] 继续讲EDA,进一步了解文档的一种方法是使用wordcloud和n-gram进行文本分析。通过从文档的摘要生成wordcloud和n-grams (n是大于1的正整数),可以确定作者使用的共同主题、主题和术语。图01显示了两个探索性分析的结果,一个wordcloud和一个3- gram(一个包含3个单词的n-gram)。

[6] 根据从文档的摘要中生成的wordcloud中突出显示的单词(图01上图),似乎集合的主要焦点是决策,特别是在多准则决策分析(MCDA)和模糊逻辑方法的背景下。这些术语在wordcloud中的突出位置表明,文档的收集可能有利于对决策过程和技术感兴趣的研究人员和实践者。对集合的进一步分析可以探索与MCDA和模糊逻辑方法相关的具体应用、挑战和创新。

[7] 3-gram分析(图01下图)提供了对文档中讨论的特定概念和技术的见解。但是,文档摘要首先通过删除英语停止词和特定于该知识领域的下列自定义停止词来规范化:" analysis “、” criteria “、” decision “、” elsevier “、” making “、” mcda “、” multiple “、” reserved “和” right "。归一化后出现频率最高的3-gram为“interval-type-fuzzy”,频率为34,说明该概念在文献收集中是一个关键主题。3-gram的“interval-valued-intuitionistic” and “valuedintuitionistic-fuzzy”的出现频率均为24,突出了这些概念的重要性。

[8] 3-gram中“type-fuzzy-sets”出现17次,说明模糊集和相关技术也是相关课题。有趣的是,“analytic-hierarchy-process”出现了13次,证实了层次分析法(AHP)是一种众所周知的多准则决策方法。这个图形是交互式的,将光标悬停在它上面可以提供关于结果的更多信息。

[9] 在使用诸如wordcloud和n-gram等技术研究数据集之后,EDA的下一步是将摘要转换为数字表示。184个文档的摘要可以转换成术语频率逆文档频率(Term Frequency- inverse Document Frequency, TF-IDF)矩阵或词嵌入。一旦文档以这种方式表示,就可以应用降维技术(如UMAP或TSVD)将维降为两个维,以实现可视化目的。基于降维技术的文本聚类被广泛应用于文本分析;通过降低数据的维数,这些技术可以揭示文本数据的底层结构,使其更容易探索和解释。最后一步是使用k-means算法将文档分组到簇,根据距离度量将文档分组到k个自然组中,并绘制结果,每个簇用不同的颜色突出。通过可视化聚类,研究人员可以快速识别数据中的模式和关系,并使用这些信息对他们的分析的下一步做出更明智的决定,并帮助研究人员发现新的见解和研究方向。

[10] UMAP和Embeddings的结合通常更适合这种方法,因为UMAP是一种比TSVD更先进的降维技术,更适合保存数据的全局结构。此外,UMAP更有效地处理具有复杂结构的高维数据,这在NLP中很常见。另一方面,TSVD和TFIDF通常比UMAP和Embeddings更受青睐,因为它们的速度和效率都相对较快,并且可以处理大量文本数据。然而,必须注意的是,技术的选择最终应该取决于分析的文本数据的具体特征。图02显示了使用UMAP和Embeddings组合的184个文档摘要的投影。

[11] 在图02中,我们任意选择了2个集群来可视化地表示转换后的抽象。此图是一个交互图,将鼠标悬停在一个节点上,可以显示额外的文档ID、群集编号和完整的文档引用信息。投影允许我们识别出一个高度同质的集群(紫色),与其他集群不同,这表明该集群中的文档可能共享一个共同的主题或主题。对这一集群的进一步研究可以为这一主题或主题提供见解,并可能揭示新的研究途径。

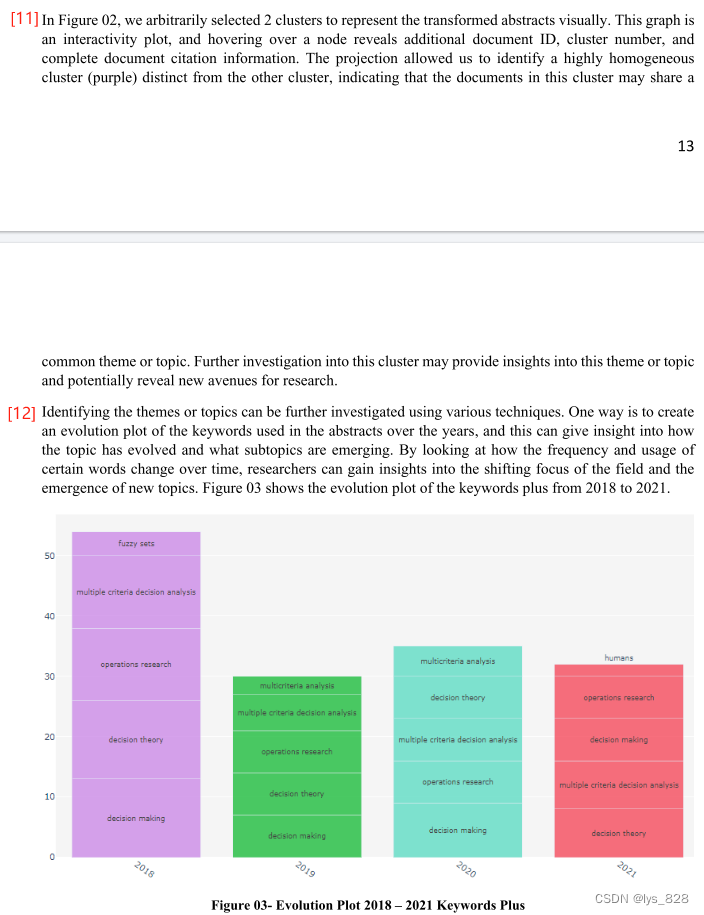

[12] 可以使用各种技术进一步研究确定主题。一种方法是创建多年来在摘要中使用的关键字的演变图,这可以洞察主题是如何演变的,以及出现了哪些子主题。通过观察特定词汇的使用频率和用法如何随时间变化,研究人员可以洞察该领域的焦点转移和新话题的出现。图03显示了2018 - 2021年关键词+的演化图。

[13] 图03显示了研究主题中一些有趣的趋势。四年中最常出现的关键词是:“多准则决策分析”、“决策理论”、“运筹学”和“决策制定”。这些关键词表明,在决策和分析方面的研究正在进行和活跃。特别是,“多标准决策分析”的流行表明继续关注这种决策方法。另一个有趣的发现是“人类”出现在2021年的关键词中,这表明人们对决策中的人类因素越来越感兴趣。

[14] 该技术提供了研究重点随时间变化的支持性可视化。图表的交互性让我们能够轻松地探索特定的关键字频率,而时间特征是一个重要因素。然而,应该注意的是,主题建模还可以提取更深入的见解,并可能提供对潜在主题和主题的更细致的理解。

[15] 与进化情节相结合,我们还可以使用树形图来帮助我们理解所有184个文档的主要中心主题。通过将此技术应用于所有184个文档中的整个关键字集,我们可以快速识别最经常出现的关键字,这些关键字可能表示重要的主题和主题。图04显示了前15个关键字plus的结果。

[16] 图04显示了184个文档中关键词plus出现的频率。最常见的是“decision making”,出现次数122次,其次是“multiple criteria decision analysis”,出现次数88次,“decision theory”,出现次数80次。“运筹学”和“模糊集”的频率分别为69和27。关键词“运筹学”在文献中出现的频率较高,表明该学科与决策和MCDA相关。在文档中,关键词“模糊集”出现的频率较低,表明与“运筹学”相比,它是一种不太受欢迎的方法。然而,这仍然表明,“模糊集”在这一背景下是一个相关的话题,可以进一步研究。同样有趣的是,关键词human的频率为23,humans的频率为22,这表明在决策过程中有一个以人为中心的方法。

[17] 如前所述,桑基图显示了七个元素的任意组合之间的文档流:作者、国家、机构、来源、作者的关键字、关键字plus或语言。为了继续我们的分析,我们可以显示作者和关键词之间的流,图05显示了前10个流。

[18] 图05显示了作者和关键字之间的前10个流程,加上Angelis A.和Kanavos P.,一个流程和Chen T.-Y。有八个。关键词加号主要与树形图中确定的主题一致(图04),包括“决策制定”、“多准则决策分析”、“运筹学”、“决策理论”和“模糊集”。值得注意的是,Chen T.-Y。他似乎是最多产的作者,研究的主题范围很广。这些结果表明,在作者的共同兴趣之间存在潜在的合作可能性,为该领域创造更多的贡献,并探索研究机会。

[19] 确认Chen T.-Y是一个多产的作者,我们可以使用图06中的作者生产率图,显示了所有年份中最多产的10位作者。

[20] 图06显示了Chen, t - y。从2011年到2022年,连续发布了最多的文件。此外,我们可以突出Angelis、A和其他具有显著生产力的作者。这个图也是交互式的,将鼠标悬停在一个节点上显示文档ID,提供关于每个作者的出版物的进一步信息。通过检查最著名的作者的出版物,研究人员可以更好地了解该领域的研究现状,并确定需要进一步调查的领域。

[21] 最后,我们可以使用条形图验证一些关于元数据的额外统计信息,从而结束EDA。可显示的选项包括:每年的文献,每年的引文,过去每年的引文,洛特卡定律(Lotka, 1926),每份文件的来源,每份引用的来源,每份文件的作者,每份引用的作者,每份h索引的作者,布拉德福德定律,每份文件的机构,每份引用的机构,每份文件的国家,每份文件的国家,每份文件的语言,每个文档的关键字加上作者的关键字。继续我们的分析,我们可以验证文档的生产是否在过去几年里下降了,因此图07显示了每年的文档图。

[22] 图07显示了该领域发表的文献数量的积极趋势,这表明人们对该研究的兴趣越来越大。令人鼓舞的是,在整个期间,每年发表的文章平均数量几乎为5篇,这表明对该领域的兴趣始终如一。此外,考虑到过去5年(2018-2022年),每年发表的文件平均数量增加到近17份,表明人们对这一领域的兴趣更加浓厚。这些结果为研究人员在该领域做出贡献和建立合作提供了许多机会。

6.2 网络分析

[1] 现在EDA已经完成了,我们可以继续进行网络分析,它主要关注科学出版物、作者和期刊之间的关系。在网络分析中,出版物、作者和期刊被表示为节点,它们的关系被表示为边。网络分析可以识别作者或机构之间的合作模式,映射一个领域内的想法,或识别一个特定研究领域内的关键出版物或期刊。

[2] 邻接分析研究实体之间的关系或连接,通常以网络或图的形式表示。引文分析是邻接分析的一种,文献之间的连接用节点之间的链接来表示。每个节点表示一个文档,而链接表示从一个文档到另一个文档的引用。在我们的方法中,蓝色节点表示每个文档,红色节点表示它的引用。通过可视化这些节点及其连接,我们可以了解文档是如何关联的,以及在多个文档之间经常引用哪些引用。图08显示了被引用至少四次的文档和引用的子集的引用分析。

[3] 图08显示了提到的文档和引用的子集,并突出显示了被文档“38”(CHEN, 2020)、“77”(CHEN, 2018)、“86”(ZHANG et al. 2017)、“129”(CHEN, 2014a)、“132”(CHEN, 2014b)和“147”(CHEN, 2011)引用的参考文献“r_602”(ATANASSOV, 1986)。这个子集由19个引用(红色节点)和28个文档(蓝色节点)组成,与数据集中的184个文档相比,这些文档看起来相对较小。然而,需要注意的是,这个子集是根据至少被引用四次的标准特别选择的,这表明它们在研究领域内具有更高的重要性和相关性。突出的参考文献表明,Atanassov关于直觉模糊集的工作被Chen T.-Y引用了五次。还有一次是由张等人。暗示着陈,t.y。他可能对这个话题特别感兴趣,因为多年来他多次引用这篇文章。

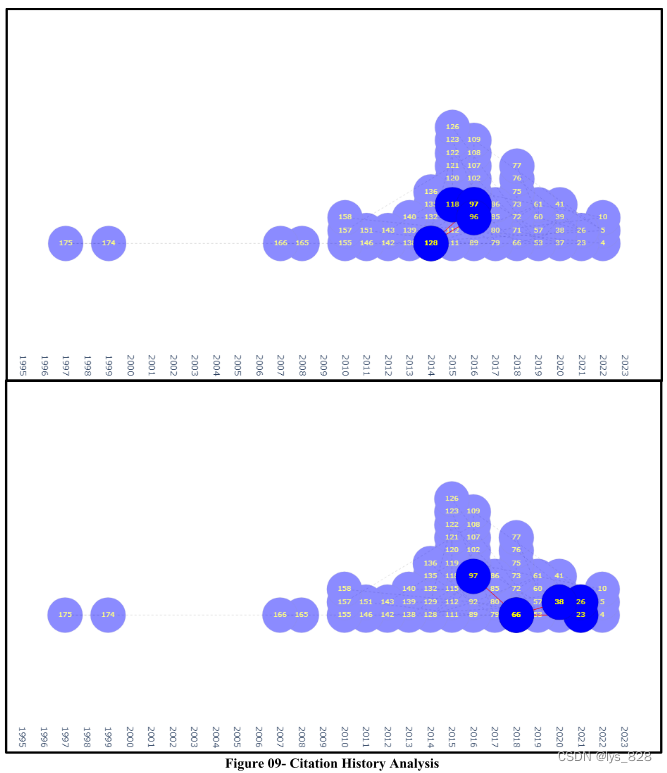

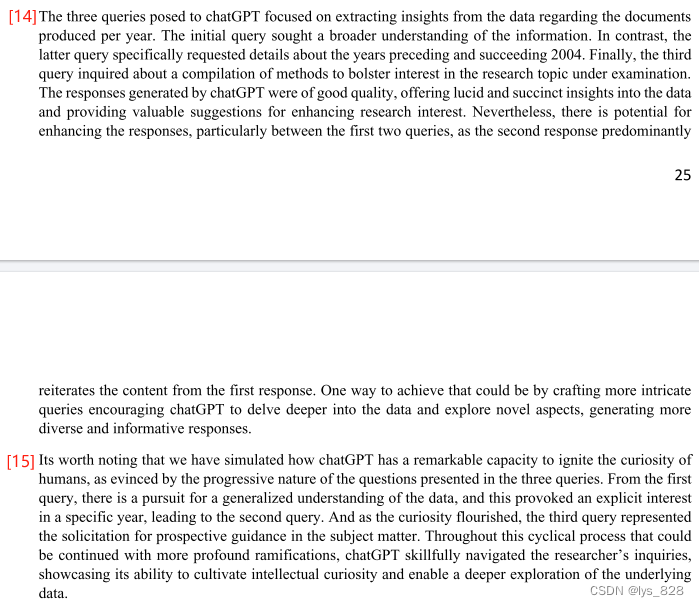

[4] 引文历史分析是了解特定研究领域演变的强大工具。分析 184 篇文档之间的引用可以确定重要贡献、关键作者和新兴趋势。这种类型的分析可以帮助研究人员确定文献中的差距、潜在的合作者以及研究的新方向。此外,它可以帮助跟踪特定出版物随时间的影响以及它如何影响后续研究。图 09 显示了引文历史分析,其中突出显示了文献“97”。

[5] 图 09 描绘了一个由标记为“97”的中央文档引用的文档网络。上图揭示了由“97”引发的连锁反应延伸到过去的文档。据网络分析,“97”引用了“118”和“96”,而“97”和“96”引用了“128”。下图显示了相同的连锁反应,但这次转向未来的文档。标有“66”的文件似乎引用了“97”。文献“38”和“23”引用了“66”,最后“26”引用了“38”,从而完成了网络。这种引文网络的全面可视化为不同文献和作者之间的关系提供了宝贵的见解,使研究人员能够得出有关特定领域随时间演变的许多结论。通过检查个人作品和作者的引用模式,研究人员可以识别塑造某个领域发展的合作和隶属关系。在此示例中,所有文档都是 Chen, T.-Y 发表的作品。

[6] 根据我们的 EDA,以最多产的研究人员 Chen, T.-Y. 为中心进行协作分析将会很有趣。根据 Castañer 和 Oliveira (2020) 的说法,协作分析是一种用于研究为实现共同目标而协作的个人、群体或组织之间的互动和关系的方法。协作分析有助于了解协作网络的结构、运作方式以及如何利用它们来促进协作、知识共享和创新。图 10 显示了研究员 Chen, T.-Y 的扩展协作网络。

[7] 图 10 显示 Chen, T.-Y.仅与其他四位研究人员合作,包括 Lin, Y.-L.、Chang, C.-H.、Tsao, C.-Y. 和 Wang, J.-C.。此外,Tsao, C.-Y.与Wang, J.-C., Lin, Y.-L. 合作。与 Ho, L.-H. 和 Chang, C.-H. 合作。与 Rachel Lu, J.-F. 合作。因为陈,T.-Y。他撰写了 184 篇文献中的 35 篇,显然他是该领域最多产、最具影响力的研究者。然而,他只与其他四位研究人员合作的事实表明,如果可能的话,该领域可能还有更多合作和跨学科研究的空间。

[8] 我们可以采取类似的方法,将注意力转移到文档上,并检查它们如何相互“协作”。由于文档无法进行传统意义上的协作,因此我们需要进行相似性分析。相似性分析是探索不同文档之间关系的一项有价值的技术,可以使用多种方法进行。一种流行的方法是书目耦合和共引方法,其中涉及分析不同文档中引用的参考文献以识别它们之间的模式和关系。在我们的示例中,我们将使用同被引分析来识别具有共同引用的文档。具体来说,我们将寻找至少有十个共同参考文献的文档,使我们能够识别与它们所涵盖的主题和所利用的来源高度相关的文档。图 11 展示了 184 篇文献的同被引分析。

[9] 在图 11 中,我们可以观察到七个不同簇的出现,这些簇标有紫色、红色、黄色、绿色、棕色、蓝色和粉色等颜色。通过放大黄色和绿色簇,我们可以看到它们之间的联系,这是两个簇之间的重要联系。紫色簇包含文件“89”和“113”;棕色组包括文件“149”和“91”;红色簇有文件“115”、“79”和“135”;黄色集群是文档“92”、“97”和“128”;绿色集群是文档“123”、“122”和“116”;蓝色簇包含文档“61”和“39”,最后,粉色簇包含文档“83”和“43”。有趣的是,我们发现 Chen, T.-Y.撰写了黄色、绿色、蓝色和红色集群中的文档,表明该作者的主题覆盖范围广泛。

[10] 分析黄色和绿色簇,“92-97”对拥有 14 个共同参考,“92-128”有 10 个,“97-128”有 20 个。黄色和绿色簇之间的链接“122-123” ,有10个共同参考。在绿色簇中,“123-122”有26个共同参考文献,“122-116”有13个。根据分析,可以得出结论,黄色簇和绿色簇中的文档之间存在实质性相似性,如下所示他们之间大量的共享参考文献就证明了这一点。两个集群(文档对“122-123”)之间的链接也显示出中等相似性。特别是绿色集群,其文档之间具有很高的相似度,“123-122”和“122-116”对具有许多共同的引用。这些发现表明黄色和绿色集群中的文档可能具有共同的研究主题和主题。

[11] 科学研究因协作而蓬勃发展,分析协作网络可以为研究人员和机构如何合作推进知识提供宝贵的见解。为了更全面地了解科学知识是如何产生和共享的,可以进行世界地图协作分析,以探索来自不同国家的研究人员和机构如何在研究项目上进行协作。此类分析可以揭示国际合作的模式和趋势,确定关键参与者和机构,并帮助指导资助决策和政策制定。图 12 显示了世界地图协作分析。(涉及地图的可视化一定要小心,原论文中Taiwan地区未被标记到China中,下图是处理过后的图片。可能原作者并没有留意每个国家的版图,只是引用了模块中的地图绘制方法,如果是我们自己发文章对于自己的国家边界应当特别敏感慎重)

[12] 图12显示了世界地图协作分析结果,强调了科学研究中协作的重要性,并揭示了国际协作中有趣的模式。该图显示,欧洲研究人员倾向于更频繁地与欧洲同行合作,这表明欧洲大陆内的合作网络很牢固。加拿大和中国成为重要的合作中心,这表明这些国家在促进全球科学知识生产方面发挥着重要作用。另一方面,分析还显示,巴西、智利和澳大利亚等国家的合作网络较弱,这可能表明需要加大力度促进这些地区的合作。世界地图合作分析为国际科学合作的模式和动态提供了宝贵的见解,可以为未来促进跨境合作和知识交流的努力提供信息。

6.3 人工智能分析

[1] 执行 EDA 和网络分析后,我们的下一步是使用人工智能工具来更深入地了解文档集合。特别是,基于深度学习技术的嵌入、主题建模和文本摘要可以帮助揭示数据中隐藏的主题和模式。通过自动识别和总结关键主题和趋势,这些工具可以提供更有效、更准确的方法来从大量文本数据中提取含义。

[2] 我们的研究将 UMAP 与词嵌入相结合,将摘要投影到低维空间并可视化它们的关系。词嵌入是使用 Reimers 和 Gurevych (2019) 开发的 Sentence-BERT 深度学习模型获得的。除了可视化摘要之间的关系之外,嵌入还可以用作其他深度学习技术的输入。通过使用这些嵌入作为输入,深度学习模型可以更好地捕获文本的语义和上下文。这些表示可以改善任务的结果,例如识别关键主题或生成简洁的摘要,展示嵌入在各种 NLP 任务中的多功能性和有用性。

[3] 主题建模是一种自动检测隐藏在一组文档中的主题和模式的方法。分析文本中的单词和短语模式可以识别经常同时出现的单词组,然后将其解释为主题,代表文档集合中的基本概念或想法。主题建模的主要目的是提供一种识别和理解大量文本数据中最重要主题的方法。使用 Grootendorst (2022) 开发的 BerTopic 深度学习模型进行主题建模的结果如表 05 所示。

[4] 根据表 05 中的结果,可以得出结论,主题建模已成功识别 184 篇文档中的两个主要主题。主题 0 最为突出,有 153 个文档,而主题 1 只有 31 个文档。与主题 0 相关的单词表明重点是“决策和偏好分析”,这是一个由有助于表征该主题的单词集支持的主题标签。中心文件陈(2016)的“96”主要代表了主题主题。另一方面,正如其相关词语所示,主题 1 似乎侧重于“卫生技术评估和患者护理”。核心文件是 Angelis (2018) 的“74”。这些发现表明,文件收集主要是决策和偏好分析研究,还有一小部分研究与卫生技术评估和患者护理相关。此外,这些发现得到了图 02 中提供的证据的支持。

[5] Chen (2016) 的“96”和 Angelis (2018) 的“74”所确定的核心文件可以使用抽象和提取摘要技术进行总结。抽象摘要涉及创建一个新的摘要来传达原始文本的基本信息。相比之下,提取式摘要涉及从原始文本中选择最重要的句子或短语来创建压缩版本。这两种技术之间的主要区别在于,抽象摘要需要创建准确传达原文含义的新文本。另一方面,提取摘要涉及从原始文本中选择和压缩文本。抽象摘要可能更具挑战性,但可能捕获原文的全部含义,而提取摘要更直接,但可能无法传达原文的全部含义。

[6] 两种摘要模型都采用了先进的技术;准确地说,提取摘要是使用 Derek (2019) 制作的 BERT 模型完成的。虽然 BERT 确实在众多 NLP 任务上取得了最先进的结果,但必须认识到,为了在特定领域的文档中获得最佳性能,可能需要进行微调。在特定领域的语料库上微调 BERT 可以更好地捕捉专业主题的细微差别、术语和上下文。这种量身定制的方法确保 BERT 更准确、更实用地应用于特定领域的任务。这会提高性能并更好地理解特定领域固有的独特特征。

[7] 另一方面,抽象摘要是通过使用Pegasus和ChatGPT(OpenAI,2023)来完成的,Pegasus是Zhang等人(2019)开发的一种复杂方法,ChatGPT(OpenAI,2023)是当前最先进的大型语言模型(LLM),并且并不总是免费访问的。这些技术的结果如表06所示,两个摘要都被用作输入。这些论文的原始摘要可以通过引用各自唯一的DOI编号在各自的科学期刊网站上方便地获取。

[8] 表 06 展示了 Chen (2016) 的核心文献“96”和 Angelis (2018) 的“74”的摘要和提取摘要。在将原始摘要与摘要进行比较时,很明显 PEGASUS 和 BERT 摘要遗漏了原始摘要中呈现的重要信息。 chatGPT 的摘要摘要提供了原始摘要的更加连贯和简洁的表示。

[9] 对于陈的作品,PEGASUS 的摘要摘要仅提供了作者所属单位的信息,与文档内容无关。另一方面,chatGPT 摘要摘要抓住了原始摘要的本质,讨论了区间值直觉模糊集的使用、包含比较的可能性以及线性和非线性规划模型的开发来估计标准权重和最优排序顺序。提取概括强调了区间值直觉模糊集理论及其在 MCDA 中的有用性。然而,它没有提供所提出模型的方法或应用的全面概述。

[10] 对于 Angelis 的工作,PEGASUS 的抽象总结仅提供了有关在 HTA 中使用 MCDA 的一般性陈述。 Chatgpt 摘要总结内容丰富,涵盖了该研究的重要方面,例如 MCDA 在 HTA 中的潜力、高级价值框架的实际测试以及转移性去势抵抗性前列腺癌的三种不同治疗方法的评估。同时,提取总结涉及该研究的背景、测量和结论,强调 MCDA 作为 HTA 的前瞻性方法。然而,它缺乏有关预先价值框架和正在评估的具体治疗方法的详细信息。

[11] 尽管 PEGASUS 和 BERT 总结技术尚未达到与 chatGPT 相同的熟练程度,但在应用程序中使用 chatGPT 时有必要强调显着差异,因为它需要付费 API 密钥或订阅才能访问更高级的模型。与此同时,PEGASUS 和 BERT 仍然可以免费使用,这一事实使得 PEGASUS 和 BERT 对更广泛的用户和研究人员更具包容性。此外,随着这些技术的不断发展,可以想象它们的性能最终可能会与chatGPT相媲美甚至超越。随着人工智能技术的快速进步,这些免费提供的摘要方法具有巨大的开发和改进潜力,最终成为那些无法或不愿意投资 chatGPT 等付费替代方案的人的宝贵资源。

[12] 在最后一步中,我们展示了 chatGPT 与我们图书馆的无缝集成,这是通过定制设计的功能实现的,这些功能简化了各种文献计量结果的检查和解释。其中包括 EDA 报告、WordCloud、N-Gram、进化图、桑基图、作者生产力图、条形图、引文分析、协作分析、相似性分析和世界地图协作分析。人类的好奇心和 chatGPT 的融合有可能增强理解力并揭示传统文献计量方法中的新观点。

[13] 以图07(按年份生成的文档条形图)为例,生成条形图后,研究人员可以提出任何有助于更好地解释结果的问题。我们将通过顺序执行一系列不同的查询来演示这种方法。

查询 1:给我关于给定信息的见解

回答:数据显示,从 1984 年到 2022 年,文档总体呈增加趋势。在 1984 年到 1995 年间,没有太大波动,因为所有文档的值几乎为 0除 1984 年和 1997 年之外的其他年份。1996 年至 2021 年期间,文件数量缓慢但稳定地增加,这在过去十年(2010-2020 年)更为明显。文件数量最多的是 2016 年,其次是 2020 年。文件数量在 2017 年下降至 9 份,2018 年和 2019 年再次增加至 18 份和 13 份。 2021 年,这些文件再次增加到 17 个。看来未来几年文件预计将保持在这个水平。 [原文如此]

问题2:2004年前后发生了什么?

回应:2004年之前,每年发布的文件数量很少,大多数年份没有新的文件。 2004 年发布了一份新文件。 2004年以后,文件数量逐年增加,2005年和2006年各发布2份文件,2008年发布3份文件。发布的文件数量持续稳定增长,2016年发布的文件数量达到峰值,达到22个。此后,发布的文件数量略有下降,但与2004年之前相比仍保持较高水平。[原文如此]

问题 3:给我列出一些提高对该主题的研究兴趣的方法。

回答: 1. 分析数据趋势,以确定推动或阻碍研究兴趣增长的因素。 2. 确定可以帮助扩大研究范围的潜在合作者。 3. 利用社交媒体和其他数字平台来推广研究并吸引更多关注。 4. 制定全面且有吸引力的研究计划,概述项目的目的和目标。 5. 制定外展策略,吸引公众参与并提高对研究的认识。 6. 利用现有的研究和数据为研究提供信息并提供额外的背景。 7. 制定全面的数据收集和分析计划以获取必要的信息。 8. 以具有视觉吸引力和全面的格式呈现数据,以更好地传达研究结果。 9. 在著名期刊上发表研究论文,以提高研究的知名度。 10. 参加相关活动和会议,与其他研究人员互动并讨论想法。 [原文如此]

[14] 重申第一个回复的内容。实现这一目标的一种方法是制作更复杂的查询,鼓励 chatGPT 更深入地研究数据并探索新颖的方面,从而生成更多样化和信息丰富的响应。向 chatGPT 提出的三个查询重点是从有关每年生成的文档的数据中提取见解。最初的询问是为了更广泛地了解这些信息。相比之下,后一个查询特别要求提供有关 2004 年前后年份的详细信息。最后,第三个查询询问了一系列方法,以增强对正在检查的研究主题的兴趣。 chatGPT 生成的回复质量很高,提供了对数据的清晰、简洁的见解,并为提高研究兴趣提供了宝贵的建议。尽管如此,仍有可能增强响应,特别是在前两个查询之间,因为第二个响应主要重申第一个响应的内容。实现这一目标的一种方法是制作更复杂的查询,鼓励 chatGPT 更深入地研究数据并探索新颖的方面,从而生成更多样化和信息丰富的响应。

[15] 值得注意的是,我们模拟了 chatGPT 如何具有激发人类好奇心的非凡能力,这从三个查询中提出的问题的渐进性质就可以看出。从第一个查询开始,人们就追求对数据的概括性理解,这引起了对特定年份的明确兴趣,从而产生了第二个查询。随着好奇心的增长,第三个查询代表了对主题的前瞻性指导的征集。在这个可能会产生更深远影响的循环过程中,chatGPT 巧妙地引导了研究人员的询问,展示了其培养求知欲和更深入探索底层数据的能力。

6.4 讨论

[1] 根据研究目标,pyBibX 的理论应用跨越多个维度,有助于促进文献计量分析理解的进步及其在塑造科学景观中的重要作用。通过结合先进的人工智能技术,pyBibX 完善了文献计量分析的方法论复杂性,为创新方法铺平了道路。换句话说,pyBibX 通过使用人工智能技术和人工智能辅助对话工具来增强文献计量学的理论基础,从而实现前所未有的新型协同作用。同时,对视觉优雅的强调加深了数据理解,促进了可视化理论和科学研究中有效沟通的最佳实践的发展。

[2] 值得注意的是,pyBibX 通过将先进的人工智能功能集成到其代码中,例如主题建模、嵌入向量、文本摘要和一般 NLP 任务,增强了 EDA 和网络分析的结果。人工智能功能的融合提高了文献计量分析的准确性和效率,揭示了传统方法可能错过的独特模式和趋势。实际上,pyBibX 通过减少通常与此类任务相关的手动工作量和时间消耗来简化文献计量分析过程。效率的提高使科学家能够更快地响应各自领域的新发现和发展。

[3] pyBibX 的一个显着特征是它能够促进研究人员和 chatGPT 之间的互动,使他们能够提出问题并根据分析结果获得全面的答案。这种互动加深了对数据的理解,加速隐藏知识的发现,最终促进科学研究的进步。凭借其创新功能,pyBibX 为研究人员提供了强大且富有洞察力的文献计量分析工具。

[4] 随着科学界的扩大和积累大量数据,对熟练和完善的文献计量分析工具的需求日益重要。 PyBibX 通过提供最先进的人工智能驱动的解决方案来满足这一需求,使研究人员能够灵活地探索复杂的数据集。其先进的人工智能功能的开创性融合为研究人员提供了保持学科先锋地位的手段,揭示隐藏的联系并为集体知识库做出贡献。

7 结论

[1] pyBibX 库是学术领域名副其实的资产,在分析科学数据、辨别模式和趋势以及生成促进协作的富有洞察力的可视化方面提供了宝贵的优势。该库的功效在于其能够从复杂的数据中提取有意义的见解,自动执行特定任务,并保持数据分析的准确性和一致性,从而降低人为错误的风险。我们的文献计量研究涵盖了多方面的方法,通过采用嵌入、主题建模和文本摘要等深度学习方法与 BERT、Sentence-BERT、BERTopic、Pegasus 和chatGPT。每种技术的成果都为研究人员节省了大量的时间和资源,使他们能够专注于假设制定、实验设计和手稿撰写等高级任务。简而言之,pyBibX 是学术界的一种工具,可以丰富书目信息的分析和综合。

1459

1459

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?