提示:本文仅适用于本人作业和部分新手所使用,如果本文有不适之处,敬请改正,感谢。

文章目录

- 一、搭建集群

- 二、配置完全分布式Hadoop

- 三、配置Spark Standalone模式的集群

- 四、启动并使用Spark Standalone模式的集群

一、搭建集群

(一)私有云上创建三台虚拟机

-

创建虚拟机的过程,这里就不再继续进行赘述,没有创建虚拟机的请先按照此篇博客《如何在OpenStack创建的私有云上搭建并配置虚拟机》把虚拟机搭建完毕后,再观看此篇博客

-

进入win7虚拟机启动远程桌面,在本机使用“win+r”进入“运行程序”,然后再输入“mstsc”,单击确定按钮,进入远程桌面对话框

-

进入远程桌面后,安装SecureCRT软件,下面会使用此软件进行操作

- 没安装过SecureCRT的可以参考此篇博客《SecureCRT的下载和安装》

本次所有需要使用到的包(可以自行网络下载,也可以使用我的包):

(二)利用SecureCRT软件分别登录三台虚拟机

1、如何连接虚拟机

- 先打开软件,单击快速连接按钮,打开连接对话框,输入IP地址(192.168.9.xxx)和用户名(root),单击继续按钮

- 输入密码,并勾选保存密码(后期就不用再重新输入密码了),然后单击OK,进入虚拟机

1.1、登录master虚拟机

1.2、登录slave1虚拟机

1.3、登录slave2虚拟机

2.为了使主机能够更加明容易识别出来,可以为相应的主机进行重命名

- 单击“连接”按钮,进入连接对话框后,鼠标右键单击相应的IP地址,出现子菜单框后,单击“Rename”选项

- 在文本框里面输入需要的主机名(master、slave1、slave2)

3.如果觉得本软件有点不美观还可以进入设置进行美化

- 单击“option”按钮,进入设置

- 单击“Emulantion”按钮,再单击“Termina”l的下级菜单,选择“Linux”

- 单击“Appearance”→“Current color schen”→“Font”→“Character encoding”按钮,分别选择合适的样式

- 我们可以打开软件的“chat Windows”功能,这样只要输入一个命令,然后多个窗口都可以进行相同的输入,为我们减去了大量的重复操作

- 分别给三台虚拟机安装vim编辑器

- 如果在这个地方无法连接外网进行下载的话,可以尝试对/etc/resolv.conf文件添加了域名解析服务器,再尝试重新进行下载

nameserver 8.8.8.8

nameserver 114.114.114.114

- 执行命令:

vim /etc/resolv.conf,修改/etc/resolv.conf文件

- 添加两个域名解析服务器

- 存盘退出

- 再对实例进行测试能否访问外网

- 输入

ping www.baidu.com

- 大功告成,现在已经能访问外网了

(三)查看三台虚拟机主机名

- 查看master虚拟机的主机名

- 查看slave1虚拟机的主机名

- 查看slave2虚拟机的主机名

(四)配置三台虚拟机IP-主机名映射

192.168.9.103 master

192.168.9.104 slave1

192.168.9.105 slave2

1、配置master虚拟机IP-主机名映射

- 执行命令:

vim /etc/hosts

- 键盘单击“O”键进行输入,输入映射

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

2、配置slave1虚拟机IP-主机名映射

- 执行命令:vim /etc/hosts

- 键盘单击“O”键进行输入,输入映射

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

3、配置slave2虚拟机IP-主机名映射

- 执行命令:vim /etc/hosts

- 键盘单击“O”键进行输入,输入映射

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

(五)关闭与禁用防火墙

- 关闭与禁用防火墙

systemctl stop firewalld.service # 关闭防火墙

systemctl disable firewalld.service # 禁用防火墙

- 查看防火墙状态

systemctl status firewalld.service

1、关闭与禁用master虚拟机的防火墙

2、关闭与禁用slave1虚拟机的防火墙

3、关闭与禁用slave2虚拟机的防火墙

(六)关闭SeLinux安全机制

- 需要对

/etc/sysconfig/selinux文件里SELINUX=enforcing,将enforcing改成disable,就可以关闭SeLinux安全机制

1、在master虚拟机上关闭SeLinux安全机制

-

执行命令:

vim /etc/sysconfig/selinux

-

单击“A”键,并在相应位置输入

disable,对文件进行修改

-

单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

2、在slave1虚拟机上关闭SeLinux安全机制

- 执行命令:

vim /etc/sysconfig/selinux

- 单击“A”键,并在相应位置输入

disable,对文件进行修改

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

3、在slave2虚拟机上关闭SeLinux安全机制

- 执行命令:

vim /etc/sysconfig/selinux

- 单击“A”键,并在相应位置输入

disable,对文件进行修改

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

(七)设置三台虚拟机相互免密登录

1、master虚拟机免密登录master、slave1与slave2

-

执行命令:

ssh-keygen,生成密钥对

-

执行命令:

ssh-copy-id root@master,将公钥拷贝到master

- 执行命令:

ssh-copy-id root@slave1,将公钥拷贝到slave1

- 执行命令:

ssh-copy-id root@slave2,将公钥拷贝到slave2

- 验证master是否可以免密登录master、slave1与slave2

2、slave1虚拟机免密登录master、slave1与slave2

- 执行命令:

ssh-keygen,生成密钥对

- 执行命令:

ssh-copy-id root@master,将公钥拷贝到master

- 执行命令:

ssh-copy-id root@slave1,将公钥拷贝到slave1

- 执行命令:

ssh-copy-id root@slave2,将公钥拷贝到slave2

- 验证slave1是否可以免密登录master、slave1与slave2

3、slave2虚拟机免密登录master、slave1与slave2

- 执行命令:

ssh-keygen,生成密钥对

- 执行命令:

ssh-copy-id root@master,将公钥拷贝到master

- 执行命令:

ssh-copy-id root@slave1,将公钥拷贝到slave1

- 执行命令:

ssh-copy-id root@slave2,将公钥拷贝到slave2

- 验证slave2是否可以免密登录master、slave1与slave2

(八)在三台虚拟机上安装lrzsr

1、在master虚拟机上安装lrzsz

- 执行命令:

yum -y install lrzsz

2、在slave1虚拟机上安装lrzsz

- 执行命令:

yum -y install lrzsz

3、在slave2虚拟机上安装lrzsz

- 执行命令:

yum -y install lrzsz

- 装这个命令是因为待会儿我们会使用rz命令来上传压缩包到三台虚拟机

(九)在三台虚拟机上安装配置JDK

1、在master虚拟机上安装配置JDK

- 上传下载到win7上面的Java安装包到master的

/opt目录

- 执行

tar -zxvf jdk-8u231-linux-x64.tar.gz -C /usr/local,将Java安装包解压到/usr/local

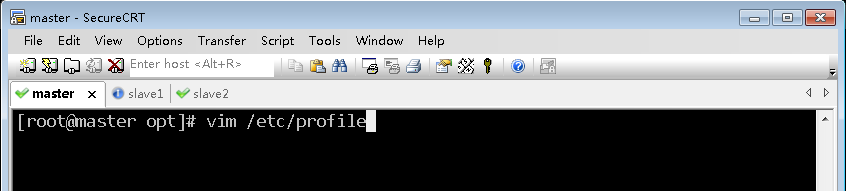

- 执行命令:

ls /usr/local,查看解压之后的jdk

- 执行命令:

vim /etc/profile,配置环境变量

- 单击“O”键,对文件进行添加,在文件的尾巴上面加入相应的环境变量

#JAVA_HOME

export JAVA_HOME=/usr/local/jdk1.8.0_231

export PATH=$PATH:$JAVA_HOME/bin

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

- 执行命令:

source /etc/profile,让配置生效

- 查看JDK版本(

java -version)

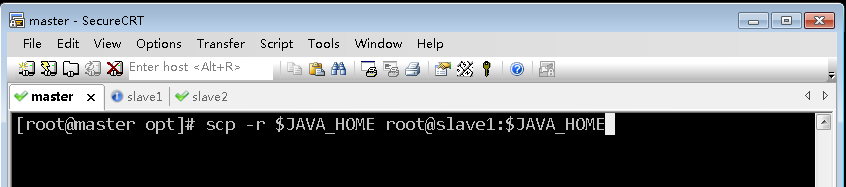

2、将master虚拟机上安装的JDK以及环境配置文件分发到slave1虚拟机

- 执行命令:

scp -r $JAVA_HOME root@slave1:$JAVA_HOME(-r recursive - 递归)

- 在slave1虚拟机上查看Java是否拷贝成功

- 在master虚拟机上,执行命令:

scp /etc/profile root@slave1:/etc/profile,将环境配置文件分发到slave1虚拟机

- 在slave1虚拟机上,使用命令

cat /etc/profile查看从master虚拟机拷贝过来的配置文件profile

- 执行命令:

source /etc/profile,让配置生效

- 执行命令:

java -version,查看JDK版本

3、将master虚拟机上安装的JDK以及环境配置文件分发到slave2虚拟机

- 执行命令:

scp -r $JAVA_HOME root@slave2:$JAVA_HOME(-r recursive - 递归)

- 在slave2虚拟机上查看Java是否拷贝成功

- 在master虚拟机上,执行命令:

scp /etc/profile root@slave2:/etc/profile,将环境配置文件分发到slave2虚拟机

- 在slave2虚拟机上,使用命令

cat /etc/profile查看从master虚拟机拷贝过来的配置文件profile

- 执行命令:

source /etc/profile,让配置生效

- 执行命令:

java -version,查看JDK版本

二、配置完全分布式Hadoop

(一)在master虚拟机上安装配置hadoop

1、上传hadoop安装包到/opt目录

- 利用

rz命令上传hadoop-2.7.1.tar.gz

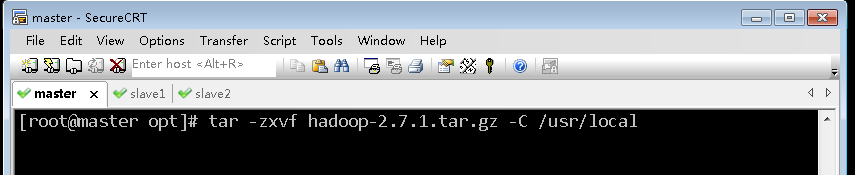

2、将hadoop安装包解压到指定位置

- 执行命令:

tar -zxvf hadoop-2.7.1.tar.gz -C /usr/local

- 查看解压之后的hadoop目录(bin: 可执行文件;etc/hadoop: 配置目录;sbin: 启动关闭系统的命令)

3、配置hadoop环境变量

- 执行命令:

vim /etc/profile

#HADOOP_HOME

export HADOOP_HOME=/usr/local/hadoop-2.7.1

export PATH=$PATH:$HADOOP_HOHE/bin

export PATH=$PATH:$HADOOP_HOME/sbin

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

- 执行命令:

source /etc/profile,让配置生效

4、编辑hadoop环境配置文件 - hadoop-env.sh

- 执行命令:

cd $HADOOP_HOME/etc/hadoop,进入hadoop配置目录

- 执行命令:

vim hadoop-env.sh

export JAVA_HOME=/usr/local/jdk1.8.0_231

export HADOOP_HOME=/usr/local/hadoop-2.7.1

export HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

- 执行命令

source hadoop-env.sh,让配置生效

- 查看三个配置的三个环境变量

5、编辑核心配置文件 - core-site.xml

- 执行命令:

vim core-site.xml

<configuration>

<!--用来指定hdfs的老大-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<!--用来指定hadoop运行时产生文件的存放目录-->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop-2.7.1/tmp</value>

</property>

</configuration>

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

- 由于配置了IP地址主机名映射,因此可用

hdfs://master:9000,否则必须用IP地址hdfs://192.168.1.103:9000

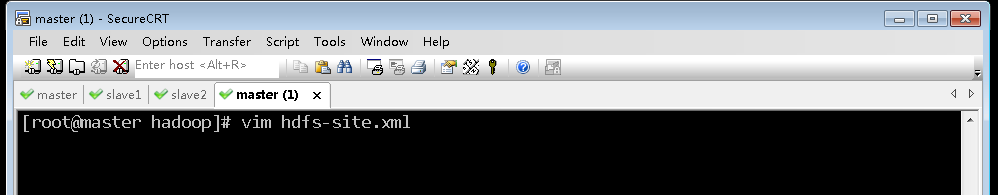

6、编辑HDFS配置文件 - hdfs-site.xml

- 执行命令:

vim hdfs-site.xml

<configuration>

<property>

<!--设置名称节点的目录-->

<name>dfs.namenode.name.dir</name>

<value>/usr/local/hadoop-2.7.1/tmp/namenode</value>

</property>

<property>

<!--设置数据节点的目录-->

<name>dfs.datanode.data.dir</name>

<value>/usr/local/hadoop-2.7.1/tmp/disk1,/usr/local/hadoop-2.7.1/tmp/disk2</value>

</property>

</configuration>

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

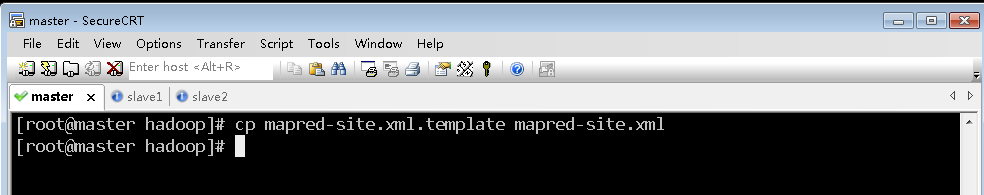

7、编辑MapReduce配置文件 - mapred-site.xml

- 基于模板生成配置文件,执行命令:

cp mapred-site.xml.template mapred-site.xml

- 执行命令:

vim mapred-site.xml

<configuration>

<property>

<!--配置MR资源调度框架YARN-->

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

8、编辑yarn配置文件 - yarn-site.xml

- 执行命令:

vim yarn-site.xml

<configuration>

<property>

<!--配置资源管理器-->

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<property>

<!--配置节点管理器-->

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

- 说明:在hadoop-3.0.0的配置中,

yarn.nodemanager.aux-services项的默认值是“mapreduce.shuffle”,但如果在hadoop-2.7 中继续使用这个值,NodeManager会启动失败。

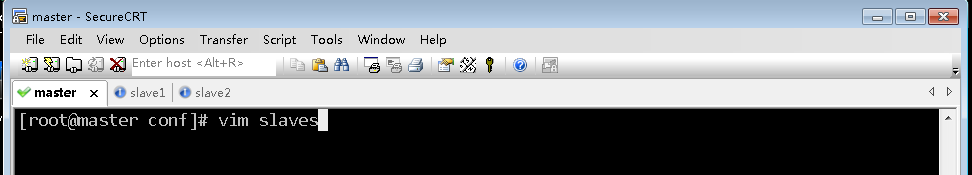

9、编辑slaves文件(定名分)

- 通过slaves文件定义从节点,有两个:slave1与slave2

- 执行命令:

vim slaves

slave1

slave2

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

(二)在slave1虚拟机上安装配置hadoop

1、将master虚拟机上的hadoop分发到slave1虚拟机

- 执行命令:

scp -r $HADOOP_HOME root@slave1:$HADOOP_HOME

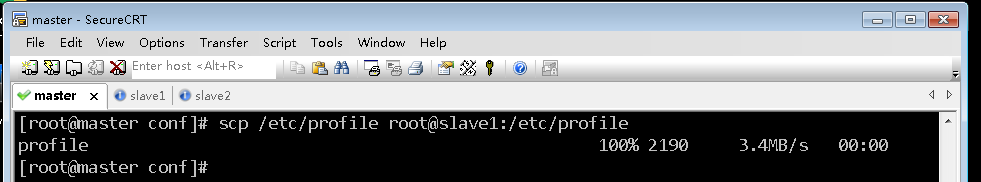

2、将master虚拟机上环境配置文件分发到slave1虚拟机

- 执行命令:

scp /etc/profile root@slave1:/etc/profile

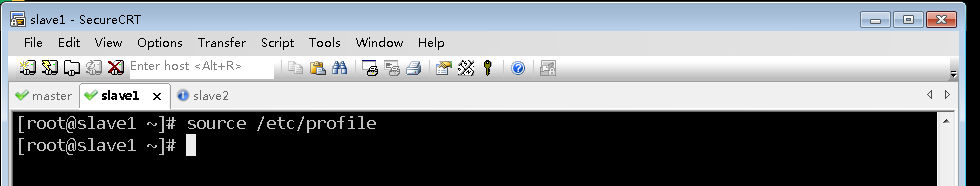

3、在slave1虚拟机上让环境配置生效

- 切换到slave1虚拟机,执行命令:

source /etc/profile

(三)在slave2虚拟机上安装配置hadoop

1、将master虚拟机上的hadoop分发到slave2虚拟机

- 执行命令:

scp -r $HADOOP_HOME root@slave2:$HADOOP_HOME

2、将master虚拟机上环境配置文件分发到slave2虚拟机

- 执行命令:

scp /etc/profile root@slave2:/etc/profile

3、在slave2虚拟机上让环境配置生效

- 切换到slave2虚拟机,执行命令:

source /etc/profile

(四)在master虚拟机上格式化名称节点

- 在master虚拟机上,执行命令:

hdfs namenode -format

- 看到

22/03/20 20:08:43 INFO common.Storage: Storage directory /usr/local/hadoop-2.7.1/tmp/namenode has been successfully formatted.,表明名称节点格式化成功。

(五)启动与关闭Hadoop集群

1、在master虚拟机上启动hadoop服务

- 执行命令:

start-dfs.sh,启动hdfs服务

- 一个名称节点(

namenode)——老大,在master虚拟机上;两个数据节点(datanode)——小弟,在slave1与slave2虚拟机上。 - 辅助名称节点(

secondarynamenode)的地址是0.0.0.0,这是默认的,当然可以修改,可以在hdfs-site.xml文件里配置辅助名称节点

<property>

<!--设置辅助名称节点-->

<name>dfs.namenode.secondary.http-address</name>

<value>master:50090</value>

</property>

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

- 再次启动hdfs服务,先停止,再重新启动

stop-dfs.sh

- 执行命令:

start-dfs.sh

- 这样就是在master虚拟机(

192.168.1.103)上启动辅助名称节点(secondarynamenode) - 使用

jps命令分别查看三台虚拟机的进程

- 执行命令:

start-yarn.sh,启动YARN服务

- 启动了YARN守护进程;一个资源管理器(

resourcemanager)在master虚拟机上,两个节点管理器(nodemanager)在slave1与slave2虚拟机上 - 再次执行命令

jps查看master虚拟机的进程,只有NameNode、SecondaryNameNode和ResourceManager

- 查看slave1和slave2上的进程,只有

NodeManager和DataNode

2、查看hadoop集群的WebUI界面

- 在hw_win7虚拟机浏览器访问

http://master:50070

- 如果不能通过主机名master加端口50070的方式,原因在于没有在hosts文件里IP与主机名的映射,现在可以访问

http://192.168.1.103:50070 - 修改hw_win7虚拟机上的

C:\Windows\System32\drivers\etc\hosts文件

192.168.9.102 Lee

192.168.9.103 master

192.168.9.104 slave1

192.168.9.105 slave2

- 重启hadoop集群,就可以访问

http://master:50070

- 查看数据节点信息

- 点开【Utilities】下拉菜单,选择【Browse the file system】

- 现在的hdfs上还没有任何东西

- 尝试在HDFS上创建一个目录

BigData,执行命令:hadoop fs -mkdir /BigData

3、停止hadoop服务

- 在master虚拟机上执行命令:

stop-all.sh(相当于同时执行了stop-dfs.sh与stop-yarn.sh)

- 提示:

This script is Deprecated. Instead use stop-dfs.sh and stop-yarn.sh,说明stop-all.sh脚本已经被废弃掉了,让我们最好使用stop-dfs.sh与stop-yarn.sh。

三、配置Spark Standalone模式的集群

(一)在master主节点上安装配置Spark

1、上传spark安装包到master虚拟机

- 利用rz将hw_win7虚拟机上的spark安装包上传到master虚拟机

/opt目录

2、将spark安装包解压到master虚拟机指定目录

- 执行命令:

tar -zxvf spark-2.4.4-bin-hadoop2.7.tgz -C /usr/local

3、配置spark环境变量

- 执行命令:

vim /etc/profile

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

- 执行命令:

source /etc/profile,让配置生效

- 使用

ll $SPARK_HOME命令查看spark安装目录(bin、sbin和conf三个目录很重要)

4、编辑spark环境配置文件 - spark-env.sh

- 使用

cd $SPARK_HOME/conf命令进入spark配置目录后,执行命令:cp spark-env.sh.template spark-env.sh与vim spark-env.sh

export JAVA_HOME=/usr/local/jdk1.8.0_231

export SPARK_MASTER_HOST=master

export SPARK_MASTER_PORT=7077

- JAVA_HOME:指定JAVA_HOME的路径。若集群中每个节点在/etc/profile文件中都配置了JAVA_HOME,则该选项可以省略,Spark集群启动时会自动读取。为了防止出错,建议此处将该选项配置上。

- SPARK_MASTER_HOST:指定集群主节点(Master)的主机名,此处为master。

- SPARK_MASTER_PORT:指定Master节点的访问端口,默认为7077。

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

- 执行命令:

source spark-env.sh,让配置生效

5、创建slaves文件,添加从节点

- 执行命令:

vim slaves

- 添加两个从节点的主机名

slave1

slave2

- 单击“ESC”键退出输入模式,然后输入“:wq!”进行存盘退出

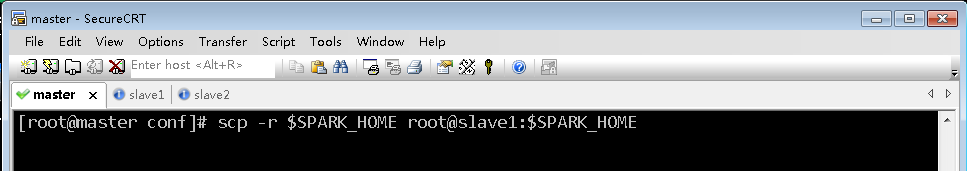

(二)在slave1从节点上安装配置Spark

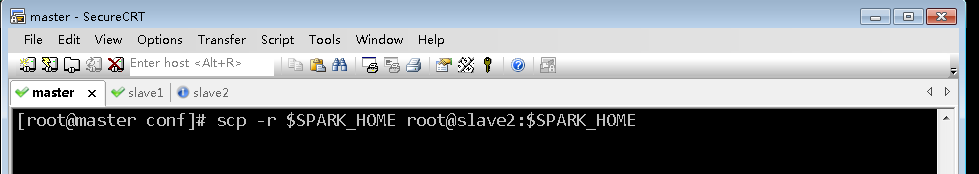

1、把master虚拟机上的spark安装目录分发给slave1虚拟机

- 执行命令:

scp -r $SPARK_HOME root@slave1:$SPARK_HOME

2、将master虚拟机上环境变量配置文件分发到slave1虚拟机

- 在master虚拟机上,执行命令:

scp /etc/profile root@slave1:/etc/profile

- 在slave1虚拟机上,执行命令:

source /etc/profile

3、在slave1虚拟机上让spark环境配置文件生效

- 使用

cd $SPARK_HOME/conf命令进入spark配置目录后,再执行命令:source spark-env.sh

(三)在slave2从节点上安装配置Spark

1、把master虚拟机上的spark安装目录分发给slave2虚拟机

- 执行命令:

scp -r $SPARK_HOME root@slave2:$SPARK_HOME

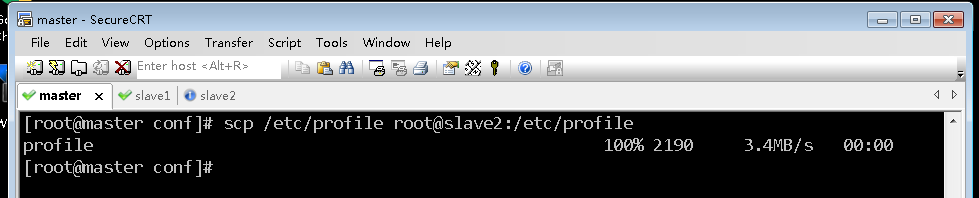

2、将master虚拟机上环境变量配置文件分发到slave2虚拟机

- 在master虚拟机上,执行命令:

scp /etc/profile root@slave2:/etc/profile

- 在slave2虚拟机上,执行命令:

source /etc/profile

3、在slave2虚拟机上让spark环境配置文件生效

- 使用

cd $SPARK_HOME/conf命令进入spark配置目录后,再执行命令:source spark-env.sh

四、启动并使用Spark Standalone模式的集群

- Spark standalone模式下使用的是Spark自带的资源调度框架,但是一般我们把数据保存在HDFS上,也就是用HDFS做数据的持久化,所以hadoop还是需要配置,但是可以只配置HDFS相关的,而Hadoop YARN不需要配置。启动Spark Standalone模式的集群,不需要启动YARN服务,因为Spark会使用自带的资源调度框架。

(一)启动hadoop的dfs服务

- 在master虚拟机上执行命令:

start-dfs.sh

(二)启动Spark集群

- 在master虚拟机上使用

cd $SPARK_HOME/sbin命令进入spark安装目录下的sbin子目录,执行命令:./start-all.sh

- 查看start-all.sh的源码,其中有以下两条命令:

# Start Master

"${SPARK_HOME}/sbin"/start-master.sh

# Start Worker

s"${SPARK_HOME}/sbin"/start-slaves.sh

-

可以看到,当执行start-all.sh命令时,会分别执行start-master.sh命令启动Master,执行start-slaves.sh命令启动Worker。

-

注意,若spark-evn.sh中配置了SPARK_MASTER_HOST属性,则必须在该属性指定的主机上启动Spark集群,否则会启动不成功;若没有配置SPARK_MASTER_HOST属性,则可以在任意节点上启动Spark集群,当前执行启动命令的节点即为Master节点。

-

启动完毕后,分别在各节点执行jps命令,查看启动的Java进程。若在master节点存在Master进程,slave1节点存在Worker进程,slave2节点存在Worker进程,则说明集群启动成功。

-

查看master节点进程

- 查看slave1节点进程

- 查看slave2节点进程

(三)访问Spark的WebUI

- 在Lee_win7虚拟机上,访问

http://master:8080

(四)启动Scala版Spark Shell

- 执行命令:

spark-shell --master spark://master:7077

- 在/opt目录里执行命令:

vim test.txt,并在该文件内随便添加几行内容

- 在HDFS上创建park目录,将test.txt上传到HDFS的/park目录

hadoop fs -mkdir /park

hadoop fs -put /opt/test.txt /park

- 使用

hadoop fs -ls /park查看该文件

- 在其它虚拟机上也可以查看到该文件

- 读取HDFS上的文件,创建RDD

val rdd = sc.textFile("/park/test.txt")

- 查看第一行内容

(五)关闭Spark服务

- 在master节点执行命令:

stop-master.sh与stop-slaves.sh

本文部分内容引用于华老师,如果有看不懂的地方可以去老师的博客下面查找相应的办法,原文链接:http://t.csdn.cn/rkZgL

4327

4327

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?