目录

第五题

LDA(线性判别分析)和QDA(二次判别分析)是两种常用的分类算法,它们在统计学习和模式识别中有着广泛的应用。以下是对LDA和QDA的介绍:

线性判别分析 (LDA)

概述

线性判别分析是一种用于分类和降维的技术。LDA假设各类别的协方差矩阵是相等的,因此其决策边界是线性的。

假设

- 各类别的协方差矩阵相等。

- 数据服从正态分布(高斯分布)。

公式

LDA的判别函数 gk(x)g_k(x)gk(x) 为: gk(x)=xTΣ−1μk−12μkTΣ−1μk+lnP(Y=k)g_k(x) = x^T \Sigma^{-1} \mu_k - \frac{1}{2} \mu_k^T \Sigma^{-1} \mu_k + \ln P(Y=k)gk(x)=xTΣ−1μk−21μkTΣ−1μk+lnP(Y=k) 其中:

- Σ\SigmaΣ 是类别共享的协方差矩阵。

- μk\mu_kμk 是第 kkk 类的均值向量。

- P(Y=k)P(Y=k)P(Y=k) 是第 kkk 类的先验概率。

优点

- 计算简单,速度快。

- 在样本量不大时表现良好。

- 在决策边界接近线性时效果较好。

缺点

- 假设各类别协方差矩阵相等,如果这一假设不成立,分类效果可能较差。

- 对异常值敏感。

二次判别分析 (QDA)

概述

二次判别分析是LDA的扩展,允许各类别有不同的协方差矩阵,因此其决策边界是二次的。

假设

- 各类别的协方差矩阵不必相等。

- 数据服从正态分布(高斯分布)。

公式

QDA的判别函数 gk(x)g_k(x)gk(x) 为: gk(x)=−12ln∣Σk∣−12(x−μk)TΣk−1(x−μk)+lnP(Y=k)g_k(x) = -\frac{1}{2} \ln|\Sigma_k| - \frac{1}{2} (x - \mu_k)^T \Sigma_k^{-1} (x - \mu_k) + \ln P(Y=k)gk(x)=−21ln∣Σk∣−21(x−μk)TΣk−1(x−μk)+lnP(Y=k) 其中:

- Σk\Sigma_kΣk 是第 kkk 类的协方差矩阵。

- μk\mu_kμk 是第 kkk 类的均值向量。

- P(Y=k)P(Y=k)P(Y=k) 是第 kkk 类的先验概率。

优点

- 更灵活,可以处理协方差矩阵不同的情况。

- 能够拟合更复杂的决策边界,适用于非线性分类问题。

缺点

- 计算复杂度较高。

- 在样本量较小时,容易过拟合。

- 对异常值敏感。

比较

- LDA 假设各类别的协方差矩阵相同,因此更适用于线性决策边界的问题。它计算简单、速度快,但在处理非线性问题时可能效果不佳。

- QDA 则允许各类别有不同的协方差矩阵,适用于更复杂的非线性问题。尽管其灵活性更高,但计算复杂度也更大,且在样本量较少时容易过拟合。

总结来说,LDA和QDA都是强大的分类工具,选择哪个方法取决于具体的数据特征和分类任务的要求。如果数据的类别分布接近线性,LDA可能是更好的选择;如果数据分布复杂且样本量足够大,

5. 我们现在来研究LDA和QDA之间的差异。

(a) 如果贝叶斯决策边界是线性的,我们期望在训练集上LDA或QDA哪个表现更好?在测试集上呢? (b) 如果贝叶斯决策边界是非线性的,我们期望在训练集上LDA或QDA哪个表现更好?在测试集上呢? (c) 一般来说,随着样本量n的增加,我们期望QDA相对于LDA的测试预测准确性是提高、下降还是不变?为什么? (d) 真或假:即使给定问题的贝叶斯决策边界是线性的,我们可能会通过使用QDA而不是LDA来获得更好的测试错误率,因为QDA足够灵活以建模线性决策边界。请证明你的答案。

回答:

(a) 如果贝叶斯决策边界是线性的,在训练集上我们期望LDA表现更好。因为LDA假设类别的协方差矩阵是相等的,这正是线性边界的前提条件。因此,LDA可以更好地拟合训练数据。在测试集上,由于模型的复杂度和灵活性,LDA也可能表现更好或至少与QDA相当,因为LDA是为线性边界设计的,而QDA可能会过拟合训练数据。

(b) 如果贝叶斯决策边界是非线性的,在训练集上我们期望QDA表现更好。因为QDA假设每个类别有不同的协方差矩阵,这使得它可以拟合更复杂的非线性决策边界。在测试集上,由于QDA的灵活性,它也有可能表现更好,因为它可以更好地捕捉数据中的非线性模式。然而,如果训练样本量不足,QDA可能会过拟合,因此在这种情况下LDA可能表现得更好。

(c) 一般来说,随着样本量 nnn 的增加,我们期望QDA相对于LDA的测试预测准确性提高。原因是随着样本量的增加,QDA能够更准确地估计每个类别的协方差矩阵,从而更好地拟合实际的决策边界。因此,随着样本量的增加,QDA的模型复杂度可以得到更好的控制,测试预测准确性会提高。

(d) 假的。如果贝叶斯决策边界是线性的,那么LDA会表现得更好或至少与QDA相当。虽然QDA足够灵活,可以建模线性决策边界,但它也有可能过拟合训练数据,特别是在样本量较小的情况下。LDA的模型更简单,当决策边界是线性时,它可以更稳健地拟合数据,因此在这种情况下LDA的测试错误率可能会更低。

总结: (a) 线性边界:训练集和测试集上LDA表现更好。 (b) 非线性边界:训练集和测试集上QDA表现更好(但需注意过拟合)。 (c) 样本量增加:QDA的测试预测准确性相对于LDA提高。 (d) 假:线性决策边界时,LDA可能表现更好或至少与QDA相当。

第六题

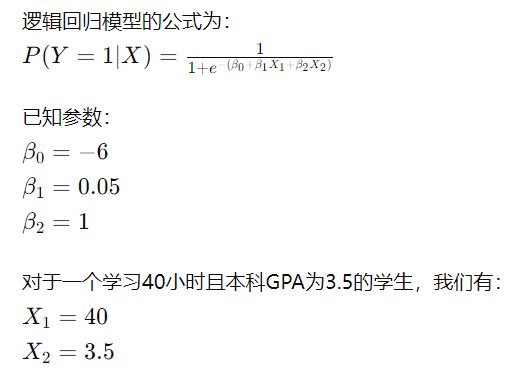

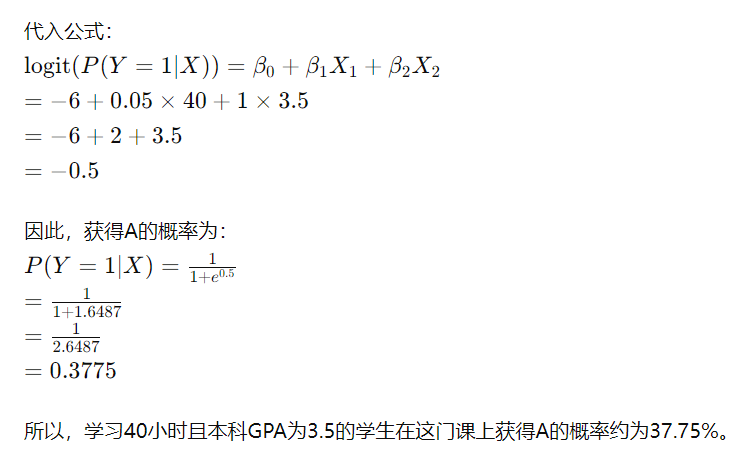

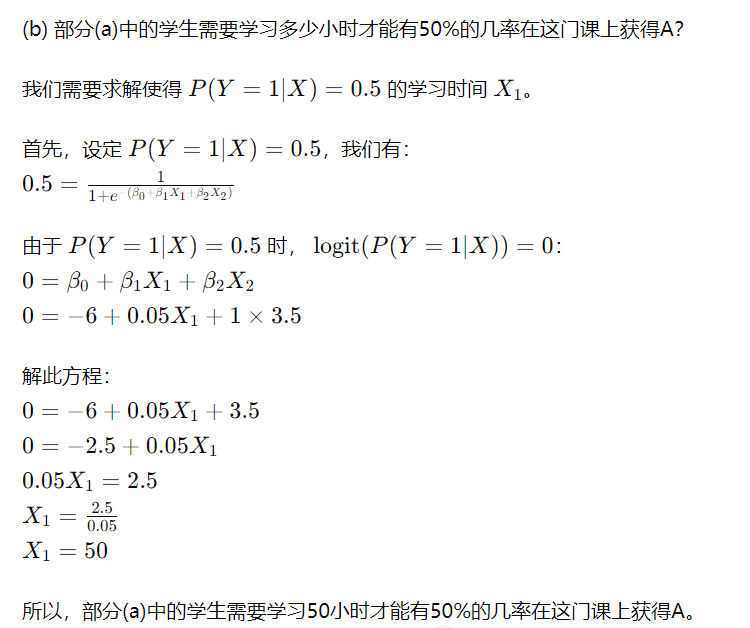

6. 假设我们收集了一组统计课学生的数据,变量为X1=学习时间(小时),X2=本科GPA,Y=获得A的概率。我们拟合了一个逻辑回归模型,并得到了估计系数:βˆ0 = −6,βˆ1 = 0.05,βˆ2 = 1。 (a) 估计一个学习40小时且本科GPA为3.5的学生在这门课上获得A的概率。 (b) 部分(a)中的学生需要学习多少小时才能有50%的几率在这门课上获得A?

回答:

(a) 估计一个学习40小时且本科GPA为3.5的学生在这门课上获得A的概率

第八题

8. 假设我们取一个数据集,将其分成大小相等的训练集和测试集,然后尝试两种不同的分类方法。首先,我们使用逻辑回归,得到的训练数据错误率为20%,测试数据错误率为30%。

接下来,我们使用1-最近邻(即K=1),在训练集和测试集上的平均错误率(在训练数据和测试数据集上平均)为18%。基于这些结果,我们应该更倾向于使用哪种方法来对新观测值进行分类?为什么?

解释:

根据给定的结果,我们需要比较逻辑回归和1-最近邻(K=1)这两种方法的性能,以决定哪种方法更适合对新观测值进行分类。

-

逻辑回归

- 训练集错误率:20%

- 测试集错误率:30%

-

1-最近邻

- 训练集和测试集的平均错误率:18%

逻辑回归

逻辑回归在训练集上的错误率较低(20%),但在测试集上的错误率较高(30%)。

这表明逻辑回归可能存在过拟合现象,即它在训练数据上表现良好,但在未见过的数据(测试数据)上表现较差。

1-最近邻

1-最近邻在训练集和测试集上的平均错误率为18%。虽然我们没有分别给出训练集和测试集的错误率,但这个平均值表明1-最近邻在整体上表现较好。

比较与结论

为了选择更好的分类方法,我们通常关注模型在测试集上的表现,因为测试集代表了模型对新数据的预测能力。虽然逻辑回归在训练数据上的错误率较低,但它在测试数据上的错误率较高,表明其泛化能力较差。而1-最近邻在训练集和测试集上的平均错误率为18%,表明它在训练数据和测试数据上都有相对较好的表现。

尽管1-最近邻的具体训练和测试错误率没有明确给出,但从平均错误率来看,1-最近邻的表现更为稳定和可靠。因此,基于这些结果,我们应该更倾向于使用1-最近邻方法来对新观测值进行分类。

综上所述,1-最近邻(K=1)由于其较低的平均错误率和稳定的表现,应该是更好的选择。

第九题

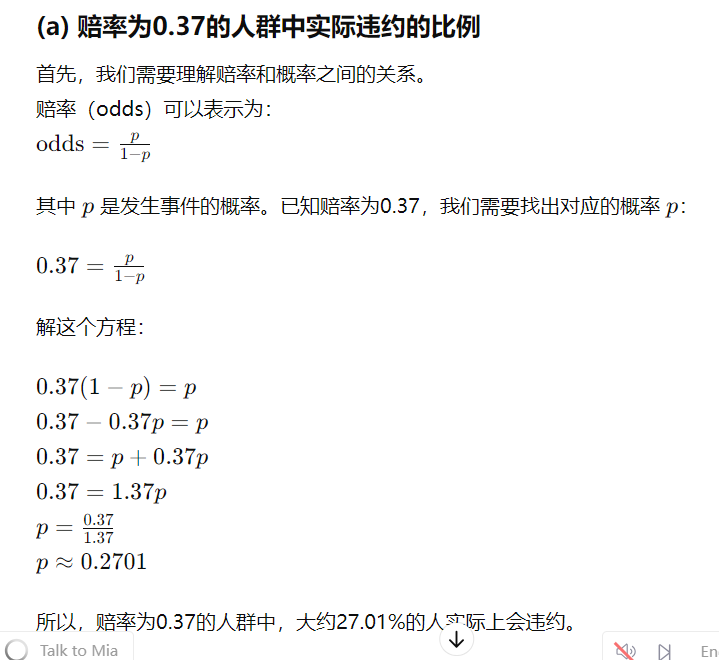

9. 这个问题与赔率有关。 (a) 平均来说,违约赔率为0.37的人群中有多少比例的人实际上会违约? (b) 假设一个人有16%的概率违约她的信用卡付款。她违约的赔率是多少?

解释

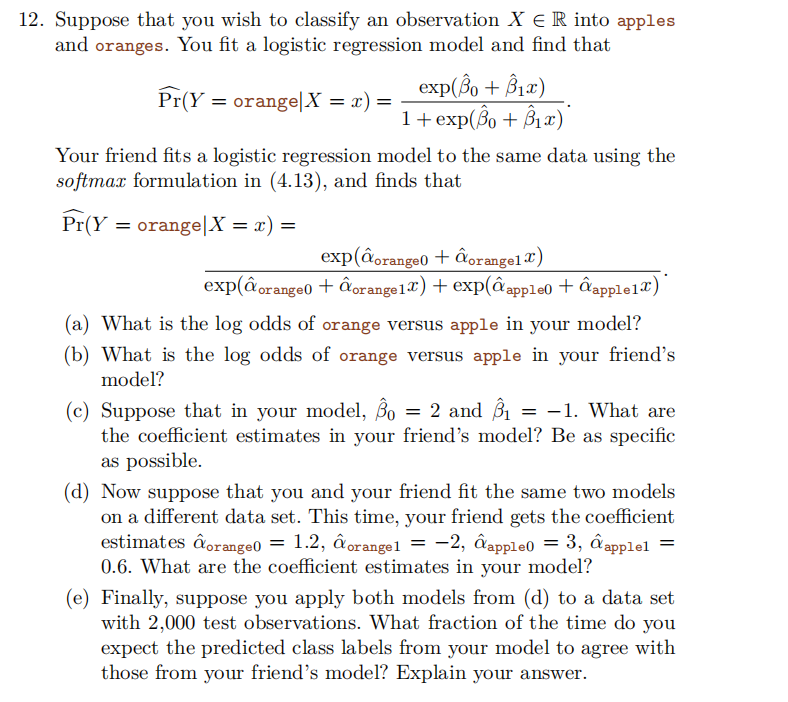

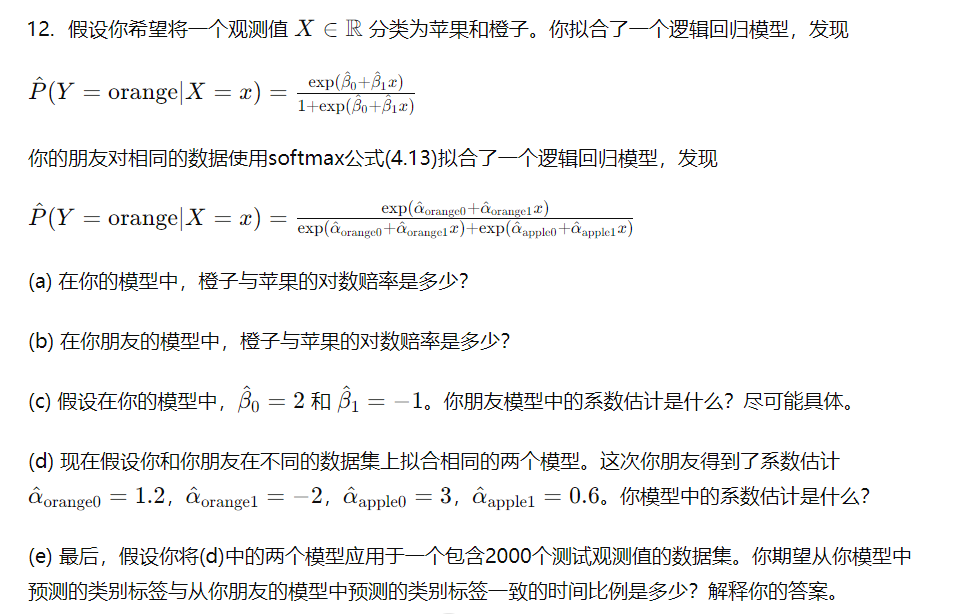

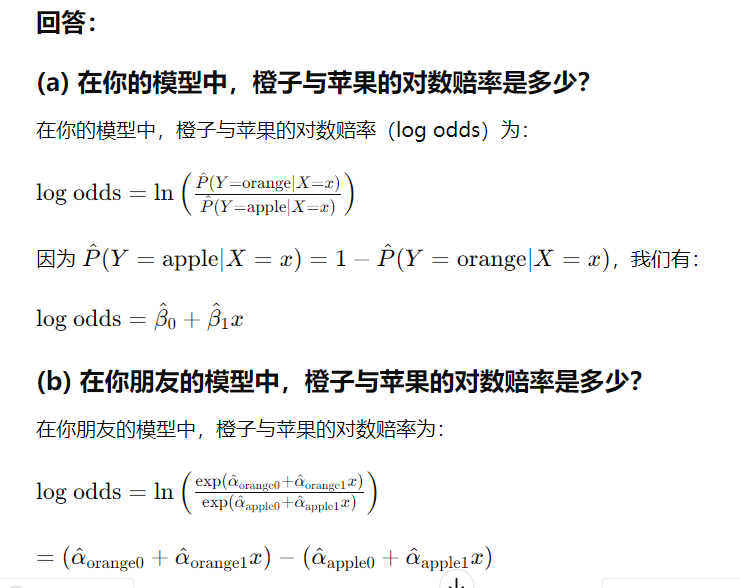

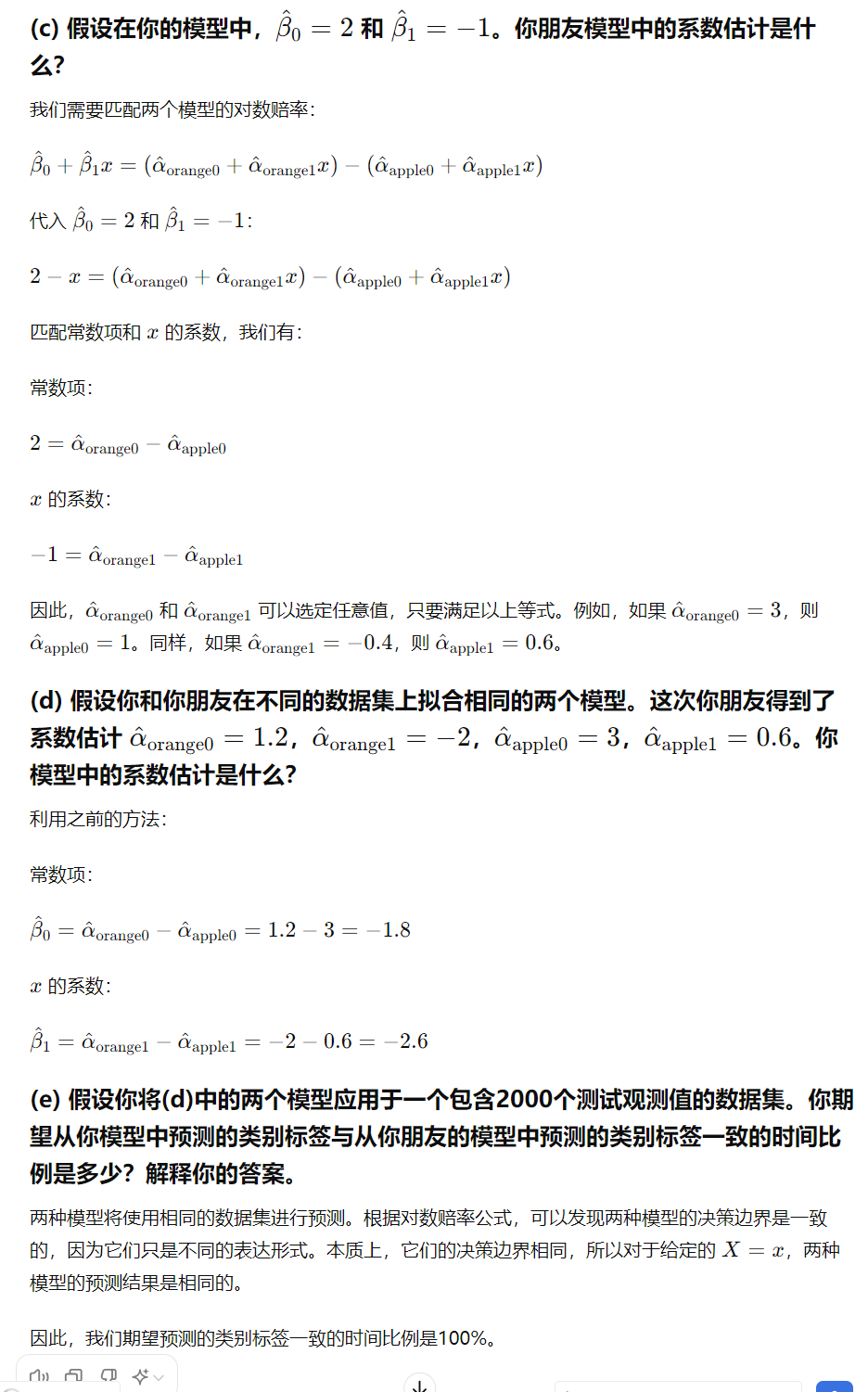

第十二题

5663

5663

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?