目录

什么是正则化(防止过拟合)

正则化(Regularization)是指在机器学习和统计学中,通过引入额外的约束或惩罚项来防止模型过拟合的一种技术。过拟合是指模型在训练数据上表现很好,但在测试数据或新数据上表现较差的现象。正则化通过限制模型的复杂度,从而提高模型在未见数据上的泛化能力。

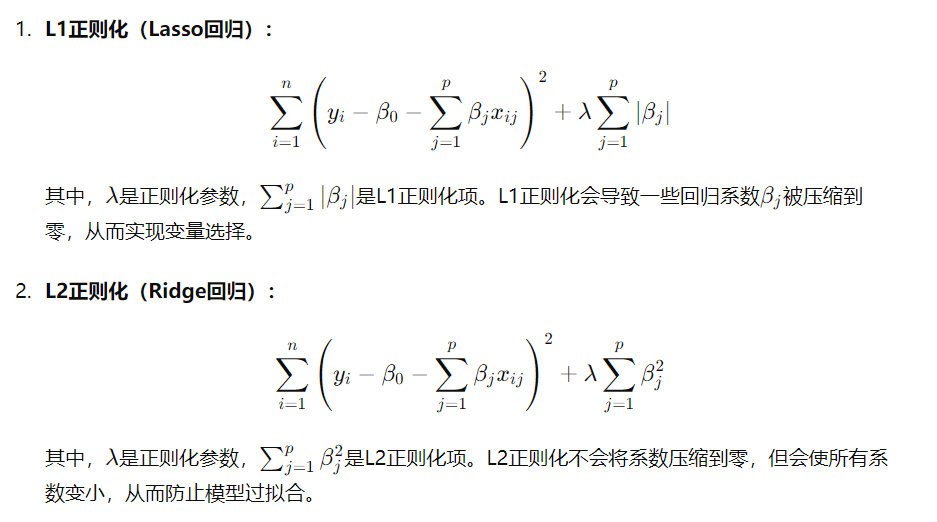

在回归分析中,常见的正则化方法包括L1正则化(Lasso回归)和L2正则化(Ridge回归)

正则化的作用

- 防止过拟合: 通过增加惩罚项,正则化方法可以限制模型的复杂度,防止模型在训练数据上过拟合。

- 提高泛化能力: 通过减少对训练数据的过度拟合,正则化方法提高了模型在未见数据上的泛化能力。

- 简化模型: L1正则化可以使一些回归系数变为零,从而实现变量选择,简化模型。

正则化参数λ

λ\lambdaλ是控制正则化强度的参数。当λ\lambdaλ较大时,正则化效应更强,模型更简单,但可能会导致欠拟合。当λ\lambdaλ较小时,正则化效应较弱,模型更复杂,但可能会导致过拟合。因此,选择适当的λ\lambdaλ值是关键,通常通过交叉验证等方法来确定最佳的λ\lambdaλ值。

第一题

我们在同一个数据集上进行了最佳子集选择、前向逐步选择和后向逐步选择。对于每种方法,我们获得了p+1个模型,包含0, 1, 2,...,p个预测变量。请解释你的答案:

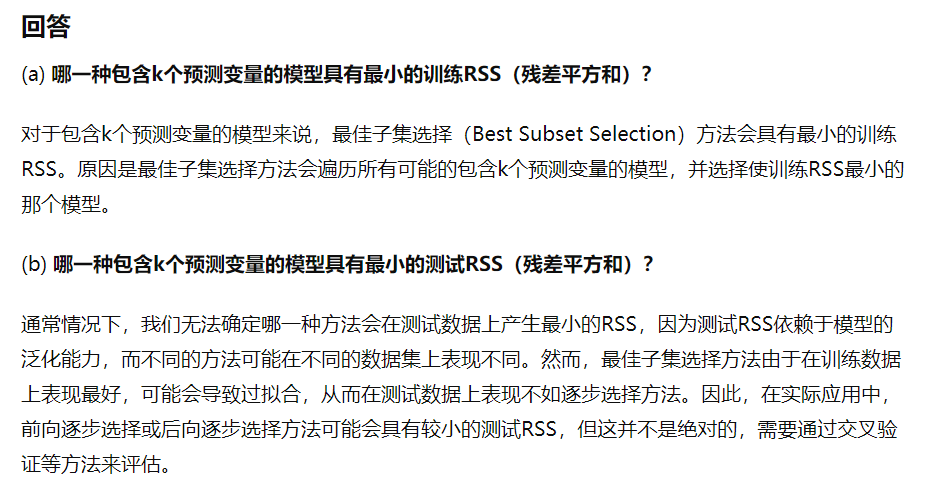

(a) 哪一种包含k个预测变量的模型具有最小的训练RSS(残差平方和)?

(b) 哪一种包含k个预测变量的模型具有最小的测试RSS?

(c) 判断以下命题的真假:

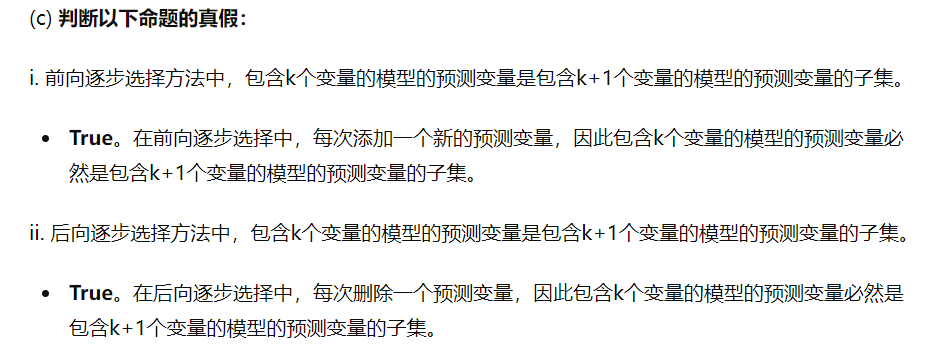

i. 前向逐步选择方法中,包含k个变量的模型的预测变量是包含k+1个变量的模型的预测变量的子集。

ii. 后向逐步选择方法中,包含k个变量的模型的预测变量是包含k+1个变量的模型的预测变量的子集。

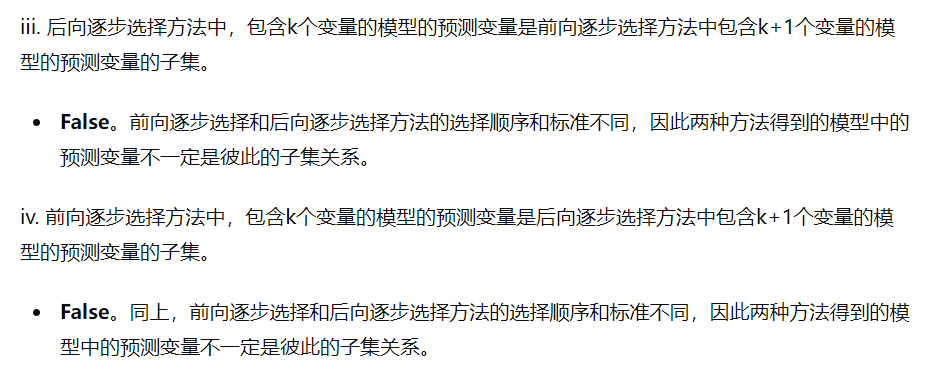

iii. 后向逐步选择方法中,包含k个变量的模型的预测变量是前向逐步选择方法中包含k+1个变量的模型的预测变量的子集。

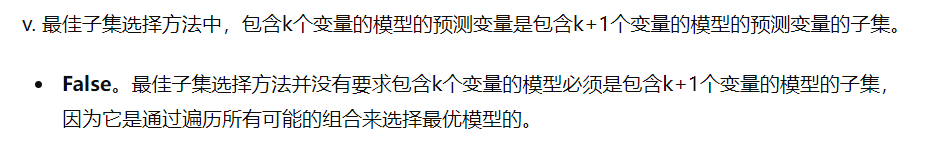

iv. 前向逐步选择方法中,包含k个变量的模型的预测变量是后向逐步选择方法中包含k+1个变量的模型的预测变量的子集。 v. 最佳子集选择方法中,包含k个变量的模型的预测变量是包含k+1个变量的模型的预测变量的子集。

第二题

对于以下各部分(a)到(c),指出哪一个选项(i. 到 iv.)是正确的。请解释你的答案。

(a) 相对于最小二乘法,lasso回归是: i. 更灵活,因此当偏差的增加小于方差的减少时会提高预测准确性。 ii. 更灵活,因此当方差的增加小于偏差的减少时会提高预测准确性。 iii. 不那么灵活,因此当偏差的增加小于方差的减少时会提高预测准确性。 iv. 不那么灵活,因此当方差的增加小于偏差的减少时会提高预测准确性。

(b) 相对于最小二乘法,岭回归是: i. 更灵活,因此当偏差的增加小于方差的减少时会提高预测准确性。 ii. 更灵活,因此当方差的增加小于偏差的减少时会提高预测准确性。 iii. 不那么灵活,因此当偏差的增加小于方差的减少时会提高预测准确性。 iv. 不那么灵活,因此当方差的增加小于偏差的减少时会提高预测准确性。

(c) 相对于最小二乘法,非线性方法是: i. 更灵活,因此当偏差的增加小于方差的减少时会提高预测准确性。 ii. 更灵活,因此当方差的增加小于偏差的减少时会提高预测准确性。 iii. 不那么灵活,因此当偏差的增加小于方差的减少时会提高预测准确性。 iv. 不那么灵活,因此当方差的增加小于偏差的减少时会提高预测准确性。

回答

(a) 相对于最小二乘法,lasso回归是:

iii. 不那么灵活,因此当偏差的增加小于方差的减少时会提高预测准确性。

解释:Lasso回归通过引入L1正则化,将一些系数缩小到零,从而实现变量选择。这使得模型更简单,减少了方差,但增加了偏差。因此,lasso回归是不那么灵活的方法,其预测准确性会在偏差的增加小于方差的减少时得到提高。

(b) 相对于最小二乘法,岭回归是:

iii. 不那么灵活,因此当偏差的增加小于方差的减少时会提高预测准确性。

解释:岭回归通过引入L2正则化,将系数缩小但不至于为零,从而减少模型的复杂度。这也使得模型更简单,减少了方差,但增加了偏差。因此,岭回归也是不那么灵活的方法,其预测准确性会在偏差的增加小于方差的减少时得到提高。

(c) 相对于最小二乘法,非线性方法是:

i. 更灵活,因此当偏差的增加小于方差的减少时会提高预测准确性。

解释:非线性方法(如决策树、神经网络等)比线性回归更灵活,因为它们可以拟合更复杂的数据模式。这种灵活性通常会减少偏差但增加方差。因此,非线性方法在偏差的增加小于方差的减少时会提高预测准确性。

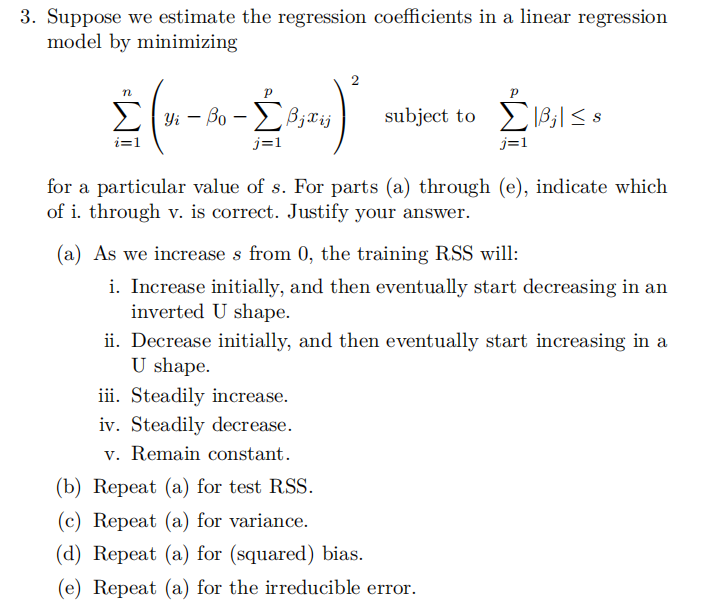

第三题

回答

(a) 当我们将s从0增加时,训练RSS将会:

iv. 稳定减少。

解释:当s增加时,约束条件变得不那么严格,允许更多的β_j有非零值,从而使模型更复杂。这将导致训练RSS稳定减少,因为更复杂的模型可以更好地拟合训练数据。

(b) 当我们将s从0增加时,测试RSS将会:

ii. 最初减少,然后最终开始增加,呈U形状。

解释:随着s的增加,模型变得更加复杂,训练RSS减少。然而,过于复杂的模型会导致过拟合,从而在测试数据上表现不好。因此,测试RSS最初会减少,但随着s进一步增加,测试RSS会开始增加,呈现U形状。

(c) 当我们将s从0增加时,方差将会:

ii. 最初减少,然后最终开始增加,呈U形状。

解释:当s增加时,模型变得更复杂,模型的方差最初会减少,因为模型能更好地捕捉数据中的变化。然而,当模型过于复杂时,它对训练数据中的噪声过拟合,导致方差增加。

(d) 当我们将s从0增加时,(平方)偏差将会:

iv. 稳定减少。

解释:随着s的增加,模型的灵活性增加,可以更好地拟合数据,从而减少偏差。由于模型更复杂,它可以更好地捕捉真实数据中的模式,因此偏差会稳定减少。

(e) 当我们将s从0增加时,不可约误差将会:

v. 保持不变。

解释:不可约误差是由数据本身的内在随机性和噪声引起的,与模型的复杂性无关。因此,当s从0增加时,不可约误差保持不变。

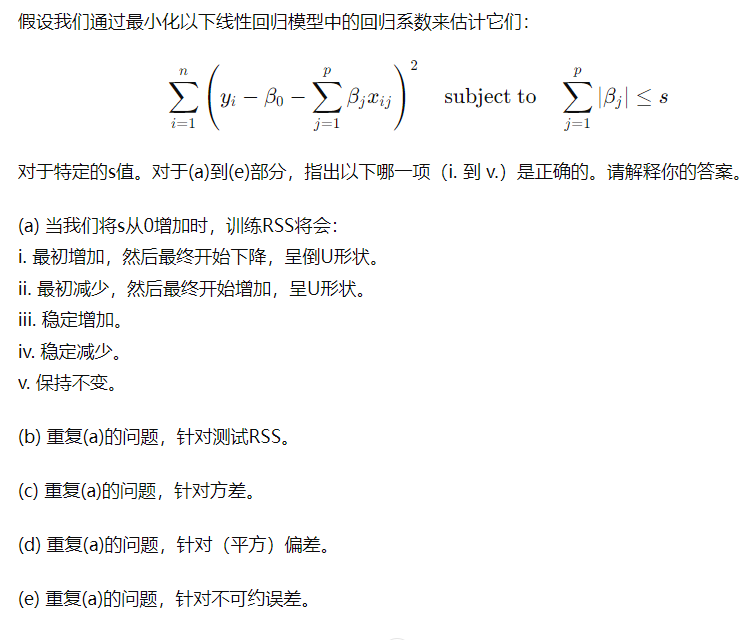

第四题

对于特定的λ\lambdaλ值。对于(a)到(e)部分,指出以下哪一项(i. 到 v.)是正确的。请解释你的答案。

(a) 当我们将λ\lambdaλ从0增加时,训练RSS将会: i. 最初增加,然后最终开始下降,呈倒U形状。 ii. 最初减少,然后最终开始增加,呈U形状。 iii. 稳定增加。 iv. 稳定减少。 v. 保持不变。

(b) 重复(a)的问题,针对测试RSS。

(c) 重复(a)的问题,针对方差。

(d) 重复(a)的问题,针对(平方)偏差。

(e) 重复(a)的问题,针对不可约误差。

回答

(a) 当我们将λ\lambdaλ从0增加时,训练RSS将会:

iii. 稳定增加。

解释:当λ\lambdaλ增加时,正则化项的权重增加,这限制了回归系数的大小,使得模型对训练数据的拟合能力减弱,因此训练RSS会稳定增加。

(b) 当我们将λ\lambdaλ从0增加时,测试RSS将会:

ii. 最初减少,然后最终开始增加,呈U形状。

解释:随着λ\lambdaλ的增加,模型的复杂度降低,过拟合现象减少,测试RSS最初会减少。然而,当λ\lambdaλ过大时,模型变得过于简单,无法捕捉数据中的重要模式,导致测试RSS增加。因此,测试RSS呈U形状。

(c) 当我们将λ\lambdaλ从0增加时,方差将会:

iv. 稳定减少。

解释:增加λ\lambdaλ会使模型更加简单和稳定,从而减少对训练数据中噪声的敏感度,降低模型的方差。

(d) 当我们将λ\lambdaλ从0增加时,(平方)偏差将会:

iii. 稳定增加。

解释:随着λ\lambdaλ的增加,模型变得更加约束,灵活性降低,导致对真实数据的拟合能力减弱,因此偏差会稳定增加。

(e) 当我们将λ\lambdaλ从0增加时,不可约误差将会:

v. 保持不变。

解释:不可约误差是由数据本身的内在随机性和噪声引起的,与模型的复杂性无关。因此,当λ\lambdaλ从0增加时,不可约误差保持不变。

1514

1514

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?