目录

一、概念

损失函数(Loss Function )是定义在单个样本上的,算的是一个样本的误差。

代价函数(Cost Function )是定义在整个训练集上的,是所有样本误差的平均,也就是损失函数的平均。

目标函数(Object Function)定义为:最终需要优化的函数。等于经验风险+结构风险(也就是Cost Function + 正则化项)。

PS:关于目标函数和代价函数的区别还有一种通俗的区别:目标函数是最大化或者最小化,而代价函数是最小化。

举个例子解释一下:(图片来自Andrew Ng Machine Learning公开课视频)

上面三个图的函数依次为,

,

。我们是想用这三个函数分别来拟合Price,Price的真实值记为

。

我们给定,这三个函数都会输出一个

,这个输出的

与真实值

可能是相同的,也可能是不同的,为了表示我们拟合的好坏,我们就用一个函数来度量拟合的程度,比如:

![]() ,这个函数就称为损失函数(loss function),或者叫代价函数(cost function)(有的地方将损失函数和代价函数没有细分也就是两者等同的)。损失函数越小,就代表模型拟合的越好。

,这个函数就称为损失函数(loss function),或者叫代价函数(cost function)(有的地方将损失函数和代价函数没有细分也就是两者等同的)。损失函数越小,就代表模型拟合的越好。

那是不是我们的目标就只是让loss function越小越好呢?还不是。

这个时候还有一个概念叫风险函数(risk function)。风险函数是损失函数的期望,这是由于我们输入输出的 遵循一个联合分布,但是这个联合分布是未知的,所以无法计算。但是我们是有历史数据的,就是我们的训练集,

关于训练集的平均损失称作经验风险(empirical risk),即

![]() ,所以我们的目标就是最小化

,所以我们的目标就是最小化![]() ,称为经验风险最小化。

,称为经验风险最小化。

如果到这一步就完了的话,那我们看上面的图,那肯定是最右面的 的经验风险函数最小了,因为它对历史的数据拟合的最好嘛。但是我们从图上来看

肯定不是最好的,因为它过度学习历史数据,导致它在真正预测时效果会很不好,这种情况称为过拟合(over-fitting)。

为什么会造成这种结果?大白话说就是它的函数太复杂了,都有四次方了,这就引出了下面的概念,我们不仅要让经验风险尽量小,还要让结构风险尽量小。。这个时候就定义了一个函数 ,这个函数专门用来度量模型的复杂度,在机器学习中也叫正则化(regularization)。常用的有

,

范数。

到这一步我们就可以说我们最终的优化函数是: ,即最优化经验风险和结构风险,而这个函数就被称为目标函数。

,即最优化经验风险和结构风险,而这个函数就被称为目标函数。

结合上面的例子来分析:最左面的 结构风险最小(模型结构最简单),但是经验风险最大(对历史数据拟合的最差);最右面的

经验风险最小(对历史数据拟合的最好),但是结构风险最大(模型结构最复杂);而

达到了二者的良好平衡,最适合用来预测未知数据集。

二、常见的代价函数

常见的损失误差有五种:

1. 铰链损失(Hinge Loss):主要用于支持向量机(SVM) 中;

2. 交叉熵损失 (Cross Entropy Loss,Softmax Loss ):用于Logistic 回归与Softmax 分类中;

3. 平方损失(Square Loss):主要是最小二乘法(OLS)中;

4. 指数损失(Exponential Loss) :主要用于Adaboost 集成学习算法中;

5. 其他损失(如0-1损失,绝对值损失)

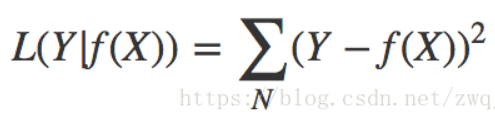

1.平方误差损失函数

最小二乘法是线性回归的一种方法,它将回归的问题转化为了凸优化的问题。最小二乘法的基本原则是:最优拟合曲线应该使得所有点到回归直线的距离和最小。通常用欧几里得距离进行距离的度量。平方损失的损失函数为:

损失函数表达式:

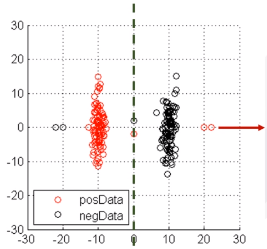

分类实例:

优点:容易优化(一阶导数连续)

缺点:对outlier点很敏感(因为惩罚是指数增长的,左图的两个outlier将分类面强行拉到左边,得不到最优的分类面)

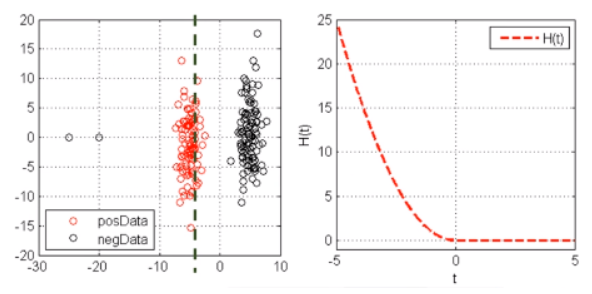

2.Logit损失函数(Logistic 回归)

逻辑斯特回归的损失函数就是对数损失函数,在逻辑斯特回归的推导中,它假设样本服从伯努利分布(0-1)分布,然后求得满足该分布的似然函数,接着用对数求极值。逻辑斯特回归并没有求对数似然函数的最大值,而是把极大化当做一个思想,进而推导它的风险函数为最小化的负的似然函数。从损失函数的角度上,它就成为了log损失函数。

损失函数表达式: ![]()

优点:稳定的分类面,严格凸,且二阶导数连续

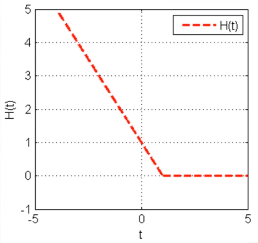

3.Hinge损失函数(SVM)

minJ(w)=1n∑i=1nH(yif(xi,w)),whereH(t)={−t+10t<1t≥0

优点:稳定的分类面,凸函数。对分对的但又不是很对的样本也进行惩罚(0-1之间),可以极大化分类间隔。

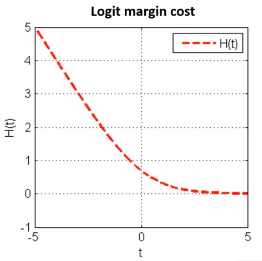

4. 指数损失函数

AdaBoost就是一指数损失函数为损失函数的。

指数损失函数的标准形式:

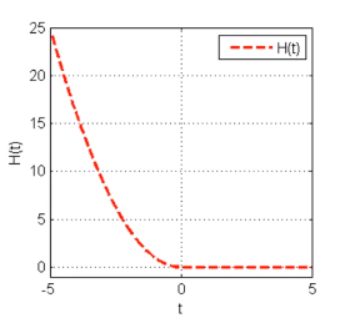

![]()

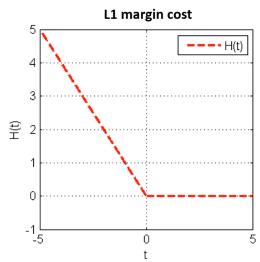

5.感知机损失函数(L1 margin cost)

损失函数:

minJ(w)=1n∑i=1nH(yif(xi,w)),whereH(t)={−t0t<0t≥0

在t=0处不连续,所以不可导,但是可以求次梯度(导数)。

优点:稳定的分类面,次梯度可导

缺点:二阶不可导,有时候不存在唯一解

587

587

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?