Abstract

有监督的人群计数严重依赖于人工标记,但人工标记密集场景下的人数非常困难。因此,作者提出CrowdCLIP。

-

CrowdCLIP核心思想

1.最近的对比预训练视觉语言模型(CLIP)在各种下游任务上表现出色.

2.人群补丁和计数文本之间存在自然映射。 -

在训练阶段,作者通过构建*“ranking text prompts”*(排序文本提示)来匹配大小排序的人群patches,从而利用多模态排序损失来指导图像编码器学习。

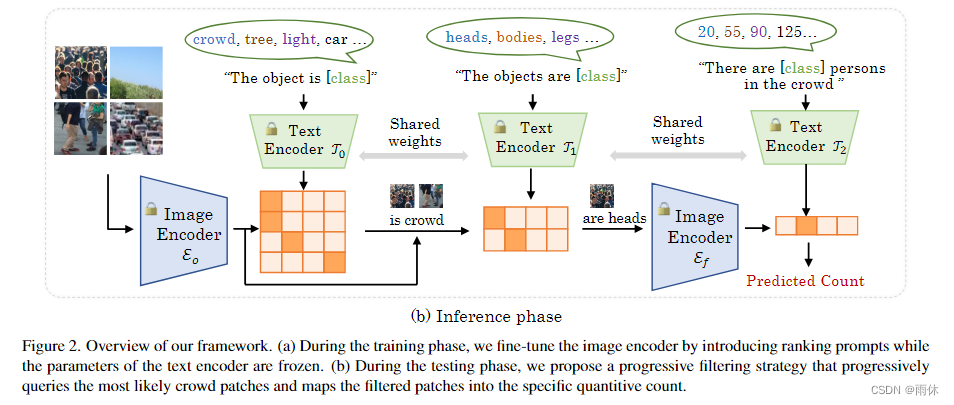

在测试阶段,我们提出了一种简单而有效的渐进滤波策略,首先选择高潜力的人群斑块,然后以不同的计数间隔将其映射到语言空间中。

结果:与之前的无监督计数方法相比,所提出的CrowdCLIP具有优越的性能。

Introduction

-

之前的人群计数的方法为回归密度图,这种方式需要在训练时在每个人的头顶做标注,这种点级对象注释是一个昂贵且费力的过程。

-

后来的弱监督方法采用注释级标签进行监督,而半监督方法使用一小部分完全标记的图像和大量未标记的图像进行训练。然而,弱监督和半监督方法仍然需要相当大的标签成本,特别是在注释密集或模糊的图像时。

到目前为止,只有一种叫做CSSCCNN的方法用纯无监督人群计数,但性能不及全监督方法。

之后文章就大致介绍了一下CLIP,说CLIP性能很好并且想把CLIP用在人群计数上。

-

比较简单的方法就是将人群数量离散为一组区间,从而将人群计数转化为分类任务而不是回归任务。然后可以直接计算图像与文本之间的相似度,并选择最相似的图像-文本对作为预测计数。

这种方法效果不好,主要原因:

1.原CLIP主要训练用于识别单目标图像,人群图像中目标太多,CLIP不好理解。

2.图像中人群分布不均匀,而计数的目的是计算每个patch内人头的数量。一些不包含人头的人群patch可能会对CLIP产生歧义。 -

作者方法

1.在训练阶段构建排序文本prompt来描述一组按大小排序的图像patches。因此,可以通过多模态排序损失对图像编码器进行微调,以更好地捕获人群语义。

2.在测试阶段我们提出了一种简单而有效的渐进式过滤策略,由三个阶段组成:前两个阶段由粗到精的分类范式选择相关度高的人群补丁,最后一个阶段将相应的人群补丁映射到合适的计数中。由于这种渐进推理策略,我们可以有效地减少模糊人群补丁的影响。 -

主要贡献

1.提出一种新的无监督人群计数方法CrowdCLIP,将人群计数创新地视为一个图像-文本匹配问题。

2.引入基于排序的对比微调策略,使图像编码器更好地挖掘潜在人群语义。此外,提出了一种渐进式滤波策略,在测试阶段选择相关度高的人群补丁映射到适当的计数区间。

Related Works

-

全监督人群计数 (这里文章并没有细讲,单纯列举)

监督方法的主流思想是回归密度图,密度图是由标记的点图生成的。标记点很难反映尺寸,因此很容易遇见尺寸变化的问题。

之前方法:

1.多列网络学习多尺度特征信息

2.利用尺度机制或尺度选择缓解尺度变化

3.利用注意机制

4.监督分类器

5.基于定位 -

弱/半/无监督人群计数

1.弱监督方法建议使用计数级而不是点级注释作为监督。

2.半监督方法利用小标签数据来训练模型,并进一步使用大量无标签数据来提高性能。

若没有标记,二者皆无法训练。

3.无监督训练只有CSS-CCNN,CSS-CCNN提出自然人群遵循幂律分布,还可以用来产生反向传播的错误信号。但CSS-CCNN效果比不上其他流行的全监督方法。 -

本文研究了如何将视觉语言知识转移到无监督人群计数任务中。

Preliminary

这里分别介绍了CLIP、无监督人群计数的相关概念,已经会的可以略过。

- CLIP

CLIP是一个典型的预训练视觉语言模型,主要研究如何在视觉概念和语言概念之间建立联系。CLIP包含两个编码器,分别用于编码图像特征和文本特征。给定一个图像-文本对,CLIP旨在计算编码图像特征和编码文本特征之间的语义相似度。预训练的CLIP可以很容易地扩展到零射击/开放词汇表图像分类。具体来说,可以使用一系列类名(例如,“cat”,“dog”)来替换预定义的文本提示模板,例如,“a photo of [class]”。然后将文本输入到文本编码器中生成类嵌入,用于计算与图像嵌入的相似度进行分类。

- 无监督人群计数

无监督人群计数人群计数的目标是在给定人群图像的情况下估计行人数量。根据之前方法[3,8]的无监督定义,即在训练过程中,模型不需要单个带注释的图像,同时允许使用原始数据提供的监督。手动注释的验证或测试集仅用于评估。

Our Method

Ranking-based Contrastive Fine-tuning基于排序的对比微调

- 训练总图

- 步骤

1.将人群图像划分为不同大小的patches,值得注意的是,每个patch的中心都是图像的中心,且patches的尺寸是由小到大的。而后将不同尺寸的patch调整到统一大小后输入图像编码器。

2.文本提示定义为“人群中有[类]人”,其中[类]代表一组基本秩数R = [R0, R0+K,…], R0+ (N−1)K],其中R0为基本参考计数,K为计数间隔,N为类数。文本提示将被输入到文本编码器中,以获得输出文本秩嵌入R ’ = [R ’ 0, R ’ 1,…], R ’ n−1],其中R '∈RN ×C。

来自不同斑块的人头数量是有序的,较大的斑块对应的人头数量较多或相等。作者设计排序文本提示来描述图像patches的顺序关系。具体来说,我们提出学习秩嵌入来保持图像补丁在语言潜空间中的顺序。

3.计算文本提示与图像patches的内积获得相似度得分,获得相似度矩阵。

因为文本提示有一定的排序信息,即小patch中人头数量一定小于大patch中的人群数量。所以获得的相似度矩阵也应该有一定的排序信息。

4.为了保持图像-文本对在潜在空间中的顺序,我们提出通过多模态排序损失对图像编码器进行优化。也就是以相似矩阵的主对角线为基,从下向上计算排序损失:

在微调过程中,文本编码器的权重是固定的,即Lr旨在将嵌入的图像对齐到固定的排序语言空间中。通过这种方式,文本嵌入被约束在良好学习的语言潜在空间中,从而实现鲁棒泛化。

Progressive Filering Strategy逐步过滤策略

- 推理总图

- 逐步过滤策略步骤

- 逐步过滤策略步骤

1.我们将原始图像编码器和微调图像编码器分别命名为Eo和Ef。Eo用于选择高置信度人群补丁,Ef用于最终计数。

2.第一阶段:给定一个输入图像,将其划分为P×P个小patches,然后将这些patches和相应的文本提示分别送入Eo和第一个文本编码器to0,生成相似度分数进行粗分类。目的是将patches划分为不同的类别,并明确区分为:人群、树、车等。

3.第二阶段:采用细粒度的文本提示,并将其输入到第二个文本编码器T1中,进一步对patch进行过滤。细粒度的文本提示被定义为“对象是[类]”,其中[类]是一些细粒度的类别(例如,“人头”,“人体”)。结果得到了具有人头的高置信度人群patches。

4.第三阶段:文本提示与微调阶段相同,即将排名文本提示定义为“人群中有[类]人”,其中[类]为预定义的排名数r。根据Ef和T2的图像嵌入和类别嵌入,选择最相似的图像-文本对得到最终计数。

注意,在实践中,T0、T1和T2共享相同的参数,所有图像共享相同的文本提示。换句话说,我们可以提前得到文本嵌入,而不是在每个推理阶段处理文本提示,从而保持效率。

Limitation

主要的限制是我们的方法只提供给定图像的计数级信息。点级信息也有助于分析人群。在未来,我们希望以一种无监督的方式探索人群计数的本地化。

Conclusion

在这项工作中,作者提出了一个新的框架,CrowdCLIP,将知识从视觉语言预训练模型(CLIP)转移到无监督人群计数任务。通过多模态排序损失对图像编码器进行微调,并采用渐进式滤波策略,大大提高了CrowdCLIP的性能。

文章提出CrowdCLIP框架,它利用CLIP的对比预训练能力解决无监督人群计数问题。通过排序文本提示和多模态排序损失进行图像编码器微调,以及在测试阶段采用渐进式滤波策略,有效提升计数性能。CrowdCLIP在无监督场景下展现出优越的计数效果。

文章提出CrowdCLIP框架,它利用CLIP的对比预训练能力解决无监督人群计数问题。通过排序文本提示和多模态排序损失进行图像编码器微调,以及在测试阶段采用渐进式滤波策略,有效提升计数性能。CrowdCLIP在无监督场景下展现出优越的计数效果。

1330

1330

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?