向大家推荐一本清华大学iDlab课题组撰写的强化学习书籍《Reinforcement Learning for Sequential Decision and Optimal Control》,于2023年由Springer出版的强化学习英文书籍。本书面向工程领域的科研人员和工程师,按照原理剖析、主流算法、典型示例的架构,介绍用于复杂系统动态决策及最优控制的强化学习方法。本书内容涵盖了强化学习的基本概念、蒙特卡洛法、时序差分法、动态规划法、函数近似法、策略梯度法、近似动态规划、状态约束的处理和深度强化学习等知识点,旨在为领域内的行业同仁提供一本适合入门学习和能力进阶的参考书籍。

作者简介

李升波

清华大学车辆与运载学院教授,博士生导师。先后留学工作于斯坦福大学,密歇根大学和加州大学伯克利分校。主要从事自动驾驶汽车、强化学习、最优控制与估计等研究。他的研究提出了周期波动型节能操控、网联车群分布式控制、类脑学习集成式决策等核心理论方法,突破了高级别智能汽车自主学习与数据闭环所面临的一系列关键技术难题。获中国自动化学会自然科学一等奖、中国汽车工业科技进步特等奖、国家科技进步二等奖、国家技术发明二等奖等。他是教育部青年科学奖的入选者,曾获得国家高层次科技创新领军人才、交通运输行业中青年科技创新领军人才、清华大学青年教师学术新人奖、清华大学青年教师教学优秀奖等。担任AI国际评测组织MLPerf自动驾驶咨询委员会委员、IEEE智能交通系统学会的理事会委员、中国汽车工程学会青工委首任主任、IEEE OJ-ITS高级副主编、IEEE TITS/IEEE ITSM/IEEE TIV副主编等。

内容简介

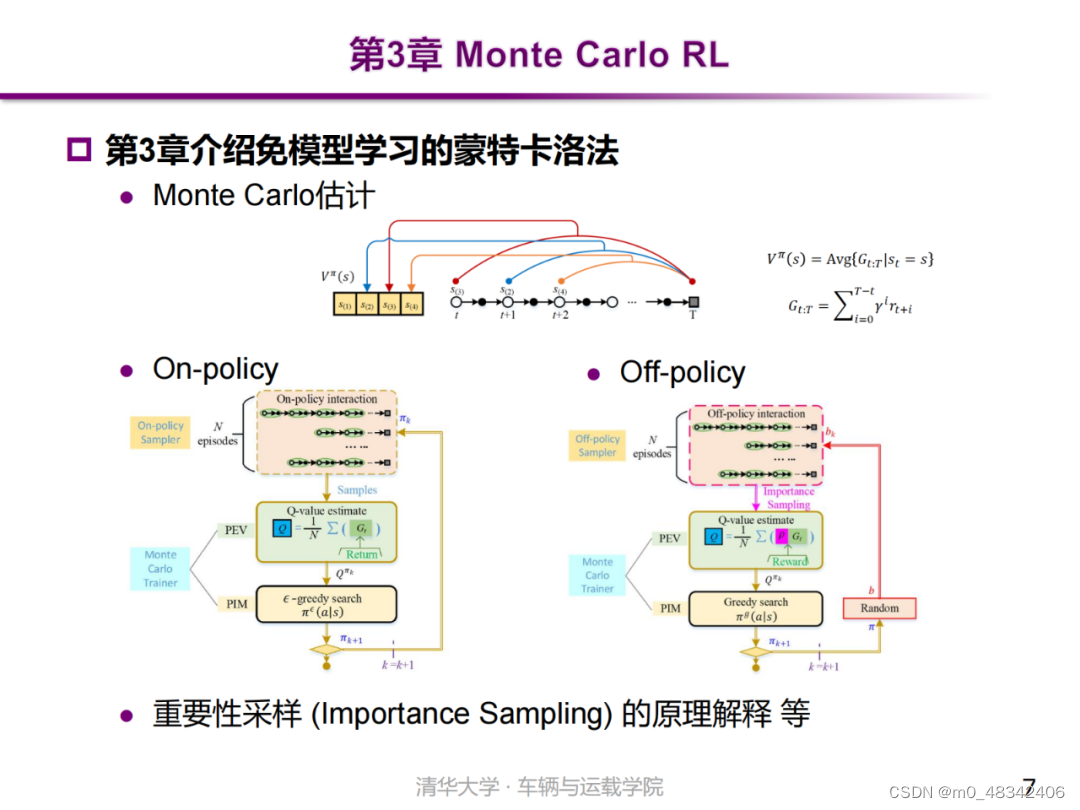

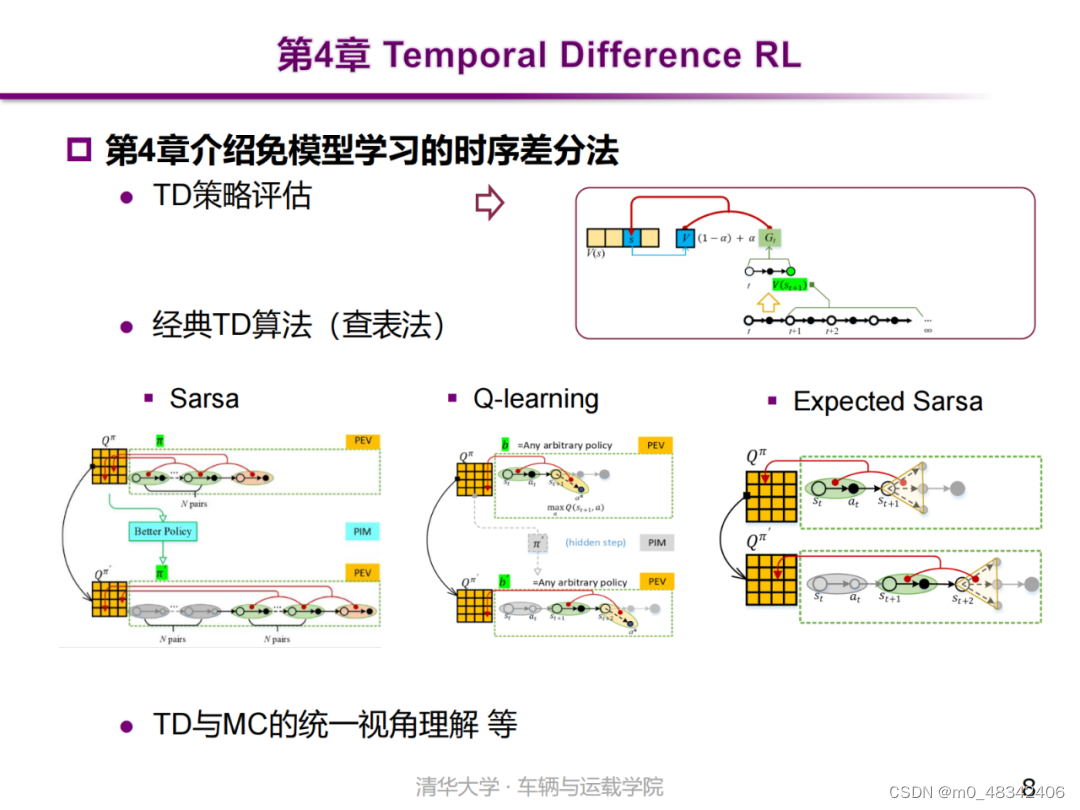

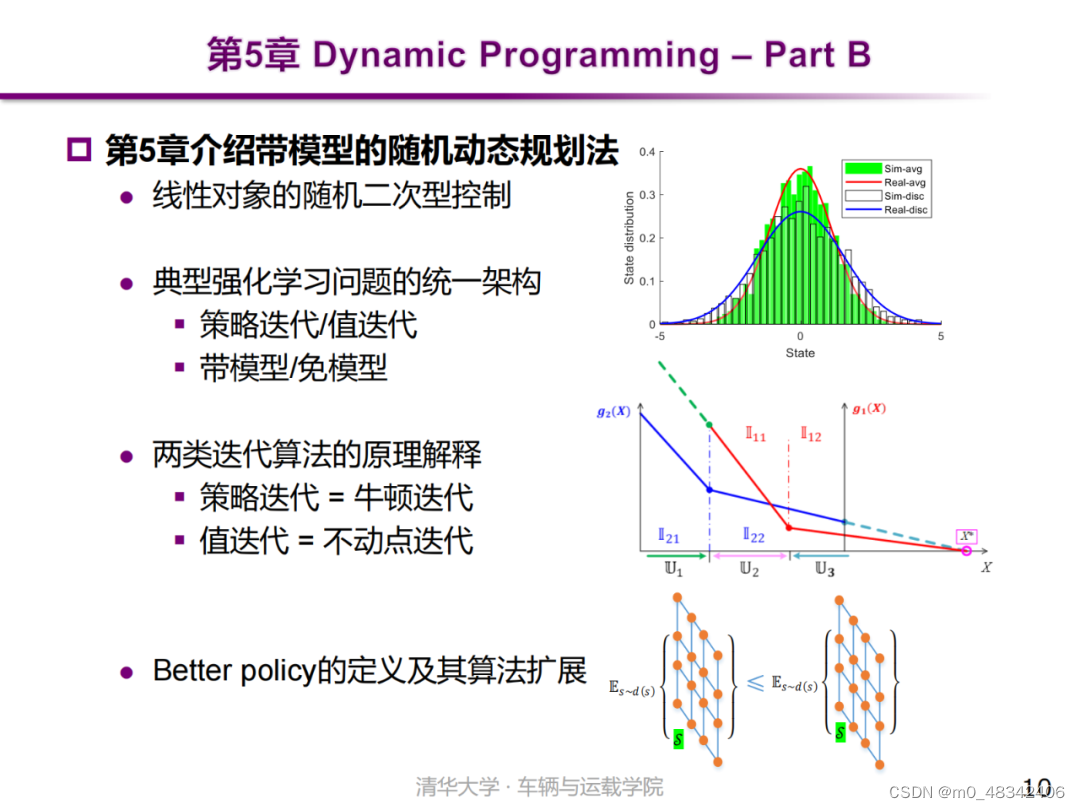

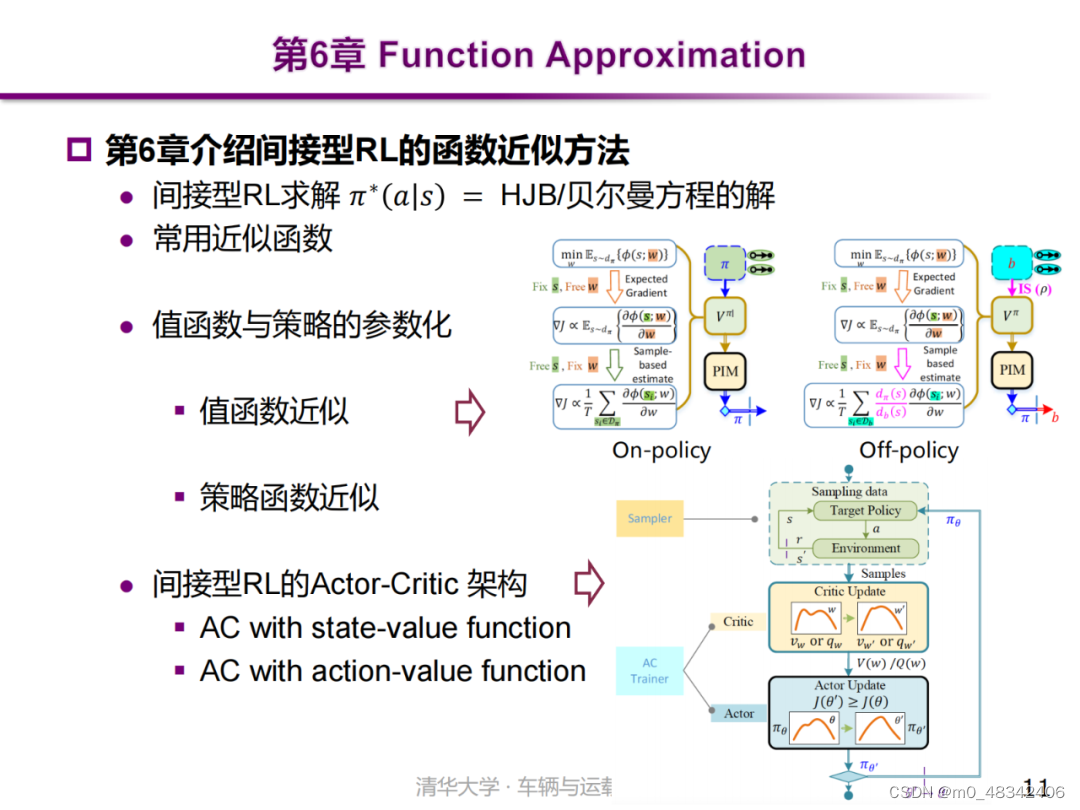

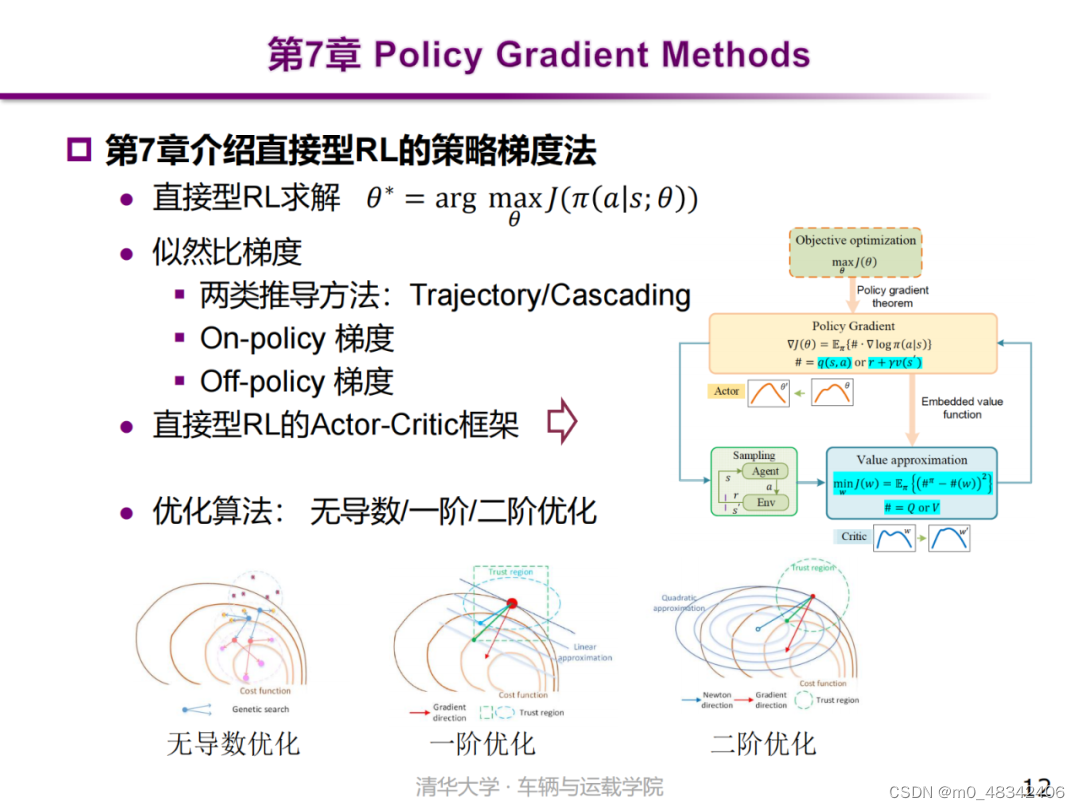

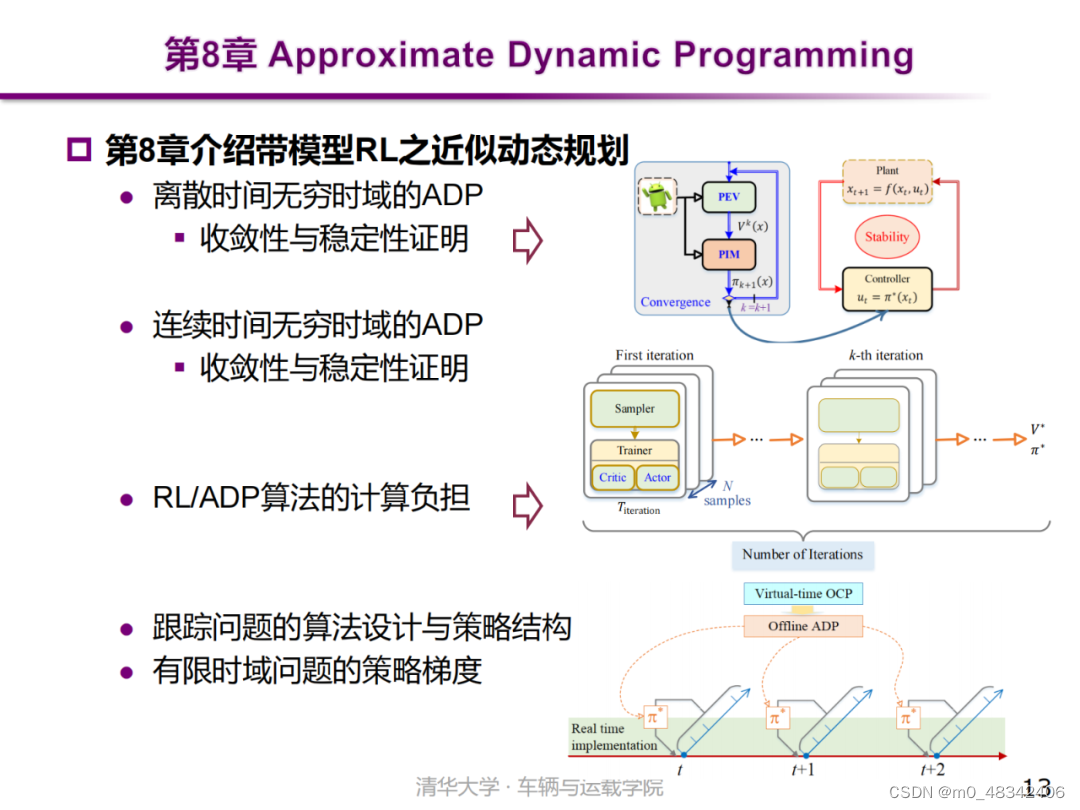

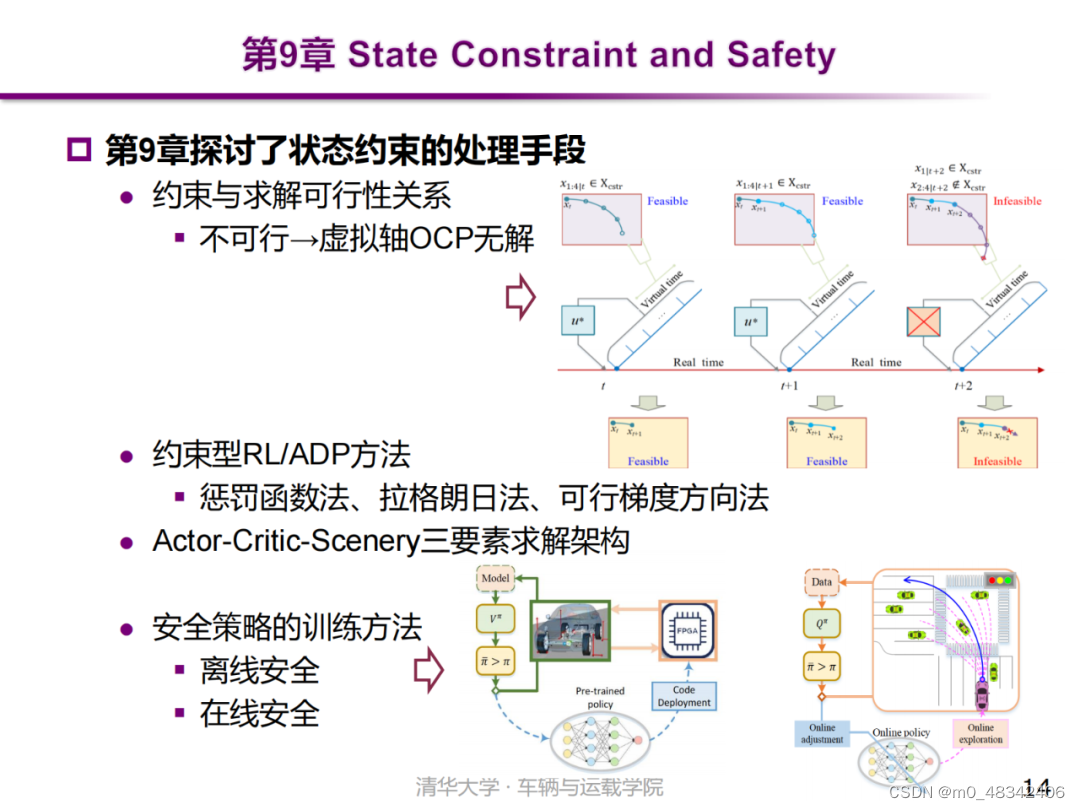

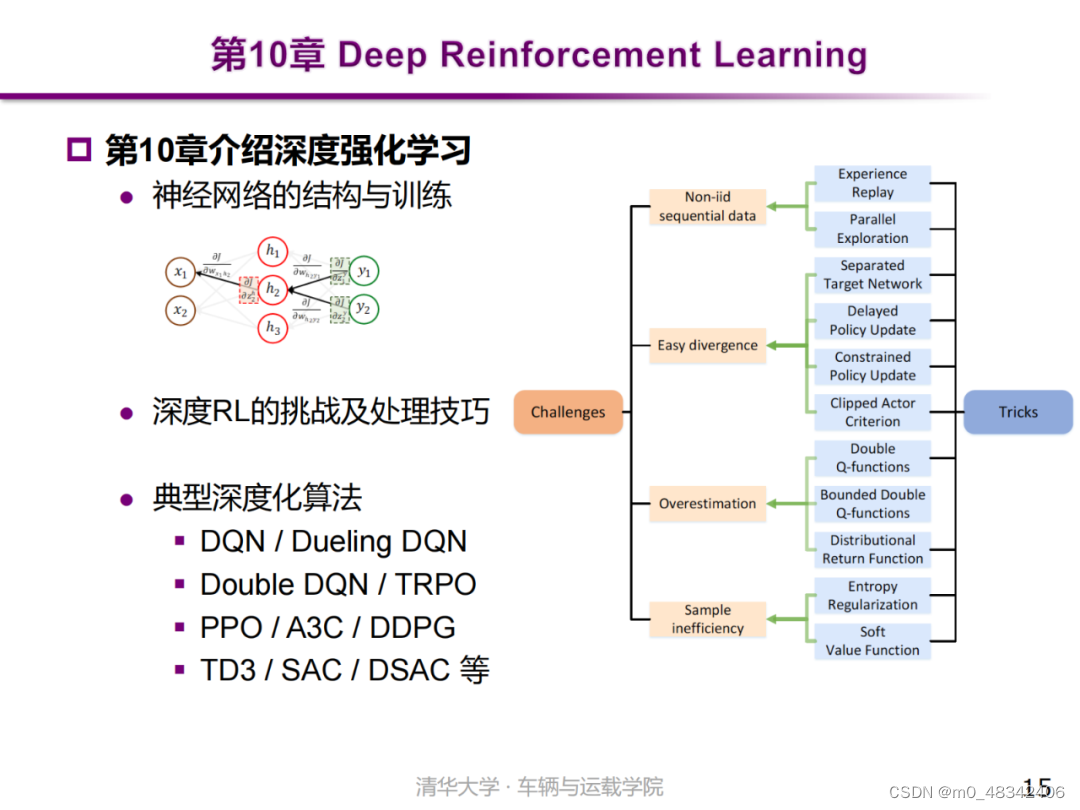

全书总共包括11章。第1章介绍强化学习(Reinforcement Learning, RL)概况,包括发展历史、知名学者、典型应用以及主要挑战等。第2章介绍RL的基础知识,包括定义概念、自洽条件、最优性原理与问题架构等。第3章介绍免模型RL的蒙特卡洛法,包括Monte Carlo估计、On-policy/Off-policy、重要性采样等。第4章介绍免模型RL的时序差分法,包括它衍生的Sarsa、Q-learning、Expected Sarsa等算法。第5章介绍带模型RL的动态规划法,包括策略迭代、值迭代、通用迭代架构与收敛性证明等。第6章介绍间接型RL的函数近似法,包括常用近似函数、值函数近似、策略函数近似以及所衍生的Actor-critic架构等。第7章介绍直接型RL的策略梯度法,包括On-policy gradient、Off-policy gradient、它们的代价函数与优化算法等。第8章介绍带模型的近似动态规划(ADP)方法,包括无穷时域的ADP、有限时域的ADP、ADP与MPC的联系与区别等。第9章探讨了状态约束的处理手段,它与求解可行性、策略安全性之间的关系,以及Actor-Critic-Scenery三要素求解架构等。第10章介绍深度强化学习(DRL),即以神经网络为载体的RL,包括神经网络的原理与训练,深度化挑战以及DQN、DDPG、TD3、TRPO、PPO、DSAC等典型深度化算法。第11章介绍RL的各类拾遗,包括鲁棒性、POMDP、多智能体、元学习、逆强化学习、离线强化学习以及训练框架与平台等。

541

541

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?