一、数据概述

使用手写数字的MNIST数据集如上图所示,该数据集包含60,000个用于训练的样本和10,000个用于测试的样本,图像是固定大小(28x28像素),其灰度值为0到255。

二、激活函数介绍:

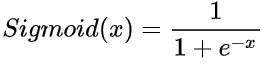

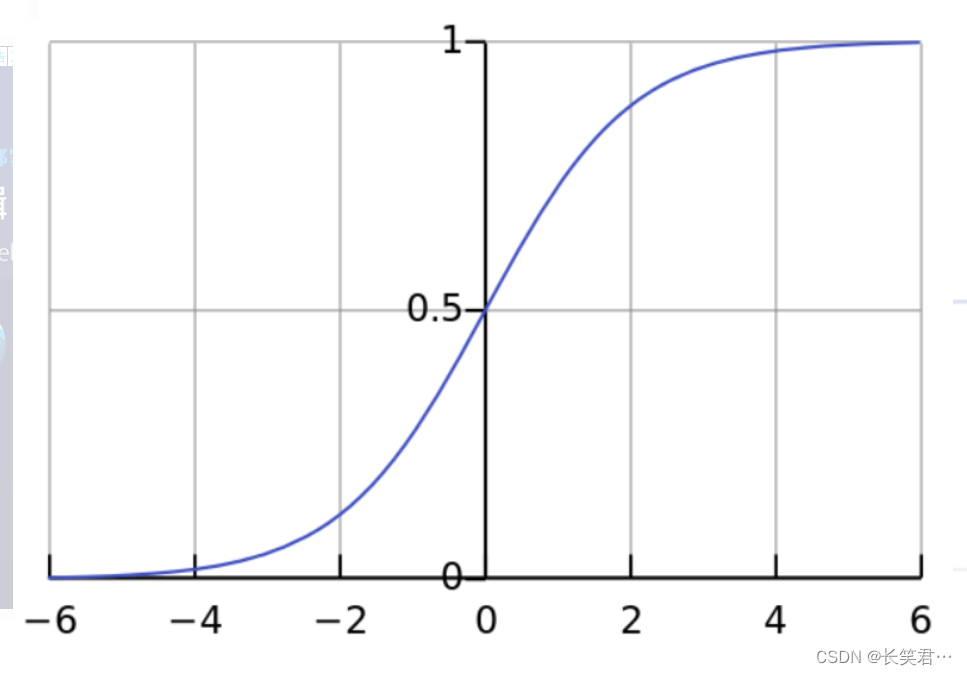

sigmoid激活函数

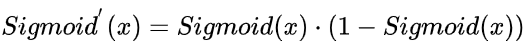

它的导函数为:

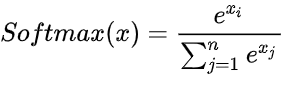

softmax激活函数:

如果模型输出为非互斥类别,且可以同时选择多个类别,则采用Sigmoid函数计算该网络的原始输出值。

如果模型输出为互斥类别,且只能选择一个类别,则采用Softmax函数计算该网络的原始输出值。

Sigmoid函数可以用来解决多标签问题,Softmax函数用来解决单标签问题。

激活函数代码实现:

def sigmoid(x):

return 1/(1 + np.exp(-x))

def softmax(x):

x = x-np.max(x)

exp_sum = np.sum(np.exp(x))

return np.exp(x)/exp_sum

三、数据预处理之参数设置

normalize:设置为True将图像像素灰度取值正规化为0.0-1.0的值,如果设置为False,则图像输入保持0~255。

faltten:将输入图像展开平铺为一维数组,否则图像为28*28*1,展开后为784。

one_hot_label:是否将标签保存为one_hot独热编码

def get_data():

(x_train, t_train), (x_test, t_test) = load_mnist

(normalize=True,flatten=True,one_hot_label=False)

return x_test, t_test四、完整代码

import sys, os

sys.path.append(os.pardir) # 为了导入父目录的文件而进行的设定

import numpy as np

import pickle#python的pickle模块实现了基本的数据序列化和反序列化。序列化对象可以在磁盘上保存对象,并在需要的时候读取出来。任何对象都可以执行序列化操作

from dataset.mnist import load_mnist

def sigmoid(x):

return 1 / (1 + np.exp(-x))

def softmax(x):

x = x - np.max(x) # 溢出对策

return np.exp(x) / np.sum(np.exp(x))

def get_data():

(x_train, t_train), (x_test, t_test) = load_mnist(normalize=False, flatten=True, one_hot_label=False)

return x_test, t_test

#训练好的参数

def init_network():

with open("sample_weight.pkl", 'rb') as f:

network = pickle.load(f)#load()从字符串中恢复对象。sample_weight.pkl是以字典形式储存的训练好的样本权重

return network

def predict(network, x):

w1, w2, w3 = network['W1'], network['W2'], network['W3']

b1, b2, b3 = network['b1'], network['b2'], network['b3']

a1 = np.dot(x, w1) + b1

z1 = sigmoid(a1)

a2 = np.dot(z1, w2) + b2

z2 = sigmoid(a2)

a3 = np.dot(z2, w3) + b3

y = softmax(a3)

return y

#预设

x, t = get_data()

network = init_network()

batch_size = 100 # 批数量

accuracy_cnt = 0#预测正确数初始化

for i in range(0, len(x), batch_size):

x_batch = x[i:i+batch_size]#每批次取100张图片

y_batch = predict(network, x_batch)#100张图片的预测结果

p = np.argmax(y_batch, axis=1)#每张图片的预测结果中找出概率最大值的下标,axis=1按行找出最大值的下标,下标达标该图片所代表的的预测值 p.shape=(100,)

accuracy_cnt += np.sum(p == t[i:i+batch_size])#预测值和正确值相比较返回bool值矩阵,True的值是1,False的值是0,对矩阵求和即可得到预测正确数,并进行累加求和

print("正确率:" + str((accuracy_cnt/ len(x))))

1407

1407

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?