一、安装 CUDA

建议下载历史版本的CUDA(以安装CUDA11.4为例)

找到你所要下载的版本,我就找CUDA Toolkit 11.4.4,点进去

然后选择自己对应的系统版本的CUDA,并下载(在这里我们推荐用

然后选择自己对应的系统版本的CUDA,并下载(在这里我们推荐用runfile(local)的方式进行下载):

请注意,有的CUDA版本只支持特定版本的linux发行版系统,请进行匹对。

按照它给出来的指令依次执行:

wget https://developer.download.nvidia.com/compute/cuda/11.4.4/local_installers/cuda_11.4.4_470.82.01_linux.run

sudo sh cuda_11.4.4_470.82.01_linux.run 出现报错Failed to verify gcc version. See log at /var/log/cuda-installer.log for details.表示安装CUDA时,安装程序无法验证系统中GCC(GNU Compiler Collection)编译器的版本。CUDA通常需要特定版本的GCC来编译部分组件。

出现报错Failed to verify gcc version. See log at /var/log/cuda-installer.log for details.表示安装CUDA时,安装程序无法验证系统中GCC(GNU Compiler Collection)编译器的版本。CUDA通常需要特定版本的GCC来编译部分组件。

解决方法:

-

检查GCC版本:运行

gcc --version查看当前GCC版本是否符合CUDA的要求。 -

安装或更新GCC:如果GCC版本不符合要求,需要安装或更新到合适的版本。可以使用包管理器(如apt-get或yum)来安装。例如,在Ubuntu系统中,可以使用以下命令安装或更新GCC:

gcc --version

sudo apt-get update

sudo apt-get install gcc输入gcc --version之后出现Command 'gcc' not found, but can be installed with: sudo apt install gcc表示'命令gcc'没有找到,但可以安装:sudo apt install gcc

安装好了gcc之后,重新运行CUDA安装程序,如下图:

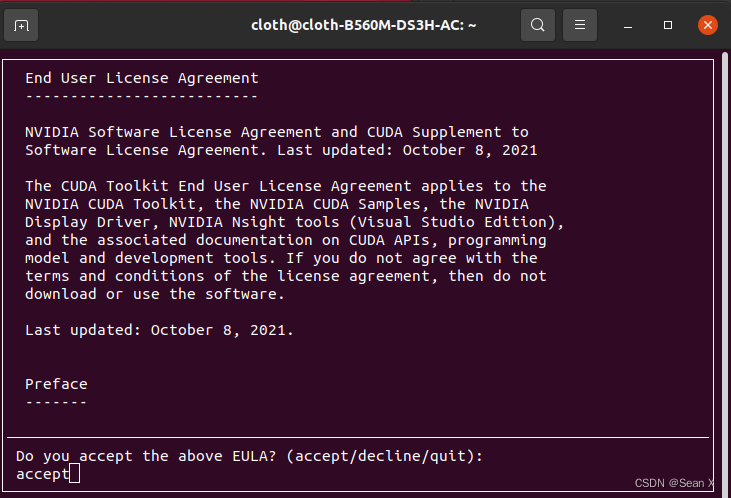

1、接下来出现以下界面,输入accept

接着出现:

接着出现:

2、按Enter回车取消 Driver 的安装,也就是

2、按Enter回车取消 Driver 的安装,也就是[ ]里面没有X(因为一般已经装好驱动了),然后点击键盘的↑ ↓按键,↓选择Install再按回车 :

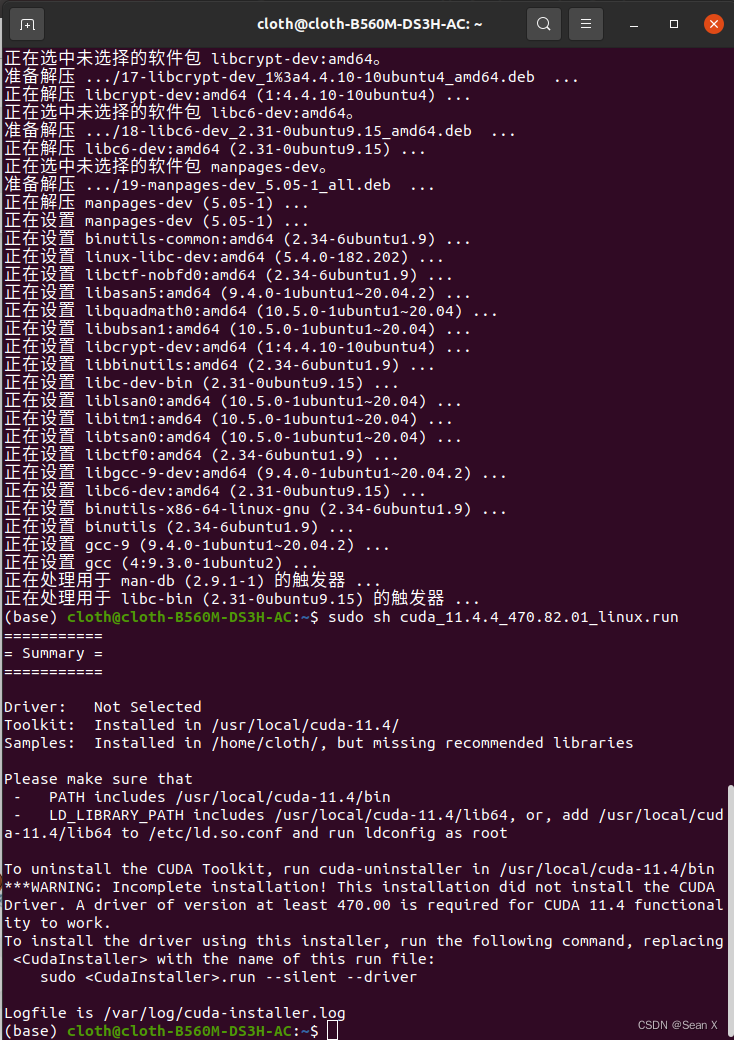

3、接着输入sudo sh cuda_11.4.4_470.82.01_linux.run等待即可,出现以下界面就是安装完成

4、接着需要添加CUDA的环境变量,以便于可以任何地方都能启动它(不知道Linux的环境变量知识点可自行搜索),输入以下命令:

sudo vim ~/.bashrc

出现sudo: vim:找不到命令的错误,是因为系统缺少vim编辑器,而sudo命令需要用到编辑器来编辑文件。

首先,我们需要确认系统是否缺少vim编辑器。在终端输入以下命令:vim

如果系统没有安装vim编辑器,终端会提示Command 'vim' not found。

然后使用以下命令来安装vim编辑器:

sudo apt-get update

sudo apt-get install vim

这样就安装好了vim编辑器,安装完成后,我们可以再次运行vim命令来确认是否成功安装了vim编辑器。此时,终端不应该再报错找不到vim命令。

这样就安装好了vim编辑器,安装完成后,我们可以再次运行vim命令来确认是否成功安装了vim编辑器。此时,终端不应该再报错找不到vim命令。

按:q<Enter>就可以退出该界面。

按:q<Enter>就可以退出该界面。

接着继续第4步输入sudo vim ~/.bashrc

在最后面一行输入export PATH=/usr/local/cuda-11.4/bin:$PATH (可以看到cuda的环境变量路径就在其他位置/计算机/usr/local/cuda-11.4/bin路径下)

export PATH=/usr/local/cuda-11.4/bin:$PATH然后输入:wq!保存

5.接着source ~/.bashrc

至此我们安装cuda成功,可以通过以下命令查看cuda信息:

查看CUDA版本信息:nvcc --version

没有问题的话,一般会输出以下信息:

里面就可以显示你的CUDA信息了。

二、Windows安装cuda,cudnn,tensorrt

先进入cuda官方网址:CUDA Toolkit 12.8 Update 1 Downloads | NVIDIA Developer

我下载的是cuda_12.6.3_561.17_windows.exe,然后双击cuda_12.6.3_561.17_windows.exe,然后点ok,同意并继续,自定义,下一步,直到安装完成。然后配置CUDA环境变量,打开控制面板,系统,高级系统设置,环境变量,系统变量,将C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\bin添加到 Path 环境变量中。接着检查是否安装成功,输入nvcc -V或者nvcc --version,如果是下面这个样子,就说明安装成功了。否则,就说明哪一步肯定出错了,需要重装CUDA。

三、Windows安装cudnn

cudnn官网地址:cuDNN Archive | NVIDIA Developer

cuda装的是12.6,要找适配的cudann,装的是框出来的cuda装的是12.6,要找适配的cudann,装的是框出来的

解压,

把cudnn-windows-x86_64-8.9.7.29_cuda12-archive里面的bin文件夹的东西复制到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\bin里面去

同理cudnn-windows-x86_64-8.9.7.29_cuda12-archive里面的include文件夹的东西复制到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\include里面去

同理cudnn-windows-x86_64-8.9.7.29_cuda12-archive里面的lib文件夹的东西复制到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\lib里面去

添加至环境变量,往系统环境变量中的 path 添加如下路径(根据自己的路径进行修改)

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\bin

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\include

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\lib

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\libnvvp

验证配置是否成功,配置完成后,我们可以验证是否配置成功,主要使用CUDA内置的deviceQuery.exe 和 bandwidthTest.exe:

首先win+R启动cmd,cd到安装目录下的 …\extras\demo_suite,然后分别执行bandwidthTest.exe和deviceQuery.exe(进到目录后需要直接输“bandwidthTest.exe”和“deviceQuery.exe”),得到下图:

已经安装好了cudnn,在终端检查cudnn,

import ctypes

cudnn = ctypes.CDLL(r"C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6\bin\cudnn64_8.dll")

print(cudnn.cudnnGetVersion())

cudnnGetVersion() 返回的 8907 代表你安装的 cuDNN 版本是 8.9.0(即 8.9.0.7)。

然后查看torch,

import torch

>>> print(torch.backends.cudnn.version())

90100

>>> print(torch.cuda.is_available())

True

>>> print(torch.backends.cudnn.enabled)

True

四、Windows安装tensorrt

接下来安装tensorrt,

我的 CUDA 12.6 ,cuDNN 8.9.0 , PyTorch 2.4.0(CUDA 12.4 版)

Tensorrt的官网:Log in | NVIDIA Developer

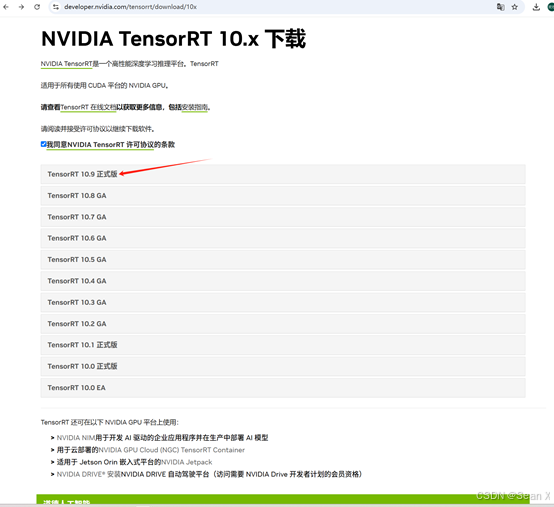

注意:EA 版本代表抢先体验(在实际发布之前)。GA 代表一般可用性。GA 是稳定版,经过全面测试。

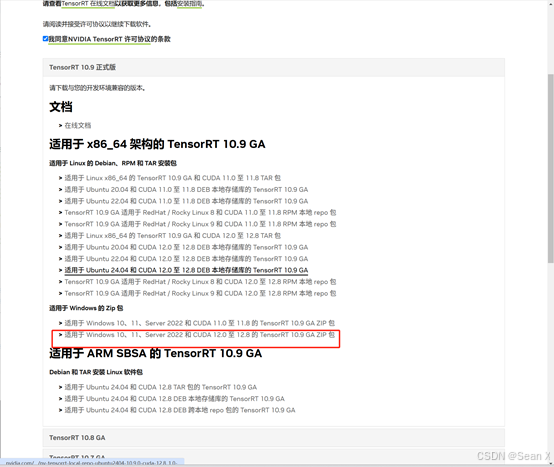

所以我们建议您使用 TensorRT 最新版本的 GA 版本。如下是cuda11.3对应的

解压文件

然后将下载好后的部分,

如我这的TensorRT-10.9.0.34文件夹中的include文件移动到你的CUDA文件夹下的include,我这是(C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6),如我这的TensorRT-10.9.0.34文件夹中的lib中的dll与lib文件分别放到CUDA下的bin与lib\x64文件夹中,TensorRT-10.9.0.34文件夹中的nclude文件移动到你的CUDA文件夹下的include,我这是(C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6)

TensorRT-10.9.0.34文件夹中的lib中的dll放到CUDA下的bin

TensorRT-10.9.0.34文件夹中的lib中的lib文件放到CUDA下的lib\x64文件夹中

然后pip安装包内的whl文件,安装方式如下,注意安装tensorrt的whl的时候,要根据你python环境来,我这里是3.11版本,所有就选的cp311,在python文件夹里选择

先cd进tensorrt的目录下,cd E:\software\tensorrt\TensorRT-10.9.0.34.Windows.win10.cuda-12.8\TensorRT-10.9.0.34\python,然后

pip install tensorrt-10.9.0.34-cp311-none-win_amd64.whl

以上就是已经安装好了tensorrt,验证是否安装好了tensorrt,

import tensorrt as trt

print(trt.__version__)

在另一个虚拟环境也装tensorrt,如下:

先看python的版本,3.11版本

在tensorrt里找到了python3.11版本

先cd E:\software\tensorrt\TensorRT-10.9.0.34.Windows.win10.cuda-12.8\TensorRT-10.9.0.34\python,然后输入 pip install tensorrt-10.9.0.34-cp311-none-win_amd64.whl就在该虚拟环境中安装好了tensorrt

1073

1073

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?