✅作者简介:热爱科研的Matlab仿真开发者,擅长数据处理、建模仿真、程序设计、期刊写作与指导,代码获取、论文复现及科研仿真合作可私信或扫描文章底部二维码。

🍎个人主页:Matlab科研工作室

🍊个人信条:格物致知。

更多Matlab完整代码及仿真定制内容点击👇

🔥 内容介绍

本文给出了一种面向动态交通环境的辅助驾驶决策方法,能够基于动态车流信息给

出路线规划方案。为了实现这一点,本方案以各个路口为节点,将道路简化为离散化网格图;基于状态对环境进行了离散化建模,使计算机得以模拟动态交通环境;通过道路长宽,其他车辆数目的因素建模计算各节点之间的行驶代价,构建车辆运行规则。在上述建模基础上,方案使用 A*和强化学习两种决策算法分别实现了实时路线规划。

关键词:动态交通环境;辅助驾驶;A*;Q-Learning;决策方法

0 引言

智能交通系统(Intelligent Transportation System,ITS)旨在构建更加安全,舒适,稳定

的交通环境;车辆高级驾驶辅助系统(Advanced Driver Assistance System,ADAS)近年来也

有了较快的发展[1]。其中,行车环境信息采集、行车环境表征建模及驾驶行辅助决策是驾驶

辅助决策的重要研究方向[2-4]。本文主要关注辅助驾驶决策中基于状态信息转换的驾驶路径

生成研究,旨在探讨动态交通环境下的车辆调度决策方法。

目前关于出行的导航规划问题,大多是基于静态道路信息进行驾驶员的辅助驾驶路线决

策,主要侧重于图论中的路径规划。涉及车辆出行规划的研究大致可分为两类[5]:第一类主

要为车辆集群推荐出行规划方案[6-8],针对车队整体运营目标进行优化,不反映驾驶员的驾

驶需求。第二类问题针对单辆汽车,考虑最短距离[9]、最短时间[9,10]或最短能量消耗[11]等目

标,为驾驶员推荐最优的驾驶路线,但仅考虑了确定性环境。

现有的地图导航软件,如百度地图、高德地图等,其动态信息大多是基于历史数据库的

迭代更新,利用数据驱动的方法,针对交通流这一批次性的间歇过程进行道路交通的建模,

并没有真正考虑到动态交通环境所带来的道路车辆转移规则,难以为驾驶员提供综合覆盖区

域动态信息等因素的辅助驾驶决策结果。

根据文献[12]的总结,无人驾驶车辆行为决策方法可以根据驾驶策略搜索和存储方式的

不同,分为四类:状态机模型、决策/行为树模型、基于知识的推理决策模型和基于效用/价

值的决策模型。本文采用了状态机模型的方法,即在司机驾驶的过程中,根据当前实时的交

通环境状态进行辅助决策,通过构建连通图来描述不同的驾驶途经点以及状态之间的转移关

系,从而根据驾驶状态的迁移地生成驾驶策略。此外,本文重点关注初始道路交通全局信息

已知情况下的动态交通流建模和车辆路径辅助决策方法,将采用基于状态更新的离散模型进

行建模,并利用 A*和 Q-Learning 两种决策算法进行求解,给出动态交通环境下的辅助决策

结果,为玉泉到紫金港的校车进行优化调度。

1 问题描述

1.1 问题目标重述

本文关注在拥有区域交通流的全局信息条件下,如何考虑动态交通流的变化情况,对玉

泉开往到紫金港的校车司机提供一种辅助性的驾驶路线决策方法。

首先,限定动态交通区域为玉泉到紫金港可能经过部分区域,对道路进行一定的简化,

考虑车流量大的主干道,删减部分小路,以降低模型的复杂度且不失一般性。同时,限定该

区域和外界没有车辆交换,仅考虑区域内的车辆流动和转移。

其次,对车流分布以及道路交通规则进行数学建模,考虑道路车辆密度、车道宽度、道

路长度、目的地导向信息等因素,构建车辆状态转移模型和区域交通流动模型。

最后,基于建立的交通规则模型,对从玉泉开往紫金港方向的校车,以朝向目标点、避

免拥堵等为综合目标,以不同车流分布(动态变化)和道路交通规则为约束,寻求一种代价

最小的行车方案。

1.2 形式化定义

辅助驾驶决策问题可以结合地图构建、路口标号,将其转化为数学问题,而优化目标为

寻求一条最优的路径。其中,最优的定义是使得总代价最小,而代价与多种因素相关。

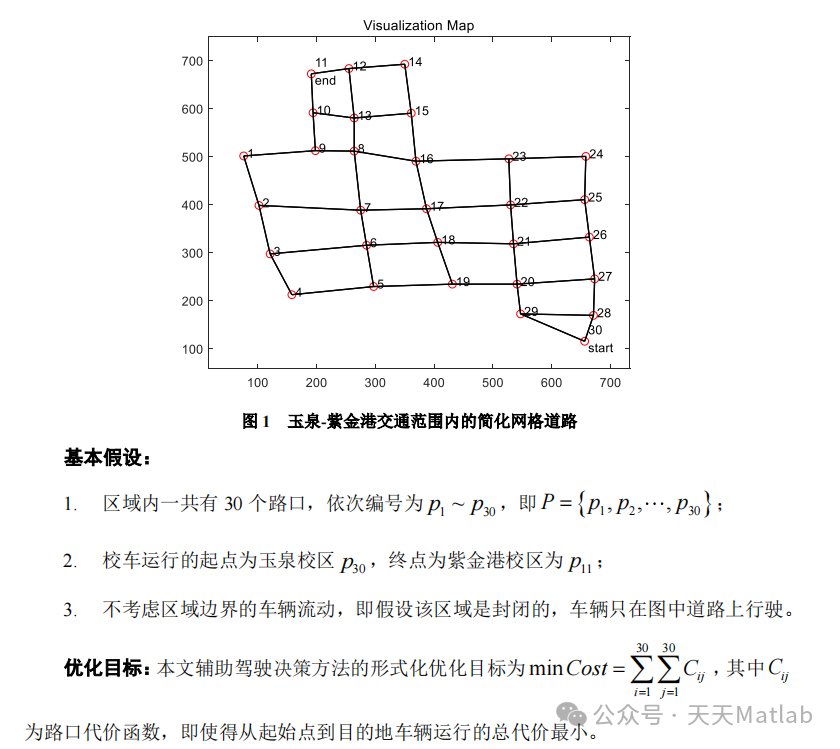

为了简便起见,需要将道路进行简化,选取其中靠近主干道的部分路口,同时假设路口

见道路呈直线(事实上也基本是直线),最终将道路简化成如图 1 所示的网格化地图。

道路信息提取与简化处理

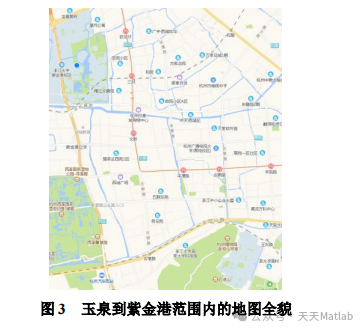

为方便后续进行道路交通建模与决策,首先通过百度地图获取从玉泉校区到紫金港校区

的地图全貌,如图 3 所示。

注意到,在图 3 中,除主干道以外,还有很多道路小分枝可以选择。在此,为了将侧重

点放在建模与决策方案上,忽略掉道路小分枝,并以主干道为重点考虑的交通道路,从而完

成对地图的简化。

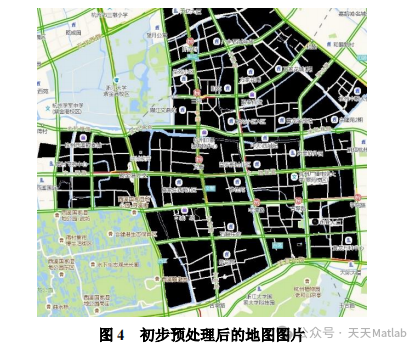

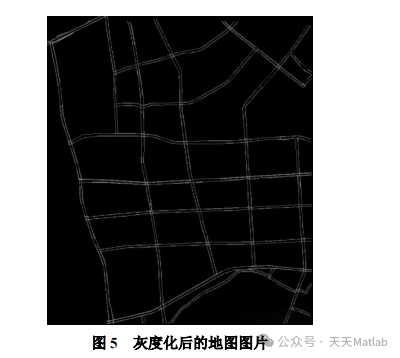

在原地图的基础上,将非道路部分涂色为黑色,可以得到下图所示的地图图片,作为道

路信息提取的输入,如图 4 所示。

由于图 4 将大部分非道路区域都进行了黑色染色处理,从而可以突出道路部分。因此,

将上图转化为灰度图片,并根据每个像素的灰度值作滤波处理,得到灰度化后的地图图像,

如图 5 所示。

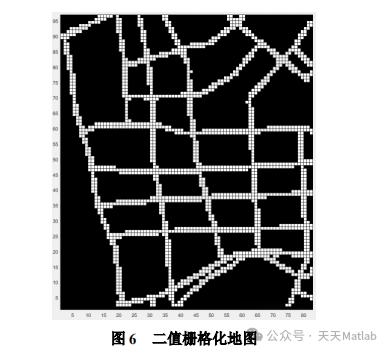

将上述灰度图进行拓展并卷积,使得在卷积核范围内出现灰度值>0 的像素时令该卷积

核范围的像素为白色(即可通道路),进行滤波处理后得到二值栅格化地图,如图 6 所示。

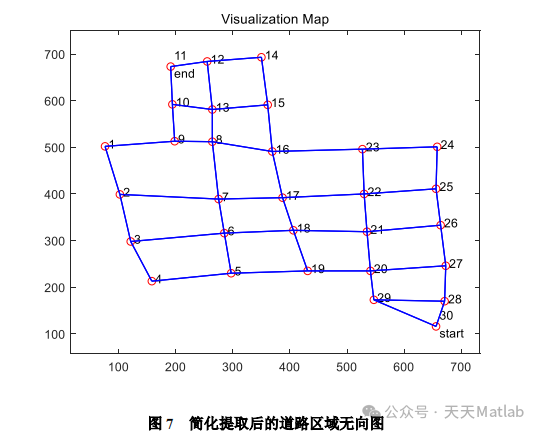

由图 6 可以看出,该二值栅格化地图很好地体现了原始地图中的道路信息。为便于进行

离散道路建模,将上述二值栅格化地图抽象为一个无向图。其中,每一个路口抽象为一个节

点,路口之间若有道路连通,则将道路抽象为边,得到抽象的无向图如图 7 所示。

其中,每个路口的横纵坐标取决于其在图片中的像素位置。由于所有路口统一由同一张

图片标定位置,其尺度是一样的,因而该无向图能够很好地表征原来的道路信息图。至此,

对道路信息的提取与简化预处理完成。

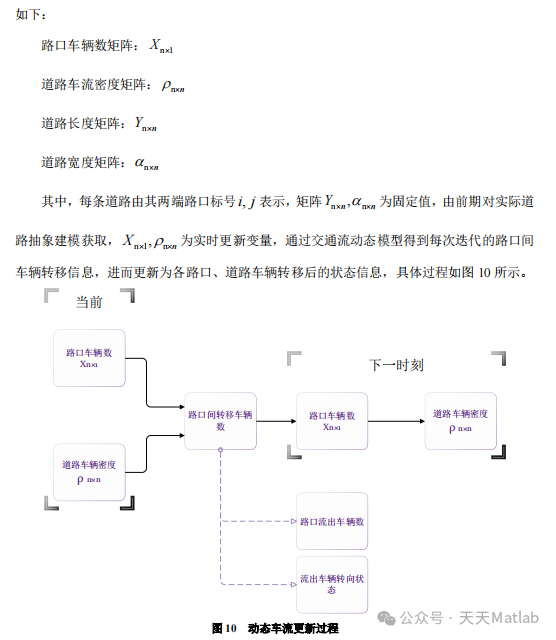

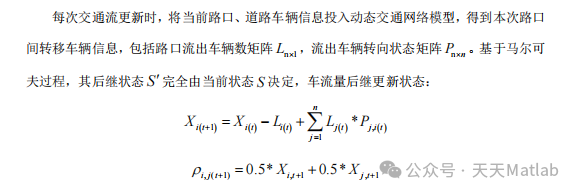

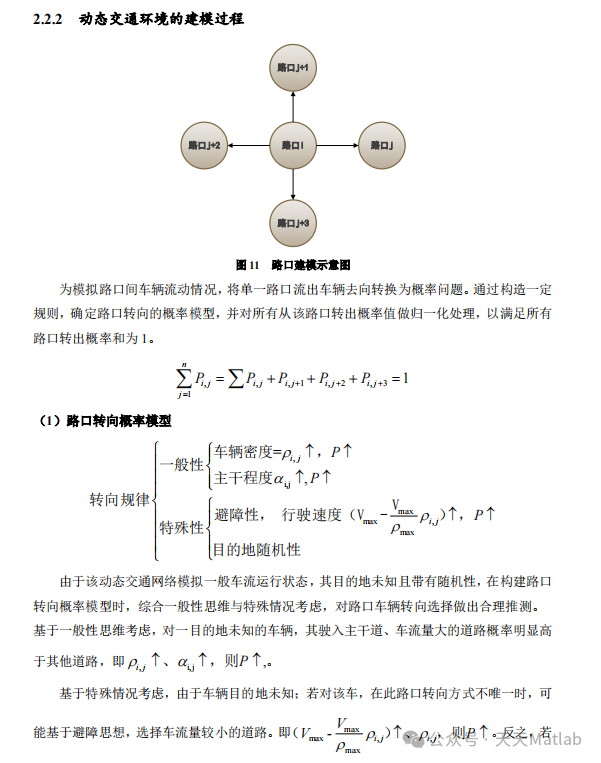

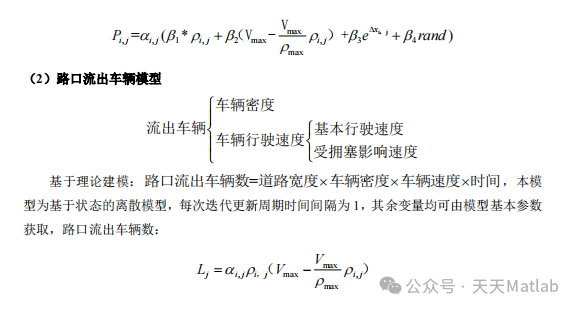

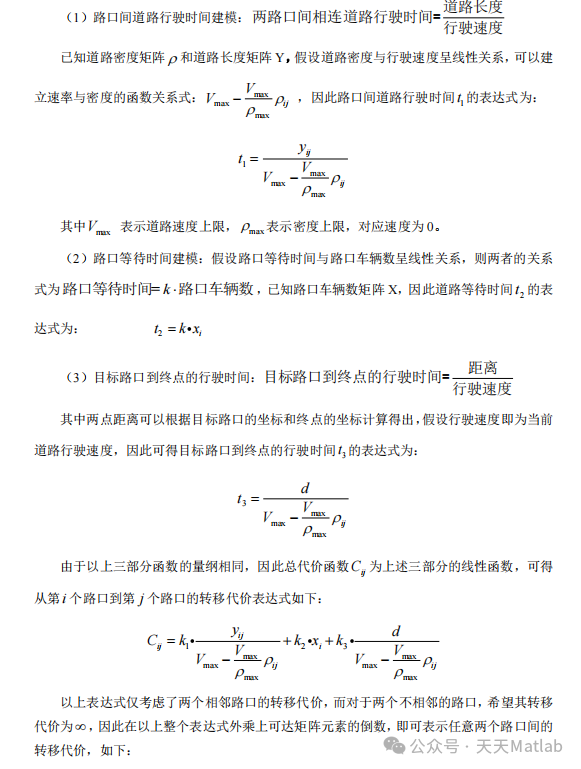

动态交通环境的构建思路

为了验证决策方法在动态交通下的运行效果,我们需要对动态交通进行基于状态的离散

建模。已知紫金港-玉泉区域共有 n 个路口,根据实际交通网络状况获得模型基本变量信息

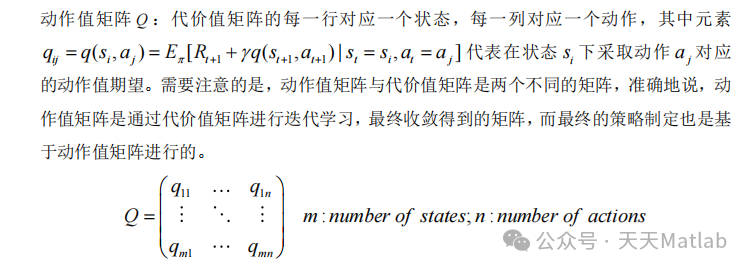

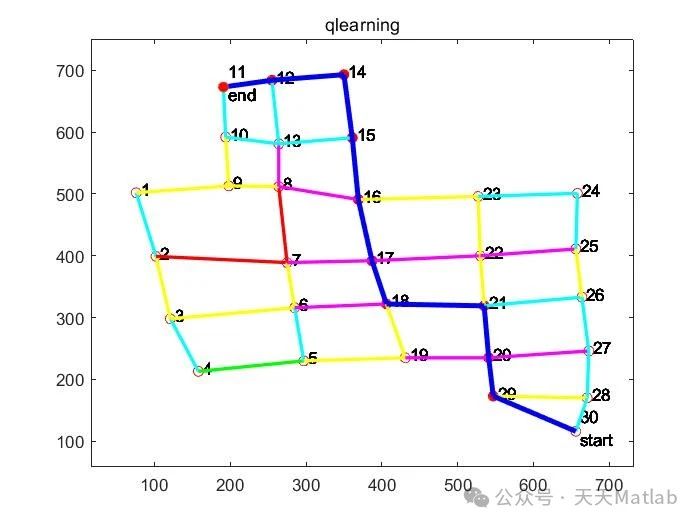

基于 Q-learning 的辅助驾驶决策方法

3.3.1 考虑局部信息的决策方法

如前文所述,在全局信息可观的情况下,A*算法是一种十分优秀的路径规划算法。但大

多数实际情况下,全局信息对于 agent 而言是不可观的,这就导致 A*等一系列启发式搜索

算法难以得到应用。如何解决全局信息不可观情况下的路径搜索策略,是一个亟待考虑的问

题。

在本次问题求解中,我们主要采用了基于强化学习的路径规划算法。在问题求解过程中,

假若 agent 仅能获取局部信息,如图 12 所示,当 agent 处于路口Cross1时,其可观的信息

仅包括相邻路口Cross i的车辆信息及相连道路Road i (1, )的车流密度信息,强化学习方法

的优势便能够得到很好地体现

⛳️ 运行结果

🔗 参考文献

🎈 部分理论引用网络文献,若有侵权联系博主删除

👇 关注我领取海量matlab电子书和数学建模资料

🎁 私信完整代码和数据获取及论文数模仿真定制

🌈 各类智能优化算法改进及应用

生产调度、经济调度、装配线调度、充电优化、车间调度、发车优化、水库调度、三维装箱、物流选址、货位优化、公交排班优化、充电桩布局优化、车间布局优化、集装箱船配载优化、水泵组合优化、解医疗资源分配优化、设施布局优化、可视域基站和无人机选址优化、背包问题、 风电场布局、时隙分配优化、 最佳分布式发电单元分配、多阶段管道维修、 工厂-中心-需求点三级选址问题、 应急生活物质配送中心选址、 基站选址、 道路灯柱布置、 枢纽节点部署、 输电线路台风监测装置、 集装箱调度、 机组优化、 投资优化组合、云服务器组合优化、 天线线性阵列分布优化、CVRP问题、VRPPD问题、多中心VRP问题、多层网络的VRP问题、多中心多车型的VRP问题、 动态VRP问题、双层车辆路径规划(2E-VRP)、充电车辆路径规划(EVRP)、油电混合车辆路径规划、混合流水车间问题、 订单拆分调度问题、 公交车的调度排班优化问题、航班摆渡车辆调度问题、选址路径规划问题、港口调度、港口岸桥调度、停机位分配、机场航班调度、泄漏源定位

🌈 机器学习和深度学习时序、回归、分类、聚类和降维

2.1 bp时序、回归预测和分类

2.2 ENS声神经网络时序、回归预测和分类

2.3 SVM/CNN-SVM/LSSVM/RVM支持向量机系列时序、回归预测和分类

2.4 CNN|TCN|GCN卷积神经网络系列时序、回归预测和分类

2.5 ELM/KELM/RELM/DELM极限学习机系列时序、回归预测和分类

2.6 GRU/Bi-GRU/CNN-GRU/CNN-BiGRU门控神经网络时序、回归预测和分类

2.7 ELMAN递归神经网络时序、回归\预测和分类

2.8 LSTM/BiLSTM/CNN-LSTM/CNN-BiLSTM/长短记忆神经网络系列时序、回归预测和分类

2.9 RBF径向基神经网络时序、回归预测和分类

4229

4229

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?