定义一个映射面部索引的字典

特定面部区域的标记

FACIAL_LANDMARKS_IDXS = OrderedDict([

(“mouth”, (48, 68)),

(“right_eyebrow”, (17, 22)),

(“left_eyebrow”, (22, 27)),

(“right_eye”, (36, 42)),

(“left_eye”, (42, 48)),

(“nose”, (27, 35)),

(“jaw”, (0, 17))

])

使用这个字典,我们可以轻松地将索引提取到面部标志数组中,并只需提供一个字符串作为键即可提取各种面部特征。

==================================================================

稍微困难的任务是将这些面部标志中的每一个可视化并将结果叠加在输入图像上。为此,我们需要 imutils 库中已包含的visualize_facial_landmarks 函数:

def visualize_facial_landmarks(image, shape, colors=None, alpha=0.75):

create two copies of the input image – one for the

overlay and one for the final output image

overlay = image.copy()

output = image.copy()

if the colors list is None, initialize it with a unique

color for each facial landmark region

if colors is None:

colors = [(19, 199, 109), (79, 76, 240), (230, 159, 23),

(168, 100, 168), (158, 163, 32),

(163, 38, 32), (180, 42, 220)]

我们的visualize_facial_landmarks 函数需要两个参数,后跟两个可选参数,每个参数的详细信息如下:

image :我们将在其上绘制面部标志性可视化的图像。

shape : NumPy 数组,包含映射到不同面部部位的 68 个面部标志坐标。

colors :用于对每个面部标志区域进行颜色编码的 BGR 元组列表。

alpha :用于控制原始图像上叠加层的不透明度的参数。

我们现在准备通过面部标志来可视化每个单独的面部区域:

分别循环面部标志区域

for (i, name) in enumerate(FACIAL_LANDMARKS_IDXS.keys()):

获取与关联的 (x, y) 坐标

#人脸地标

(j, k) = FACIAL_LANDMARKS_IDXS[name]

pts = shape[j:k]

检查是否应该绘制下颌线

if name == “jaw”:

由于下颌线是一个非封闭的面部区域,

只在 (x, y) 坐标之间画线

for l in range(1, len(pts)):

ptA = tuple(pts[l - 1])

ptB = tuple(pts[l])

cv2.line(overlay, ptA, ptB, colors[i], 2)

否则,计算人脸的凸包

地标坐标点并显示

else:

hull = cv2.convexHull(pts)

cv2.drawContours(overlay, [hull], -1, colors[i], -1)

遍历 FACIAL_LANDMARKS_IDXS 字典中的每个条目。

对于这些区域中的每一个,我们提取给定面部部分的索引并从形状 NumPy 数组中获取 (x, y) 坐标。

检查是否正在绘制下颌,如果是,只需循环各个点,绘制一条将下颌点连接在一起的线。

否则,处理计算点的凸包并在叠加层上绘制包。

最后一步是通过 cv2.addWeighted 函数创建透明叠加层:

应用透明覆盖

cv2.addWeighted(overlay, alpha, output, 1 - alpha, 0, output)

return the output image

return output

将visualize_facial_landmarks 应用于图像和关联的面部标记后,输出将类似于下图:

使用 dlib、OpenCV 和 Python 提取部分人脸

=========================================================================================

新建一个文件,将其命名为 detect_face_parts.py ,并插入以下代码:

import the necessary packages

from imutils import face_utils

import numpy as np

import argparse

import imutils

import dlib

import cv2

construct the argument parser and parse the arguments

ap = argparse.ArgumentParser()

ap.add_argument(“-p”, “–shape-predictor”, required=True,

help=“path to facial landmark predictor”)

ap.add_argument(“-i”, “–image”, required=True,

help=“path to input image”)

args = vars(ap.parse_args())

初始化dlib的人脸检测器(基于HOG)然后创建

面部标志预测器

detector = dlib.get_frontal_face_detector()

predictor = dlib.shape_predictor(args[“shape_predictor”])

加载输入图像,调整大小,并将其转换为灰度

image = cv2.imread(args[“image”])

image = imutils.resize(image, width=500)

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

在灰度图像中检测人脸

rects = detector(gray, 1)

导入我们需要的 Python 包。

解析我们的命令行参数。

实例化 dlib 的基于 HOG 的面部检测器并加载面部标志预测器。

加载和预处理我们的输入图像。

在我们的输入图像中检测人脸。

现在我们已经在图像中检测到人脸,我们可以单独循环每个人脸 ROI:

循环面部检测

for (i, rect) in enumerate(rects):

确定面部区域的面部标志,然后

将地标 (x, y) 坐标转换为 NumPy 数组

shape = predictor(gray, rect)

shape = face_utils.shape_to_np(shape)

单独循环面部部分

for (name, (i, j)) in face_utils.FACIAL_LANDMARKS_IDXS.items():

克隆原始图像,以便我们可以在其上绘制,然后

在图像上显示人脸部分的名称

clone = image.copy()

cv2.putText(clone, name, (10, 30), cv2.FONT_HERSHEY_SIMPLEX,

0.7, (0, 0, 255), 2)

循环面部标志的子集,绘制

特定的面部部分

for (x, y) in shape[i:j]:

cv2.circle(clone, (x, y), 1, (0, 0, 255), -1)

自我介绍一下,小编13年上海交大毕业,曾经在小公司待过,也去过华为、OPPO等大厂,18年进入阿里一直到现在。

深知大多数Python工程师,想要提升技能,往往是自己摸索成长或者是报班学习,但对于培训机构动则几千的学费,着实压力不小。自己不成体系的自学效果低效又漫长,而且极易碰到天花板技术停滞不前!

因此收集整理了一份《2024年Python开发全套学习资料》,初衷也很简单,就是希望能够帮助到想自学提升又不知道该从何学起的朋友,同时减轻大家的负担。

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,基本涵盖了95%以上Python开发知识点,真正体系化!

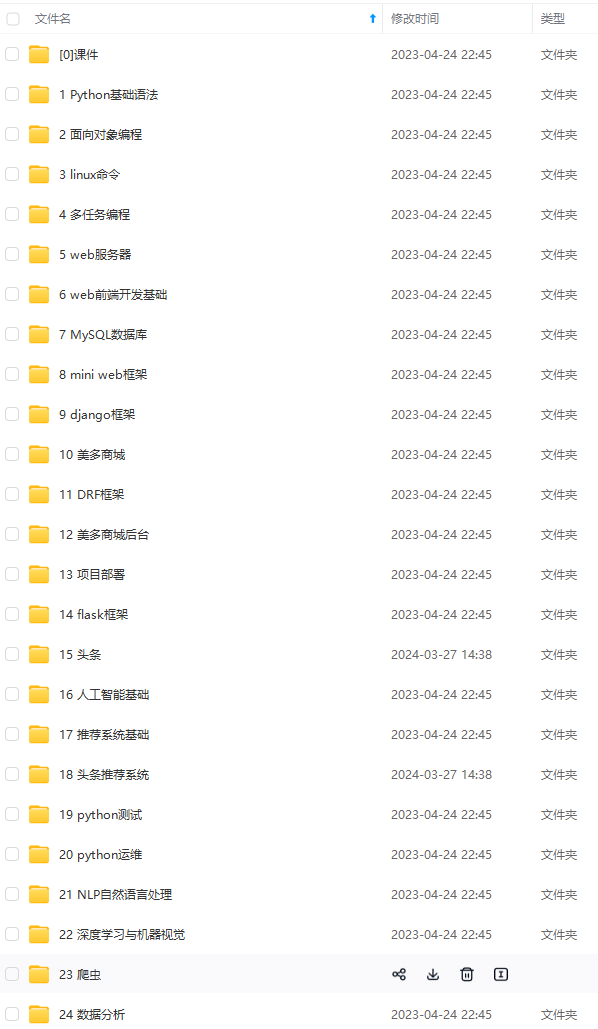

由于文件比较大,这里只是将部分目录大纲截图出来,每个节点里面都包含大厂面经、学习笔记、源码讲义、实战项目、讲解视频,并且后续会持续更新

如果你觉得这些内容对你有帮助,可以添加V获取:vip1024c (备注Python)

做了那么多年开发,自学了很多门编程语言,我很明白学习资源对于学一门新语言的重要性,这些年也收藏了不少的Python干货,对我来说这些东西确实已经用不到了,但对于准备自学Python的人来说,或许它就是一个宝藏,可以给你省去很多的时间和精力。

别在网上瞎学了,我最近也做了一些资源的更新,只要你是我的粉丝,这期福利你都可拿走。

我先来介绍一下这些东西怎么用,文末抱走。

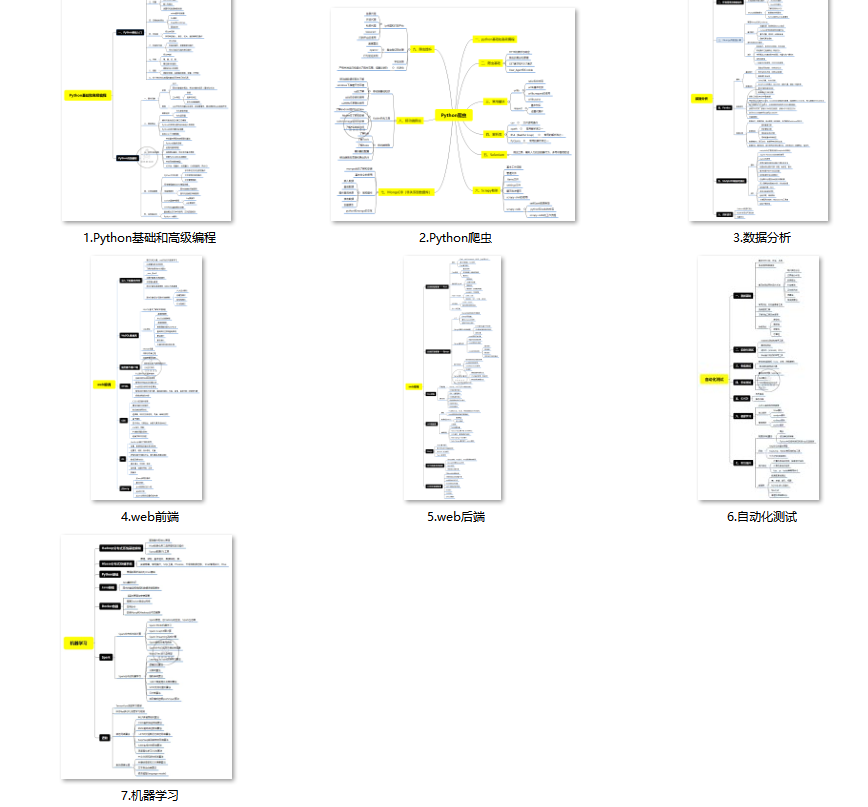

(1)Python所有方向的学习路线(新版)

这是我花了几天的时间去把Python所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

最近我才对这些路线做了一下新的更新,知识体系更全面了。

(2)Python学习视频

包含了Python入门、爬虫、数据分析和web开发的学习视频,总共100多个,虽然没有那么全面,但是对于入门来说是没问题的,学完这些之后,你可以按照我上面的学习路线去网上找其他的知识资源进行进阶。

(3)100多个练手项目

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了,只是里面的项目比较多,水平也是参差不齐,大家可以挑自己能做的项目去练练。

(4)200多本电子书

这些年我也收藏了很多电子书,大概200多本,有时候带实体书不方便的话,我就会去打开电子书看看,书籍可不一定比视频教程差,尤其是权威的技术书籍。

基本上主流的和经典的都有,这里我就不放图了,版权问题,个人看看是没有问题的。

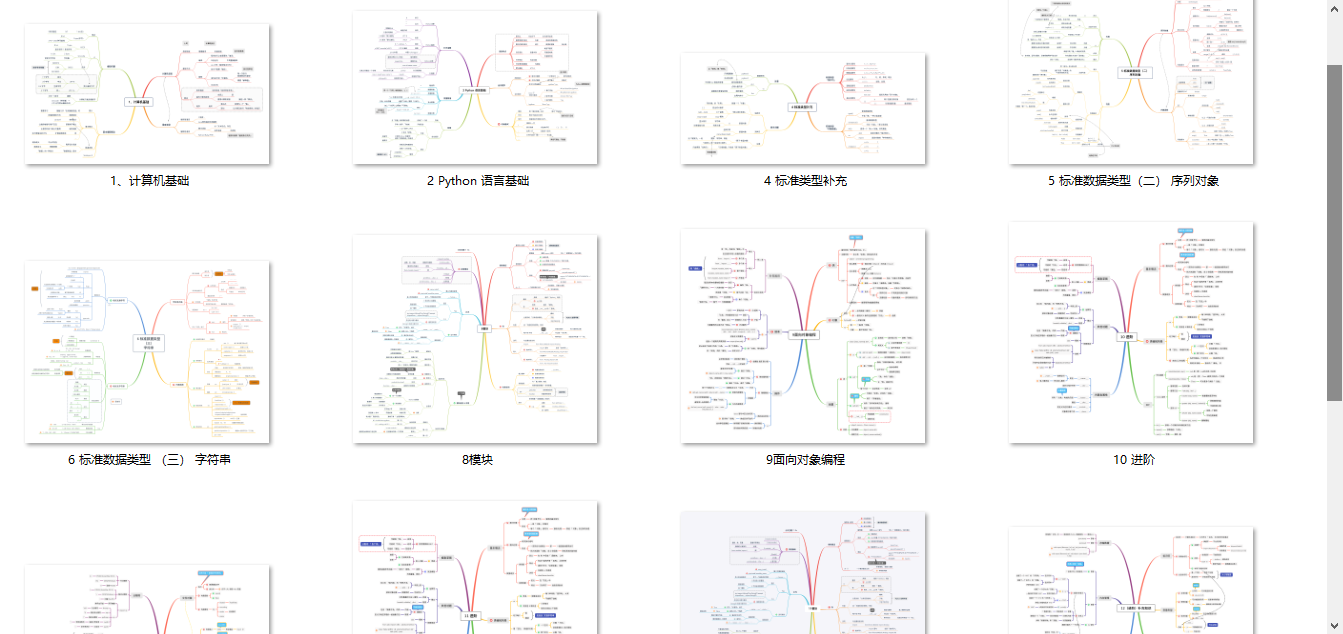

(5)Python知识点汇总

知识点汇总有点像学习路线,但与学习路线不同的点就在于,知识点汇总更为细致,里面包含了对具体知识点的简单说明,而我们的学习路线则更为抽象和简单,只是为了方便大家只是某个领域你应该学习哪些技术栈。

(6)其他资料

还有其他的一些东西,比如说我自己出的Python入门图文类教程,没有电脑的时候用手机也可以学习知识,学会了理论之后再去敲代码实践验证,还有Python中文版的库资料、MySQL和HTML标签大全等等,这些都是可以送给粉丝们的东西。

这些都不是什么非常值钱的东西,但对于没有资源或者资源不是很好的学习者来说确实很不错,你要是用得到的话都可以直接抱走,关注过我的人都知道,这些都是可以拿到的。

一个人可以走的很快,但一群人才能走的更远。不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎扫码加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

有其他的一些东西,比如说我自己出的Python入门图文类教程,没有电脑的时候用手机也可以学习知识,学会了理论之后再去敲代码实践验证,还有Python中文版的库资料、MySQL和HTML标签大全等等,这些都是可以送给粉丝们的东西。

这些都不是什么非常值钱的东西,但对于没有资源或者资源不是很好的学习者来说确实很不错,你要是用得到的话都可以直接抱走,关注过我的人都知道,这些都是可以拿到的。

一个人可以走的很快,但一群人才能走的更远。不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎扫码加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

[外链图片转存中…(img-kkTENuZi-1712936595543)]

1098

1098

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?