论文相关信息

- 会议:ICLR

- 时间:2018.12

- 论文地址:https://arxiv.org/pdf/1711.04043.pdf

- 论文代码:https://github.com/vgsatorras/few-shot-gnn

- 数据集:Omniglot、Mini-ImageNet

- 参考:

https://blog.csdn.net/StreamRock/article/details/102808091

https://gaoyi.blog.csdn.net/article/details/123594901

https://blog.csdn.net/qq_41180996/article/details/109351263

https://www.zdaiot.com/DeepLearningApplications/Few-shot%20Learning/Fewshot%20learning%20with%20graph%20neural%20networks/

https://zhuanlan.zhihu.com/p/67745489

Abstract

受到神经网络消息传递算法的启发,提出了一个图神经网络结构。

1 INTRODUCTION

- 优化技术的改进,有监督的端到端学习在计算机视角、语音、和机器翻译任务中取得了很大成功,但是这种学习设置没有涵盖许多方面。

- 比如:从很少的样本中学习的能力,也就是小样本学习任务中,这篇文章《Human-level concept learning through probabilistic program induction》受到人类学习的启发,提出了一种新的监督学习机制(也称“元学习”),利用了相似任务分布的方法,而不是依靠正则化来弥补数据的缺乏,输入输出对不是图像样本和标签给出,是由图像样本和标签的相似性构成。

- 这些文章*《Siamese neural networks for one-shot image recognition》《Matching networks for one shot learning》《Meta-learning with temporal convolutions》《Prototypical networks for few-shot learning》* 都用到了元学习的方法。 本质上,这些工作学习一种上下文的、特定于任务的相似性度量,该度量首先使用CNN嵌入输入图像,然后学习如何组合集合中的嵌入图像,以向目标图像传播标签信息。

- 《Matching networks for one shot learning》 将小样本学习问题转化为一个监督分类任务,将支持集的图像映射到期望的标签中,并开发了一个端到端的架构,通过注意力机制接受这些支持集作为输入。 在本文中,我们建立在这条工作线上,并论证了该任务自然地表示为图上的有监督插值问题,其中节点与集合中的图像相关联,边缘由可训练的相似性核给出。 受到这两篇文章《Community detection with graph neural networks》《Neural message passing for quantum chemistry》启发,我们提出了一个简单的基于图的小样本学习模型,该模型实现了任务驱动的消息传递算法。 得到的体系结构是端到端训练的,该模型捕获了任务的不变性,例如输入集合中的排列,并在简单性、通用性、性能和示例复杂性之间提供了良好的折衷。

- 该模型不仅可用于小样本学习,还可以用于半监督学习和主动学习的任务中。

- 贡献

1.我们将小样本学习转化为一个有监督的消息传递任务,并使用图神经网络进行端到端的训练。

2.我们用较少的参数匹配Omniglot和Mini-ImageNet任务上的最先进性能。

3.在半监督学习和主动学习两种情况下对模型进行了扩展。

2 RELATED WORK

小样本学习

- *《One-shot learning of object categories》*2006 最早提出一个样本的学习,这篇文章假设当只有一个或几个标签可用时,当前学习的类可以帮助预测新的类。

- *《Human-level concept learning through probabilistic program induction》*2015年提出了一个层次贝叶斯模型,该模型在小样本学习字母表重构任务中达到了人类水平的错误。

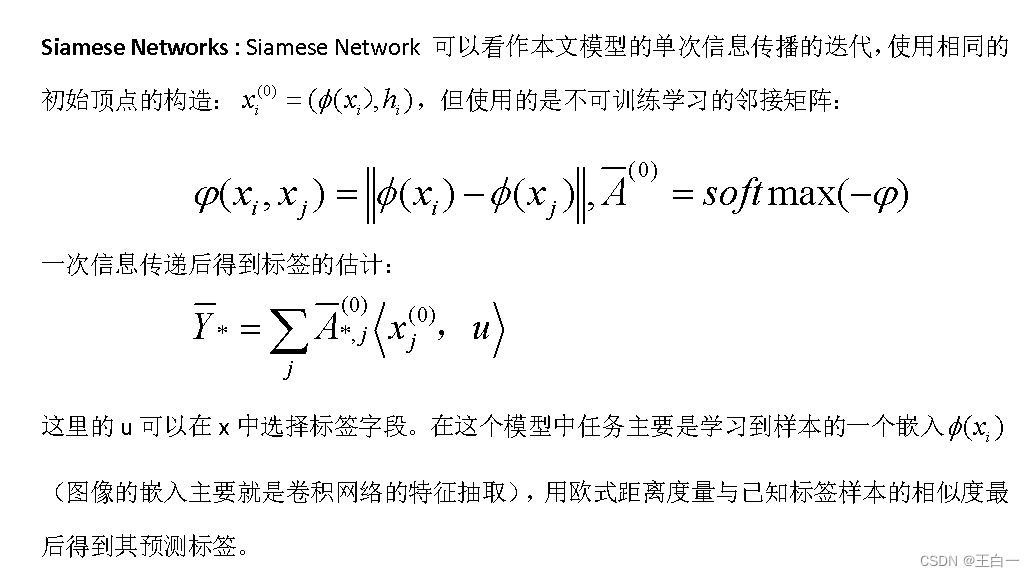

- *《Siamese neural networks for one-shot image recognition》*2015年提出了一种基于Siamese网络计算样本间成对距离的Deeplearning模型,然后利用该学习距离通过k-最近邻分类解决一次搜索问题。

- *《Matching networks for one shot learning》*2016年提出了一种使用余弦距离的端到端可训练的k-近邻,并引入了一种使用注意LSTM模型的上下文机制,该模型在计算样本之间的成对距离时考虑了子集T的所有样本。

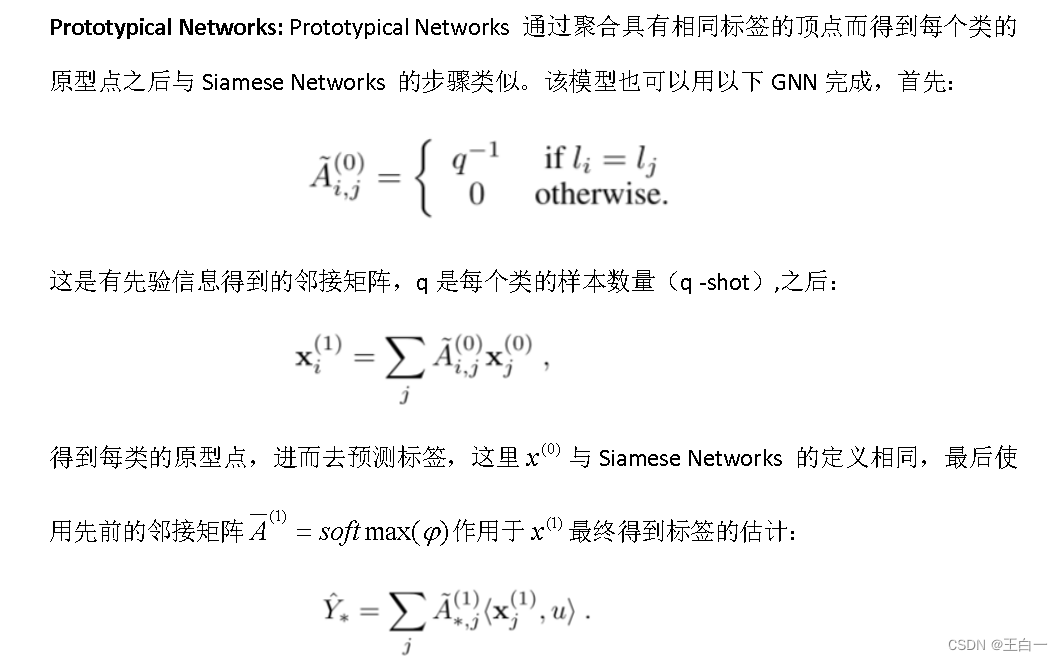

- *《Prototypical networks for few-shot learning》*2017年这篇文章扩展了《Matching networks for one shot learning》工作,通过使用欧几里得距离而不是余弦(提供了显著的改进),他们还为小样本学习场景构建了每个类的原型表示 。

- *《Generative adversarial residual pairwise networks for one shot learning》*2017训练一个深度残差网络和一个生成模型来逼近样本之间的成对距离。

- *《Optimization as a model for few-shot learning》*2016年介绍了一种元学习方法,其中LSTM对给定集更新分类器的权值。

- *《Meta networks》*提出了一种跨任务学习元知识的元学习体系结构,并通过快速参数化改变其归纳偏差

- *《Model-agnostic meta-learning for fast adaptation of deep networks》*2017年是使用一个基于梯度下降的模型不可知元学习器,目标是训练一个分类模型,使给定一个新任务,少量的梯度步骤和少量的数据将足以泛化。

- *《Meta-learning with temporal convolutions》*2017年使用基于扩展卷积的深度递归网络时域卷积,该方法还利用子集T中的上下文信息,提供了很好的结果。

图卷积

- *《A new model for learning in graph domains》*2005年首次提出GNN,《The graph neural network model》2009年作为一种可训练的经常性信息传递,其固定点可以有区别地调整。

- *《Gated graph sequence neural networks》*2015年《Learning multiagent communication with backpropagation》2016年 这两篇文章通过解除递归层权重来放松模型,并通过门控机制提出了几种非线性更新。 图神经网络实际上是卷积网络对非欧几里德图的自然推广。

- *《Spectral networks and locally connected networks on graphs》2013年《Deep convolutional networks on graph-structured data》2015年 提出学习拉普拉斯图的光滑谱乘子,尽管计算代价很高。

-《Convolutional neural networks on graphs with fast localized spectral filtering》*2016年《Semi-supervised classification with graph convolutional networks》2016年这两篇文章通过学习图的拉普拉斯多项式,解决了计算瓶颈,从而避免了特征向量的计算,完成了与GNNS的连接。Semi-supervised classification with graph convolutional networks 这篇文章第一个提出将GNNS用于半监督分类问题。 - 《Geometric deep learning: going beyond euclidean data》 2016年《A compositional object-based approach to learning physical dynamics》2016年 这两篇文章开发学习成对粒子相互作用的图相互作用网络,并将其应用于离散粒子物理动力学。

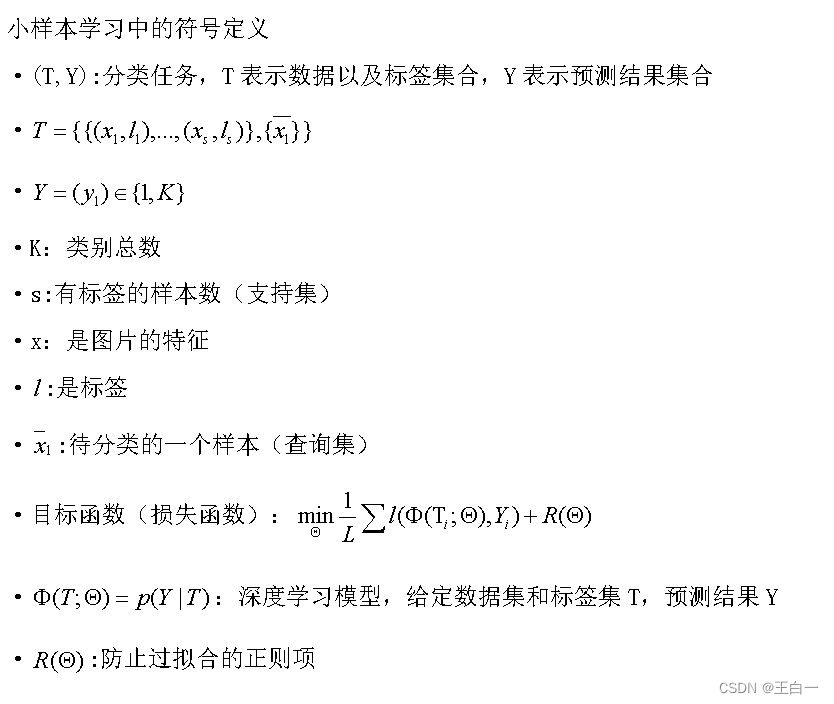

3 PROBLEM SET-UP

我们首先描述了一般的设置和符号,然后详细说明了小样本学习、半监督学习和主动学习的情况。

4 MODEL

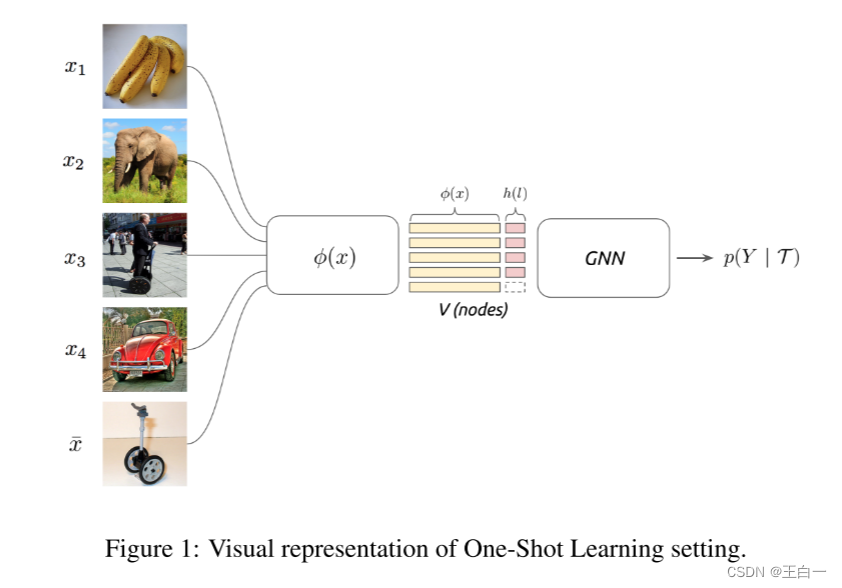

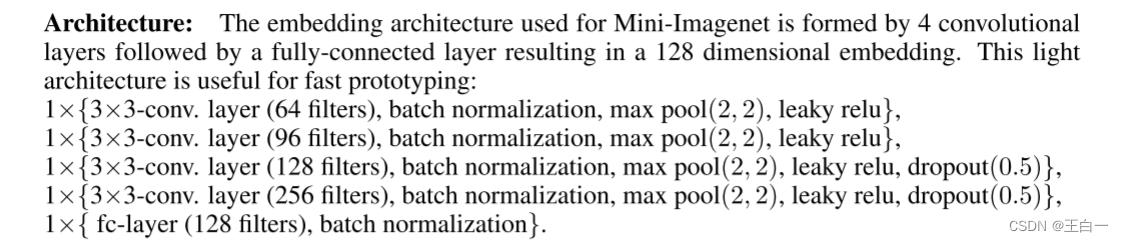

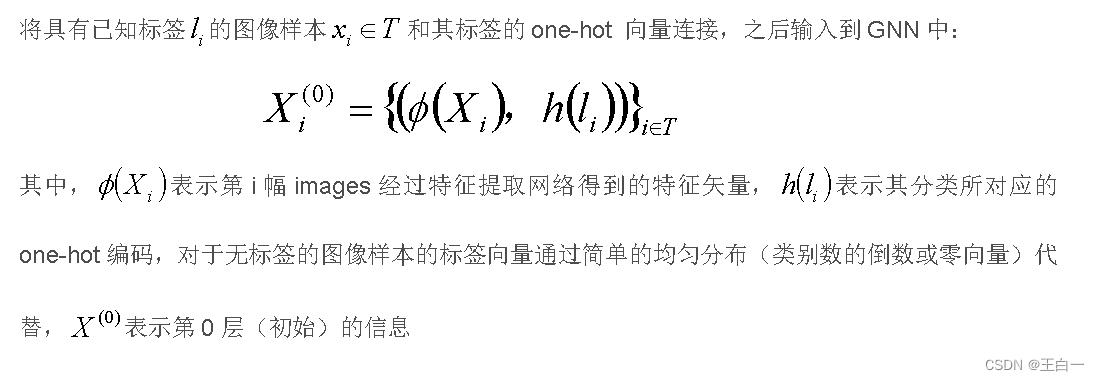

4.1 SET AND GRAPH INPUT REPRESENTATIONS

输入T包含一个图像集合,有标签的和无标签的。 小样本学习的目标是从有标签的支持样本向没有标签的查询图像传播标签信息。 信息的这种传播可以被形式化为在由输入图像和标签确定的图形模型上的后验推断。

《The graph neural network model》2009 《Convolutional networks on graphs for learning molecular fingerprints》2015 《Neural message passing for quantum chemistry》2017 这几篇文章使用定义在图上的神经网络的消息传递进行后验推断 。我们将T和一个全连通图G=(V,E)其中Va属于V对应于T中存在的图像(有标签和无标签)。在本文中,该设置没有指定两张图片固定的相似性,而是用一种类似于《Neural message passing for quantum chemistry》这篇文章的方法,比如:a siamese neural architecture 相似性度量是用参数模型以区分的方式学习的。这个框架与 《Matching networks for one shot learning》集合表示密切相关,但我们接下来详细描述的图神经网络形式扩展了推理机制。

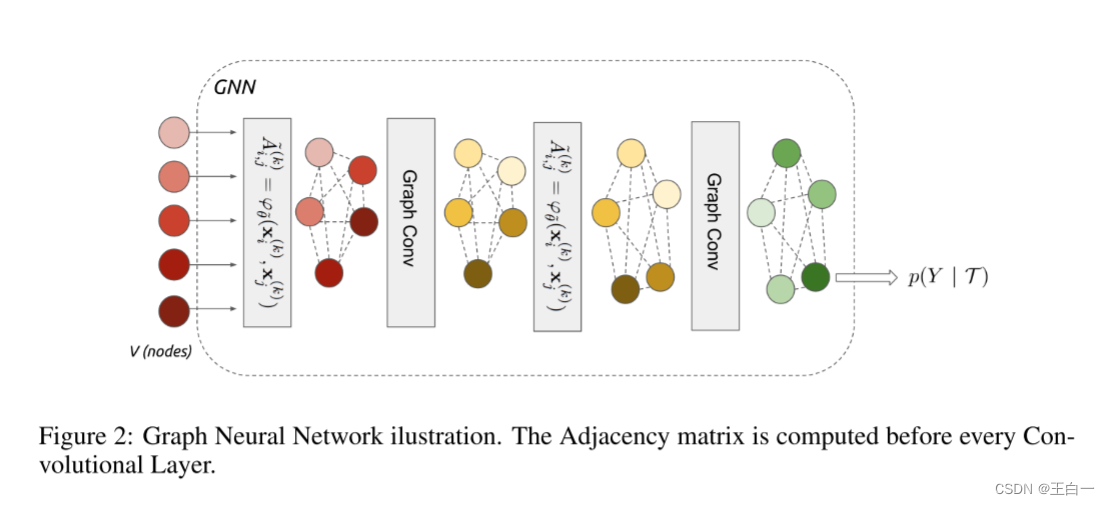

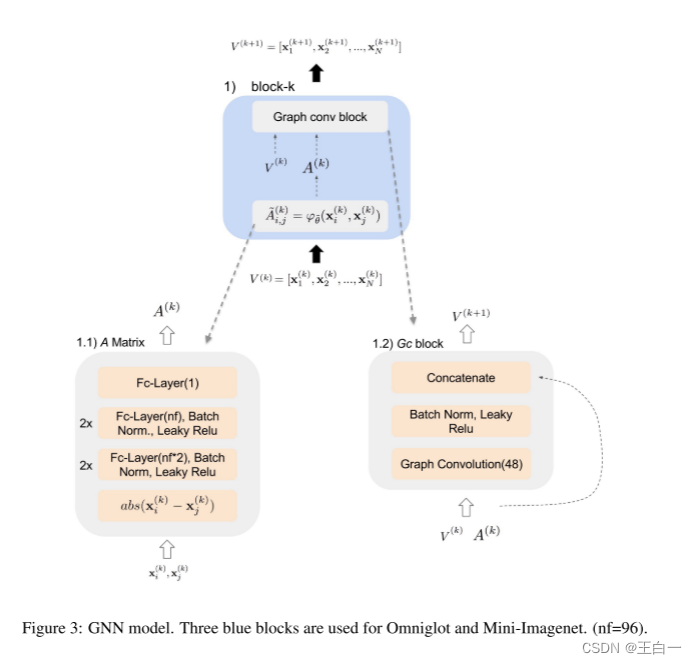

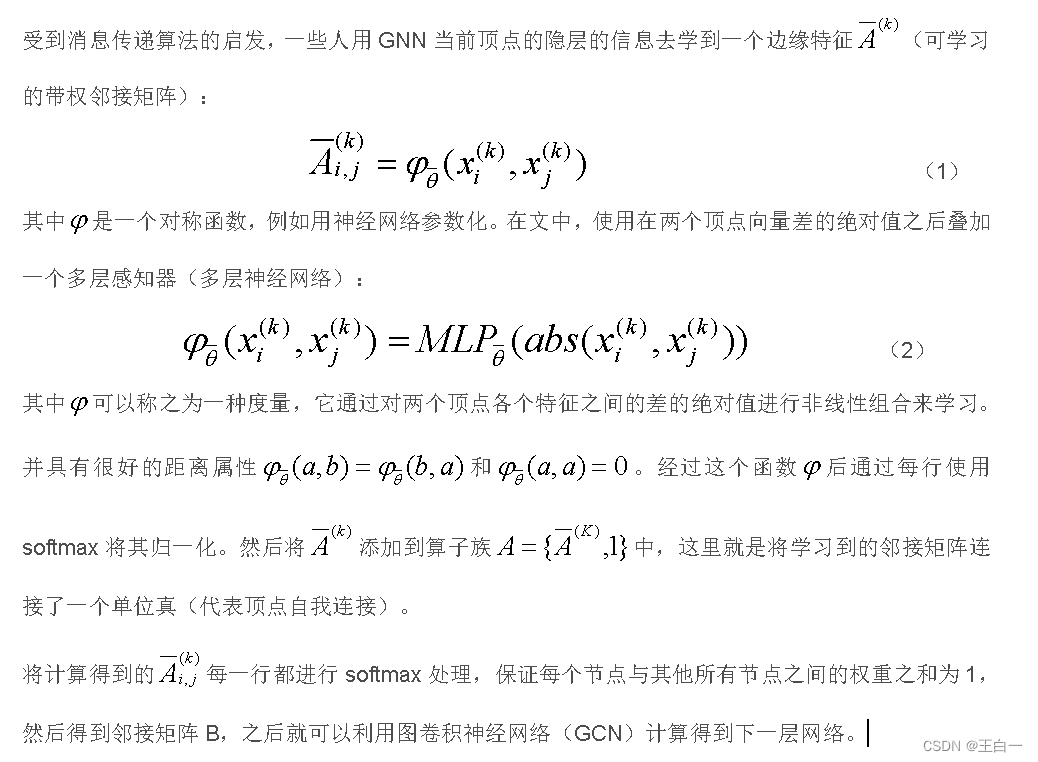

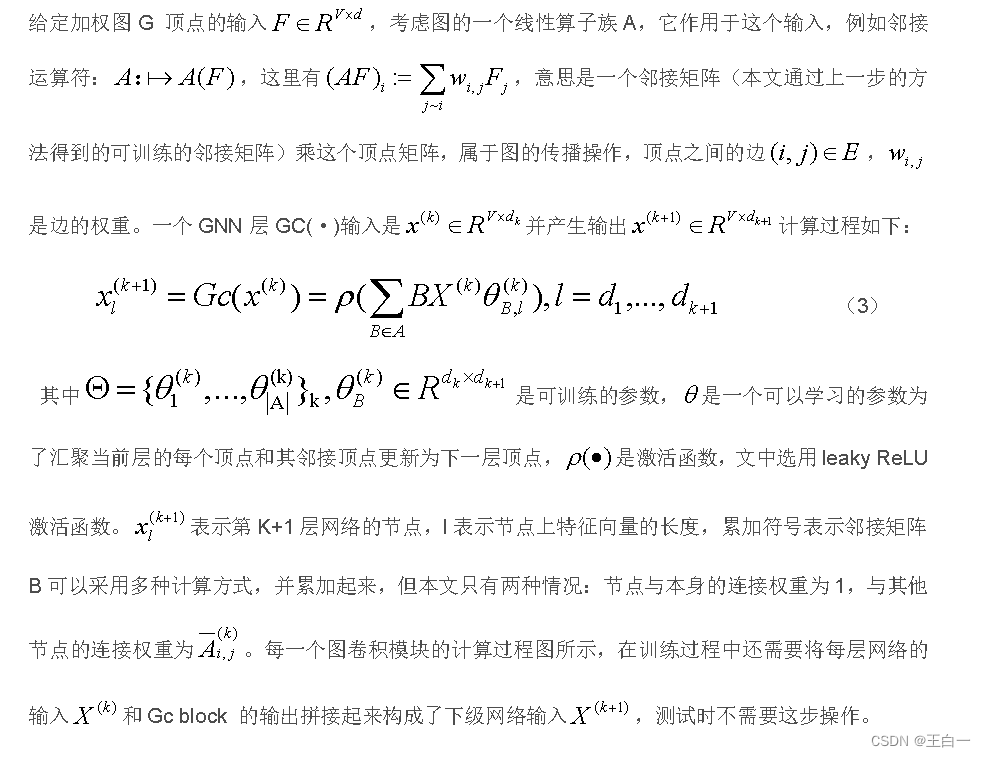

4.2 GRAPH NEURAL NETWORKS

《A new model for learning in graph domains》2005《The graph neural network model》2009介绍了图神经网络,《Gated graph sequence neural networks》2015进一步简化图神经网络

- 整体架构

核心思想:将有标签的样本信息传递到无标签的查询样本上

对于 5 way 1 shot 取一个查询样本 , 每一个batch中,共有6张图片

首先将支持集5张图片和查询集1张图片输入到卷积神经网络Φ(x)中提取特征,支持集中的标签经过one-hot 编码,查询集样本的标签设置为1/5或0;

然后,将特征向量和表示标签的向量拼接起来,作为GNN的输入节点;

最后,经过GNN得到预测结果

- 图神经网络

- 初始顶点的构造

- 邻接矩阵的构造

- 整体图模型

4.3 RELATIONSHIP WITH EXISTING MODELS

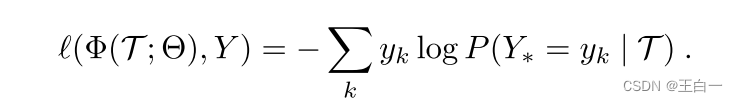

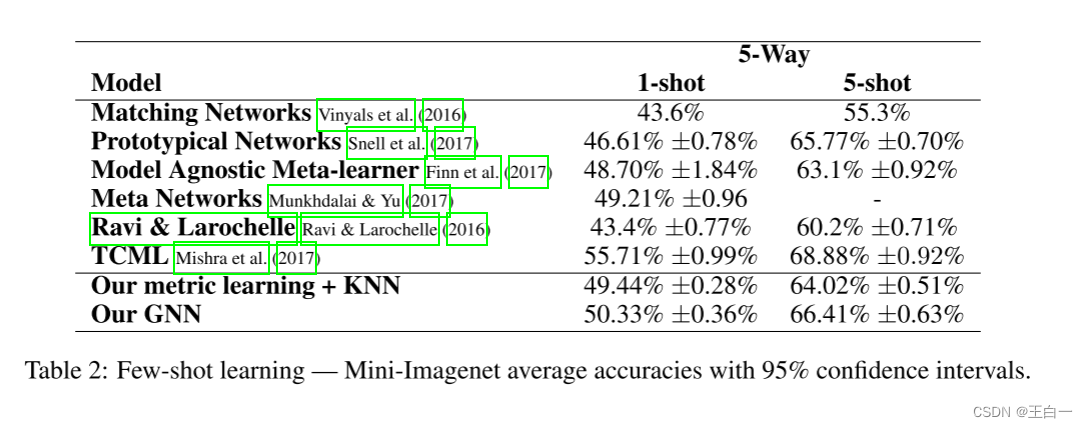

5 实验

数据集: Omniglot miniImageNet

损失函数:交叉熵

- 实验结果

619

619

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?