一、本文创新点

PointNet有许多令人满意的特性:它直接处理原始点,而不需要像体素化或投影这样的有损操作,并且它随输入点的数量线性缩放。但是,原来的PointNet配方不能用于开箱即用的3D回归。这里我们描述我们对PointNet所做的两个重要改变。

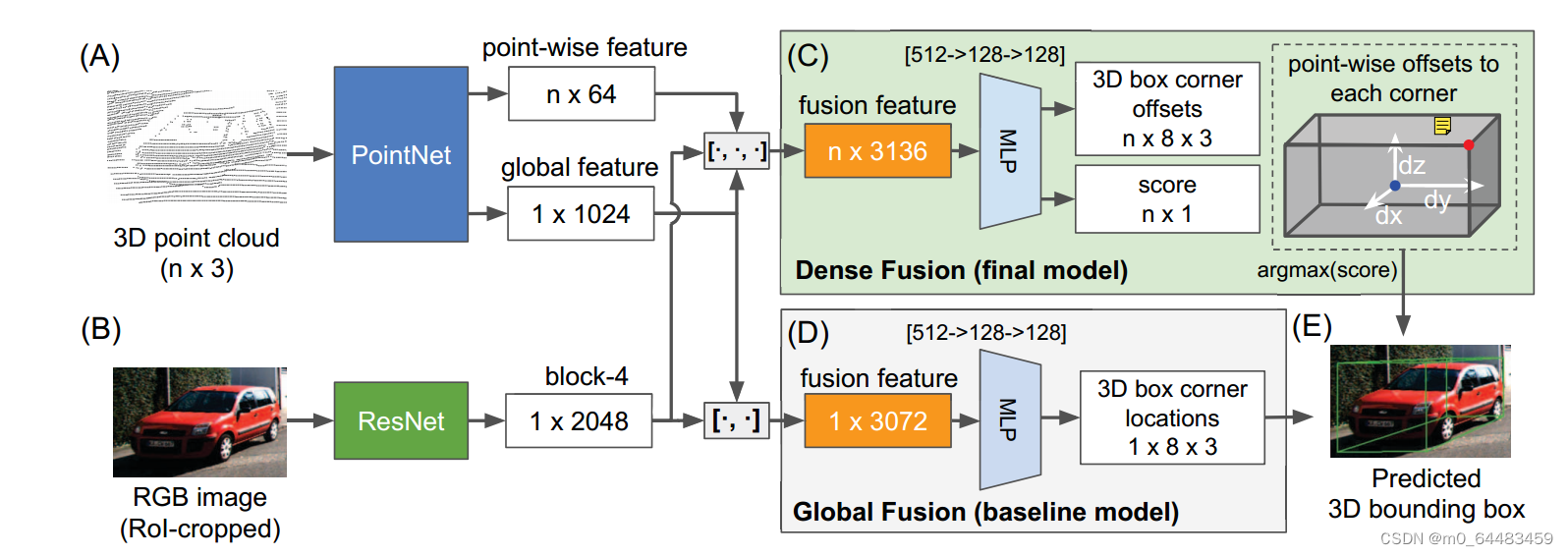

密集PointFusion架构的概述。PointFusion有两个特征提取器:处理原始点云数据的PointNet变体(a)和从输入图像中提取视觉特征的CNN (B)。我们提出了两种融合网络公式:直接回归框角位置的香草全局架构(D),以及预测8个角相对于输入点的每个角的空间偏移的新颖密集架构,如(C)所示:对于每个输入点,网络预测从一个角落(红点)到输入点(蓝点)的空间偏移量(白色箭头),并选择得分最高的预测作为最终预测(E)。

1.改进pointNet处理点云数据

- 去除批处理归一化(no BatchNorm):批处理归一化是可以用在深度神经网络每一层输入的一个训练技巧,它可以对输入数据求均值求方差做归一化,使得输入数据具有较小的变化范围,加快模型的训练速度,同时减轻梯度消失或梯度爆炸的问题。 但是BN阻碍了三维bbox的估计性能,对于三维回归任务,位置的绝对数值是有帮助的。

- Input normalization:PointNet应用空间转换网络(STN)来规范化输入空间。然而,STN不能完全纠正这些偏差。我们使用已知的相机几何来计算规范旋转矩阵Rc。(不懂)

2.两种融合网络

- global fusion network:提取点云和图像的全局特征,进行拼接后放入MLP处理,直接回归出3D预测框8个角的坐标

- dense fusion network:融合点云和图像的全局特征的基础上,再加上每个3D点的特征得到fusion feature。将其放入MLP处理,对于每一个3D点会输出得到一个预测的边界框和该点的分数。在测试时,选择得分高的作为预测结果。

- 使用3D点作为空间锚点并得到预测的3D框,网络自动学习选择最优的预测,可以使得预测和场景的空间范围无关,比如目标物体离你1m或者100m是一样的。

3.密集融合预测得分

- 监督得分函数(Supervised scoring):限制得分高的点在target bbox内

- 无监督得分函数(Unsupervised scoring):让网络选择一个点进行最优预测,即便位于target bbox外的点,只要能得到好的结果,也会给它高的置信度

证明,无监督得分函数更好

二、实验

1.数据集

- KITTI:激光雷达相机拍摄的室外驾驶数据集,包括行人、骑自行车的人、汽车

- SUN-RGBD:侧重于室内环境,使用RGB-D相机收集数据

三、总结

本文提出点云和图像融合的新方法来估计3D目标框,旨在提出一种通用的适用于室内和室外驾驶环境的模型。因此对提取点云数据特征的PointNet做出改进,去除BatchNorm以及输入归一化。后又提出将3D点作为空间锚点,经过dense fusion network处理得到fusion feature,输出每个点的得分以及它的预测3D框。在测试时,选择得分高的预测作为最终预测。

本文介绍了对PointNet进行改进以适应3D回归任务,提出PointFusion架构,结合点云和图像数据,通过两种融合网络(DenseFusion)进行3D目标框预测。实验在KITTI和SUN-RGBD数据集上验证,证明了无监督得分函数的优势。

本文介绍了对PointNet进行改进以适应3D回归任务,提出PointFusion架构,结合点云和图像数据,通过两种融合网络(DenseFusion)进行3D目标框预测。实验在KITTI和SUN-RGBD数据集上验证,证明了无监督得分函数的优势。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?