💡💡💡本专栏所有程序均经过测试,可成功执行💡💡💡

在标准卷积神经网络 (CNN) 中,每层人工神经元的感受野被设计为具有相同的大小。在神经科学界众所周知,视觉皮层神经元的感受野大小受刺激调节,但在构建 CNN 时很少考虑这一点。然而动态的选择机制,允许每个神经元基于多种输入信息尺度自适应地调整其感受野大小。在本文中,给大家带来的教程是将原来的网络中C3模块替换为SKConv,或者单纯的添加SKconv。文章在介绍主要的原理后,将手把手教学如何进行模块的代码添加和修改,并将修改后的完整代码放在文章的最后,方便大家一键运行,小白也可轻松上手实践。

目录

1.原理

官方论文:Selective Kernel Networks——点击即可跳转

官方代码:代码仓库地址——点击即可跳转

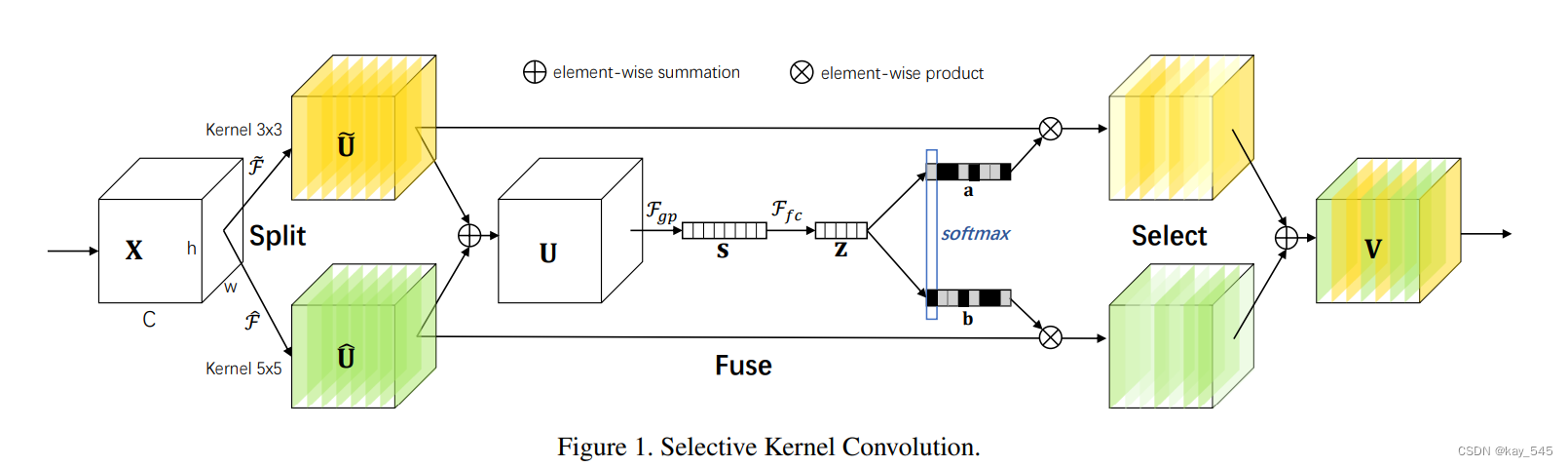

SKconv是一种用于图像处理中的卷积神经网络(CNN)的卷积层变体。SKconv的全称是Selective Kernel Convolution,它引入了一种选择性内核机制,可以动态地选择不同尺寸的卷积核来捕捉不同尺度的特征。

SKconv的核心思想是引入一个注意力机制,允许网络在每个位置上选择性地聚焦于局部和全局特征之间的权衡。为了实现这一点,SKconv引入了三个部分:SK模块(Selective Kernel Module)、SK卷积操作和SK融合。

-

SK模块:SK模块包括一个全局池化操作,用于捕捉全局信息,并通过一系列操作将全局信息与局部信息进行融合,以便在每个位置上动态选择适当的卷积核尺寸。

-

SK卷积操作:在SKconv中,卷积核的选择不再是固定的,而是基于SK模块的输出动态确定的。这意味着在每个位置上,网络可以选择不同大小的卷积核来捕获局部和全局特征。

-

SK融合:SKconv使用一种有效的方式将选择的不同尺寸的卷积核的输出进行融合,以产生最终的特征图。

SKconv的引入旨在提高CNN模型对不同尺度特征的表达能力,从而增强模型对于图像的感知能力和识别性能。通过动态地选择卷积核尺寸,SKconv可以更好地适应不同尺度的目标,提高了模型的泛化能力和鲁棒性。因此,SKconv已经被广泛应用于图像分类、目标检测和语义分割等任务中,并取得了较好的效果。

2. SKConv代码实现

2.1 将SKConv代码添加到YOLOv5中

关键步骤一: 将下面代码粘贴到/projects/yolov5-6.1/models/common.py文件中

class SKConv(nn.Module):

def __init__(self, features, WH, M=2, G=1, r=2, stride=1, L=32):

""" Constructor

Args:

features: input channel dimensionality.

WH: input spatial dimensionality, used for GAP kernel size.

M: the number of branchs.

G: num of convolution groups.

r: the radio for compute d, the length of z.

stride: stride, default 1.

L: the minimum dim of the vector z in paper, default 32.

"""

super(SKConv, self).__init__()

d = max(int(features / r), L)

self.M = M

self.features = features

self.convs = nn.ModuleList([])

for i in range(M):

self.convs.append(

nn.Sequential(

nn.Conv2d(features,

features,

kernel_size=3 + i * 2,

stride=stride,

padding=1 + i,

groups=G), nn.BatchNorm2d(features),

nn.ReLU(inplace=False)))

# self.gap = nn.AvgPool2d(int(WH/stride))

# print("D:", d)

self.fc = nn.Linear(features, d)

self.fcs = nn.ModuleList([])

for i in range(M):

self.fcs.append(nn.Linear(d, features))

self.softmax = nn.Softmax(dim=1)

def forward(self, x):

for i, conv in enumerate(self.convs):

fea = conv(x).unsqueeze_(dim=1)

if i == 0:

feas = fea

else:

feas = torch.cat([feas, fea], dim=1)

fea_U = torch.sum(feas, dim=1)

# fea_s = self.gap(fea_U).squeeze_()

fea_s = fea_U.mean(-1).mean(-1)

fea_z = self.fc(fea_s)

for i, fc in enumerate(self.fcs):

# print(i, fea_z.shape)

vector = fc(fea_z).unsqueeze_(dim=1)

# print(i, vector.shape)

if i == 0:

attention_vectors = vector

else:

attention_vectors = torch.cat([attention_vectors, vector],

dim=1)

attention_vectors = self.softmax(attention_vectors)

attention_vectors = attention_vectors.unsqueeze(-1).unsqueeze(-1)

fea_v = (feas * attention_vectors).sum(dim=1)

return fea_vSKconv的关键流程步骤主要包括SK模块的构建、SK卷积操作和SK融合。

-

SK模块的构建:

-

首先,对于输入特征图,通过一个全局池化操作(通常是全局平均池化),得到一个全局特征向量。

-

接着,通过几个全连接层或者卷积层,将全局特征向量映射到一个较低维度的表示,通常使用非线性激活函数来引入非线性。

-

在SK模块中,通常还会引入一些规范化操作,如归一化或者正则化,以便更好地控制特征的范围和稳定性。

-

最后,使用softmax函数或者sigmoid函数来生成一组权重,这些权重代表了每个位置上不同尺度卷积核的选择概率。

-

-

SK卷积操作:

-

在SK卷积操作中,根据SK模块生成的权重,动态地选择不同尺寸的卷积核来对输入特征图进行卷积操作。

-

对于每个位置,根据SK模块生成的权重,选择相应尺寸的卷积核,并在该位置上进行卷积操作。

-

通常,SK卷积操作可以在单个卷积层中实现,但也可以通过串联多个卷积层来实现。

-

-

SK融合:

-

在SK融合阶段,将不同尺寸卷积核的输出进行融合,以产生最终的特征图。

-

通常,可以采用加权求和或者拼接的方式来融合不同尺寸卷积核的输出。

-

在加权求和的情况下,使用SK模块生成的权重来对不同尺寸卷积核的输出进行加权求和。

-

在拼接的情况下,将不同尺寸卷积核的输出在通道维度上拼接起来,形成最终的特征图。

-

这些步骤的关键是引入了一个选择性的机制,使得网络可以动态地选择不同尺寸的卷积核,从而更好地捕获局部和全局特征。这样的设计使得SKconv在处理不同尺度的目标时更加灵活和有效。

2.2 新增yaml文件

关键步骤二:在下/projects/yolov5-6.1/models下新建文件 yolov5_skcov.yaml并将下面代码复制进去

*注 这个yaml文件是直接添加的SKconv,替换C3的可以自己摸索,欢迎在评论区讨论

# YOLOv5 🚀 by Ultralytics, GPL-3.0 license

# Parameters

nc: 80 # number of classes

depth_multiple: 1.0 # model depth multiple

width_multiple: 1.0 # layer channel multiple

anchors:

- [10,13, 16,30, 33,23] # P3/8

- [30,61, 62,45, 59,119] # P4/16

- [116,90, 156,198, 373,326] # P5/32

# YOLOv5 v6.0 backbone

backbone:

# [from, number, module, args]

[[-1, 1, Conv, [64, 6, 2, 2]], # 0-P1/2

[-1, 1, Conv, [128, 3, 2]], # 1-P2/4

[-1, 3, C3, [128]],

[-1, 1, Conv, [256, 3, 2]], # 3-P3/8

[-1, 6, C3, [256]],

[-1, 1, Conv, [512, 3, 2]], # 5-P4/16

[-1, 9, C3, [512]],

[-1, 1, Conv, [1024, 3, 2]], # 7-P5/32

[-1, 3, C3, [1024]],

[-1, 1, SKConv, [1024]], # SKConv

[-1, 1, SPPF, [1024, 5]], # 9

]

# YOLOv5 v6.0 head

head:

[[-1, 1, Conv, [512, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 6], 1, Concat, [1]], # cat backbone P4

[-1, 3, C3, [512, False]], # 13

[-1, 1, Conv, [256, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 4], 1, Concat, [1]], # cat backbone P3

[-1, 3, C3, [256, False]], # 17 (P3/8-small)

[-1, 1, Conv, [256, 3, 2]],

[[-1, 15], 1, Concat, [1]], # cat head P4

[-1, 3, C3, [512, False]], # 20 (P4/16-medium)

[-1, 1, Conv, [512, 3, 2]],

[[-1, 11], 1, Concat, [1]], # cat head P5

[-1, 3, C3, [1024, False]], # 23 (P5/32-large)

[[18, 21, 24], 1, Detect, [nc, anchors]], # Detect(P3, P4, P5)

]温馨提示:本文只是对yolov5l基础上添加swin模块,如果要对yolov8n/l/m/x进行添加则只需要指定对应的depth_multiple 和 width_multiple。

# YOLOv5n

depth_multiple: 0.33 # model depth multiple

width_multiple: 0.25 # layer channel multiple

# YOLOv5s

depth_multiple: 0.33 # model depth multiple

width_multiple: 0.50 # layer channel multiple

# YOLOv5l

depth_multiple: 1.0 # model depth multiple

width_multiple: 1.0 # layer channel multiple

# YOLOv5m

depth_multiple: 0.67 # model depth multiple

width_multiple: 0.75 # layer channel multiple

# YOLOv5x

depth_multiple: 1.33 # model depth multiple

width_multiple: 1.25 # layer channel multiple2.3 注册模块

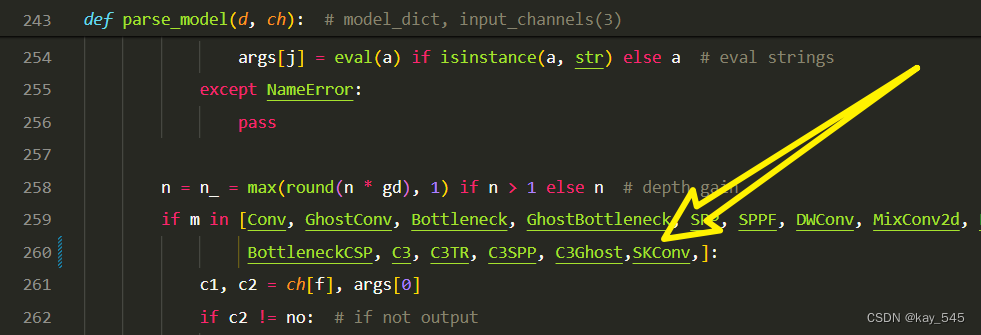

关键步骤三:在yolo.py中注册, 大概在260行左右添加 ‘SKConv’

2.4 执行程序

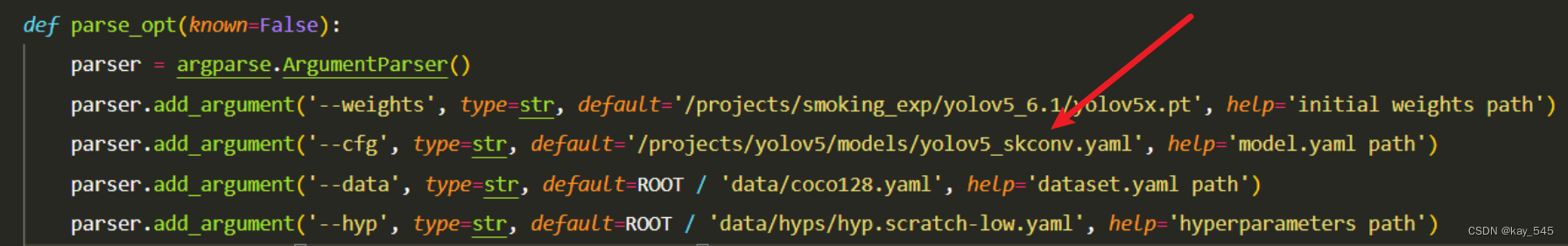

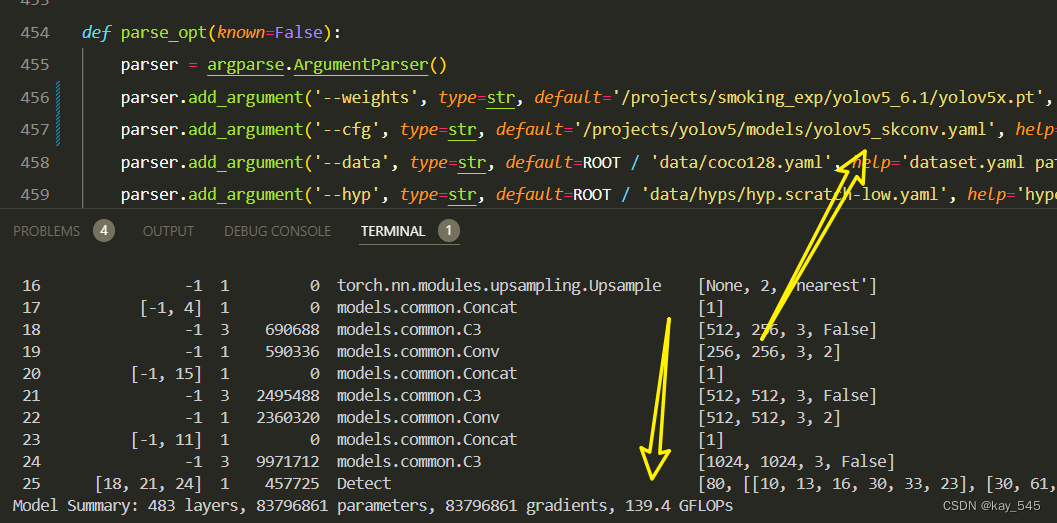

在train.py中,将cfg的参数路径设置为yolov5_skconv.yaml的路径

建议大家写绝对路径,确保一定能找到

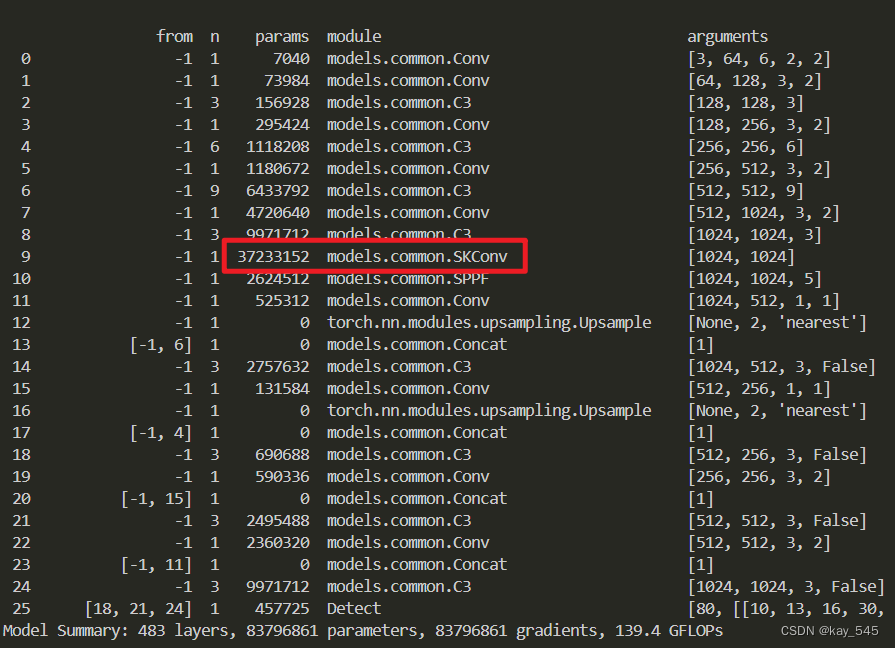

🚀运行程序,如果出现下面的内容则说明添加成功🚀

3. 完整代码分享

https://pan.baidu.com/s/1E2yLbuZtziOT1Xstga8J0g?pwd=9rba提取码: 9rba

4.GFLOPs

关于GFLOPs的计算方式可以查看:百面算法工程师 | 卷积基础知识——Convolution

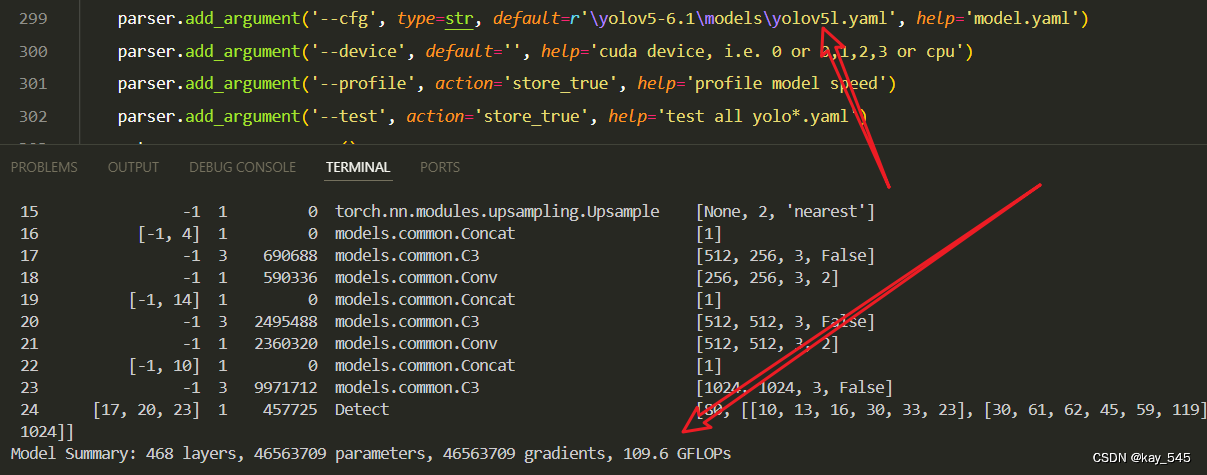

未改进的GFLOPs

改进后的GFLOPs

5. 进阶

你能在不同的位置添加添加SKconv或者替换C3模块吗?这非常有趣,快去试试吧

6. 总结

SKconv是一种图像处理中的卷积神经网络卷积层变体,其核心思想是引入选择性内核机制,允许网络动态地选择不同尺寸的卷积核,以捕获局部和全局特征之间的权衡。其关键流程包括构建SK模块、SK卷积操作和SK融合,通过全局池化、全连接层和softmax函数生成不同尺寸卷积核的选择权重,然后根据这些权重动态选择卷积核进行卷积操作,并最终通过加权求和或拼接融合不同尺寸卷积核的输出。SKconv提高了CNN模型对不同尺度特征的表达能力,增强了模型对图像的感知能力和识别性能,适用于图像分类、目标检测和语义分割等任务。

2008

2008

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?