Abstract

联邦学习是一种新兴的分布式学习技术,由于其隐私保护的特性,允许网络中的多个客户端设备在不直接暴露客户端数据的情况下联合训练机器学习模型。然而,研究发现使用联邦学习训练的模型通常比标准的集中学习模式下训练的模型性能更差,尤其是当训练数据不平衡时。在联邦学习的背景下,数据不平衡可能发生在本地的一个客户端设备上,也可能发生在全局的多个设备上。不同类型数据不平衡的复杂性对联邦学习技术的发展提出了挑战,特别是考虑到同时缓解数据不平衡问题和保护数据隐私的需要。因此,在文献中,已经做了许多尝试来处理联邦学习中的类不平衡问题。

本文对这一领域的最新进展进行了详细的回顾:

1. 介绍了联邦学习中的各种类型的类不平衡。

2. 回顾了现有的估计类不平衡程度的方法,这些方法为了保护数据隐私,不需要知道实际的数据。

3. 讨论了FL中现有的处理类别不平衡的方法,并讨论了这些方法的优缺点。

4. 总结了常见的针对类别不平衡任务的评价指标.

5. 并指出了潜在的未来方向。

1. Introduce

机器学习( Machine Learning,ML )模型的性能高度依赖于其训练数据的数量和质量。ML模型的经典训练策略要求训练数据驻留在一个地方,这意味着在不同设备上收集的数据需要传输到一个集中的服务器,这带来了隐私、安全和处理风险。联邦学习( FL )已被确定为解决这些风险的有前途的技术。FL是一个分布式训练框架,它允许边缘设备(例如,客户端的笔记本电脑和移动电话)协作训练一个ML模型,而不需要将一个边缘设备上的本地数据暴露给其他设备或中央服务器。

一般而言,FL使用一组异构的边缘设备和一个中心服务器来协调学习过程。为了避免跨设备的数据传输,一个边缘设备采集的数据被保存在本地,并用于训练本地模型。边缘设备不直接传输数据,而是将训练好的模型传输到中心服务器,然后将其聚合成全局模型。FL的去中心化架构在模型训练中带来了一些挑战,包括通信成本、系统异构性和统计异构性。特别地,统计异构性是指在网络中的边缘设备上训练数据不是独立同分布(非IID )。由于优化算法通常假设训练数据是独立同分布(IID)的,研究表明,统计异构性可能会导致模型训练中收敛缓慢,有时甚至发散,以及非平凡的性能恶化。

在本文中,关注FL中一类特殊的统计异构性,即具有类不平衡的数据。类不平衡在文献中也被称为标签偏斜、类不平衡和数据不平衡。图1举例说明了类别不平衡对模型训练的对抗影响。文中使用MNIST数据集(用10个类)生成具有不同程度类别不平衡的数据集,然后使用这些数据集进行模型训练。

用Γ表示类不平衡的程度,即最大类和最小类的大小之比,其中Γ = 1表示平衡的类分布,Γ的值越大表示类不平衡越严重。

可以看出,当Γ = 1时,分类精度约为97 %。当类不平衡度在2 ~ 5之间时,分类精度下降到86 %,当类不平衡度在10 ~ 20之间时,分类精度进一步下降到83%。

ML方法在类别不平衡数据集上分类性能下降的原因主要有以下五个方面:

(1) 标准分类器的设计假设训练数据是平衡的;

(2) 分类过程由全局性能指标引导,如分类准确率,这会导致对多数类样本的偏见;

(3) 稀少的少数类样本可能被分类器当作噪声处理;

(4) 少数类样本可能与其他类样本重叠,而这些类的先验概率是相等的;

(5) 小析取项、缺乏密度、小样本和高特征维度使得少数类的学习更具挑战性。

在FL环境下,处理类不平衡问题更具有挑战性,主要有两个原因。首先,由于FL的去中心化特性,类不平衡可能发生在不同的层面,包括一个或少数几个客户端设备上的局部层面和跨多个客户端的全局层面的系统性不平衡问题。此外,客户机和服务器之间的类分布不匹配也可能导致FL的性能下降。数学上已经证明,训练数据中的类别不平衡会降低FL应用的分类性能。特别地,实验结果表明,发生在全局层面上的类不平衡会对全局模型的性能产生不利影响,而所有参与FL的客户端之间的类分布差异会降低全局模型的整体性能和延迟收敛。

其次,在FL系统中,保护用户隐私是首要的优先事项之一。因此,泄露客户数据,甚至仅仅是客户数据的类别分布,可能会导致用户机密信息泄露的潜在风险。因此,管理类不平衡变得更加困难,因为需要在无法获得关于训练数据中类不平衡严重程度的具体信息的情况下做出判断。因此,许多处理FL系统中类不平衡的方法遵循两个阶段的过程:(1)类分布估计;(2)解决FL中的类不平衡问题。

本文的其余部分组织如下:

第2节从总体上介绍了FL的定义,并讨论了FL中存在的各种类型的类不平衡。

第3节回顾了现有的估计FL中类分布的方法。

第4节回顾了解决FL中类不平衡问题的方法。

第5节总结了FL中分类模型的性能指标。

第6节讨论了挑战和未来方向。

第7节对本文进行了总结。

2. Preliminaries

2.1 背景

由 Google 首次提出的联邦学习 (FL) 已迅速成为实际 ML 应用程序的流行框架,其中用户隐私是主要关注点。联邦学习是一种用于训练 ML 模型的去中心化策略。它允许边缘设备协作训练 ML 模型,同时保持每个边缘设备的数据隐私。因此,联邦学习有可能将更多的用户设备带入训练过程,通过结合用户/边缘设备的数据和计算资源,从而形成更有效的全局模型。

与联邦学习密切相关的一个概念是分布式ML。在分布式机器学习中,整个训练数据集被划分为许多较小的分区,每个分区被转移到一个计算节点。分布式 ML 的目的是在计算节点之间分摊训练成本,因此,在必要时允许跨节点共享数据。这与联邦学习不同,在联邦学习中,保护数据隐私是重中之重。

图 2 中描绘了联邦学习的一般框架。联邦学习假设独立于 C 语言的客户端设备(例如,用户的手机、平板电脑和笔记本电脑)将参与模型训练,并有一个中央服务器用于协调训练。设 c ∈ [C] = {1,2, . . . ,C} 是一个参与设备,Dc = {(,

), . . . ,(

,

)} 是客户端 c 拥有的私有数据集,其中 Nc 表示客户端 c 的训练实例数,(

,

)表示第 i 个训练实例,输入为

,目标类标签为

。

整个培训过程包括四个步骤:

(1) 全局模型被复制到每个参与的客户端。

(2) 每个客户端将使用自己的数据来更新全局模型。

(3) 经过训练的本地模型将上传到中央服务器。

(4) 在中央服务器中,所有经过训练的模型都聚合到一个新的全局模型中。

通常假设包括服务器在内的所有参与者都是半诚实的,即他们遵循联邦学习的确切协 议,但可能对其他数据感到好奇。

Fed Avg是第一个也是最著名的FL模型。它是一种多轮迭代算法,逐步优化一个目标函数,直至收敛。具体地,第t轮训练的目标设定为:

式中,K为第t轮参与训练的客户数,为第t轮参与训练的总实例数,Fi ( W )为第t轮参与训练的第i个客户的损失函数。

FedAvg中的一轮训练可以总结如下:

(1) 服务器随机选择一个客户子集,并将全局模型分发到这些选定的客户。

(2) 本轮选择的每个客户端通过使用其本地数据集不断训练来更新接收到的模型。

(3) 每一个参与本轮迭代的客户端都将自己更新后的模型返回给服务器。

(4) 服务器将接收到的客户端模型聚合成一个新的全局模型。

在第t轮,中心服务器对客户端上传的本地模型进行如下聚合:

除了迭代聚合,FedAvg通过执行更多的局部更新和更少的全局更新来优化通信效率。利用这些数据,Fed Avg被实验证明可以在非IID数据中成功发挥作用。可以看出,FedAvg训练的CNN模型在非IID MNIST数据集上可以达到99%的测试准确率。

2.2 联邦学习模型的分类

给定一个数据集,我们将其特征空间定义为用于描述数据样本的属性集合。我们进一步将其样本空间定义为从其中收集样本的源实体。例如,对于一个包含患者健康记录的数据集,这些患者已经完成的临床测试的集合是该数据集的特征空间,患者的集合代表了样本空间。

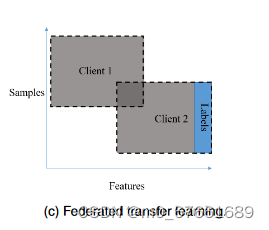

在FL中,数据集被收集并被不同的客户端设备所拥有。因此,这些数据集的特征可能存在显著差异,从而导致特征和/或样本空间的分布模式不同。可分为横向FL,纵向FL和联邦迁移学习。

横向FL。在水平联邦学习中,边缘设备的客户端数据集在特征空间上高度相似,但在样本空间上有所不同。也就是说,不同设备上的客户端数据集可以按样本维度进行划分:一个客户端数据集与另一个客户端数据集具有相似的特征集,并且在样本方面是另一个数据集的扩展。举个例子,假设我们有多个病理研究中心,在不同地区提供类似的临床试验服务。因此,这些病理站点收集的数据可能具有不同的患者组(即样本空间),但共享相同的临床试验(即特征空间)。在这方面,横向联邦学习在扩展训练数据的样本量方面有利于 ML 模型。文献中,横向联邦学习中的模型聚合主要集中在梯度聚合上,即所有客户端都基于自己的本地数据集计算并上传本地梯度到服务器进行聚合。有人指出,在横向联邦学习中,在梯度通信过程中,私有客户端信息仍可能被泄露,同态加密、差分隐私和安全聚合已被提出来解决这个问题。

纵向 FL。在纵向联邦学习中,客户端数据集在样本空间上具有很强的重叠性,但在特征空间上有所不同。这意味着示例实体在客户端数据集中是相似的,并且每个客户端数据集都扩展了这些示例的功能。联邦学习的一个例子可能是多个设备存储同一患者在不同年份的临床试验结果。在这里,样本实体(即患者)在不同的设备上是相同的,但特征空间是不同的(即不同年份的健康记录)。要在纵向联邦学习中训练全局模型,在不同设备上加密不同的特征至关重要。特征加密已成功应用于开发基于各种ML模型的联合系统,包括逻辑回归、树结构模型和神经网络。

联邦迁移学习。在联邦迁移学习中,客户端数据集在样本空间或特征空间中没有太多重叠。在健康记录示例中,假设医疗保健提供者提供不同的服务,并且位于不同的地区。因此,这些医疗保健提供者拥有的数据集在特征空间(即不同的医疗保健服务)和样本空间(即不同的患者)上将有所不同。在这种情况下,客户端数据集之间没有明显的重叠。然而,一个数据集所承载的固有知识可能仍然有利于我们理解另一个客户数据集。因此,人们已经做出了许多努力来开发迁移学习技术,以提取可转移到其他数据集的可泛化特征[42]。客户端数据的机密性可以通过联邦迁移学习来保存。而且,它可以将辅助任务的模型转移到导演学习中,从而解决了数据量小的问题。

我们说明了三种类型的联邦学习,其中灰色矩形表示客户端数据集的特征和样本空间。图中的虚线矩形表示联邦学习的数据。我们以蓝色突出显示客户端数据集提供的标签。在垂直联邦学习中,额外的客户端数据集仅用于增强数据样本的特征,因此只需要一个客户端数据集来提供目标类标签。这同样适用于联邦迁移学习,其中额外的客户端数据集通常用于不同的任务,并用于提供外部知识。因此,纵向联邦学习和联邦迁移学习中的类不平衡问题仅在提供标签的客户端数据集存在类不平衡时才会发生。这类似于传统非联邦模型中的类不平衡,这已被许多文献所涵盖。因此,本文主要关注水平联邦学习中的类不平衡问题。

2.3 联邦学习中的不平衡问题

由于 FL 具有分层训练结构,由一个集中式服务器管理一组客户端设备,因此 FL 中的类别不平衡可能会发生在客户端数据集的较低级别以及全局级别。接下来介绍文献中常用的 FL 中类别不平衡的分类。为了便于表述,我们用表示客户端 i 上 p 类数据样本的数量。

局部不平衡:每个客户端拥有的本地数据集不平衡。客户端 i 的局部不平衡率γi 是客户端 i 上多数类的样本数与客户端 i 上少数类的样本数之间的比率,即 γi = 。在极端情况下,一个客户端数据集中可能

。

全局不平衡:客户数据集的并集 (即全局数据集) 是不平衡的。全局类别不平衡度Γ定义为所有客户的总体多数类样本数与少数类样本数之比,Γ = 。

失配不平衡:每个客户的局部不平衡不同于全局不平衡。在现实中,这种不匹配被发现是普遍且重要的。一类可能是客户为i的多数类,但在全球层面上成为少数阶层。为了更准确地量化这种不匹配,我们使用向量来表示客户端i的类组成,其中Q是类的总数。我们进一步使用向量

来表示全局数据集的组成。因此,本地客户端i和全局数据集之间的失配不平衡可以表示为它们组成向量之间的余弦相似度( cosine similarity,CS ),即

。

不同类型的类不平衡会给FL带来不同的挑战。局部不平衡可能导致局部模型的分类性能较差,进而损害全局模型的性能。因此,首先要解决局部不平衡问题,以确保更好的全局模型。

即使不存在局部不平衡,训练数据的全局不平衡也会导致性能恶化,这在数学上已经得到了证明。已有研究指出,当在不平衡的全局数据集上训练时,全局模型很可能收敛于局部最优点。FL中的性能下降也可以由训练集和测试集的分布之间的差异引起。

在FL中,失配不平衡也不利于模型性能。在FL的不同训练步骤中类分布的变化会引起模型优化的波动。此外,当客户端之间的数据分布多样性较低时,会导致生成的局部模型多样性较低。因此,这将导致生成的全局模型鲁棒性较差。

解决FL中的类不平衡问题比传统的ML更具有挑战性。这是因为在FL中,为了保护用户隐私,客户端数据集的数据分布通常是机密的。而且,上述三种类型的类不平衡往往交织在一起,因此开发联合处理不同类型类不平衡的技术至关重要。

3. 类别分布估计

然而,在FL设定中估计实际的类别分布通常是困难的。虽然理解一个局部数据集的类分布是相当简单的,但是在全局层面上获得一个完整的类分布是不平凡的。这是因为在FL设置中,只有训练好的本地模型可以在客户端设备之间共享。然而,为了保护用户隐私,客户端之间不能共享本地数据集。

因此,人们提出了许多方法来估计全局类别分布。我们将现有文献中估计全局类别失衡的方法分为两组。第一组要求每个客户端设备将类分布(不是数据本身)上传至中心服务器,中心服务器可用于导出全局类分布。第二组方法基于训练好的模型或上传的梯度推断类别分布。在这一部分中,分别对这两组方法进行了综述。

3.1 基于局部分布的分布推导

估计全局数据分布的一种直接方法是要求客户端将其本地数据集的类别分布上传到服务器。然后,所有客户端上传的类分布可以合并为全局类分布。

Mhaisen等人在分层FL方法中提出了一种最优的user-edge assignment(用户-边分配)。客户端的数据分布需要上传到中心服务器。Duan等人提出了Astraea method,即客户端向服务器发送本地数据分布信息。

要求客户端上传数据分布,操作简单。然而,有研究指出,泄露类别分布仍然可能泄露用户的部分隐私信息。以推荐系统中的FL为例。客户数据的标签分布的披露可能会揭示用户在客户端的偏好。虽然这种方法可能会轻微地损害用户的隐私,但保护客户原始数据的核心FL要求仍然是满足的。

3.2 基于模型参数的分布估计

第二组方法通过考察客户共享的模型来间接推断类别分布。因此,这些方法不需要客户端直接显示类别分布,从而更好地保护了用户隐私。几种类型的模型参数,如梯度、损失和预测,可以用来估计客户端设备的数据分布。接下来,我们回顾了属于该组的现有方法。

Gradient-based methods(基于梯度的方法):首先,分析了模型的梯度与不同类别样本数量之间的关系。在类别平衡的辅助数据集上计算模型梯度。然后通过梯度可以估计不同类别的样本数。

然而,该方法需要辅助数据,在一定条件下可能无法获得。

Wang等提出了一种模型,用于在客户端设备不断生成新数据时持续监测训练数据的组成。它使用在类分布中平衡的辅助数据集。在时间步长t+1处,模型下载全局模型,将辅助数据集中的样本馈入

,并获取辅助数据集的梯度更新。通过将这些梯度更新与时间步长t+i的全局模型

进行比较,该模型可以推断出全局类分布。在真实数据集上的实验结果表明,估计分布与真值分布之间的余弦相似度得分平均达到0.98。

Yang等揭示了梯度和类分布之间的相关性:训练模型对不同类的梯度平方的期望值近似等于这些类的基数平方。基于这一发现,他们将辅助数据集输入到经过训练的全局模型中,以获得不同类的梯度更新。然后,这些梯度更新用于近似训练数据的全局类分布。

Chen等基于Yang等关于梯度与类分布相关性的发现,提出了一种类分布估计方法。但是,他们的方法不需要辅助数据集。对于每个客户端,它们会计算客户端训练模型的梯度更新,从中可以直接派生客户端本地数据集的类分布。然后,可以将全局分布表述为所有客户端类分布的加权平均值,其中权重是要学习的参数集。因此,训练全局模型可以看作是通过quasi two-party theory将整体损失最小化的过程。他们提出了一种算法,该算法可以交替优化权重和模型参数以进行模型训练。

Dong等认为,联邦学习的数据失衡可能在局部和全局水平上随时间而变化。此外,他们假设数据集中可能会出现看不见的类的新数据。因此,由于存储空间有限,本地或全局模型可能会忘记有关旧类的信息。为了解决这样一个灾难性的遗忘问题,他们提出了一个global-local forgetting compensation model(全球-局部的遗忘补偿模型)。特别是,本地客户端将通过class-aware gradient compensation loss(类感知梯度补偿损失)和class-semantic distillation loss(类语义蒸馏损失)来解决遗忘问题。在全局级别上,该模型保存了一组旧的全局模型。一旦遇到看不见的类,模型就会使用基于原型梯度的通信机制将新类的受干扰原型样本发送到代理服务器。代理服务器在接收到这些梯度后重建受扰动的原型样本,并使用它们来跟踪保存的旧全局模型的有效性。性能最好的旧模型将用于关系蒸馏,以解决全局遗忘问题。

对于数据不平衡程度较高的数据集,少数类的损失通常比多数类高得多。在文献中,一个客户端的损失函数值被认为反映了客户端数据集在一轮训练中的有用性。因此,被认为更有用的客户(即拥有更多属于全局少数群体的样本)将更有可能在随后的训练轮次中被选中,以处理类别不平衡的问题。

Shen等在标准联邦学习方案中增加了一个约束条件:每个客户的经验损失不应超过平均经验损失。在具有失配不平衡的异构数据配置下,该约束使全局分类器能够平等地考虑所有类,从而减轻类不平衡的不利影响。

Chou等提出了一种针对FL的全局正则化个性化(GRP-FED)技术。他们的目标是提高所有客户对全局模型的贡献的公平性。如果所有客户端的训练损失的标准差都很高,则训练损失差异很大,全局模型可能会受到客户端不平衡的影响。

模型性能:后续的联邦学习过程由模型对每个类样本的分类性能进行调整。分类精度较高的类通常具有较多的样本数。该方法无法估计数据的分布信息,只能通过每个类样本的分类性能来指导后续的联邦学习过程。例如,在基于客户选择的求解类不平衡问题的方法中,选择综合分类性能较好的客户参与训练,从而提高全局模型的性能。

为了减轻偏度对客户数据集标签分布的影响,Mou等在服务器端采用了平衡的全局验证数据集来对每个客户模型的性能进行评分。这为客户评估提供了一种简单而易于操作的方法。

Geng等提出在模型聚合过程中,根据局部模型的F1分数对局部模型进行加权。因此,通过增加高质量客户端模型的权重,增强了联邦学习中的聚合策略。

Hao等提出了zero-shot data generation algorithm(ZSDG),该算法可用于生成标记的合成数据,用于客户端或服务器端的数据增强。ZSDG可以通过两种方式使用,这两种方式都可以缓解数据不平衡问题。首先,ZSDG 可以利用预先更新的全局模型在客户端生成所需类的合成数据。其次,它可以利用更新后的本地模型在服务器端生成所需类的合成数据,而无需访问任何非本地数据。

3.3 Cluster(聚类)

这组方法根据客户端的某些属性将客户端聚类到不同的组中。为了保护用户隐私,客户端向服务器公开的属性应仅限于某些信息,如模型权重、梯度、局部最优等。根据聚类结果,服务器可以针对不同的集群使用不同的策略,以缓解数据平衡问题,例如为每个集群生成个性化模型、数据采样和客户端选择,旨在解决全局数据不平衡问题。

Zhao等采用agglomerative hierarchical clustering algorithm(聚合分层聚类算法)将客户端聚类成簇。聚类中的功能包括客户端训练和上传的本地模型的参数。

Wang等提出了一种基于自适应聚类算法的新型weighted clustered FL(加权聚类联邦学习)(CFL)模型。在每一轮联邦学习训练中,客户端根据上传的局部梯度的余弦相似性进行分组。每个客户端不仅上传本地梯度,还将其类不平衡度上传到服务器。

Fu等提出了一种 class imbalance-aware clustered FL method(类不平衡感知聚类联邦学习方法)(CIC-FL)。每个客户端都使用权重更新和全局模型的标签梯度来计算特征向量,并将其发送到服务器。CIC-FL采用自上而下的分层聚类过程。然后,服务器迭代地进行双分区,将这些客户端划分为两个集群。

3.4 自下而上的类分布估计

由于客户端对其本地模型具有完全访问权限,因此可以根据 FL 模型的状态推断数据分布,或者推断局部数据与全局数据分布之间的相似程度。

为了保护客户的隐私,Zhang等人提出了一种FedSens方法,客户根据当前状态和外部-内部奖励来决定是否参与本轮学习。客户端当前应该考虑的状态是在每个类别上的分类性能以及在每个设备上训练一个局部模型所需要的能量。每个客户端的奖励取决于客户端的数据集。如果客户拥有均衡的本地数据,客户应该获得更大的奖励。

在Dubhe中,每个参与的客户端计算本地数据分布,然后使用同态加密方法对分布进行加密。服务器根据加性同态将所有客户端的分布相加,然后将结果返回给所有客户端。然后,客户端解密结果以获取整个类分布。

Li等提出了一种针对联邦学习的数据选择方法。每个客户端不公开本地数据或分发本地数据,而是只报告1位信息,即客户端的数据是否与服务器相关。

Hahn等提出了一种基于贝叶斯计算的近似高斯混合模型(approximate Bayesian computation-based Gaussians Mixture Model ),称为“Federated ABCGMM”,该模型可以通过估计模型参数的后验分布来对次要类中的数据进行过采样。该算法从后验分布中选择候选参数,并根据所选参数生成样本。然后,中央服务器生成的这些样本将共享给客户端,客户端将计算这些样本与其本地样本之间的相似性。根据所有客户端之间的相似性,抽样的候选参数将在 CS 上确定是接受还是拒绝。当过程被迭代时,接受的参数集变得接近其真实的后验分布。

表 1 列出了这些类估计方法。

4. 联邦学习中类不平衡的分类

类不平衡在真实世界的数据集中很常见。由于少数类别的样本量有限、类别之间的重叠以及一个类别内的微小分离带来的信息差距,它可能对分类模型的工作效果产生不利影响。这种影响的程度取决于训练数据的不平衡程度、概念复杂性和大小。为此,对传统ML中的类不平衡问题进行了广泛的研究,一般可分为5种类型:预处理方法、成本敏感学习、以算法为中心的方法、集成学习和混合方法。这些方法中的大多数都假设传统 ML 的设置,其中训练数据位于集中位置。然而,在联邦学习的设置中,训练数据分布在客户端设备上,这给处理类不平衡带来了新的挑战。因此,针对联邦学习量身定制的新方法被提出来解决类不平衡问题。接下来,我们将在本节中回顾这些方法。

与传统ML中使用的分类模式类似,我们将联邦学习中类不平衡的分类方法分为三类:(1)基于抽样的技术;(2)以算法为中心的技术;(3)系统中心技术,如图4所示。基于采样的技术可以看作是预处理方法的一个子类型,它将预处理步骤应用于训练数据以平衡类分布。以算法为中心的技术旨在通过修改分类算法(例如,更改损失函数和修改算法)并允许算法更多地关注少数类来处理类不平衡。以系统为中心的技术在联邦学习框架中系统地解决了类不平衡问题,包括基于聚合、个性化、系统修改和元学习的方法。

4.1 采样技术

基于抽样的技术有选择地选择训练过程中应该涉及的数据,以生成具有平衡类分布的新样本空间。一般来说,与其他方法组(例如,以算法为中心的技术)相比,基于采样的技术更易于操作,并且不需要广泛的机器学习专业知识。因此,当模型由域外专家操作时,这些方法已经变得流行起来。基于抽样的技术的另一个优势是它们与核心分类模型无关。因此,这些技术可以合并到任何分类模型中,并事件多个分类模型的集合。

然而,直接的数据采样并不能保证提高分类精度,有时甚至可能降低模型在一个客户端上的性能。研究发现,数据抽样可能会产生少数(多数)类的过度拟合(欠拟合)局部模型。一种可能的解释是,简单的数据重采样可能会阻止客户从联邦学习的本地数据集中学习“特殊知识”,最终导致准确性低下。因此,需要针对联邦学习精心设计抽样策略,以有效处理类别不平衡。

因此,已经进行了许多尝试来提出抽样策略,以系统地解决联邦学习中的数据不平衡问题。通常,可以在数据实例级别(即确定一个数据实例是否应参与训练)或客户端级别(即确定一个客户端拥有的数据实例是否应参与训练)进行采样。在本节中,我们将联邦学习中的抽样技术分为三组,并分别介绍它们:(1)数据抽样;(2)客户抽样;(3)数据和客户端混合抽样。

4.1.1 Data Sampling

给定不平衡的数据集,数据采样旨在使用预定义的采样策略来平衡样本空间。现有的抽样策略可分为三类,如图5所示:

过采样:为少数类生成新的合成数据实例以增加其类大小。属于这一组的方法包括 SMOTE 和 bootstrapping。

欠采样:从多数类中删除样本以减小其类大小。一种简单而有效的方法是随机欠采样(RUS),它从多数类中随机删除数据。

混合抽样:通过过采样和欠采样的组合生成平衡数据集。

客户端数据采样(Client-side data sampling)。在联邦学习中,每个客户端都可以对其本地数据集进行数据采样,即对少数类进行过采样或对多数类进行欠采样,以平衡其本地类分布。由于每个客户端拥有的本地数据量通常在大小上是有限的,因此在文献中更倾向于过采样。由于局部模型的性能对于联邦学习中的最终全局模型至关重要,因此使用客户端数据重采样执行高质量的本地更新通常可以显着提高模型质量。

服务器端数据采样(Server-side data sampling)。仅仅在客户端本地执行数据采样可能无法系统地解决联邦学习中的数据不平衡问题。这是因为客户端可能具有来自不同类的数据。即使每个客户端在类分布上是平衡的,客户端数据集的聚合也可能不平衡。因此,需要服务器端数据采样来解决此问题。服务器可以根据数据集特征选择采样策略,该特征是通过第 3 节中总结的方法估计的。

Shingi等采用SMOTE方法对客户端少数类进行过采样,以解决局部不平衡问题。

Hao等提出了一种新的零样本数据生成(zero-shot data generation)(ZSDG)过采样方法,以减轻联邦学习系统中的类不平衡。他们研究了 ZSDG 的两种变体:客户端 ZSDG 和服务器端 ZSDG。除了处理类不平衡外,ZSDG 还可以鼓励 FL 中的客户端之间更统一的准确性性能(即公平性)。

Tijani等人提出了一种直接的数据扩展方法(straightforward data extension method )来处理严重的标签偏斜问题。根据客户端私有数据缺失的类,每个客户端从外部数据样本中选择少数几个扩展样本。

Weinger等人在FL中研究了数据过采样对物联网异常检测性能的影响。他们实现了一系列的过采样技术,包括随机过采样,SMOTE和SMOTE的变体ADASYN。它们旨在提高客户端局部模型的质量,确保这些客户端能够对全局模型做出有意义的更新。因此,他们在客户端对数据进行局部过采样。

Tang等提出了一种不平衡权重衰减采样( Imbalanced Weight Decay Sampling)( IWDS )方法,该方法是一种简单但有效的数据重采样策略。它动态调节不同标签的采样概率,加速训练过程。在IWDS中,所有数据样本的采样权重随着训练轮数的增加而衰减。在早期的训练轮中,为了更快地收敛,使得所有客户端具有更相似的标签采样概率。在以后的轮次中,为了让每个客户端更好地从本地数据集中学习特殊知识,使得所有客户端都使用自己的原始标签采样概率,这类似于本地采样。

4.1.2 Client Sampling

客户抽样方法通过有选择地选择参与FL训练迭代的客户来解决类别不平衡问题。当FL中的参与客户端不总是可访问的,例如,某些客户端可能没有足够的电源,或者在服务器轮询时可能被关闭时,这些方法尤其有用。图6展示了一个无人机( UAV )网络的例子,其中参与的无人机是能量受限的。进行客户端采样的另一个原因是,并不是所有的客户端都能访问到与底层全局数据分布相当的数据分布。由于特定客户的分布与全局分布之间缺乏相似性,学习过程会收敛缓慢甚至发散。

当客户之间的数据是非IID且全局数据分布有偏时,随机客户选择可能会加剧数据偏差。因此,许多方法选择一个类不平衡度最小的客户机集合。然而,这将导致在客户端训练的局部模型的多样性较低。这也可能导致全局模型的鲁棒性较差。

因此,针对FL提出了更为复杂的客户端采样方法来解决类别不平衡问题。在这一部分,对这些方法进行了综述。我们将这些方法按照其采样策略进行分类:( 1 )基于优化的方法;( 2 )基于排名;( 3 )基于聚类;( 4 )基于自下而上。

基于优化的客户端采样(Optimization-based client sampling)。这组方法将客户选择问题建模为在给定一定约束条件(例如,沟通成本)的情况下,最大化某一目标(例如,整体模型性能)的优化问题。

Mrad等针对能量受限的无人机网络,提出了一种解决FL中类不平衡问题的方案,同时考虑了无人机由于其严格的能量约束而导致的有限可用性。他们的目标是在考虑类不平衡问题的情况下,为无人机网络获得可靠稳定的FL性能。优化策略是选择类别不平衡度最低的无人机集合,以提高分类精度。

Mhaisen等人[ 67 ]研究了用户-边-云的层次化FL范式(User-Edge-Cloud hierarchical FL paradigm)。为了减少边缘设备之间的分布差异,他们将客户端采样问题建模为将用户(客户端)分配给其通信范围内的边缘节点的问题,该问题可以看作是一个NP - Hard问题。针对这一问题,他们提出了两种解决方案。第一种是基于分支定界的解决方案,以简化线性版本的问题,该问题假设边缘设备之间的分配相等。第二种方案使用启发式方法来贪婪地平衡边缘设备之间的类分布。

基于排序的客户端采样(Ranking-based client sampling)。客户端可以通过本地数据分布和本地模型分类性能等指标进行评估和排名。基于排序的客户抽样根据选定的指标对客户进行排序,并根据排序结果选择客户。

Chen等人提出了一种为每个客户分配奖励的客户抽样方法。客户端的奖励与客户端和全局类分布之间的余弦相似度有关。此后,所有的客户根据他们的奖励进行排名,只有排名靠前的客户才允许参与全局模型更新。

在文献中,提出了一个主动联邦学习模型。在每个联邦学习训练轮中,它根据反映该客户端数据有用程度的值函数选择优化的客户端子集。他们提出,可以利用自然值函数为局部模型的损失值:少数类样本的损失值将明显高于多数类样本。此后,服务器将所有客户的价值分数转换为每个客户在下一轮被选中的概率。因此,在下一轮训练中,价值较高的客户被选中的概率更高,这隐含地有利于那些为少数群体提供更多样本的客户。

基于聚类的客户端采样(Cluster-based client sampling)。这组方法将客户端分组到集群中,并根据其关联的集群选择客户端,以确保全局数据集的类平衡。

Zhao等提出了一种基于聚类的解决方案,以降低多数类的性能为代价,提高少数类的精度。首先,它执行 FedAvg。然后,当模型几乎稳定时,它使用分层聚类分析方法将客户端聚类到组中。最后,从这些集群中选出参与者参加本轮培训。

自下而上的客户端采样(Bottom-up client sampling)。在此组中,客户端的参与由客户端本身(底部)决定,而不是由服务器集中决定。客户端观察全局数据集的数据分布或当前全局模型的性能,然后决定是否参与全局训练。

在文献中,每个客户端的数据分发信息都使用同态加密进行编码。服务器添加加密的分发信息,然后将其返回给客户端。每个客户端根据此类分布计算参与概率。该方法还提出了一种多时间客户端选择方法,以进一步平衡每轮训练中的全局数据集。

Zhang等人提出了一种自底向上的设备选择方法来解决异常健康检测应用中的类不平衡问题。为了保护客户的隐私,客户根据当前状态(在每个类别上的分类性能以及在每个设备上训练一个局部模型所需要的能量)和外部-内部奖励来判断是否参与本轮学习。外部奖励是当前环境提供的反馈,它被定义为全局模型的性能。内在奖励考虑了局部模型更新的重要性和设备的能量成本。

4.1.3 Hybrid Data and Client Sampling

可以进一步结合数据采样和客户端采样的策略,实现模型性能的进一步提升。特别地,客户选择往往与全局数据采样相结合,以解决FL中的全局不平衡问题。

Duan等人提出了一种自平衡FL框架Astraea。在文献中,他们采用数据增强(过采样)的方法来解决全局不平衡问题。它首先根据客户的分布信息,通过基于z - score的数据增强和欠采样来解决训练数据的全局不平衡问题。然后,它使用一个中介器(mediator)异步接收并应用参与客户端的这些更新模型来平均局部不平衡。因此,中介者可以通过重新安排客户的训练来获得一个更加平衡的模型。

Li等人提出了一个有效的分层样本选择系统,该系统首先选择最好的客户,然后选择他们的顶尖样本。在训练之前,他们使用基于私有集合交集的方法选择与目标FL任务相关的客户。使用基于行列式点过程的方法,它们在一个预算内最大化这些选定客户的统计同质性和内容多样性。然后,在FL训练过程中,提出了一种基于错误感知重要性的选择策略,在每次迭代过程中动态地选择重要的客户和样本。

4.2 Algorithm-Centered Techniques

与采样方法只对数据施加预处理步骤不同,以算法为中心的方法对分类算法做出改变以处理类不平衡。这包括改变损失函数和修改分类算法本身,目的是使分类算法对少数类更敏感。

4.2.1 Cost-Sensitive Learning

用于分类任务的经典损失函数(例如交叉熵)假设所有数据样本都是独立的,并对所有数据样本的错误分类错误应用相同的惩罚。这使得当样本不能确认IID分布时,容易出现类别不平衡。因此,提出了成本敏感学习,如果模型对少数群体的样本进行错误分类,即为少数群体分配更高的错误分类成本,则通过对模型进行更多惩罚来增强传统的损失分类损失函数。

’ 一般来说,成本敏感型学习方法可以看作是重新加权策略,在损失函数的计算中根据数据样本的重要性对数据样本进行加权。因此,它与数据重采样有着相似的原理,只是成本敏感型学习是一种软重加权策略,而数据重采样则为数据样本分配硬(积分)权重。与数据过采样相比,成本敏感型学习不会增加数据集大小。这提供了更有效的模型训练,使其可能更适合海量数据流。

然而,与重采样技术相比,对成本敏感的方法似乎不太受欢迎。可能的原因有两个。首先,在这些方法中定义适当的成本值具有挑战性。大多数情况下,仅通过观察数据无法确定最佳成本值。因此,需要执行昂贵的微调过程来搜索优化模型性能的最佳成本值。其次,成本敏感型学习往往需要修改学习算法,因此,它要求联邦学习的联邦学习应用开发人员对分类算法有扎实的理解。

Lin等介绍了焦点损失(focal loss),它是用于二元分类的传统交叉熵(CE)损失的改进版本。对于一个数据实例,CE 可以表述为:

其中 y ∈ {±1} 表示数据实例的真值类,p ∈ [0,1] 表示模型预测的实例被标记为 1 的概率。为了便于呈现,我们将实例被归类为真值标签的概率定义为真值标签:

因此,CE 可以隐含为 CE(p,y) = −log()。

Lin等人将损失函数重塑为低权重的易正样本(即,多数类样本),从而专注于学习决策边界(即,少数类样本)附近更困难的样本。他们引入一个系数来实现这一点。焦损失( FL )表示为:

其中γ是一个超参数,控制着模型应该关注更困难的样本的多少。当γ = 0时,FL与CE等价。

FL有两个性质:(1)当取值较小(也就是说,样本被严重误分)时,系数1 -

接近于1。当

接近1 (也就是说,样本以高置信度被正确分类)时,因子减小为0;( 2 )通过聚焦参数γ平滑调整易分类样本降权的速率。

Wang等人提出了一种监控方案,可以根据梯度推断每个FL轮的全局训练数据分布。他们设计了一个新的Ratio Loss来减轻不平衡的影响。一旦监控器连续检测到类似的不平衡分布,就会确认客户采用基于Ratio Loss函数的缓解策略。

Sarkar等人提出了一种新的损失函数,称为Fed - Focal Loss。它在训练过程中重塑CE。根据客户的训练表现,它对分配给分类好的样本的损失进行降权,并将注意力集中在那些较难的样本上。此外,通过使用可调节的采样框架,服务器选择性能最佳的客户端进行全局训练。因此,该方法提高了全局模型的鲁棒性。

Wang等人引入了一个修正的CE损失函数,平衡交叉熵( Balanced Cross Entropy,BCE )。此外,他们定义了一个结构性损失函数,旨在防止过拟合。那么一个参数λ就是平衡这两种损失。

Shen等对标准FL公式施加约束,使得每个客户的经验损失不应过度超过平均经验损失。这种约束被证明可以迫使分类器对所有类进行平等的计算,从而减轻类不平衡的不利影响,在捕获局部和全局不平衡之间不匹配的一类异构数据配置下。它们的提法可以显著提高少数类的测试精度,而不会损害整体性能。

Dong等人提出了一种全局-局部遗忘补偿模型。它主要由类感知梯度补偿损失和类语义关系蒸馏损失组成,用于对抗客户端类不平衡导致的局部灾难性遗忘和客户端非IID类不平衡导致的全局灾难性遗忘。在使用旧的具有最佳性能的全局模型的同时,在代理服务器和客户端之间创建了一个原型的基于梯度的通信机制,用于它们的私人通信。

4.2.2 Algorithmic Classifier Modification

一些以算法为中心的方法直接修改学习过程来增加分类器对少数类的敏感性。如图7所示,该方法鼓励分类模型在少数类和其他类之间有更大的间隔。以动态裕度softmax(dynamic margin softmax)为例,对少数类增加 ∆margin。

Ran等人提出了一种在FL中创建动态边界的方法。利用类别不平衡数据训练的分类器,其原始决策边界往往更接近少数类。它鼓励每个参与客户端的局部分类模型对少数类具有较大的裕度,巧妙地在损失函数中添加动态项,引导模型从数据中学习更多可分离的特征。相应地,在局部训练阶段,将原softmax替换为动态裕度softmax。进一步将CE损失与动态裕度方法相结合。

Hua等人通过赋予多数类和少数类不同的惩罚分量,对传统的SVM模型进行了改进。该技术能够处理牵引和制动不平衡的数据。

类不平衡数据的联邦模糊学习方法(Federated fuzzy learning approach with class imbalanced data )是由Dust等人提出的。其主要思想是对少数类样本进行虚拟过采样。他们提出了一种不平衡适应机制,以增加模糊学习过程中少数类样本的影响,从而解决类别不平衡问题。通过允许少数阶层的主管规则与多数阶层的主管规则共存,从而起到防止该模式对多数阶层产生偏见的效果。

Li等人提出了一种FedRS方法。在局部过程中,他们主张对缺失类代理的更新进行限制,从而引入了受限的softmax。在softmax操作中加入"缩放因子"是一种简单的实现方法。然后,基于,

进行细粒度聚合,其中

为第k个客户端上第c类样本的个数。

4.3 以系统为中心的技术

以系统为中心的方法通过改变FL框架的结构来解决类不平衡问题。我们进一步将它们分为基于聚合的方法、个性化方法和系统修改方法。

4.3.1 Aggregation Method

在模型聚合阶段,每个局部模型的权重可以根据一定的评价指标进行调整。标准的Fed Avg假设类别平衡的训练数据,在聚合时只考虑客户端的数据量。然而,客户的权重也可以被操纵,以处理类别不平衡问题。

Wang等人基于自适应聚类算法提出了一种新的加权聚类FL ( CFL )模型。在服务器端进行加权的每簇模型聚合。为每个簇分配不同的权重,以平衡每个类对全局训练数据的贡献。此外,通过收敛速度分析对每个聚类的权重进行优化。

Geng等人提出了一种基于F1 - score的加权聚合策略。为了解决类别不平衡问题,基于加权F1 - score对客户端的局部模型进行加权,隐式地处理了类别不平衡问题。他们还提出了一种改进的聚合算法,该算法基于客户端临时精度和一个基准精度之间的精度差异。该方法不仅可以提高模型聚合的准确性,还可以减少通信时间。

Mou等人提出在服务器端生成一个全局平衡的数据集。然后,通过评估客户端 i 的局部模型在平衡的全局数据集上的性能,计算验证得分。最后,根据验证得分计算每个客户端的聚合权重。他们测试了不同选项的验证得分,如准确率、IoU和交叉熵损失。

4.3.2 Personalization Method

在传统的FedAvg算法中,所有的客户端都被同等对待。因此,忽略了客户数据分布之间的差异,导致在高类不平衡的情况下模型性能较差。此外,由于FedAvg以数据量来衡量客户,这些大客户很容易在全局模型中占主导地位,而其他客户在聚合中被忽视。因此,它们的分类性能显著下降。即使算法鼓励这些被忽视的客户关注全局公平性,但全局测试和局部测试之间的性能差距可能仍然很大。

这些都表明个性化在FL模型中是必不可少的。在个性化的情况下,本地客户在训练时对他们的本地数据有独特的关注。如图8所示,对于每个客户端集群或每个客户端,基于全局模型和自身的局部数据生成个性化的局部模型。

Fu等人提出了CIC - FL方法,其中每个客户端使用过采样或降采样来生成平衡的局部数据集。此后,客户被聚类到不同的组。为了解决类不平衡和数据漂移问题,在每个聚类中训练一个个性化模型。

Chou等人在FL中提出了一种全局正则化个性化( GRP-FED )方法,该方法通过考虑单个全局模型和针对不同客户的个性化局部模型来解决类不平衡问题。全局模型缓解了全局长尾问题,并通过自适应聚合公平地对待客户。每个客户的本地模型从本地数据中学习,并与它的分布对齐,以实现个性化。GRP - FED使用对抗判别器对学习到的全局-局部特征进行正则化,防止局部模型简单的过拟合。

为了处理物联网设备的上下文访问抽象,Yu等人设计了一种定制的数据增强方法。他们设计了两种机制来解决不平衡记录:上下文随机采样和添加上下文噪声。目标是通过对环境变量和设备状态进行随机采样,降低环境变量/设备状态与某一动作的物联网接入之间的相关性。在攻击样本的环境变量中加入噪声。

Chen等人设计了一个代理增强迁移模型来平滑地将全局知识迁移到客户的个性化局部模型中。他们提出了联合原型对齐( CPA )损失来解决类不平衡问题,使FL框架的平衡优化变得更加容易。CPA损失基于全局不平衡计算全局联合目标,然后通过原型对齐精化调整客户端局部训练,以消除这种平衡目标下的不平衡差距,同时考虑到FL模型中客户端的局部数据对其他客户端和服务器的不可访问性。

4.3.3 System Modification Method

类不平衡问题也可以通过系统性地修正FL框架来解决。

Cheng等人在客户端和服务器端都使用卷积神经网络( CNNs )来提取实用的特征。不平衡的输入数据会导致神经网络提取不平衡的特征,因此它们首先为每个类得到一个聚类,然后用于构建分类器。然后,以分类交叉熵函数为指导,对每个客户端模型进行训练。在区块链技术的帮助下,传统的FL得到了增强,而不必担心服务器的故障,并增强了客户的隐私。

Cheng等人提出了类不平衡的异构FL方法。他们在客户端和服务器端都使用卷积神经网络( CNN )来提取有用的特征。在客户端和服务器端,通过对每个类到潜在空间的特征提取,得到一个原型。然后,基于获得的原型构建分类器。因此,所提出的方法不需要原始数据的分布信息,从而有效地保护了隐私。

Giorgas等人提出了带采样的在线FL ( Online FL with Sampling,OFLwS )。在线FL ( OFL ) 的目标是利用额外的资源和训练样本,这些资源或者在中心节点,或者在边缘节点。OFL重复了多轮的 share-train-merge 过程。所提出的OFLwS建立在OFL的基础上,并对每个再训练步骤中使用的训练数据进行采样。

Chakraborty等人提出了一个两阶段FL模型。第一步,使用自动编码器对局部模型进行预训练。然后用深度学习模型重新训练这些局部模型。他们表明自动编码器预训练对于类别不平衡的FL模型是有用的。此外,他们针对FL模型中的严重类别不平衡数据集提出了一种自适应焦点损失。

4.3.4 Meta Learning Method

元学习,即学会学习,是伴随着模仿人类"学习能力"的期望而诞生的。在ML中,大量的数据被用来训练一个模型。然而,当场景发生变化时,训练好的模型可能需要重新训练。然而,对于人类来说,我们可以很容易地将先前获得的技能适应到看不见的场景中。元学习是这样一个框架,旨在使ML模型获得这样的能力:在现有"知识"的基础上学习新的任务。元学习也可以用于提高少数类在FL中的分类性能:将模型对多数类的已有知识适应到少数类中。

图9说明了元学习的核心思想,包括3个步骤:

1. 识别一个具有一组可学习参数(即,变量)的函数(例如,线性回归模型和神经网络);

2. 定义一个关于这些可学习参数的损失函数;

3. 寻找最优参数使损失函数最小化。

以上的整个过程可以看作是一个学习算法,这个过程的目标是找到一个具有一定参数的函数。学习算法本身可以看作一个函数,用F表示,它的输入是训练数据,输出是分类器(一个函数)。F通常是手工制作的,因此可以直接学习这个函数,即学习如何"学习"。

为了检测信用卡欺诈行为,Zheng等人提出了一种利用FL技术的元学习模型。为了实现小样本分类,他们提出了一种增强的三元组度量学习方法,称为深度K - tuplet网络。为了能够与每个小批量中的K个负样本进行联合比较,该网络专门概括了三联体网络。此外,他们还创建了一个基于K - tuple网络的FL模型,该模型可以保护数据隐私,同时允许FL模型与多家银行共享。这些解决FL中类不平衡问题的方法总结如表2所示。

4.4 对比分析

在这一部分中,我们比较了上面讨论的所有方法的特点,这些方法在数据分布估计完成后解决了类不平衡问题。表3给出了这些方法的优缺点。

5. 联邦学习性能评价

在这一部分中,首先介绍了传统ML中用于评估分类性能的度量指标。然后,我们介绍了用于评估考虑类不平衡问题的FL模型的性能指标。

5.1 模型评价分类性能的度量

模型评估对于我们确定任何ML模型的性能都是至关重要的。因此,选择合适的、具有指示性的评价指标对于理解ML模型具有重要意义,特别是考虑到许多模型的黑箱性质。混淆矩阵是评价一个分类模型性能好坏的核心指标之一,在此基础上可以衍生和计算许多其他指标:

- 真阳性( TP ):模型预测为正类的正样本数量。

- 假阳性( FP ):模型预测为正类的负样本数量。

- 真阴性( TN ):模型预测为负类的负样本数量。

- 假阴性( FN ):模型预测为负类的正样本数量。

FL需要不断迭代,因此需要展示每次迭代的分类性能,包括总体性能和在每个类中的分类性能。对于个性化解决方案,还需要显示每个参与者的分类性能和方差。

首先介绍了评价单类样本分类性能的度量指标。

精度被计算为真实正例在所有预测正例中的比例。它反映了一个模型对一个类别做出积极预测的准确性。它被表述为:

召回率被计算为真实肯定值在所有真实论据中的比例。它表示模型能够正确地找到多少个正样本。公式如下:

敏感度( sensitivity ),也称为真阳性率( true positive rate,TPR ),衡量的是属于正类的样本的分类准确率:

特异性,也称为真阴性率( TNR ),衡量的是属于阴性类别的样本的分类准确率:

假阳性率( false positive rate,FPR )描述假阳性的发生情况:

假阴性率( false negative rate,FNR )描述了假阴性的发生情况:

接下来,介绍用于评估所有样本整体分类性能的评价指标。

F1 score为精确率和召回率的调和平均值。计算平均F1 score为:

准确率反映了所有样本的分类精度:

有时,准确率也被称为top - 1准确率,因为模型的预测标签是从模型最终的softmax层中挑选出概率最高( top-1 )的类。

G-means 有全局地衡量正负样本的分类能力:

马修斯相关系数( Matthews correlation coefficient , MCC )综合评价分类能力:

The receiver operating characteristics ( ROC )曲线将TPR映射为FPR。ROC曲线下面积( Area Under the ROC Curve,AUC )的值为ROC曲线下面积的大小。面积越大,模型分类越准确。一般分类器的AUC值在0.5 ~ 1:0.5之间表示模型的判别能力与随机猜测没有差异;1表示模型是完全准确的。

5.2 类不平衡联邦学习模型的分类性能评价

对类别不平衡FL模型的评价通常基于上面讨论的度量指标。然而,为了全面了解FL模型的性能,从不同角度对FL模型的性能进行评估是至关重要的。

训练和测试性能(Training and testing performance)。ML模型的开发通常分为训练( +验证)和测试阶段。FL模型也是如此。为了理解FL模型,需要对这两个阶段的模型性能进行评估。虽然模型在训练阶段和测试阶段的性能稍有差异是正常的,但这两个阶段的性能相似通常表明一个训练有素的模型对看不见的数据具有很好的泛化能力。训练过程中的高性能与测试数据上的低性能可能反映了过拟合的风险。

全局和客户端性能(Global and client performance)。通过聚合FL中所有客户端模型得到的全局模型可能与每个客户端模型具有不同的性能。因此,需要评估模型在服务器端(在整体测试集上的表现)和每个客户端(在客户端的本地训练集或测试集上的表现)的性能。特别地,在个性化FL框架中,会产生多个局部模型,因此需要评估每个用户的局部模型的性能。

多数类和少数类的性能(Majority class and minority class performance)。对于类别不平衡问题,需要显示每个类别的分类性能,尤其是那些少数类。

迭代性能(Iteration performance)。FL模型的训练需要多次迭代。因此,跟踪每次迭代后的模型性能和全局模型收敛所需的训练轮数是有用的。

6. 挑战和未来方向

尽管为解决FL的类失衡问题已经开展了广泛的研究,但仍存在各种开放性挑战,需要在未来加以解决。在这一部分中,我们讨论了这些开放的挑战,并指出了该领域未来可能的发展方向。

隐私保护(Privacy protection)。虽然FL中客户端的数据并不与中心服务器共享,但恶意服务器通过客户端上传的模型,在有无额外协助的情况下重构客户端的私有数据,仍然存在潜在的风险。在FL中保护用户隐私的现有解决方案包括差分隐私,安全多方计算和同态加密( HE ) 。HE允许直接在密文上进行计算,并在FL框架中被广泛采用,以保护客户的隐私。HE可以直接连接到现有的FL解决方案中。例如,Paillier是一个已经建立的密码系统,已经在FL系统中实现,最著名的是FATE。HE的缺点是当模型参数数量巨大时,增加了传输和加密成本。

有鉴于此,最近的研究表明,FL中客户隐私的保护仍然是可以被泄露的。造成这个的主要原因之一是通过模型参数(例如,梯度),这可能会将敏感信息泄露给恶意敌手,造成深度隐私泄露。正如文献所报道的那样,原始梯度中的一小部分可能会泄露关于局部训练数据集的隐私。为了解决类不平衡问题,本文讨论的许多现有方法需要访问客户端局部模型的梯度,而在一定程度上忽略了用户隐私暴露的风险。因此,如果FL能够进一步利用同态加密或差分隐私技术,通过"加密"梯度来保护用户隐私,同时解决类别不平衡问题,将是有趣的。

动态(Dynamic)。大多数联邦学习方法通常被建模为静态应用场景,其中整个联邦学习框架的数据类是固定的和预先确定的。然而,实际应用程序通常是动态的,每天都会生成新数据。现有的联邦学习方法通常需要将旧类的所有训练数据存储在客户端,但是当新类动态出现时,高昂的存储和计算成本可能会使联邦学习变得不现实。此外,如果这些方法需要在非常有限的存储内存下连续学习新类,那么它们在旧类中可能会遭受显著的性能下降(即灾难性的遗忘)。最后,在实际场景中,以流式方式收集新类数据的新客户端可能希望参与联邦学习训练,这可能会进一步加剧全局模型训练中对旧类的灾难性遗忘。因此,对于社区来说,提出处理动态现实世界场景的解决方案将是很有趣的。

数据漂移(Data shift)。概念转移是指由于客户的个人偏好,不同的客户为相似的数据样本分配了不同的标签。这样的场景在实际应用中很常见,尤其是来自所有客户端的训练数据都是水平重叠的,例如图像识别、智能键盘和推荐系统,仅举几例。举个例子,当联邦学习用于使用不同人群提供的数据来训练推荐系统时,如果不同的参与人群具有不同的文化背景和不同的偏好,就会发生概念转变。Crowd-sourced是一种更复杂的情况,数据标签可能会产生干扰,这给许多传统的集中式ML任务中的信息收集带来了重大挑战,更不用说联邦学习任务了。例如,一些客户端只有未标记的数据,并且需要由几个不同的人标记数据。因此,某些标签通常不准确、嘈杂甚至缺失。在这种情况下,联邦学习可能无法给出一个可以适应所有客户端数据分布的全局模型。

局部模型与全局模型的关系(Relation between local models and global model)。在FL中,为了获得全局模型的高精度,保持所有客户数据集之间的多样性是非常重要的。研究发现,将大量类别多样性较小的数据分布在一些客户端中会导致全局模型精度较低,而将少量类别多样性较大的数据分布在一些客户端中可以获得较高的全局性能。这是因为在每个FL训练过程中,每个客户端都可以协作地完成他们的数据样本。因此,调整客户端的局部不平衡可能会损害客户端之间的多样性,从而降低全局模型的性能。然而,如果局部不平衡和全局不平衡之间存在显著的不匹配,FL模型的有效性就会降低。这对全局模型在保持每个客户端良好分类性能的同时,对少数类保持良好的分类性能提出了挑战。此外,探索局部不平衡、全局不平衡和误匹配不平衡之间的关系,以及三类类别不平衡对测试数据集和客户局部数据集分类性能的影响也是非常重要的。

鉴于上述在类不平衡FL中的挑战,建议未来的方向如下:

- 在解决类不平衡问题的同时,需要进一步保护客户端的隐私。目前的方法大多需要用户上传梯度等明文参数,仍然会泄露用户隐私;

- 在处理动态类别不平衡数据时,如何保证旧类的分类性能是一个亟待解决的问题;

- 对于一些FL应用,客户端之间的概念漂移现象为类不平衡问题增加了另一个维度:客户端之间的标签不仅是倾斜的,而且是不一致的和有噪声的。这就需要FL方法能够容纳客户端的不同偏好,同时解决类别不平衡问题;

- 不同客户端拥有的局部数据集可能包含冲突模式。因此,为一个客户获得一个高性能的局部模型有时并不一定能得到一个高性能的全局模型。因此,提出在全局模型和每个客户端的局部模型之间取得平衡的方法将是有趣的。

7. 结论

本文对类不平衡的FL进行了系统的概述。介绍了FL系统中的各种类型的类不平衡,并对现有的处理类不平衡数据的技术进行了全面的总结。首先对FL中的类别不平衡数据进行了详细的分类,然后对所提出的类别分布估计方法进行了回顾。然后,对FL中处理类别不平衡数据的现有工作进行了全面的回顾。进一步给出了用于评估所述方法的度量指标。最后,讨论了该领域仍然存在的挑战,并提出了解决这些开放性问题的一些研究方向。

948

948

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?