联邦学习架构:客户端层,骨干层,FL任务层

FL任务层:模型所有者每次只发布一个任务,模型在无人机上进行训练,生成原始数据,然后,在不泄露原始数据的情况下,将本地更新的模型参数传输给模型所有者进行聚合。在集中平台进行参数聚合后,更新后的全局模型响应无人机进行下一轮训练,直到收敛到目标。

骨干层:由无人机簇头组成,每个簇头充当集群的中央聚合服务器,在集群内聚合和更新训练模型;并且执行集群间交互来聚合中间训练结果。本文直接选择了资源较多的节点作为簇头(感觉是不是可以从能量,信任度来考虑簇头的选择问题)

客户端层:对于每个集群,数据可以被认为是同构的,可以将全局优化问题看作针对多个聚类的联合优化问题。其中CFL包括:

- 工人通过下载最后一轮模型w来将任务与簇头h同步

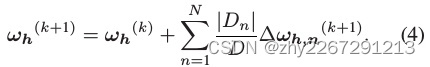

- 无人机进行随机梯度下降来执行多次迭代,tig奥中间模型的性能

![]()

- 簇头h聚合集群内参与者的局部参数,更新新的中间模型

每隔k,簇头发送中间模型参数,模型所有者进行全局聚合,如果不满足训练目标,则将中间模型打回重新进行局部训练。

系统模型:作为任务发布者,模型所有者的目标是通过k迭代 训练模型,使全局损失函数L(w)最小化,其中w表示全局模型参数。

无人机:每个worker都有本地数据样本来说参与Dn![]() 来参与聚类联邦学习任务,簇头h的支付取决于相应worker的数据贡献。数据贡献可以定义为Pn=DnD

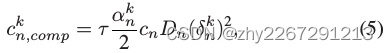

来参与聚类联邦学习任务,簇头h的支付取决于相应worker的数据贡献。数据贡献可以定义为Pn=DnD ,考虑到一个集群内的学习过程消耗的计算资源,计算成本可以表示为

,考虑到一个集群内的学习过程消耗的计算资源,计算成本可以表示为

(τ表示一次迭代k期间的轮数,cn表示能量消耗的单位成本。αnk

本文探讨了在联邦学习中,通过构建客户端、骨干和任务层的架构,利用无人机进行分布式训练。通过Stackelberg博弈模型优化集群效率,解决数据异构和隐私保护问题。实验结果显示,提出的多方博弈辅助CFL架构在资源有限的动态环境中表现优秀。

本文探讨了在联邦学习中,通过构建客户端、骨干和任务层的架构,利用无人机进行分布式训练。通过Stackelberg博弈模型优化集群效率,解决数据异构和隐私保护问题。实验结果显示,提出的多方博弈辅助CFL架构在资源有限的动态环境中表现优秀。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1158

1158

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?