2024年12月,未来生命研究所(Future of Life Institute)发布了第一份《人工智能安全指数报告》(FLI AI Safety Index 2024),共80页。该报告由图灵奖得主 Yoshua Bengio、加州大学伯克利分校计算机科学教授 Stuart Russell 等7位全球顶尖AI专家组成的独立评审小组,评估6家主流 AI 公司(Anthropic、Google DeepMind、Meta 、OpenAI、x.AI、智谱)在六大领域的安全实践,包括风险评估、现有危害、安全框架、存在性安全战略、治理与问责以及透明度与沟通。

报告指出了公司在管理风险上的巨大差异,并呼吁加强第三方监督及改进当前的治理结构,以应对当前及潜在的AI风险。

报告链接:https://futureoflife.org/document/fli-ai-safety-index-2024/

报告显示,尽管 Anthropic 获得了最高的安全性评级,但分数仅为“C”,包括 Anthropic 在内的 6 家公司在安全实践方面仍有提升空间。

PART.01

主要发现

-

风险管理差距显著:尽管一些公司已经建立了初步的安全框架或开展了一些严肃的风险评估工作,但其他公司甚至尚未采取最基本的预防措施。

-

绕过限制(Jailbreaks):所有旗舰模型都被发现易受对抗性攻击的影响。

-

控制问题:尽管许多公司明确表达了开发人工通用智能(AGI)的雄心,这种智能能够媲美或超越人类智能,但评审小组认为,目前所有公司的策略都不足以确保这些系统在安全范围内运行并保持在人类控制之下。

-

外部监督:评审人员一致指出,在缺乏独立监督的情况下,公司往往难以抵抗逐利动机而在安全方面偷工减料。尽管 。Anthropic 目前的治理结构和OpenAI初期的治理结构被视为具有前景的案例,但专家呼吁对所有公司的风险评估和安全框架合规性进行第三方验证。

PART.02

6 大维度评估 AI 安全

评审专家从风险评估(Risk Assessment)、当前危害(Current Harms)、安全框架(Safety Frameworks)、生存性安全策略(Existential Safety Strategy)、治理和问责制(Governance & Accountability)以及透明度和沟通(Transparency & Communication)分别对每家公司进行评估,最后汇总得出安全指数总分。

在指数设计上,6 大评估维度均包含多个关键指标,涵盖企业治理政策、外部模型评估实践以及安全性、公平性和鲁棒性的基准测试结果。

01

维度 1:风险评估

-

OpenAI、Google DeepMind 和 Anthropic 因在识别潜在危险能力(如网络攻击滥用或生物武器制造)方面实施更严格的测试而受到肯定。然而,报告也指出,这些努力仍存在显著局限,AGI 的相关风险尚未被充分理解。

-

OpenAI 的欺骗性能力评估和提升研究获得了评审专家的关注;Anthropic 则因与国家人工智能安全机构的深度合作被认为表现尤为突出。

-

Google DeepMind 和 Anthropic 是仅有的两家维持针对模型漏洞的专项漏洞奖励计划的公司。

-

Meta 尽管在模型部署前对危险能力进行了评估,但对自治、谋划和说服相关威胁模型的覆盖不足。

-

智谱的风险评估相对不够全面,而 x.AI 在部署前的评估几乎缺失,大幅低于行业标准。

02

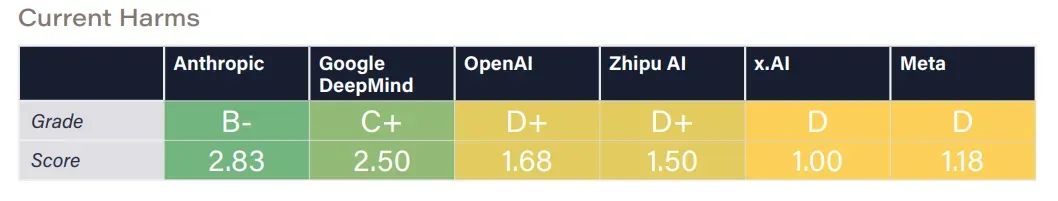

维度 2: 当前危害

-

Anthropic 的人工智能系统在安全性与信任度基准测试中得到了最高分,Google DeepMind 紧随其后,该公司的 Synth ID 水印系统被认可为减少人工智能生成内容滥用的最佳实践。

-

其他公司得分偏低,暴露出安全缓解措施的不足。例如,Meta 因公开前沿模型权重被批评,该做法可能被恶意行为者利用来移除安全防护。

-

此外,对抗性攻击仍是一个主要问题,多数模型易受越狱攻击,其中 OpenAI 的模型尤为脆弱,而 Google DeepMind 在此方面防御表现最佳。

-

评审专家还指出,只有 Anthropic 和 智谱 在默认设置下避免将用户交互数据用于模型训练,这一实践值得其他公司借鉴。

03

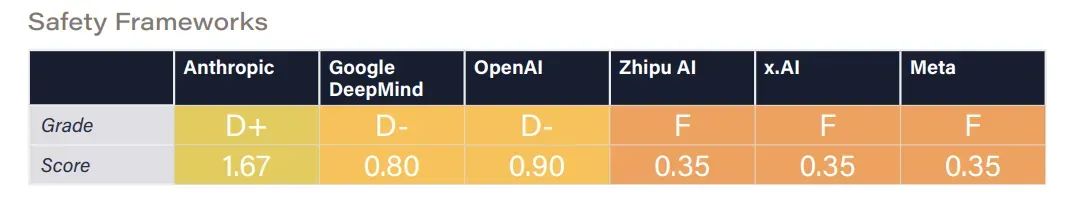

维度 3:安全框架

-

所有 6 家公司均签署了《前沿人工智能安全承诺》,承诺制定安全框架,包括设置不可接受风险阈值、高风险场景下的高级防护措施,以及在风险不可控时暂停开发的条件。

-

然而,截至本报告发布,仅有 OpenAI、Anthropic 和 Google DeepMind 公布了相关框架,评审专家仅能对这三家公司进行评估。其中,Anthropic 因框架内容最为详尽而受到认可,其也发布了更多实施指导。

04

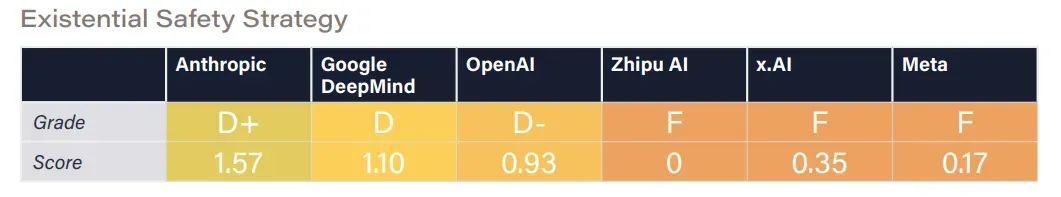

维度 4:生存性安全策略

-

尽管所有公司均表示有意开发 AGI 或超级人工智能(ASI),并承认此类系统可能带来的生存性风险,但仅有 Google DeepMind、OpenAI 和 Anthropic 在控制与安全性方面开展了较为严肃的研究。

-

Anthropic 凭借其详尽的 “Core Views on AI Safety” 博客文章获得最高分,但专家认为其策略难以有效防范超级人工智能的重大风险。

-

OpenAI 的 “Planning for AGI and beyond” 博客文章则仅提供了高层次原则,虽被认为合理但缺乏实际计划,且其可扩展监督研究仍不成熟。

-

Google DeepMind 的对齐团队分享的研究更新虽有用,但不足以确保安全性,博客内容也不能完全代表公司整体战略。

-

Meta、x.AI 和智谱尚未提出应对 AGI 风险的技术研究或计划。评审专家认为,Meta 的开源策略及 x.AI 的 “democratized access to truth-seeking AI” 愿景,可能在一定程度上缓解权力集中和价值固化的风险。

05

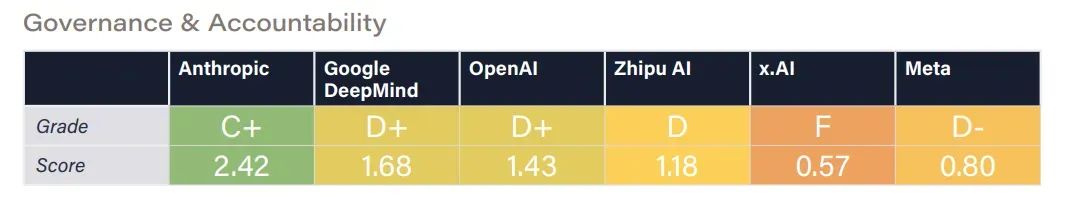

维度 5:治理和问责制

-

Anthropic 的创始人在建立负责任的治理结构方面投入了大量精力,这使其更有可能将安全放在首位。Anthropic 的其他积极努力,如负责任的扩展政策,也得到了积极评价。

-

OpenAI 最初的非营利结构也同样受到了称赞,但最近的变化,包括解散安全团队和转向营利模式,引起了人们对安全重要性下降的担忧。

-

Google DeepMind 在治理和问责方面迈出了重要一步,承诺实施安全框架,并公开表明其使命。然而,其隶属于 Alphabet 的盈利驱动企业结构,被认为在一定程度上限制了其在优先考虑安全性方面的自主性。

-

Meta 虽然在 CYBERSEC EVAL 和红队测试等领域有所行动,但其治理结构未能与安全优先级对齐。此外,开放源代码发布高级模型的做法,导致了滥用风险,进一步削弱了其问责制。

-

x.AI 虽然正式注册为一家公益公司,但与其竞争对手相比,在人工智能治理方面的积极性明显不足。专家们注意到,该公司在关键部署决策方面缺乏内部审查委员会,也没有公开报告任何实质性的风险评估。

-

智谱作为一家营利实体,在符合法律法规要求的前提下开展业务,但其治理机制的透明度仍然有限。

06

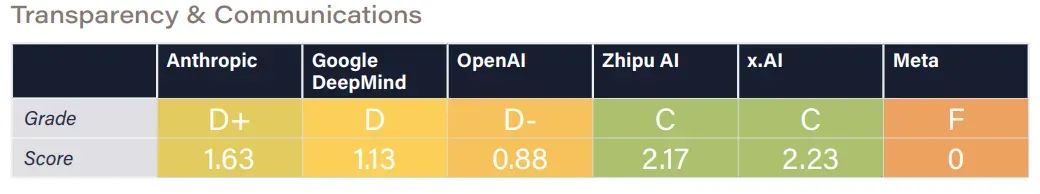

维度 6:透明度和沟通

-

评审专家对 OpenAI、Google DeepMind 和 Meta 针对主要安全法规(包括 SB1047 和欧盟《人工智能法案》)所做的游说努力表示严重关切。与此形成鲜明对比的是,x.AI 因支持 SB1047 而受到表扬,表明了其积极支持旨在加强人工智能安全的监管措施的立场。

-

除 Meta 公司外,所有公司都因公开应对与先进人工智能相关的极端风险,以及努力向政策制定者和公众宣传这些问题而受到表扬。

-

x.AI 和 Anthropic 在风险沟通方面表现突出。

-

Anthropic 不断支持促进该行业透明度和问责制的治理举措。

-

Meta 公司的评级则受到其领导层一再忽视和轻视与极端人工智能风险有关的问题的显著影响,评审专家认为这是一个重大缺陷。

-

专家们强调,整个行业迫切需要提高透明度。x.AI 缺乏风险评估方面的信息共享被特别指出为透明度方面的不足。

-

Anthropic 允许英国和美国人工智能安全研究所对其模型进行第三方部署前评估,为行业最佳实践树立了标杆,因此获得了更多认可。

如何学习AI大模型 ?

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。【保证100%免费】🆓

CSDN粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传CSDN,朋友们如果需要可以扫描下方二维码&点击下方CSDN官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉CSDN大礼包:《最新AI大模型学习资源包》免费分享 👈👈

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

👉1.大模型入门学习思维导图👈

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

对于从来没有接触过AI大模型的同学,我们帮你准备了详细的学习成长路线图&学习规划。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。(全套教程文末领取哈)

👉2.AGI大模型配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。

👉3.大模型实际应用报告合集👈

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(全套教程文末领取哈)

👉4.大模型落地应用案例PPT👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(全套教程文末领取哈)

👉5.大模型经典学习电子书👈

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(全套教程文末领取哈)

👉6.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(全套教程文末领取哈)

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习

CSDN粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传CSDN,朋友们如果需要可以扫描下方二维码&点击下方CSDN官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉CSDN大礼包:《最新AI大模型学习资源包》免费分享 👈👈

1123

1123

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?