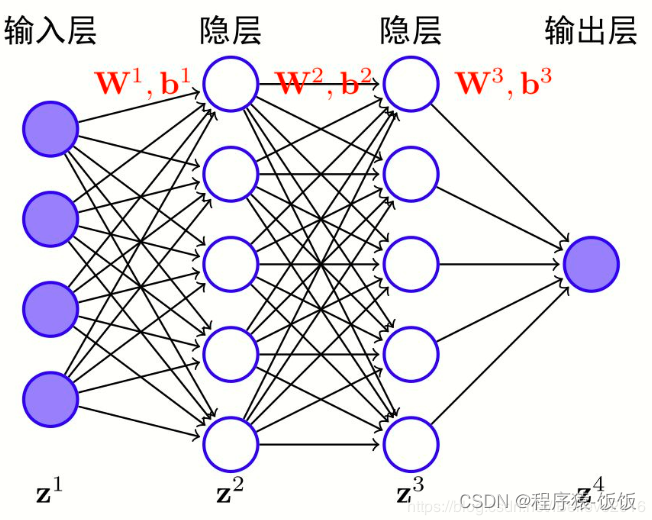

激活函数在神经网络中起着至关重要的作用,它们引入非线性性质,帮助神经网络模型更好地逼近复杂的非线性函数关系。本文将介绍神经网络中常见的激活函数,并探讨如何选择适合的激活函数以提高模型性能和训练效率。

神经网络中的激活函数有哪些?

-

Sigmoid激活函数:

- Sigmoid函数将输入映射到[0, 1]的区间,适合处理二分类问题。然而,Sigmoid函数在输入较大或较小的情况下容易饱和,导致梯度消失的问题。

-

Tanh激活函数:

- Tanh函数将输入映射到[-1, 1]的区间,是Sigmoid函数的变体。它解决了Sigmoid函数的饱和问题,但仍然存在梯度消失的问题。

-

ReLU激活函数:

- ReLU函数在输入大于0时返回输入值,否则返回0。它克服了Sigmoid和Tanh函数的饱和和梯度消失问题,且计算速度快。然而,ReLU函数在输入小于0时会失去激活,称为“神经元死亡”问题。

-

Leaky ReLU激活函数:

- Leaky ReLU函数在输入小于0时引入一个小的斜率,以避免ReLU函数的神经元死亡问题。

-

ELU激活函数:

- ELU函数在输入小于0时引入一个较小的斜率,并且在输入大于0时是线性的。ELU函数相对于Leaky ReLU函数具有更平滑的曲线。

-

Softmax激活函数:

- Softmax函数常用于多分类问题,将输出转化为概率分布。它对输入进行归一化,使得所有类别的输出概率之和为1。

如何选择适合的激活函数:

- 对于多层感知机(MLP)和卷积神经网络(CNN)等常见网络结构,ReLU函数是一个常用的默认选择,因为它相对简单且有效。

- 如果模型存在梯度消失问题,可以尝试使用ReLU的变体,如Leaky ReLU或ELU函数。

- 对于输出层的二分类问题,使用Sigmoid函数;对于多分类问题,使用Softmax函数。

- 在实际应用中,可以通过实验和交叉验证来选择最适合特定任务和数据集的激活函数。

-

感谢大家对文章的喜欢,欢迎关注威

❤公众号【AI技术星球】回复(123)

白嫖配套资料+60G入门进阶AI资源包+技术问题答疑+完整版视频

内含:深度学习神经网络+CV计算机视觉学习(两大框架pytorch/tensorflow+源码课件笔记)+NLP等

本文介绍了神经网络中常见的激活函数,包括Sigmoid、Tanh、ReLU、Leaky ReLU、ELU和Softmax函数。对于不同的问题和网络结构,选择适合的激活函数非常重要。ReLU是一个常用的默认选择,但也可以根据具体情况尝试其他激活函数来解决梯度消失、神经元死亡等问题。在实际应用中,可以通过实验和交叉验证来选择最合适的激活函数,以提高模型性能和训练效率。

459

459

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?