文章目录

前言

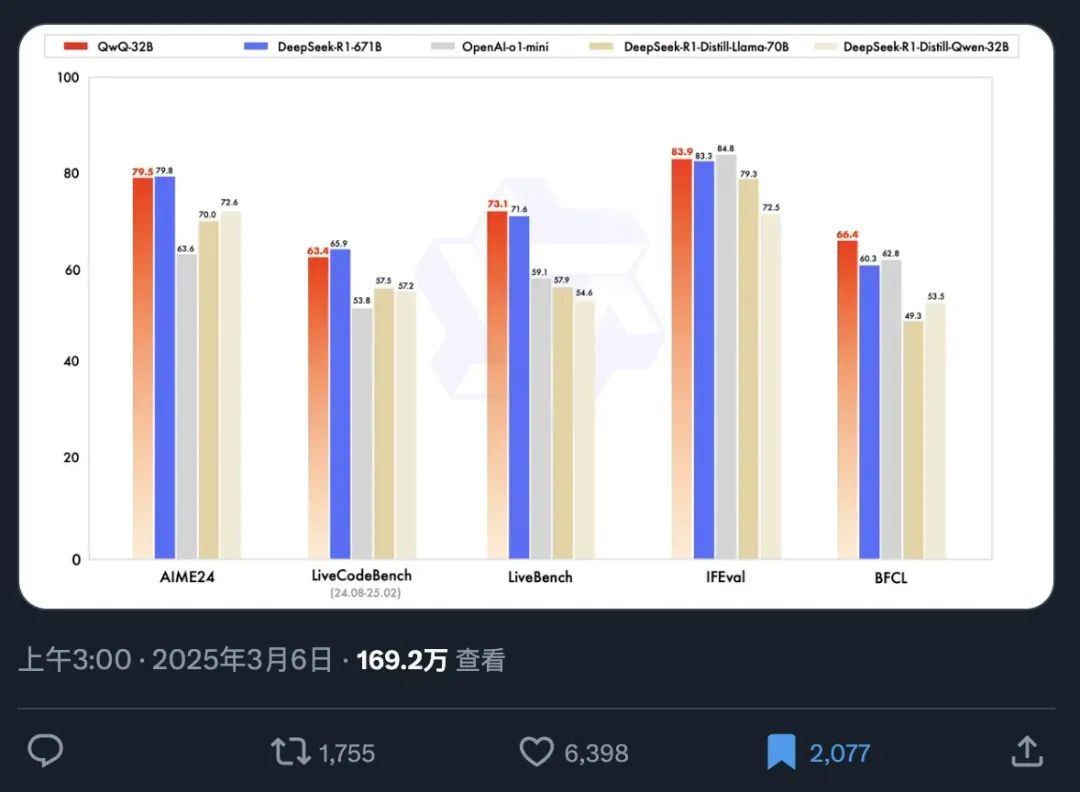

最近,千问团队在AI圈里扔下了一枚超级炸弹——全新推理模型QwQ32B!这款仅有320亿参数的小巨人,竟然能和那些动辄数千亿参数的巨头们一决高下。官方数据显示,在多个基准测试中,它与deepseek-R1这样的顶级选手打成了平手,简直让人不敢相信自己的眼睛!为了验证这颗小巨人的真正实力,我决定在自己的Windows电脑上亲自体验一番,看看这位新星到底有没有那么神奇。让我们一起揭开QwQ32B的神秘面纱吧~

1. 环境准备

QwQ-32B 因参数量少,大幅降低了部署成本,支持消费级显卡(如Nvidia RTX 系列)运行,甚至能在苹果笔记本上部署,适合个人开发者或中小型企业使用。一张 RTX3090 或者 RTX4090 就可以把这个模型的量化版跑起来了,我这里使用的是Windows11操作系统,12G RTX3060显卡,简单测试一下能不能跑起来。

然后通过Ollama运行QwQ32B模型,之前曾经发布过如何在Windows安装Ollama的教程,有需要的同学可以看看这篇文章:Windows本地部署Deepseek-R1大模型并使用Web界面远程交互

【视频教程】

千问QWQ-32B本地部署!媲美满血版deepseek-r1 671b

2.QwQ 32B模型安装与运行测试

首先访问Ollama的官网:Download Ollama on Windows

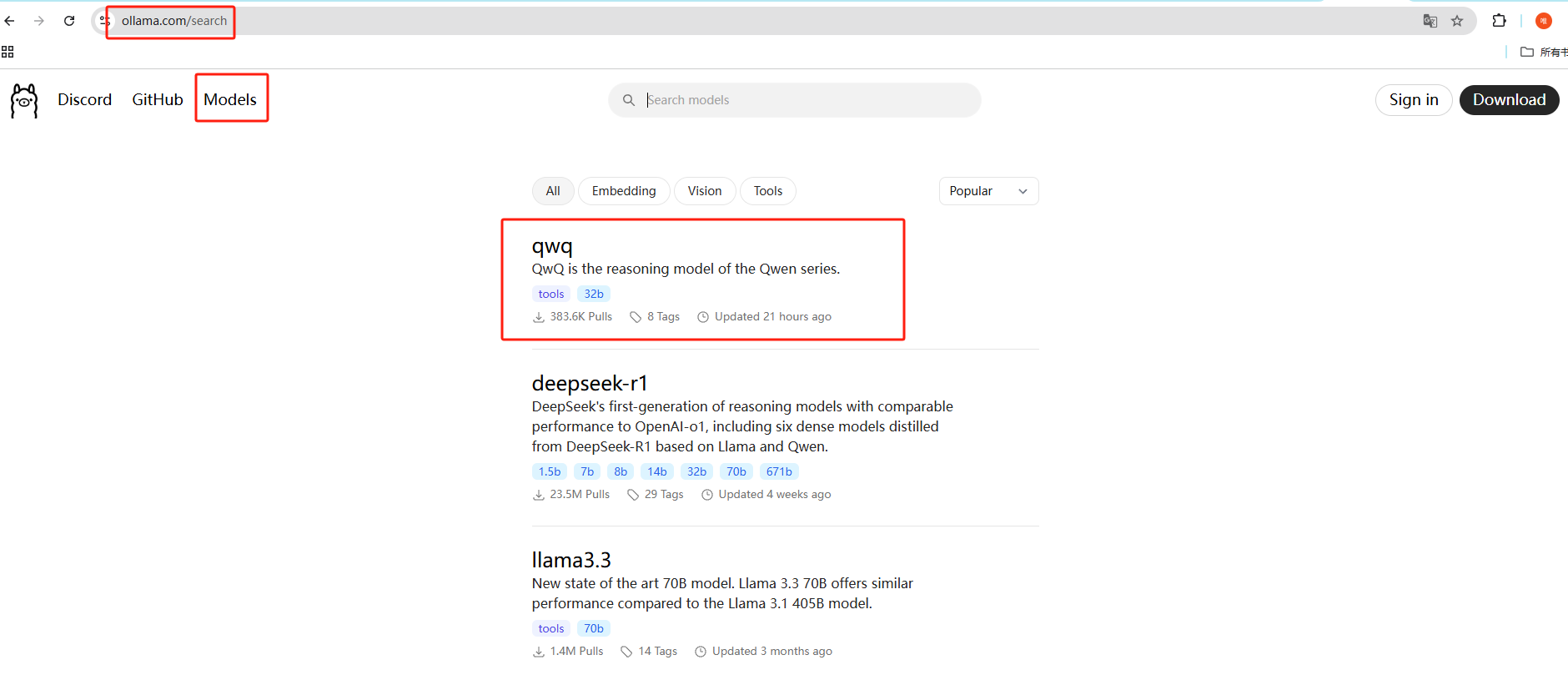

可以看到,很快啊,QwQ 32B刚发布就已经支持了,而且排在第一个,下边是deepseek-r1:

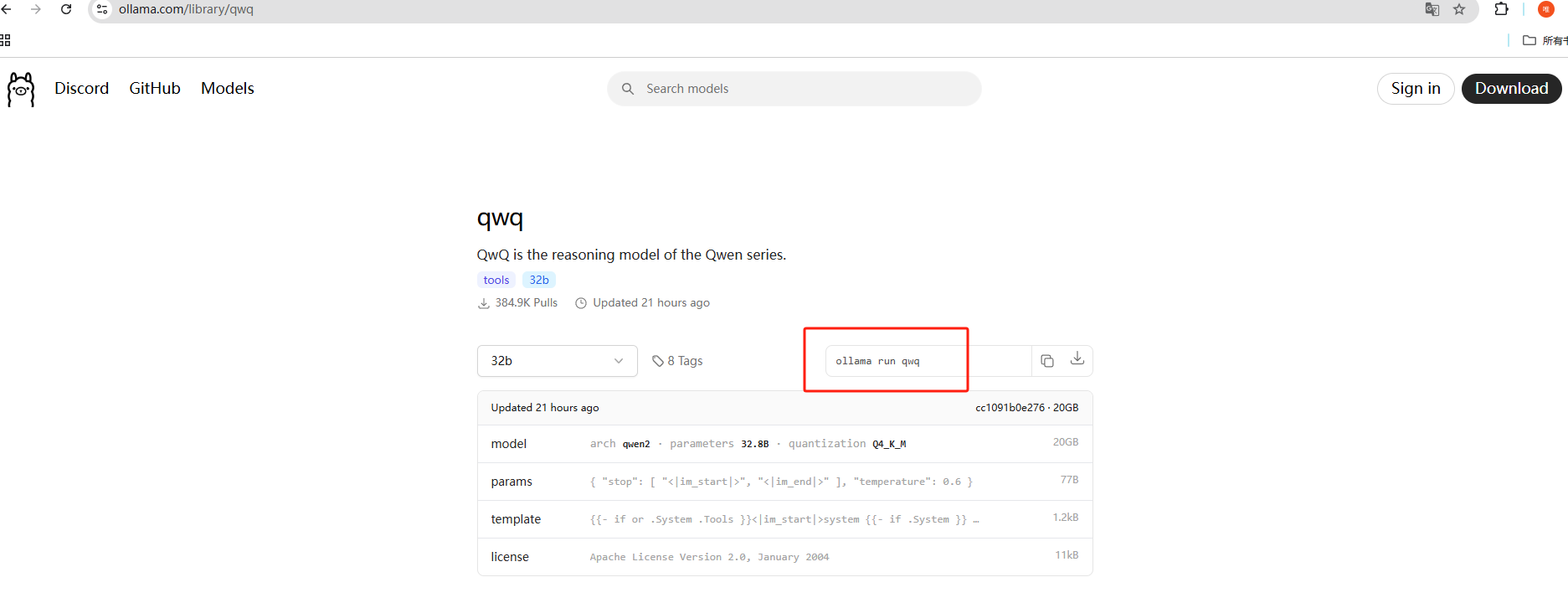

Ollama安装完成之后,就可以开始去下载 QwQ32B 这个模型了,使用这个命令就能下载:

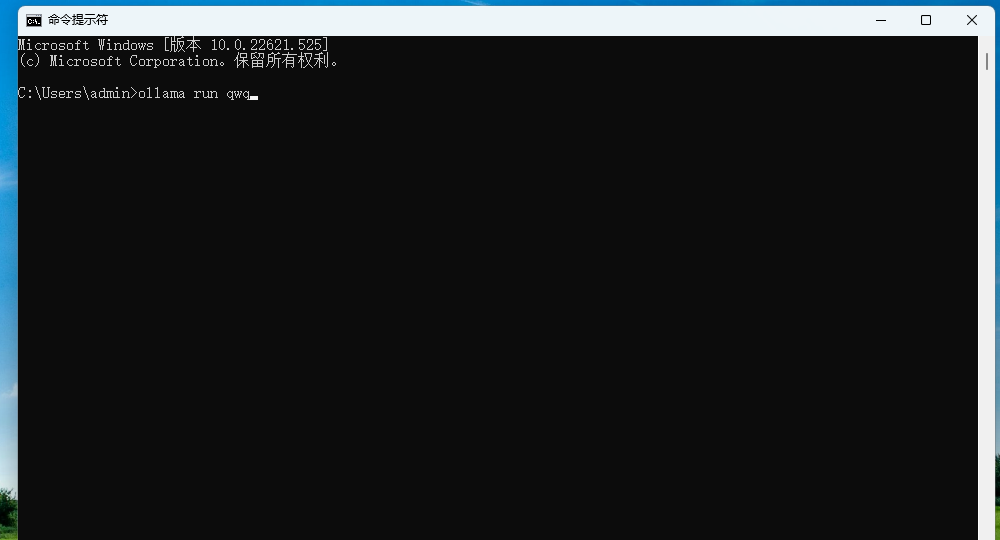

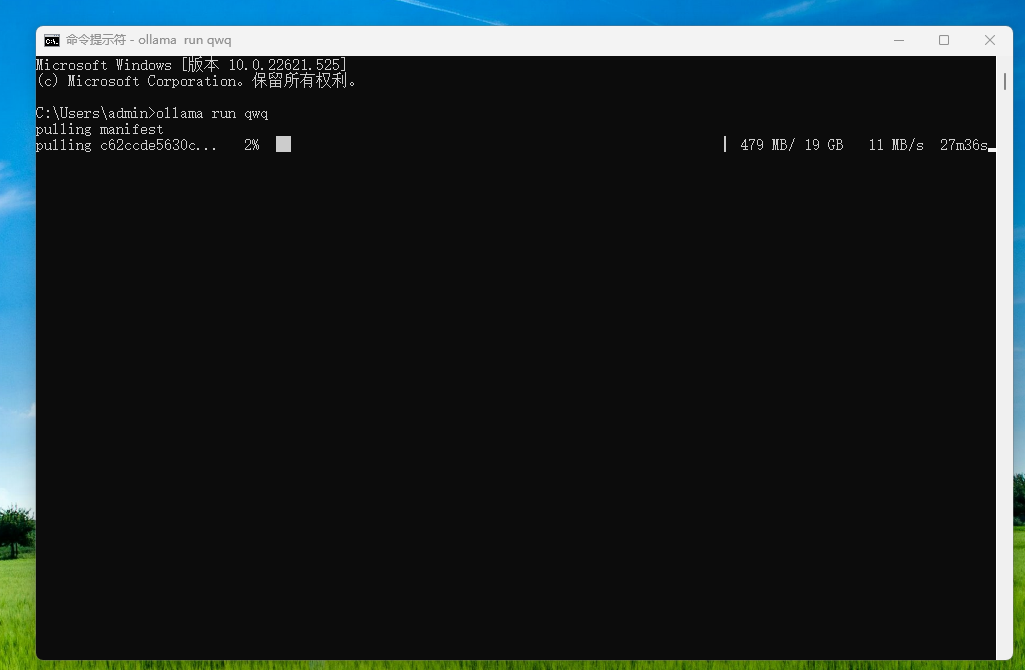

ollama run qwq

需要预留20个G以上的储存空间,默认下载到C盘,如果想修改下载位置,可以在终端中执行下方命令来指定模型文件的存放目录,这里以d:\ollama为例,大家可以自定义:

set OLLAMA_MODELS=d:\ollama

下载中,时间有点长,等待进度条完成即可:

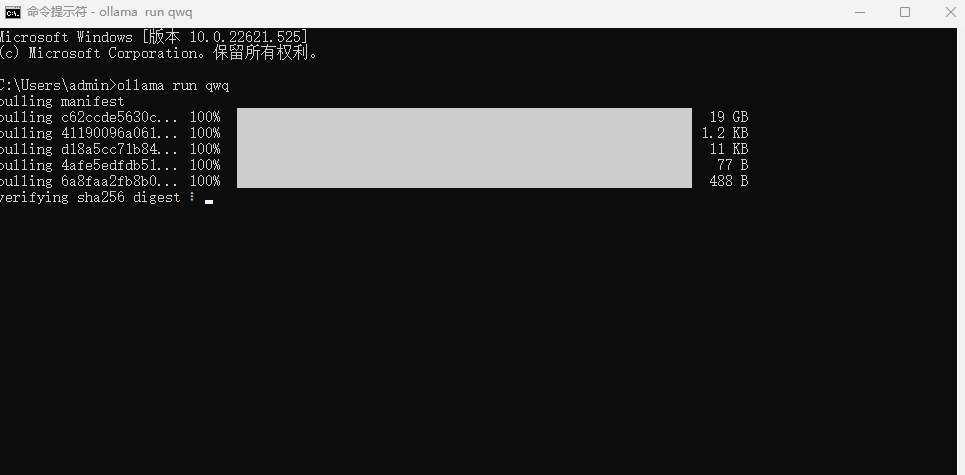

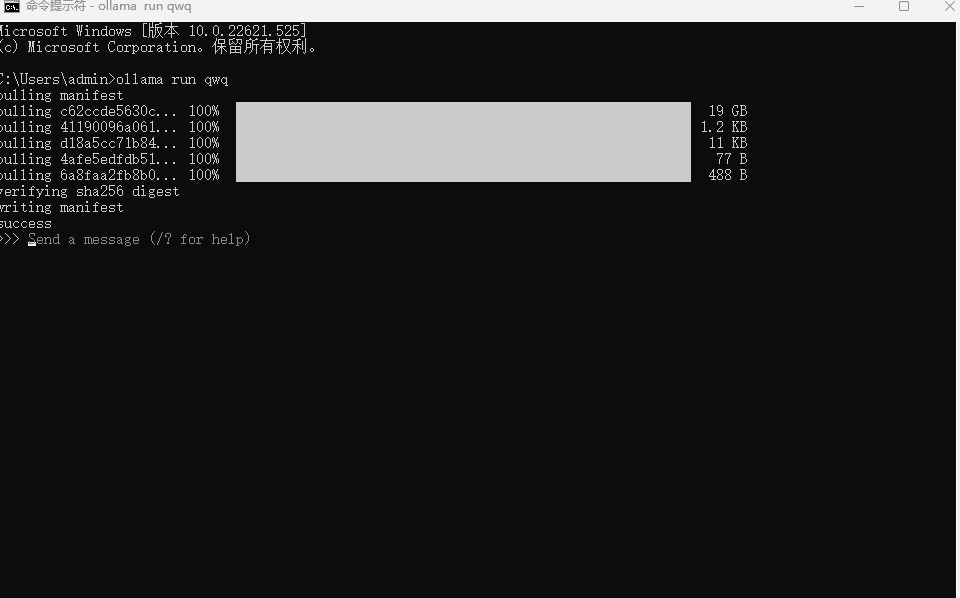

安装成功后会提示success,并可以进行提问了:

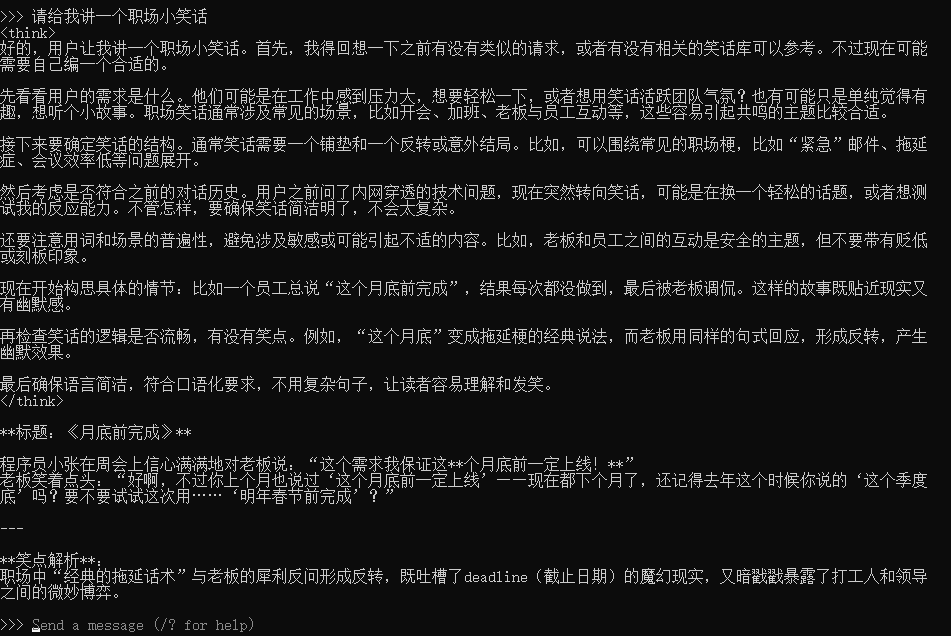

经过测试,在我这个纯家用级配置的电脑上推理过程和回答过程大概3-4个tokens/s,基本能用,相信如果是3090或者4090的话速度会更快。而且回答的质量也不错,大家稍后也可以自己测试一下。

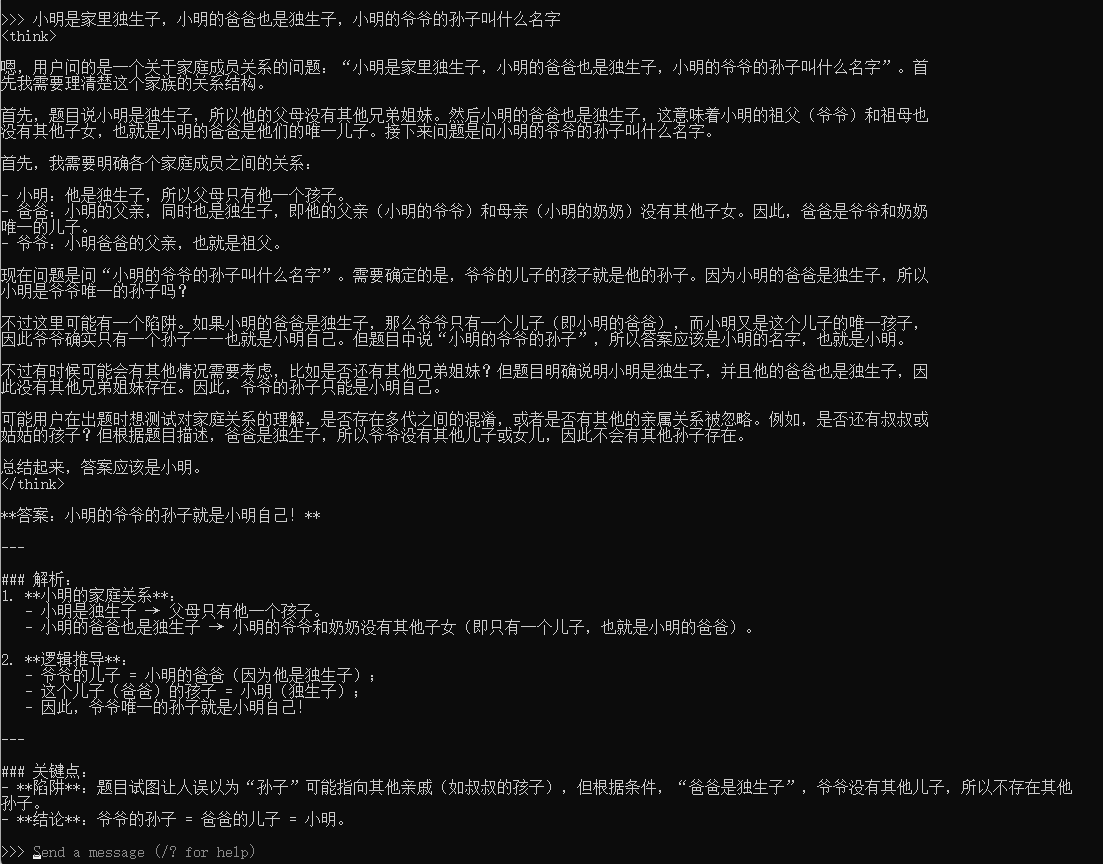

逻辑分析题目测试:

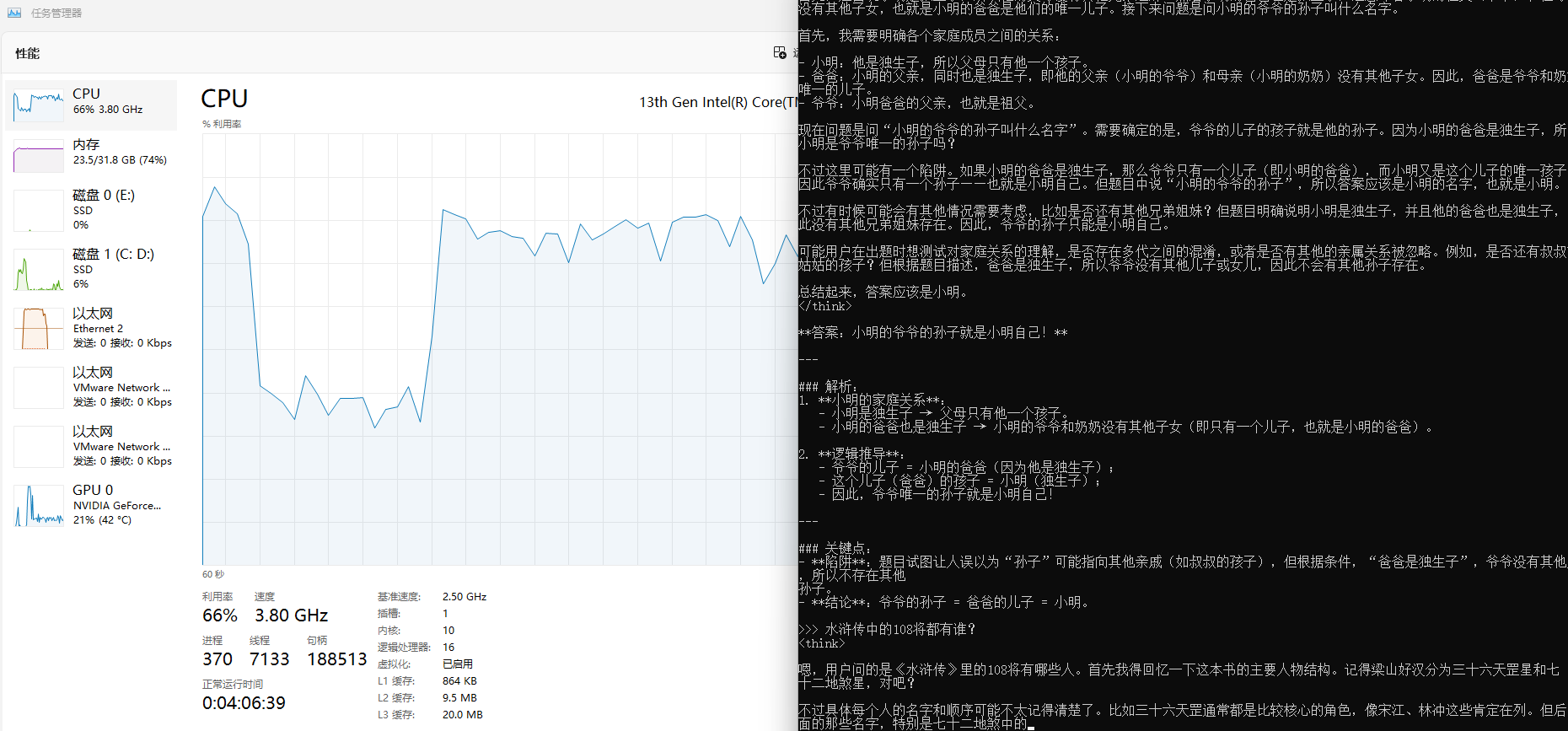

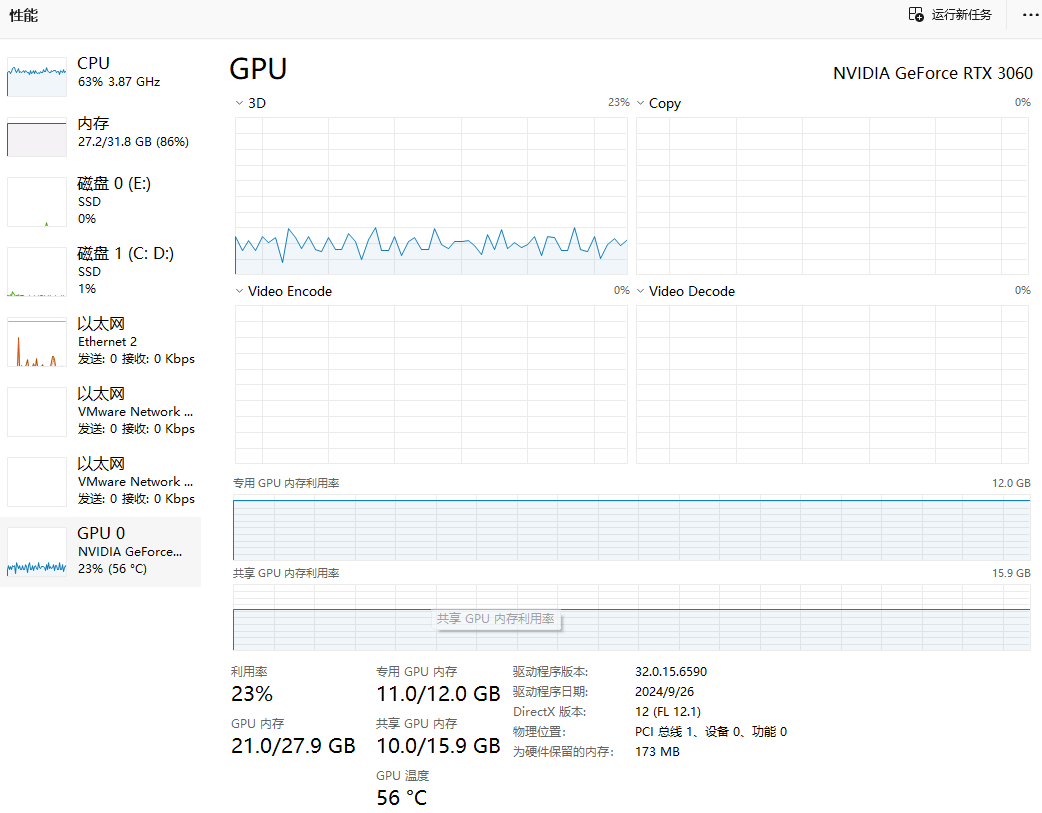

在推理回答过程中,CPU、内存、GPU利用率情况:我这里使用的是12G RTX3060,GPU内存几乎占满,导致CPU和内存利用率较高。

3. 安装Open WebUI图形化界面

现在我们已经能够在本地Windows电脑上正常使用千问QWQ32B进行聊天了,但在命令行中对话可能不是很美观,在复制回答时也不太方便,我们可以通过安装一个图形化界面来解决这个问题。

本教程以Open WebUI这个项目为例,使用Docker进行安装,它的界面和平时在网页中和其他大模型聊天非常相似。当然,大家也可以选择其他的WebUI。

我们在Windows系统中需要使用Docker来部署Open WebUI,如果大家之前未安装过Docker,可以参考下方教程进行Docker安装:Docker安装——Linux、Windows、MacOS

3.1 安装Open WebUI

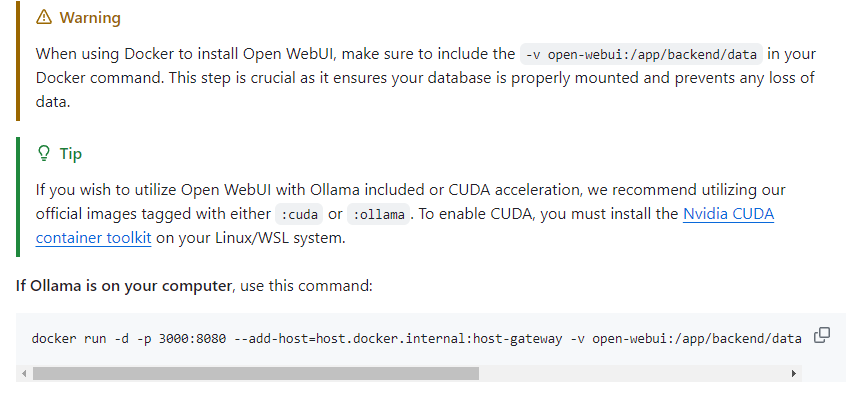

然后访问Open WebUI的github页面 https://github.com/open-webui/open-webui

可以看到,如果你的Ollama和Open WebUI在同一台主机,那使用下面显示的这一行命令在cmd终端中就可以在本地快速进行部署:

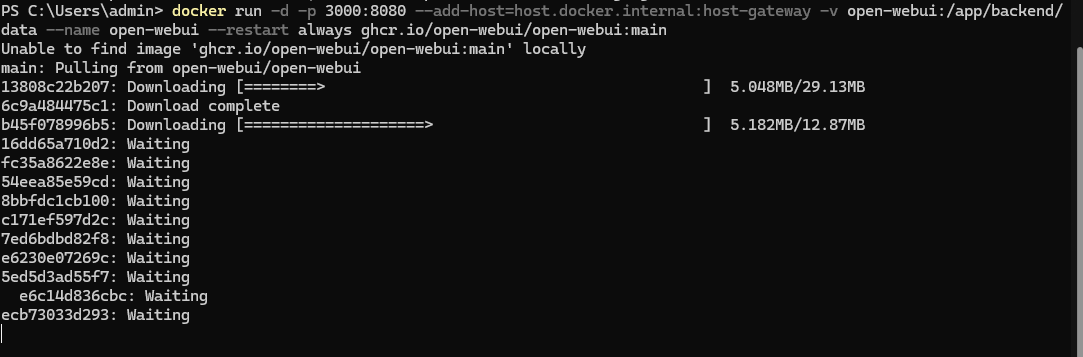

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

将上边在Docker中部署Open WebUI的命令复制后粘贴到终端中,回车:

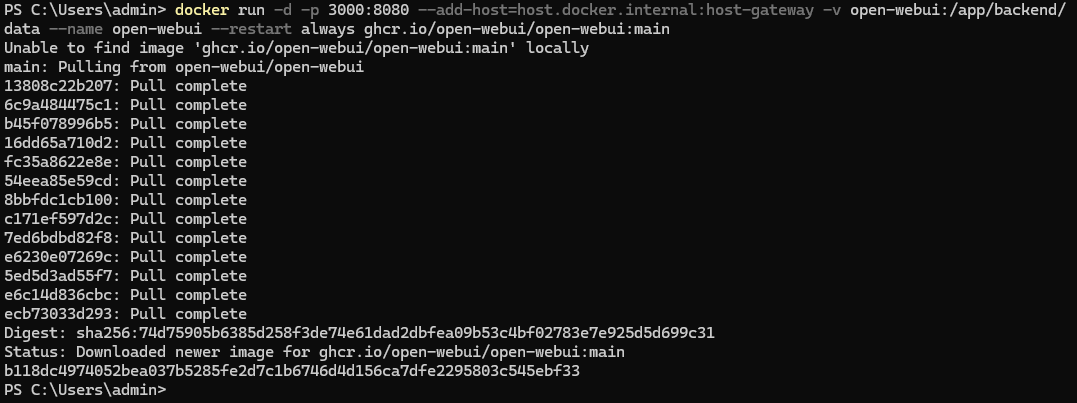

然后等待安装完毕即可:如下图所示:

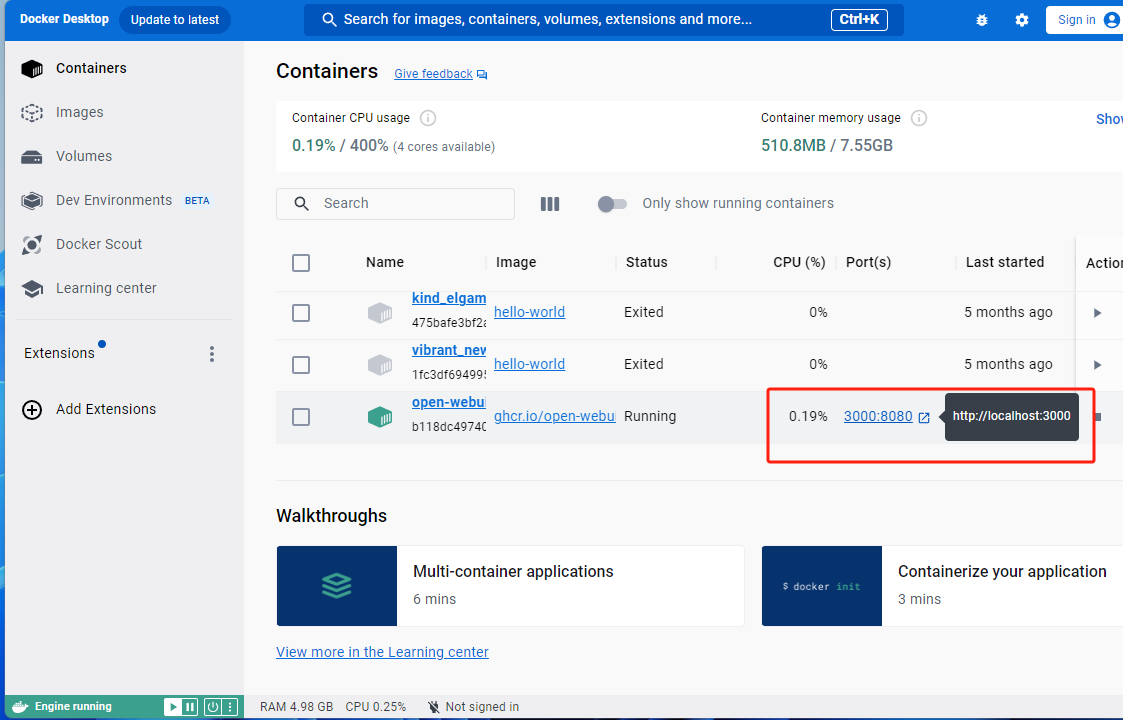

安装完成后,在Docker Desktop中可以看到Open WebUI的web界面地址为:https://localhost:3000

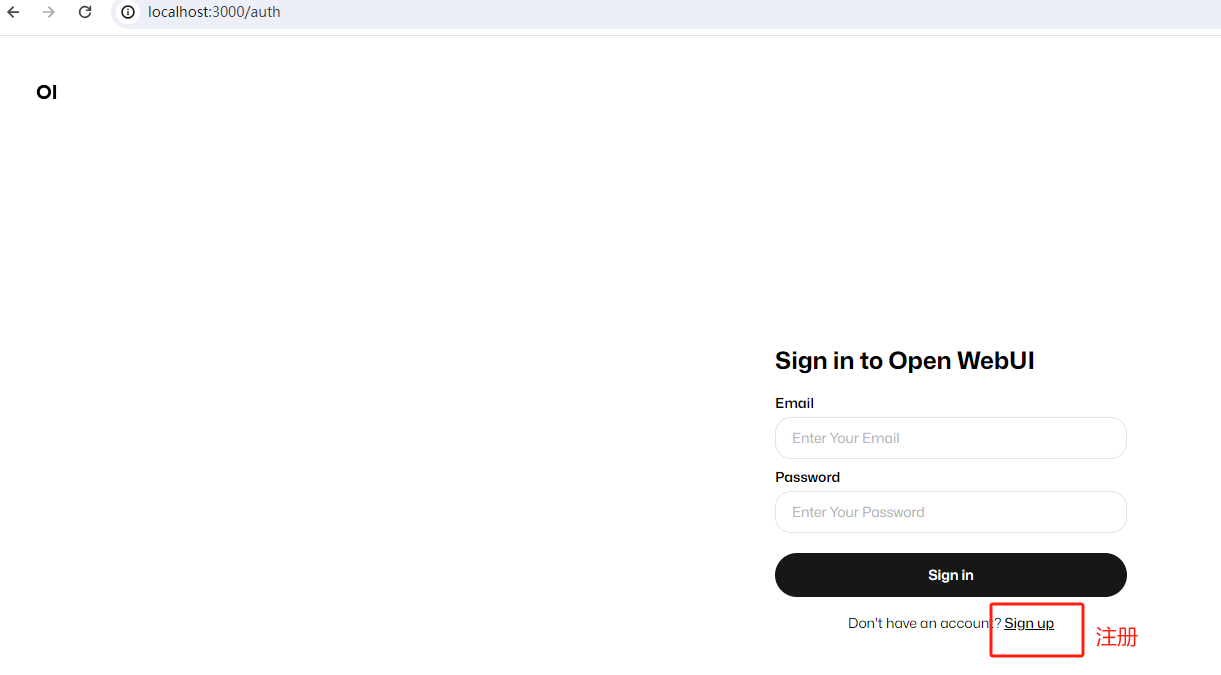

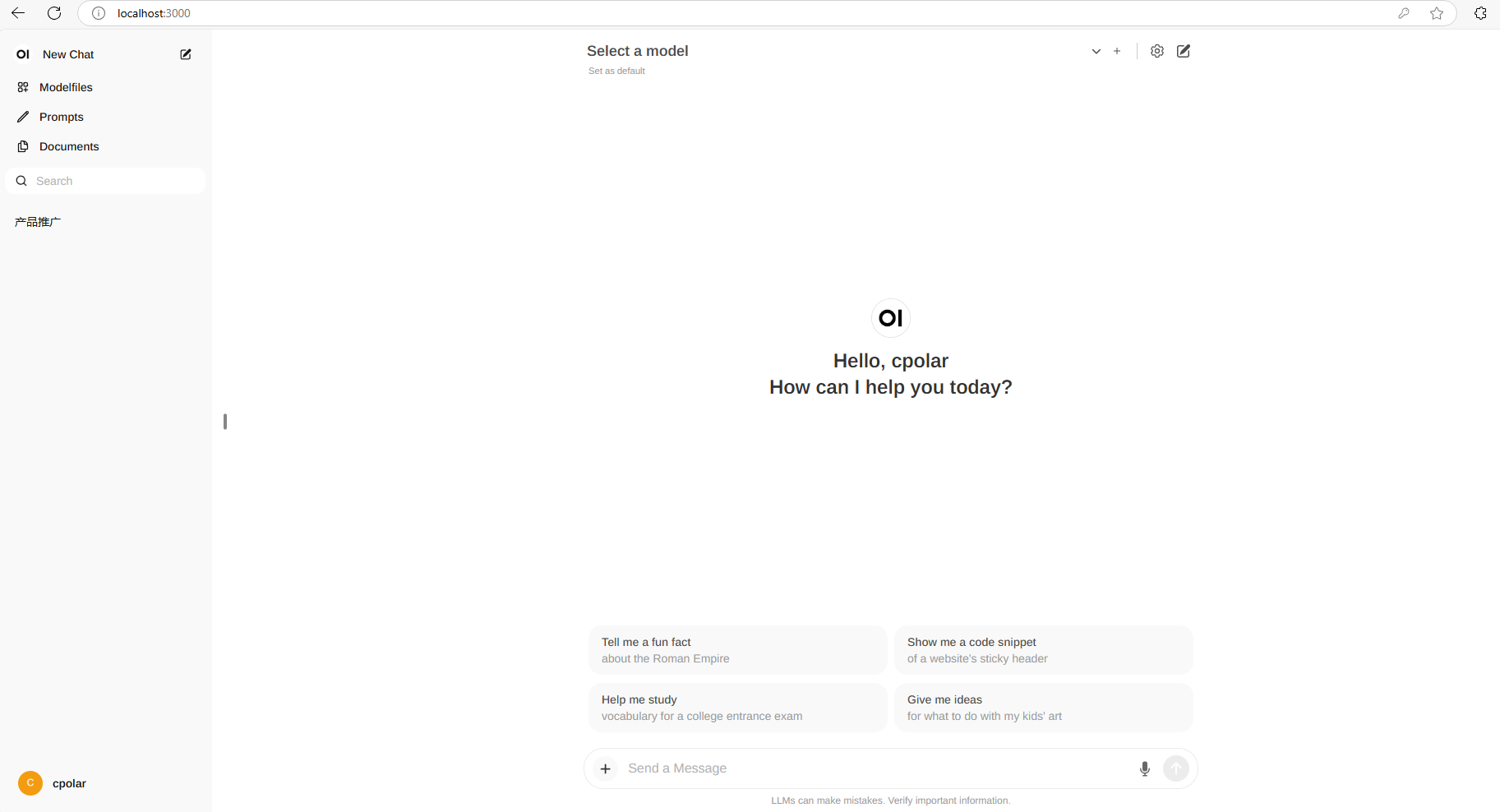

点击后,会在浏览器打开登录界面:

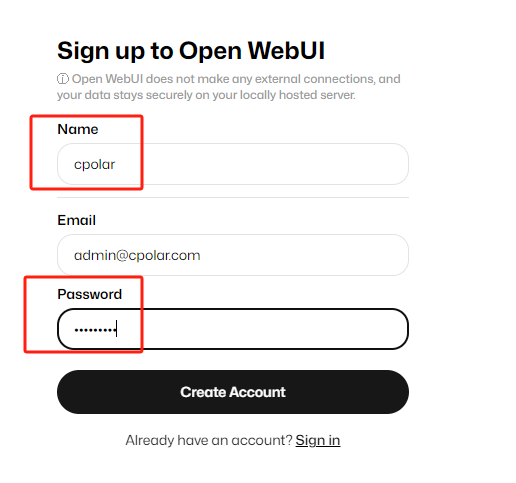

点击sign up注册,账号,邮箱,密码记好,下次登录时需要用到邮箱和密码登录:

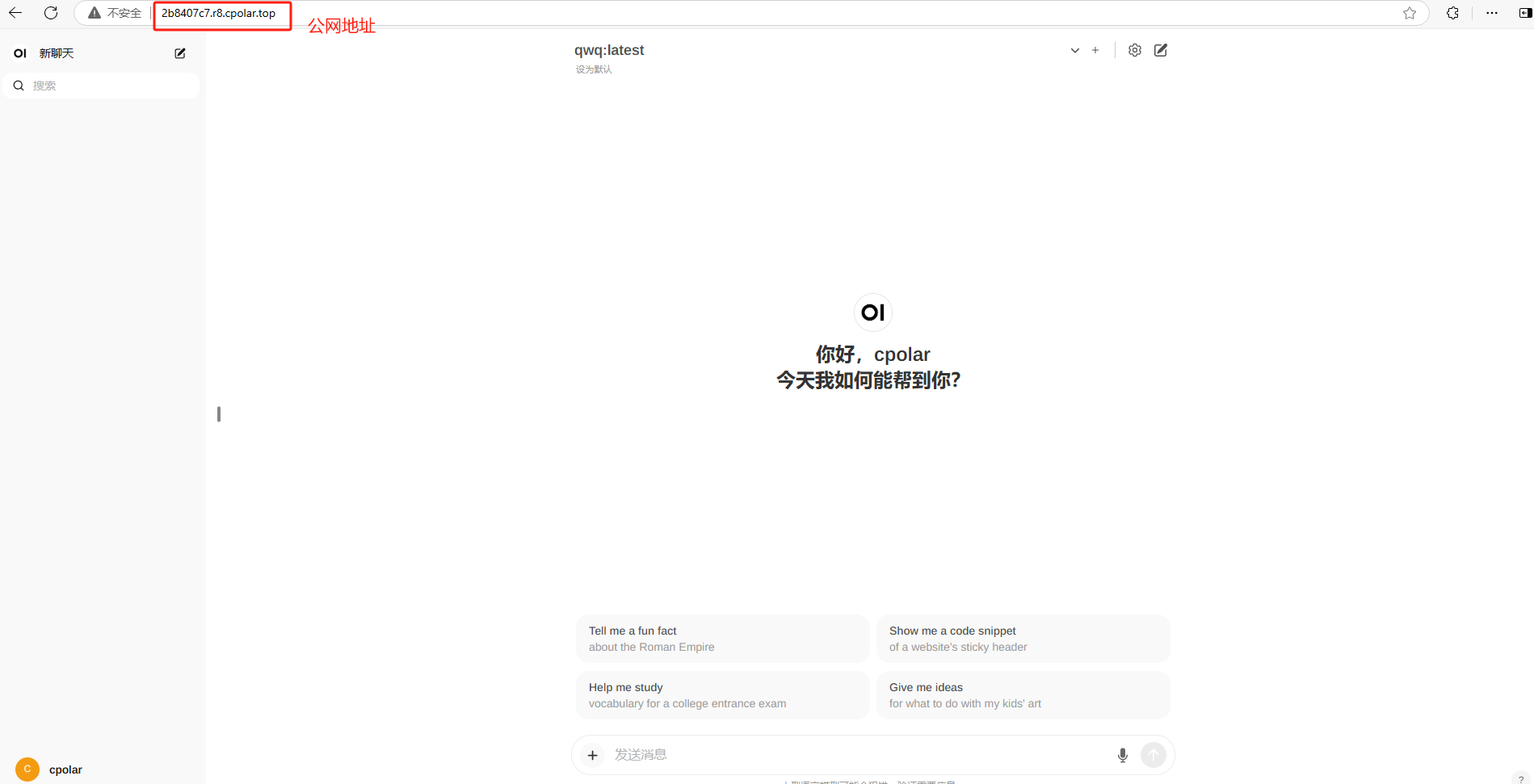

添加模型后就能在浏览器中使用web界面来和QWQ32B聊天了!

3.2 添加QWQ32B模型

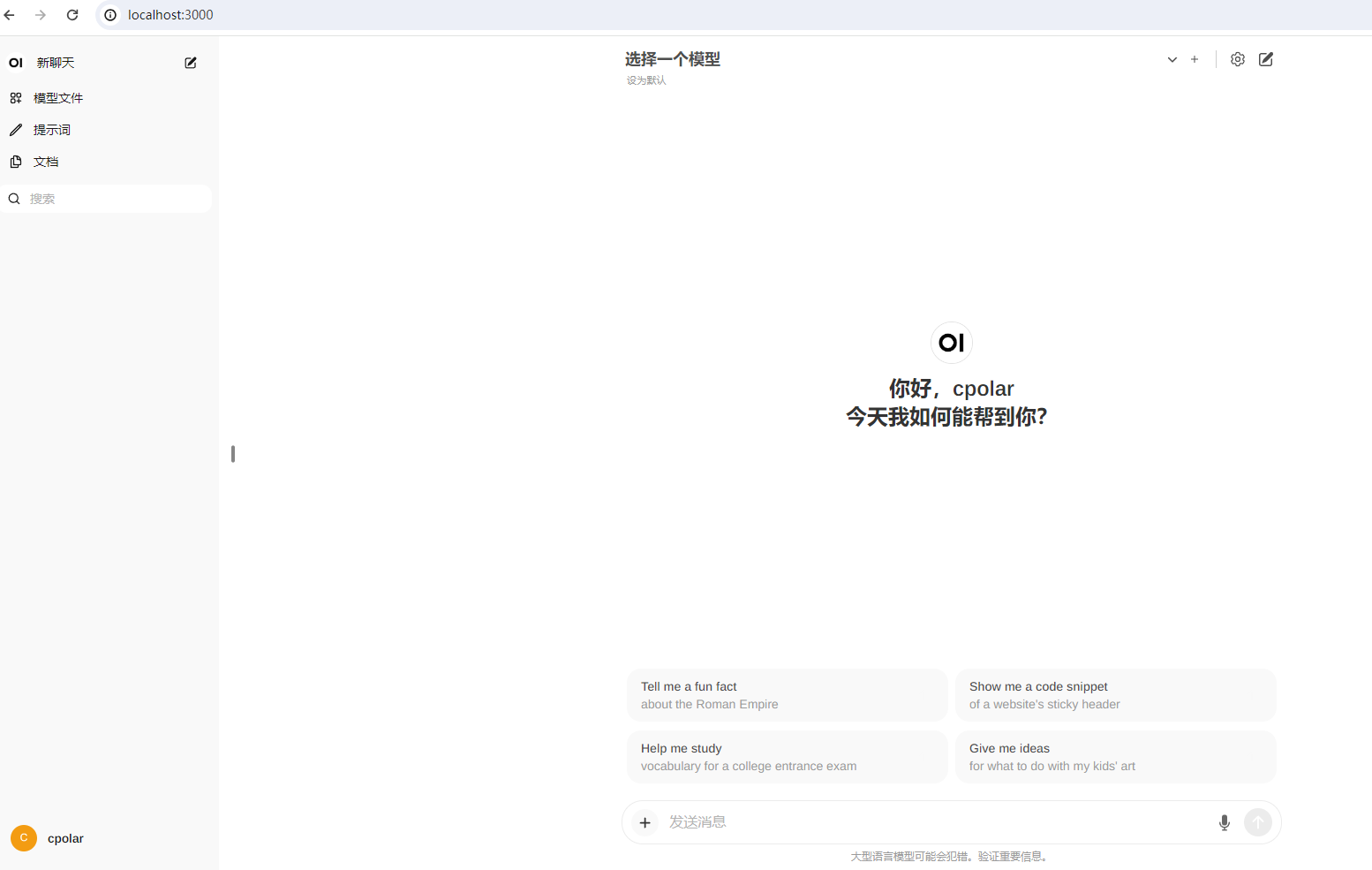

点击右上角的设置,可以修改当前界面的语言为简体中文:然后点击保存即可。

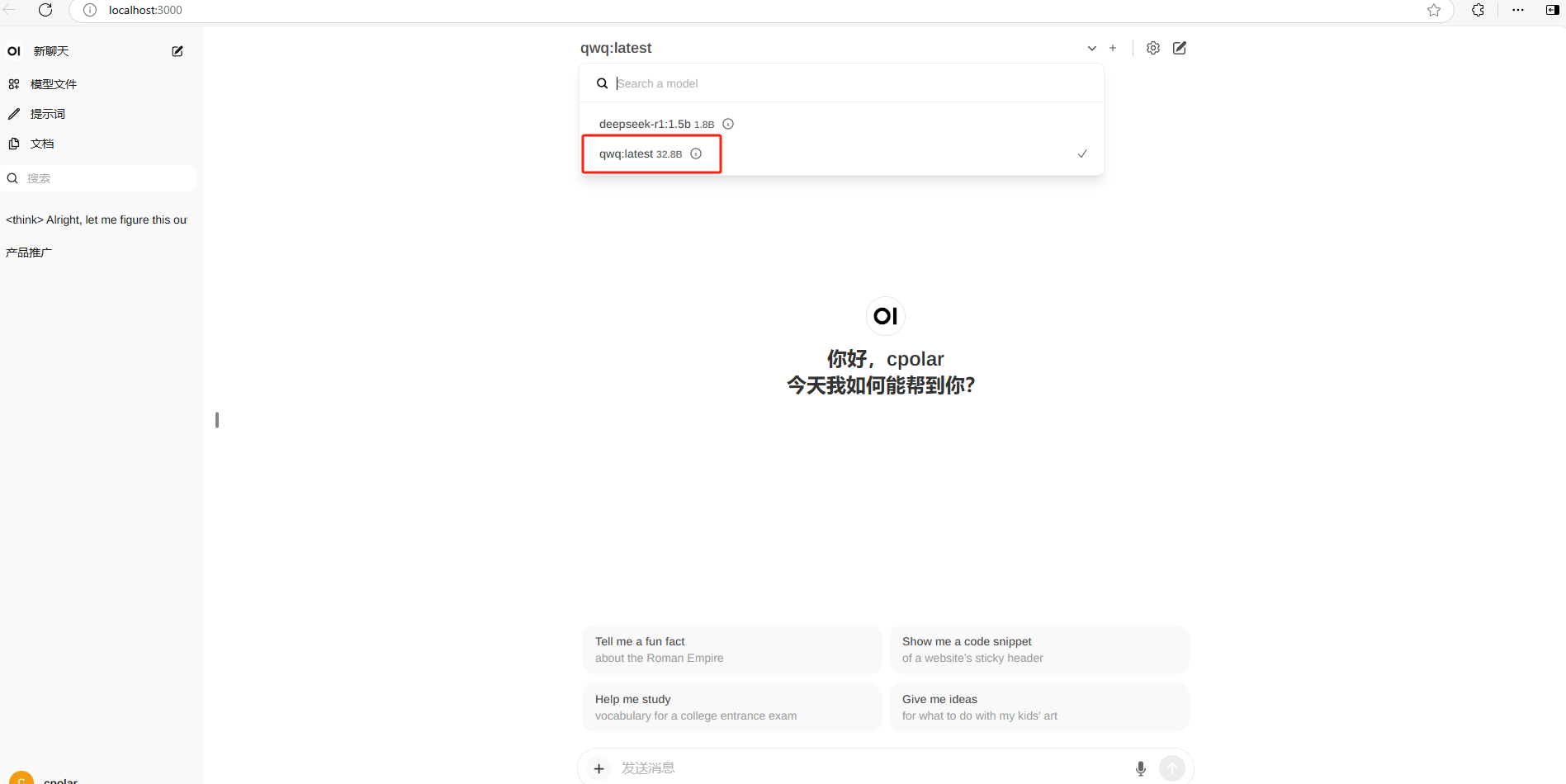

点击上方选择一个模型旁边的加号+可以增加大模型,点击下拉按钮可以选择当前使用哪一个已安装的模型,这里选择刚才安装的qwq:latest 32.8B,接下来就可以愉快的跟大模型在网页中聊天了!

到这里就成功在本地部署了QWQ32B模型并使用Open WebUI在网页中与AI交互,之后你可以根据自己的需求把它训练成自己专用AI助手啦。

4. 安装内网穿透工具

但如果想实现不在同一网络环境下,也能随时随地在线使用Open WebUI与本地部署的DeepSeek-r1大模型在网页中聊天,那就需要借助cpolar内网穿透工具来实现公网访问了!接下来介绍一下如何安装cpolar内网穿透,过程同样非常简单:

首先进入cpolar官网:

cpolar官网地址: https://www.cpolar.com

点击免费使用注册一个账号,并下载最新版本的cpolar:

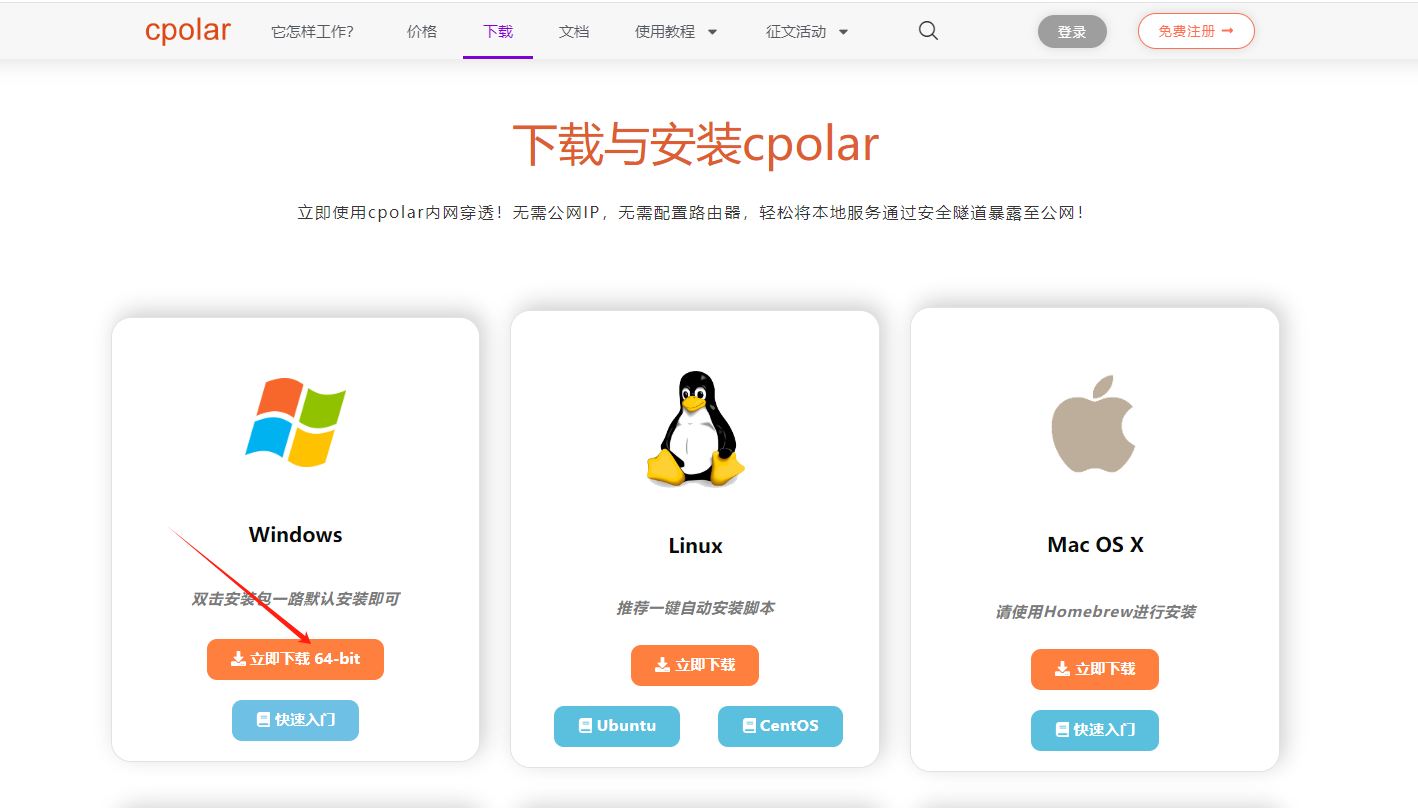

登录成功后,点击下载cpolar到本地并安装(一路默认安装即可)本教程选择下载Windows版本。

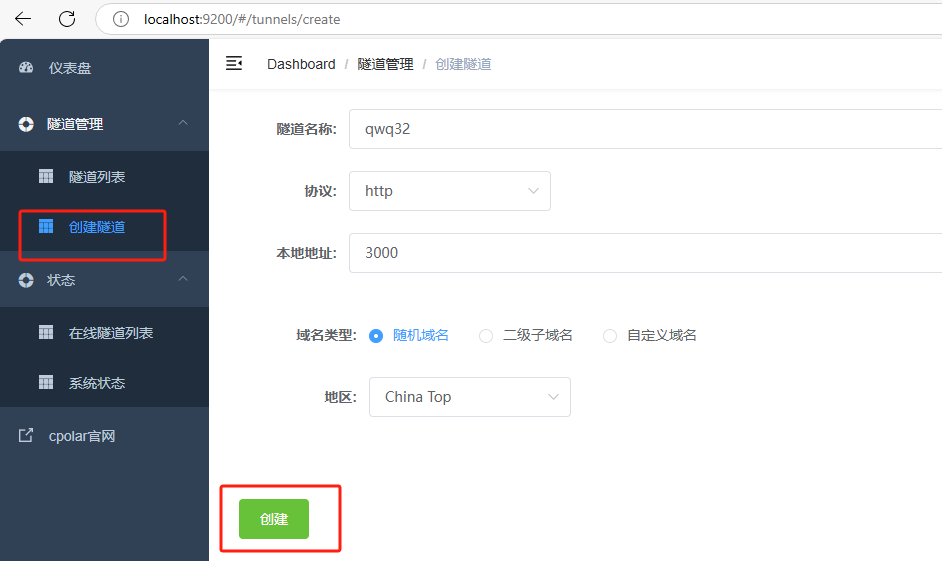

cpolar安装成功后,在浏览器上访问http://localhost:9200,使用cpolar账号登录,登录后即可看到配置界面,结下来在WebUI管理界面配置即可。

接下来配置一下 Open WebUI 的公网地址:

登录后,点击左侧仪表盘的隧道管理——创建隧道,

- 隧道名称:qwq32(可自定义命名,注意不要与已有的隧道名称重复)

- 协议:选择 http

- 本地地址:3000 (本地访问的地址)

- 域名类型:选择随机域名

- 地区:选择China Top

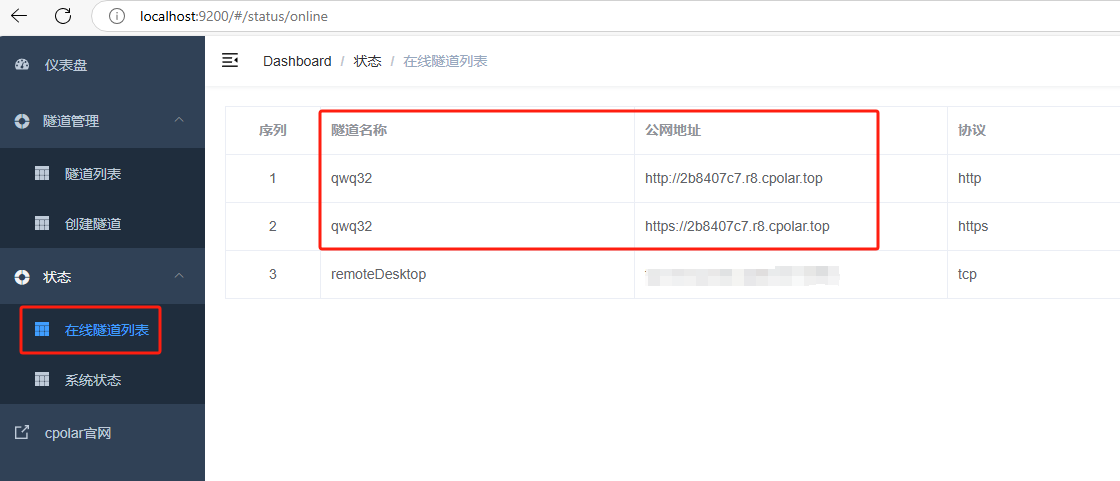

隧道创建成功后,点击左侧的状态——在线隧道列表,查看所生成的公网访问地址,有两种访问方式,一种是http 和https:

使用上面的任意一个公网地址,在手机或任意设备的浏览器进行登录访问,即可成功看到 Open WebUI 界面,这样一个公网地址且可以远程访问就创建好了,使用了cpolar的公网域名,无需自己购买云服务器,即可到随时在线访问Open WebUI来在网页中使用本地部署的qwq32b大模型了!

小结

为了方便演示,我们在上边的操作过程中使用cpolar生成的HTTP公网地址隧道,其公网地址是随机生成的。这种随机地址的优势在于建立速度快,可以立即使用。然而,它的缺点是网址是随机生成,这个地址在24小时内会发生随机变化,更适合于临时使用。

如果有长期远程访问Open WebUI使用QWQ32B模型,或者异地访问与使用其他本地部署的服务的需求,但又不想每天重新配置公网地址,还想让公网地址好看又好记并体验更多功能与更快的带宽,那我推荐大家选择使用固定的二级子域名方式来为Open WebUI配置一个公网地址。

5. 配置固定公网地址

接下来演示如何为其配置固定的HTTP公网地址,该地址不会变化,方便分享给别人长期查看你部署的项目,而无需每天重复修改服务器地址。

配置固定http端口地址需要将cpolar升级到专业版套餐或以上。

登录cpolar官网,点击左侧的预留,选择保留二级子域名,设置一个二级子域名名称,点击保留:

保留成功后复制保留成功的二级子域名的名称:myqwq,大家也可以设置自己喜欢的名称。

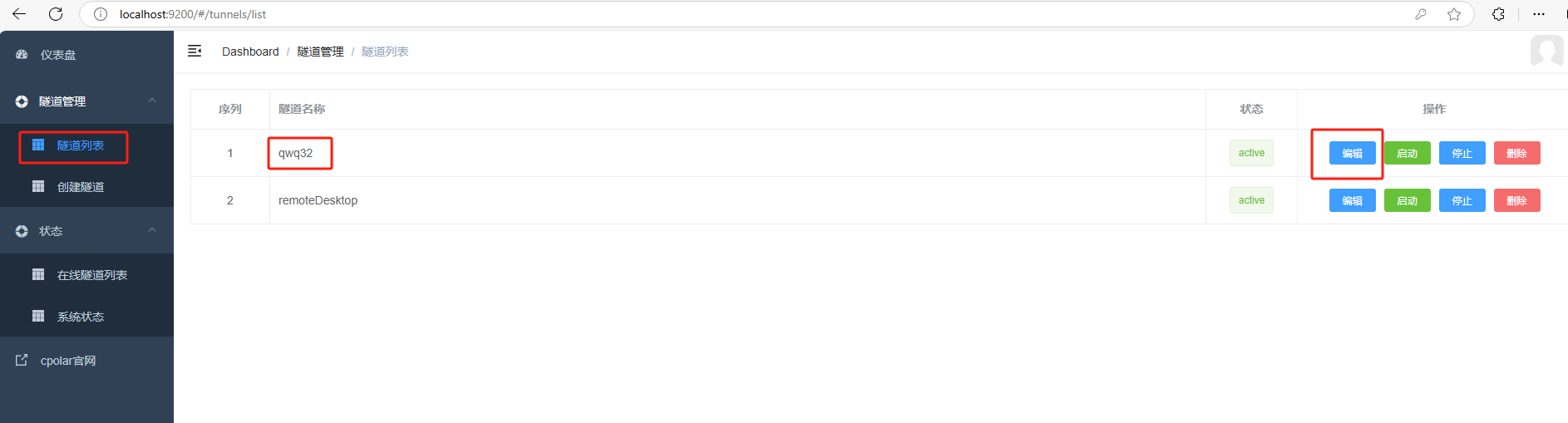

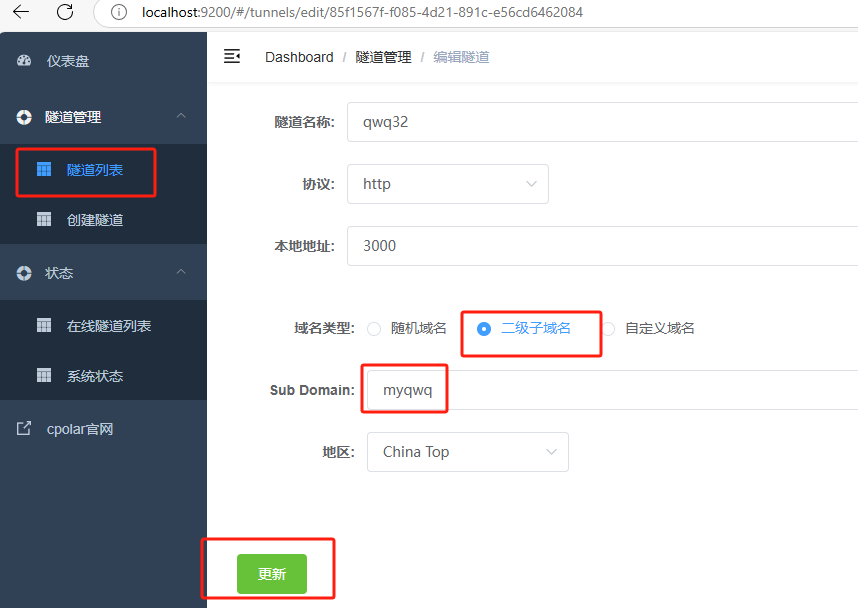

返回Cpolar web UI管理界面,点击左侧仪表盘的隧道管理——隧道列表,找到所要配置的隧道:qwq32,点击右侧的编辑:

修改隧道信息,将保留成功的二级子域名配置到隧道中

- 域名类型:选择二级子域名

- Sub Domain:填写保留成功的二级子域名:

myqwq

点击更新(注意,点击一次更新即可,不需要重复提交)

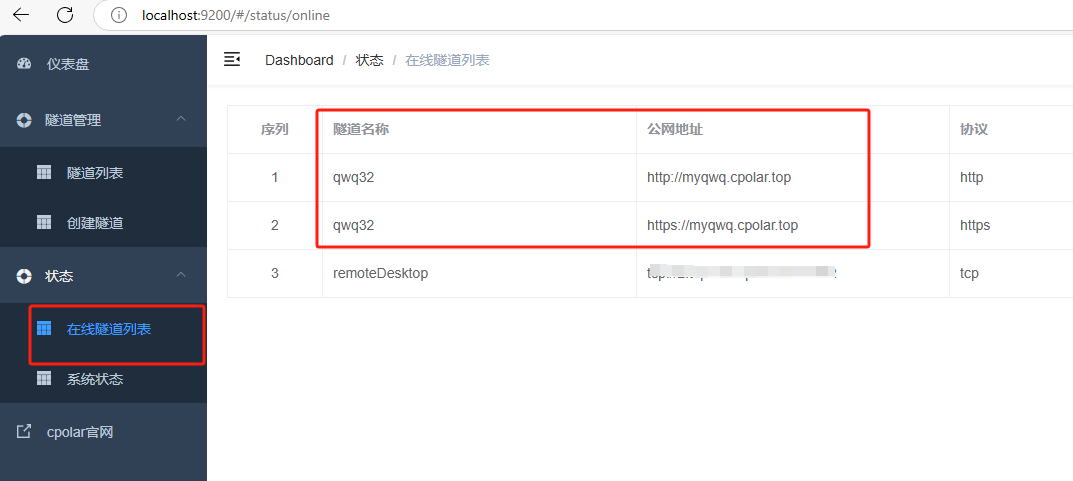

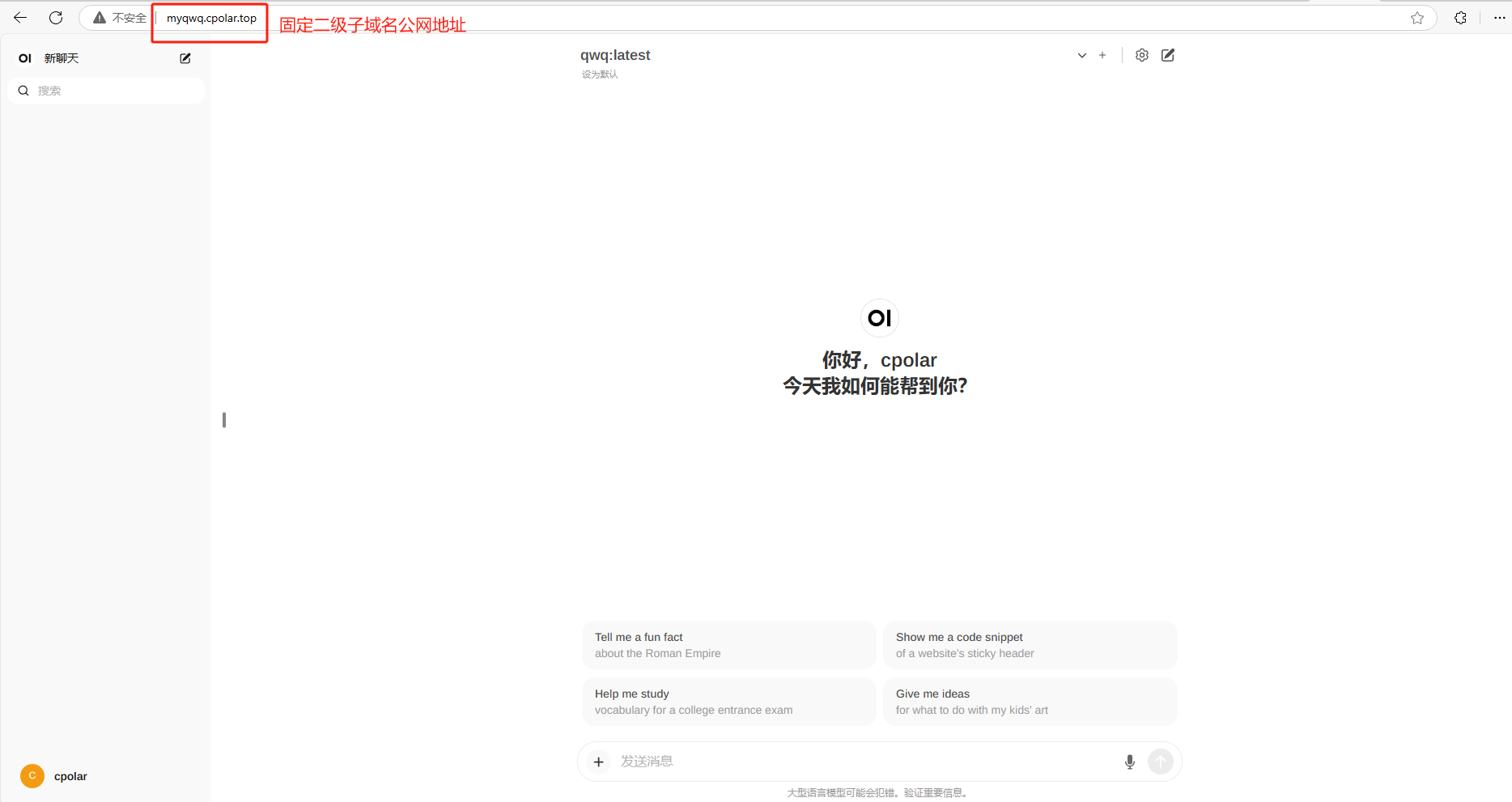

更新完成后,打开在线隧道列表,此时可以看到公网地址已经发生变化,地址名称也变成了固定的二级子域名名称的域名:

最后,我们使用上边任意一个固定的公网地址访问,可以看到访问成功,这样一个固定且永久不变的公网地址就设置好了,可以随时随地在公网环境异地在线访问本地部署的Open WebUI来使用QWQ32B大模型了!

总结

今天我们不仅成功地将Ollama与千问QWQ32B大模型安装到了本地Windows系统中,还利用Docker和Cpolar内网穿透技术实现了远程访问,配置了固定不变的二级子域名公网地址。老实说,这款大模型的表现真的超出了我的预期,尤其是在家用级硬件上的表现,简直就是为普通用户量身打造的神器!对于未来的发展,我充满了期待,谁不想拥有一个这么强大的私人AI助手呢?如果你也心动了,不妨动手试试吧!遇到问题别担心,欢迎随时留言交流,我们一起探索这个充满无限可能的世界。

1194

1194

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?