课程地址:https://class.coursera.org/ntumlone-001/class

课件讲义:http://download.csdn.net/download/malele4th/10208897

注明:文中图片来自《机器学习基石》课程和部分博客

建议:建议读者学习林轩田老师原课程,本文对原课程有自己的改动和理解

红色的石头专栏

Lecture 6 : 泛化理论

目录

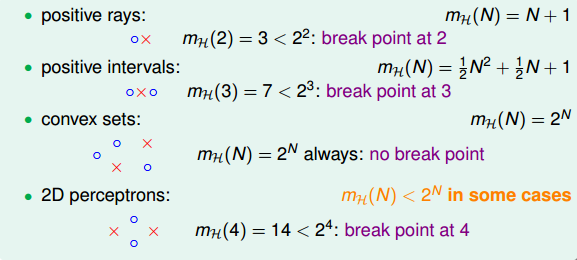

上一节课,我们主要探讨了当M的数值大小对机器学习的影响。如果M很大,那么就不能保证机器学习有很好的泛化能力,所以问题转换为验证M有限,即最好是按照多项式成长。然后通过引入了成长函数mH(N)和dichotomy以及break point的概念,提出2D perceptrons的成长函数mH(N)是多项式级别的猜想。这就是本节课将要深入探讨和证明的内容。

一 Restriction of Break Point

我们先回顾一下上节课的内容,四种成长函数与break point的关系:

下面引入一个例子,如果k=2,那么当N取不同值的时候,计算其成长函数mH(N)是多少。很明显,当N=1时,mH(N)=2,;当N=2时,由break point为2可知,任意两点都不能被shattered(shatter的意思是对N个点,能够分解为

2N

种dichotomies(二分法));mH(N)最大值只能是3;当N=3时,简单绘图分析可得其mH(N)=4,即最多只有4种dichotomies。

下面的对照课件完成吧…………………………………….

………………………………………………………………..

五 总结

本节课我们主要介绍了只要存在break point,那么其成长函数mH(N)就满足poly(N)。推导过程是先引入mH(N)的上界B(N,k),B(N,k)的上界是N的k-1阶多项式,从而得到mH(N)的上界就是N的k-1阶多项式。然后,我们通过简单的三步证明,将mH(N)代入了Hoffding不等式中,推导出了Vapnik-Chervonenkis(VC) bound,最终证明了只要break point存在,那么机器学习就是可行的。

1616

1616

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?