任务与奖赏

种瓜有许多步骤,但在种瓜的过程中,某些操作并不能立即得到最终奖励,只能得到一个当前反馈(例如瓜苗看起来更健壮了),我们需要不断摸索,才能总结出较好的种瓜策略,这个过程就是强化学习。

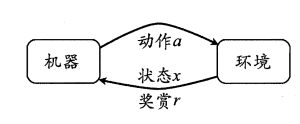

强化学习任务通常用马尔可夫决策过程 (Markov Decision Process,简称 MDP)来描述:机器处于环境E中,状态空间为X,其中每个状态 x∈X 是机器感知到的环境的描述,如在种瓜任务上这就是当前瓜苗长势的描述;机器能采取的动作构成了动作空间A,如种瓜过程中有浇水、施不同的肥、使用不同的农药等多种可供选择的动作;若某个动作 α∈A 作用在当前状态 x,则潜在的转移函数P将使得环境从当前状态按某种概率转移到另一个状态,如瓜苗状态为缺水,若选择动作浇水,则瓜苗长

势会发生变化,瓜苗有一定的概率恢复健康,也有一定的概率无法恢复;在转移到另一个状态的同时,环境会根据潜在的"奖赏" (reward) 函数R反馈给机器一个奖赏,如保持瓜苗健康对应奖赏 +1 ,瓜茵凋零对应奖赏一10 ,最终种出了好瓜对应奖赏 +100。 综合起来,强化学习任务对应了四元组 = (X,A,P,R), 其中 P:XAX →P指定了状态转移概率 ,R:XAX →R指定了奖赏;在有的应用中,奖赏函数可能仅与状态转移有关,即 R:X*X →R。其中在环境中状态的转移与奖赏的返回是不受机器控制的。机器只能通过选择要执行的动作来影响环境,也只能通过观察转移后的状态和返回的奖赏来感知环境。

一个简单的例子

机器要做的是通过在环境中不断地尝试而学得一个"策略" (policy) π,根据这个策略,在状态x下就能得知要执行的动作 a= (x) ,例如看到瓜苗状态是缺水时,能返回动作"浇水"策略有两种表示方法:二种是将策略表示为函数π :X →A,确定性策略常用这种表示;另一种是概率表示汀 :X*A →R,随机性策略常用这种表示。π(x,a) 为状态 x下选择动作a的概率。

在强化学习任务中,学习的目的就是要找到能使长期累积奖赏最大化的策略。常用的奖励累计奖赏有“T步累积奖赏”。

K-摇臂赌博机

仅考虑异步操作,最大化单步奖赏。则需要知道每个动作带来的奖赏,然后执行奖赏最大的动作。然而,更一般的情形是,一个动作的奖赏值是来自于一个概率分布,仅通过一次尝试并不能确切地获得平均奖赏值。

单步强化学习任务对应了一个理论模型,即 K-摇臂赌博机 (K-armed bandit). K-摇臂赌博机有 个摇臂,赌徒在投入一个硬币后可选择按下其中一个摇臂,每个摇臂以一定的概率吐出硬币,但这个概率赌徒并不知道。赌徒的目标是通过一定的策略最大化自己的奖赏,即获得最多的硬币.

仅探索:将所有的尝试机会平均分配给每个摇臂(即轮流按下每个摇臂),最后以每个摇臂各自的平均吐币橄率作为其奖赏期望的近似估计。

仅利用::按下目前最优的(即到目前为止平均奖赏最大的)摇臂,若

强化学习是机器通过不断尝试与环境互动来学习最优策略的过程。它以马尔可夫决策过程(MDP)为基础,目标是找到最大化长期累积奖赏的策略。强化学习包括有模型学习和免模型学习,如策略评估、策略改进、蒙特卡罗强化学习和时序差分学习等方法。在解决探索与利用的矛盾中,e-贪心和Softmax策略提供了平衡的解决方案。

强化学习是机器通过不断尝试与环境互动来学习最优策略的过程。它以马尔可夫决策过程(MDP)为基础,目标是找到最大化长期累积奖赏的策略。强化学习包括有模型学习和免模型学习,如策略评估、策略改进、蒙特卡罗强化学习和时序差分学习等方法。在解决探索与利用的矛盾中,e-贪心和Softmax策略提供了平衡的解决方案。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6369

6369

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?