前言

毕设要用到基于图神经网络的动作识别方法,因此要阅读一系列GCN相关文章,后面会出一个专门关于GCN的专栏。

论文全称:Spatial Temporal Graph Convolutional Networks for Skeleton-Based Action Recognition,AAAI 2018。

文章链接:https://arxiv.org/abs/1801.07455

Github 代码:https://github.com/yysijie/st-gcn

摘要与论文贡献

人体骨骼间的相互作用为人类的动作识别提供了重要的信息。传统的骨骼建模方法通常依赖于特别制定的模块或相关的遍历规则,从而导致了有限的表达能力和泛化困难。在这项工作中,这篇提出了一种新的动态骨架模型,称为时空图卷积网络(ST-GCN),它通过自动从数据中学习空间和时间维度的信息为下游任务做准备。这一方法不仅有强大的表达能力,而且具有更强的泛化能力,在动力学数据集和NTU-RGBD上比主流方法具有实质性的改进。

提出了ST-GCN,一个通用的基于图的动态骨架建模算法,它是第一个将基于图的神经网络用于人体动作识别任务的算法

提出了在动作识别中实现ST-GCN卷积的相关原则,以满足骨架建模的具体要求

在两个任务为动作识别的大规模数据集上,与以往使用手工模块或遍历规则的方法相比,该模型取得了更好的性能,而人工设计的工作量相当少

ST-GCN模型

总体描述

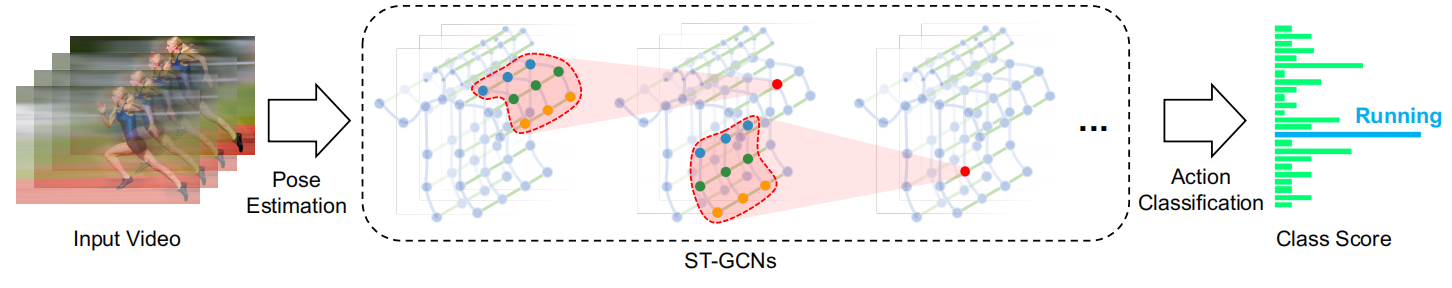

图一 动作识别流程图

从图一可以看出,将ST-GCN运用于动作识别任务中首先需要通过运动捕捉设备或视频姿态估计算法获得基于骨骼的数据。这些数据通常有一系列的帧,每一帧将有一组联合坐标,从而构建了按照规定顺序以二维或三维坐标的形式构造的以关节为图节点,人体结构和时间为图边的时空图。ST-GCN的输入是图节点上的联合坐标。这可以被认为是一种类似于基于图像的CNN,对输入数据进行多层的时空图卷积运算,并在图上生成更高层次的特征映射,然后通过SoftMax分类器将将其分类为相应的动作类别,整个模型以反向传播的方式进行训练。下面将详细介绍ST-GCN模型中的组件。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6763

6763

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?