很多教程喜欢把信息熵和离散随机变量X的期望定义联系在一块,但是想深入专业的人可能觉得并不觉得好理解,

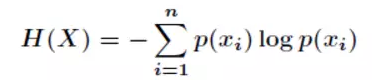

我们首先知道信息熵是

考虑该随机变量X的所有可能取值,即X的所有的可能取值对应的平均信息量(不确定性),也就是信息量(不确定性的期望)。公式如下:

但是回想概率论里面的E(X)的公式, ,是X取所有值x1,x2....xn的期望。对应信息量的期望还是很难关联起来,首先是信息量并不是xi的函数g(xi),是-logp(xi),仅仅与概率有关,到底是哪一个随机变量可能的取值也没给出。下面结合个人肤浅的理解。采用这样的方式转换,若有不妥欢迎批评指正。

,是X取所有值x1,x2....xn的期望。对应信息量的期望还是很难关联起来,首先是信息量并不是xi的函数g(xi),是-logp(xi),仅仅与概率有关,到底是哪一个随机变量可能的取值也没给出。下面结合个人肤浅的理解。采用这样的方式转换,若有不妥欢迎批评指正。

假设X为离散随机变量,X=xi的时候,xi发生的概率为p(xi),可以把log1/pxi当成是X=xi的信息量或者不确定性,就以log1/xpi为桥梁,假设X对应着另一个随机变量Y,则Y的取值Y={y1,y2....yn},其中y1=log1/py1,y2=log1/py2,......,yn=log1/pyn。而这时候Y={y1,y2,y3...yn}的概率仍然还是(px1,px2...pxn)(因为x1,x2..xn互相独立,yi只与xi有关,那么自然pxi=pyi)

因此Y的期望E(Y)=∑yi*p(yi)=∑log(1/pyi)*pyi=-∑pxi*logpxi,i=1,2....n。log是以2为底。单位为比特。这就是随机变量Y的数学期望(概率论里面最直观的数学期望公式),而Y期望正好就是X对应所有可能取值的信息量的数学期望,也是就X的信息熵。

629

629

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?