前言

CTRL: A Conditional Transformer Language Model For Controllable Generation

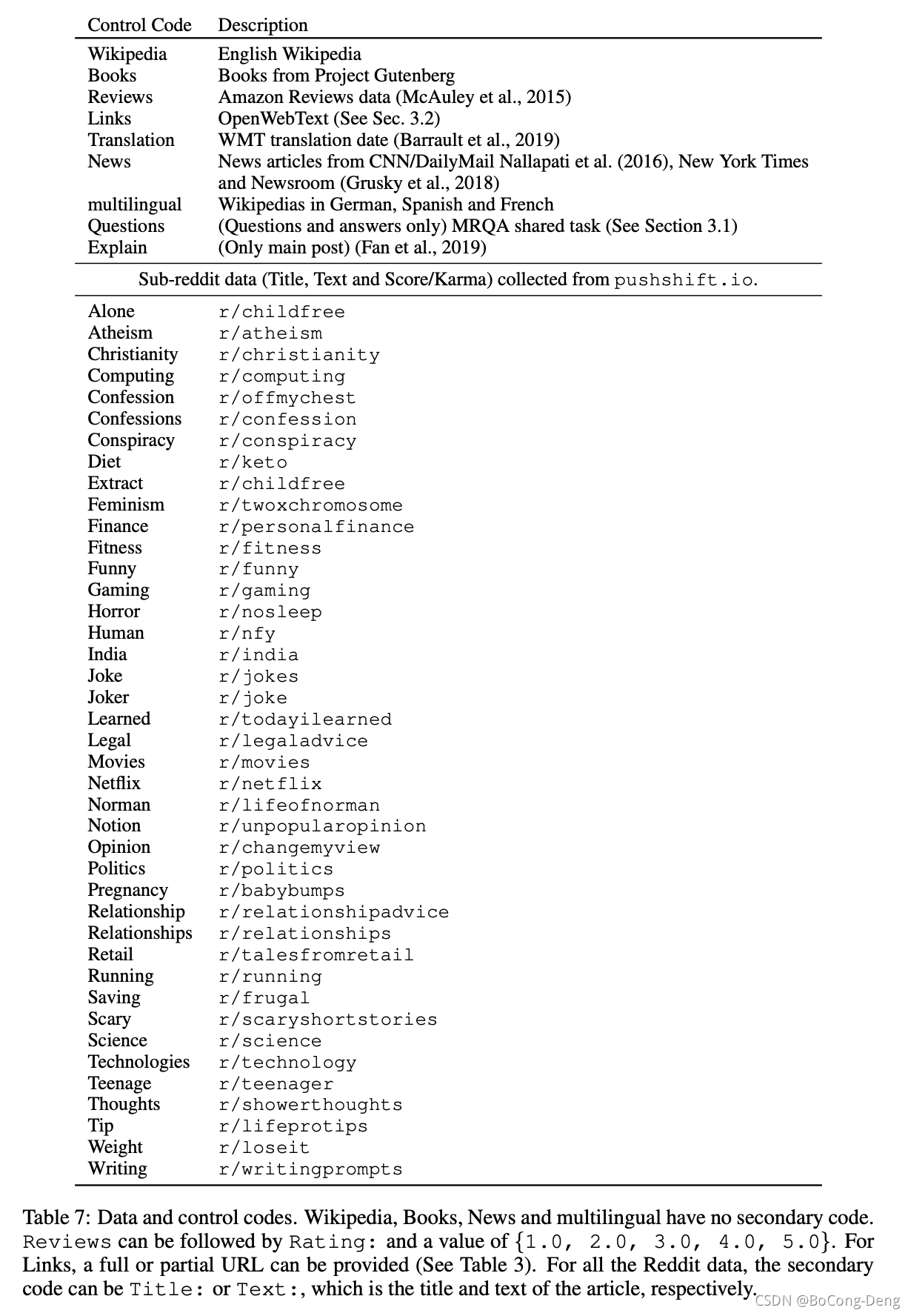

2019年推出GPT-3,和它以往的风格一样,模型巨大参数超多,在生成文本能力上表现惊人,不过GPT模型生成的文本风格往往由模型自身决定(和训练语料有关,有着一定的随机性)。而本篇所要提的模型CTRL(Conditional Transformer Language Model),对标GPT-2,可以更好的控制文章的内容,生成有价值的文本,且无需进一步训练就可以解决特定领域的具体问题。CTRL模型的最大优势是在生成文本时可指定文章的类型,同一模型可以写作不同风格的文章,可以指定文章的领域、风格、主题、时间、实体,实体间的关系,以及任务相关的行为等等。模型使用的Control Code和sub-reddit data如下:

不同的角度,有不同的答案。换言之,CTRL关注了语料在不同场景中的不同含义。模型更符合实际应用的场景:使用者在同一时间,只可能生成某一特定类型,同时又希望单个模型支持生成各种类型的文章,CTRL可视为多任务学习。使用 CTRL,只要提供control code,control code可以是 URL、问题和语言,也可

订阅专栏 解锁全文

订阅专栏 解锁全文

955

955