幻觉是事实,不是错误;错误的是基于幻觉的判断。——伯特兰·罗素

大型语言模型 (LLM)表现出色,但仍受到幻觉的困扰。特别是对于敏感应用来说,这不是一个小问题,因此已经研究了几种解决方案。尽管一些缓解策略有助于减少幻觉,但问题仍然存在。

变形金刚安魂曲?

Transformer 会成为引领我们走向通用人工智能的模型吗?还是会被取代?

聊天堂吉诃德与风车:在通往准确性的道路上驾驭人工智能幻觉

提高大型语言模型可靠性的策略和工具

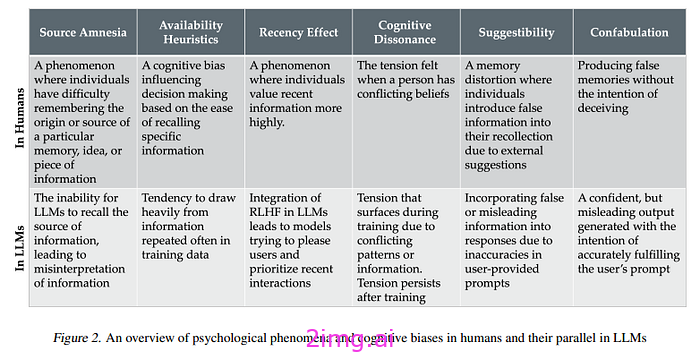

幻觉产生的原因仍是一个悬而未决的问题,尽管有一些理论解释了幻觉产生的原因(在情境幻觉的情况下忽略情境等等)。最近的一篇文章提出了一个有趣的观点,即人类和模型对幻觉的定义是不同的。在人类中,它被定义为幻觉:

“当你听到、看到、闻到、尝到或感觉到看似真实但只存在于你脑海中的事物时” —来源

因此,作者试图将LLM中出现的幻觉与心理学概念 [2] 联系起来。其想法是使用更合适的词汇来描述这些现象:

我们摆脱了对“幻觉”一词的传统使用,这不仅仅是一种语义练习;相反,这是一种刻意的手段,旨在增强我们对高级语言模型所面临的局限性和挑战的理解。——来源

图片来源:这里[2]

这些从心理学角度的定义显示出与记忆概念的联系,因此一些作者决定为 LLM 提供记忆。

最流行的方法之一是提供外部存储器的概念。检索增强生成(RAG) 是最流行的范例,其中在外部存储器中寻找适合查询的信息。然后使用检索到的上下文进行生成。

RAG 已死,RAG 万岁

长期 LLM 真的会扼杀 RAG 吗?

余弦相似度和嵌入仍然很受欢迎吗?

余弦相似度是最常用的方法,但它真的是最好的吗?

但是,存在具有读/写访问权限的内存的替代方案。事实上,LLM 继承了与转换器相同的局限性,包括无法更新 LLM 的知识。为了保持相关性,我们需要一个系统,允许我们在添加新信息的同时删除不需要的、不正确的或过时的事实。微调是一种昂贵的解决方案,但如果我们想经常更新模型的“内存”,它是不切实际的。

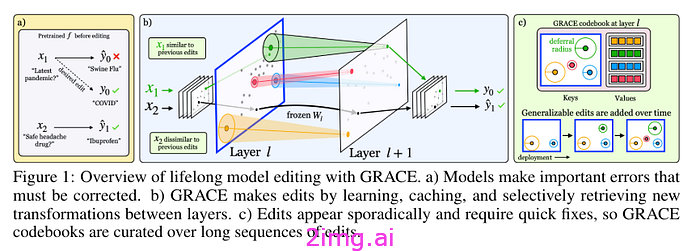

另一种方法是在保留原始冻结模型的同时进行编辑。最有趣的方法之一是用于持续编辑的通用检索适配器 (GRACE) [4]。您无需编辑模型的权重,而是编辑适配器的权重。这些适配器与模型的各层互连,并修改所选输入的层间转换。

图片来源:这里[4]

相比之下,对于人类来说,既可以更新自己的知识,也可以用它来概括未知的数据。通常,这种能力是由海马体提供的,它对情景记忆很重要(海马体用于快速学习,大脑皮层用于慢速学习)。

HippoRAG:为大型语言模型赋予人类记忆动态

复制大脑,更好地整合和检索知识

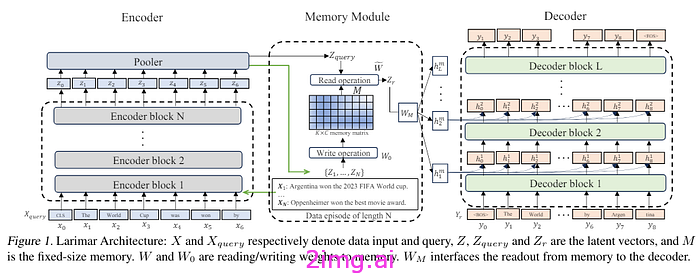

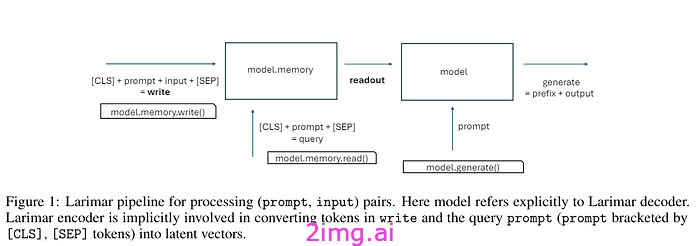

受此想法的启发,他们在这篇论文中提出了 Larimar [3],这是一类由情景记忆控制的模型。换句话说,控制器学习情景记忆,而LLM(慢速记忆)学习输入分布的汇总统计数据。控制器充当事实更新和一代 LLM 条件的全局存储器。然后可以读取和重写此全局内存。该系统是一个编码器-解码器转换器,其中的输出用于写入内存或搜索内存中的信息以发送给解码器。

图片来源:这里[3]

持续学习机制和模型重新校准可以让 LLM 根据不断变化的信息进行调整和自我纠正。——来源

我们现在有了可以编辑自己记忆的模型,我们可以测试这是否会改善幻觉问题。在这项工作 [1] 中,他们使用幻觉基准数据集测试了这一假设。WikiBio 是使用GPT-3为 238 名受试者生成类似维基百科的传记而获得的。

这里作者测试了两个模型:

- Larimar,由BERT大型编码器、记忆矩阵(已使用来自 wiki 文本的 7.6 M 条目进行训练)和GPT2-large解码器构建。

- GRACE模型,GPT2-XL已经微调。

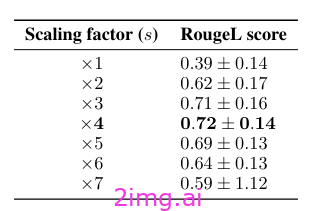

在任务中,作者使用幻觉条目,然后使用从维基百科获得的更正条目。通过这种方式,他们通知模型(在 Larimar 中更新矩阵或在 GRACE 中进行适配器编辑)。然后他们要求模型生成提示的输出,从而生成新的 WikiBio 条目。

图片来源:这里[1]

从图片中可以看出,在 Larimar 中,模型可以重写内存、从内存中读取或直接生成。作者指出,你可以强制模型在管道的各个阶段对齐潜在表示。简而言之,就是将内存中的写入表示与读取表示对齐。这种对齐可以减少幻觉。

图片来源:这里[1]

更好的幻觉分类法使我们能够更好地解释幻觉是如何产生的。例如,在最近发表在《自然》杂志上的一项研究中[5],他们重点研究了虚构症(幻觉的一种亚型,之前被定义为一种可信但具有误导性的输出)。

我们展示了如何通过开发一种定量测量方法来检测虚构,该测量方法可以衡量输入何时可能导致 LLM 生成任意且没有根据的答案。通过检测虚构,基于 LLM 构建的系统可以避免回答可能导致虚构的问题,让用户意识到问题答案的不可靠性,或者通过更有根据的搜索或检索来补充 LLM。—来源

图片来源:这里[2]

这表明幻觉是一个异质性家族,很难找到一种针对所有类型的单一解决方案。

同时,从记忆的角度进行讨论可以开发出减少幻觉的方法。添加外部记忆不仅会影响持续学习,还可以减少幻觉。这些方法很有趣,并且表明人们对解决变压器限制的替代解决方案很感兴趣。

1870

1870

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?