大型语言模型(LLM)就像游轮。

邮轮上提供各种活动,满足不同兴趣的人群。例如,您可以享受几乎任何种类的美食、现场娱乐、电影院、夜总会、水上乐园、特定年龄段的俱乐部、零售购物和各种体育赛事。

但如果我想去钓鱼,我不会预订游轮旅行,我会租一艘小型摩托艇,因为它们用途更广泛。

如果我想去滑水,我会选择专为速度和尾流冲浪设计的滑水艇。

这是区分小型和大型模型的一个很好的比喻。LLM 是通用体验,几乎可以满足任何需求。这相当于访问整个网络。

但 SLM 可以更加高效,并且更有针对性。

什么是小型语言模型 (SLM)?

首先让我们定义一下 SLM 的含义。

SLM 的大小主要由其包含的参数数量定义,语言模型中的参数是模型在训练期间调整以创建其预测的旋钮和杠杆。

据传,像 GPT4o 这样的 LLM 有数万亿个参数。例如,Gemini Ultra 有大约 5000 亿个参数,而新发布的开源 Llama 405b 正是如此——有 4050 亿个参数。

现在,当 AI 模型公司发布新模型时,他们往往会分层发布,通常包括大号、中号和小号版本的模型。

“小”的定义可能因较大模型的大小而异,但可以肯定地说,小型语言模型 (SLM) 可以被视为任何具有少于 100 亿个参数的模型。

以下是一些示例:

- Meta 的 Llama 3.1 (8B)

- 谷歌的 Gemma (7B 和 2B)

- Mistral (7B)

- 微软的 Phi-3 小型版(70 亿)、迷你版(38 亿)和远景版(42 亿)

- OpenAI GPT4o mini(8B)

- Anthropic Claude Haiku(?B)

所有这些模型都是开源的,除了 GPT4o mini 和 Haiku,虽然它们不是开源的,但可以进行微调。

这些模型需要进行训练的原因是这是 SLM 的一大优势。

针对特定领域定制的精度

由于 SLM 可以针对特定领域的小众任务进行微调,因此对于想要拥有自己定制模型的公司来说,它们非常有吸引力。

使用 LLM 进行微调一直很困难,因为它需要大量计算,更不用说成本了。使用 SLM 后,这种情况发生了变化 - 你可以使用单个高端 GPU(例如 NVIDIA A100)对 7B 参数模型进行微调。

公司可以创建特定领域且与自身数据一致的目标 SLM,现在有了 SLM,管理起来更加容易。老实说,这是每家公司都想做的事情,现在通过成本和效率就可以实现。

情报成本低

当然,运行模型的成本很高,它们可能需要大量计算。100 万个代币(大约相当于一本标准书籍的 2500 页)的标准 GPT4o 定价为代币输入 5.00 美元,代币输出 15.00 美元。

GPT-4o

输入:5.00 美元 / 100 万个代币

输出:15.00 美元 / 100 万个代币

相比之下,以下是您为某些 SLM 支付的费用的示例:

GPT-4o mini

输入:0.15 美元 / 100 万个代币

输出:0.60 美元 / 100 万个代币

Claude Haiku

输入:0.25 美元 / 100 万代币

输出:1.25 美元 / 100 万代币

Llama-3 8b (Groq)

输入 : $0.05 / 1M 代币

输出 : $0.08 / 1M 代币

Gemini 1.5 Flash

输入:0.35 美元 / 100 万代币

输出:1.05 美元 / 100 万代币

很疯狂吧?

当价格降到如此低时,AI 推理就会商品化,更多公司可以大规模发布 AI 产品。但当然,如果模型不具有可比性或无法产生良好的输出,成本和性能就毫无意义。

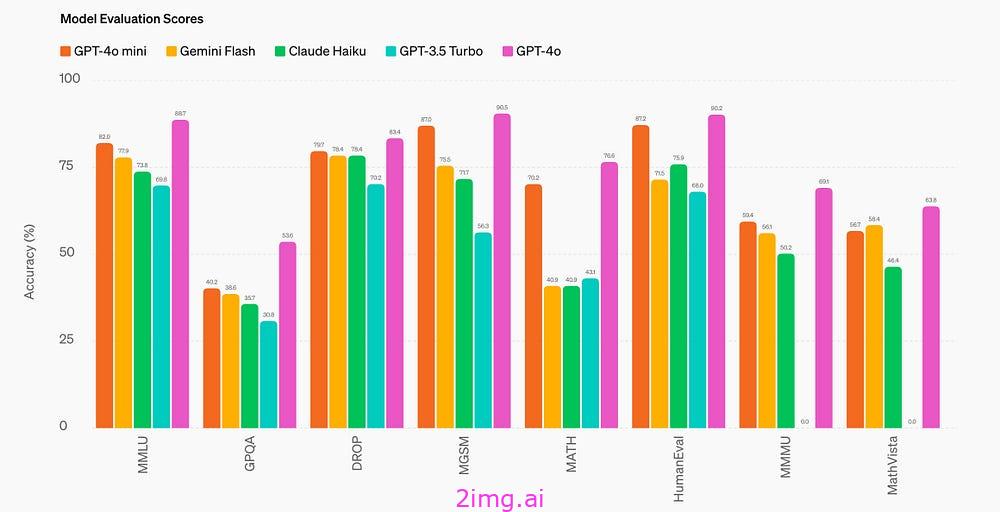

当您查看下面的图表时,请关注右侧第二个蓝绿色条,它代表 GPT 3.5 Turbo。这款 LLM 于一年前发布,该条左侧的每个较小模型都比它好很多。

来源:OpenAI- GPT4o mini 发布

那么这些 SLM 如何才能胜过 GPT 3.5 等 LLM?

这与数据的质量有关。

你只需要教科书

2023 年 5 月,担任微软生成式 AI 研究主管的副总裁 Sebastien Bubeck 和他的团队进行了一项有趣的研究。他们用一种非常规的方法创建了一个名为“TinyStories”的数据集:

他们促使大型语言模型仅使用经过精心挑选的有限词汇来编写儿童故事。

这项创新技术促成了极小语言模型的开发,这些模型仅包含约 1000 万个参数。尽管模型体积小,但出乎意料的是,它们能够生成连贯的故事,语法也无懈可击。

基于这一成功,研究人员开发了一个名为“CodeTextbook”的更复杂的数据集,使用高质量的教育内容来训练更先进的 SLM Phi-1。

微软研究院在 Phi-1 上的工作强调了高质量数据在提高语言模型在代码生成任务的有效性方面发挥的重要作用。

这就像一本精心编写的教科书可以帮助学生理解新科目。通过开发精心挑选的“教科书质量”数据,他们能够训练出一种模型,该模型在 HumanEval 和 MBPP 等关键编码基准上超越了大多数开源模型。

虽然 Phi-1 专门用于代码生成,更具体地说是“Python 编码”,但它证明了一个重要方面:

尽管他们的模型体积小 10 倍并且使用数据集小 100 倍,但仍实现了如此出色的性能。

边缘模型

小型语言模型 (SLM) 的成功正在重塑 AI 模型的发展。虽然具有高级推理能力的大型模型不断发展,但小型模型却提供了一种有价值且独特的替代方案。

它们可以在您的设备上本地运行。

“SLM 的独特优势在于......无需通过云端即可完成计算。”- Ece Kamar,微软研究实验室副总裁

智能手机、智能家居设备、可穿戴技术、汽车系统、个人电脑和平板电脑……基本上任何具有数字存储的设备都可以包含 SLM。其优势不仅在于本地处理带来的超快速度,还在于每个请求的隐私性。

SLM 有可能回答大多数请求的任务,但这种方法真正出彩的地方在于当有一个可以在需要时利用更大模型的编排层时。

因此,其理念是,请求最初由本地小语言模型 (SLM) 处理,只有在需要时才路由到更强大的世界模型。这种方法类似于 Apple 正在实施的“Apple Intelligence”,尽管它使用了专有架构。

Google 刚刚发布了运行 Gemini 多模态 Nano SLM 原生设备的 Google Pixel 9。它在 Tensor G4 芯片上每秒原生处理 45 个 token。

这意味着所有设备上的 AI 应用程序和功能都超级快并且私密。

如果计划是将语言模型交到用户手中(从字面上理解),那么没有比智能手机设备更接近实现这一目标的了。

未来在于小

如果你听马克·扎克伯格等人工智能创新者和企业家谈论人工智能的未来,他们经常会提到,人工智能的未来将不是单一的大型前沿模型,而是数百万个在边缘运行的 SLM 的协调。

未来看起来更像是在配备 AI 功能的边缘设备上运行的小型模型。低延迟、快速性能、安全,最重要的是,与其他语言模型联网。代理可能会根据用户请求协调网络。

这些设备包括你戴的眼镜、手腕上的手表以及耳朵里的耳机等各种设备。

未来的模型可能很小,但用户体验将会很大、很丰富。

1094

1094

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?