▼最近直播超级多,预约保你有收获

今晚直播:《ChatGLM3/Qwen业务案例实战》

—1—

为什么要在 MacBook 上搭建知识库?

最核心最重要的是我们手上的文档资料出于安全要求,不能随便上传到云服务,也就无法实际验证知识库的实际效用。另外对于 IT 同学来说,自己亲手搭建一个完整的方案、能灵活调整和对接各种不同的模型、评测各种模型不同的表现,也是出于对技术的探索本能使然。

使用的 MacBook 配置如下,对大模型经过量化处理(比如:int8)后,可以流畅运行。

—2—

知识库的架构设计

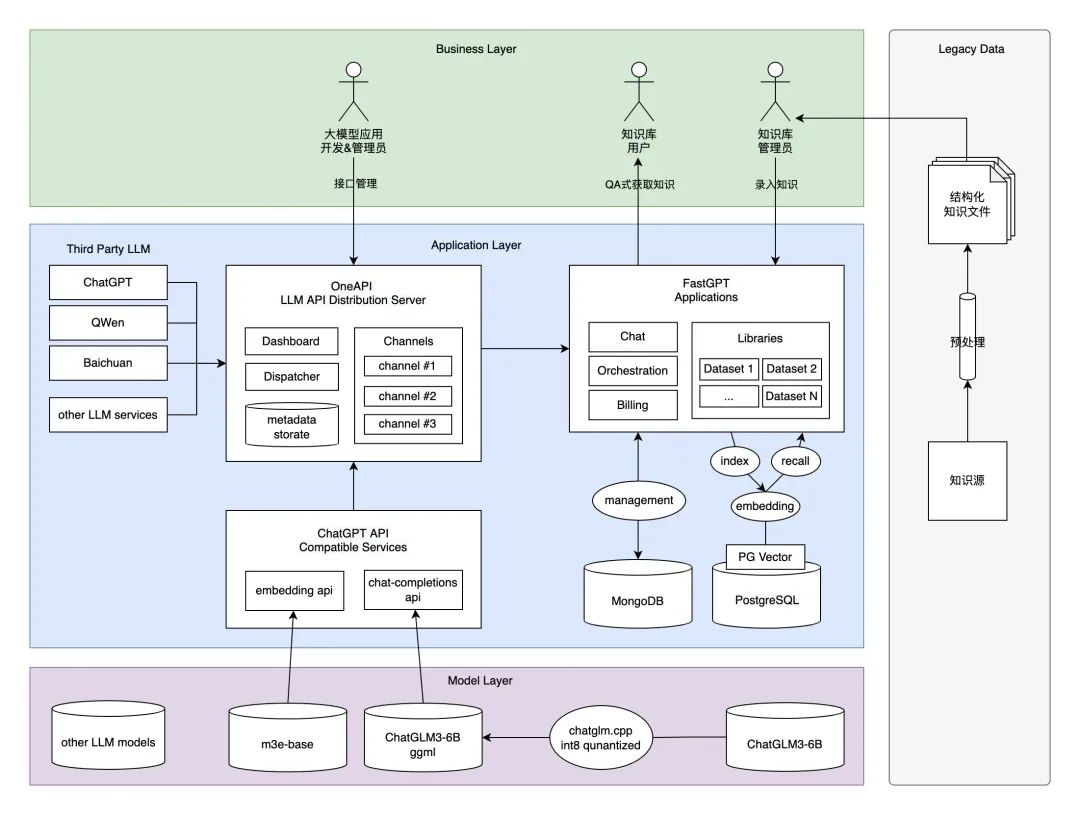

基于一台 MacBook 搭建部署的架构设计如下图,在这套架构设计中,我们采用了实力排上游、并且对企业和学术都友好的国产开源大模型 ChatGLM3-6B。

并采用了基于 m3e-base 模型的 embedding search RAG 方案。基于这两个模型封装和 ChatGPT 兼容的 API 接口协议;通过引入 One API 接口管理 & 分发系统,形成统一 LLM 接口渠道管理平台规范,并把封装好的接口协议注册进去;搭建与 Dify.ai 齐名开源大模型知识库平台管理系统 FastGPT,实现集私有知识数据源预处理、嵌入检索、大模型对话一体的完整知识库应用流程。

麻雀虽小五脏俱全,最终形成一套既满足商用标准、又能在 MacBook 跑起来的的方案。虽然智能程度和实际需求还有一定差距,但至少我们在不用额外购买显卡或云服务的情况下,以最小成本部署运行、并且能导入实际业务数据(如:设计文档、业务流程文档、项目管理文档、技术分享文档等等)进行实操验证,值得每位工程师都来动手尝试一下。

更详细的架构设计剖析,今晚20点直播详细剖析,请同学点击下方按钮预约直播。

—3—

知识库的部署设计

基于 MacBook 的部署方案分为四个主要环节、14个具体步骤,只要一步步实操下去,每位 IT 同学都可以在自己的 MacBook 上拥有属于自己的私有大模型知识库系统,步骤清单如下:

部分步骤可以简单地通过 Docker 镜像一键部署完成,但本着对细节一杆子插到底的部署思路,还是采取了纯手工作业的方法。

由于需要动手实际操作,更详细的实操步骤,放在今晚20点直播实操进行,直播精彩看点:

1、ChatGLM3 核心能力和架构设计剖析

2、基于 ChatGLM3 构建 AI 电商中台/知识库案例和部署

3、基于 ChatGLM3 构建推荐系统案例和部署

请同学点击下方按钮预约直播,咱们今晚20点直播见!

带你全面掌握 AIGC 技术体系:大模型架构内核、Fine-tuning 微调、LangChain 开发框架、Agent 开发、向量数据库、部署治理等核心技术,扫码一键全部预约直播!

END

本文介绍了在MacBook上搭建知识库的必要性,特别是对于不能上传云端的安全需求。通过使用ChatGLM3和开源模型,作者提供了一个详细架构设计和部署步骤,包括直播中将深入剖析大模型能力、案例和部署技术。

本文介绍了在MacBook上搭建知识库的必要性,特别是对于不能上传云端的安全需求。通过使用ChatGLM3和开源模型,作者提供了一个详细架构设计和部署步骤,包括直播中将深入剖析大模型能力、案例和部署技术。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?