1. 摘要翻译

本篇文章中,我们提出了一个新颖的损失函数,称之为LMCL,来给出loss函数的一种不同思路。更确切地说,我们用L2范数(欧几里得范数)归一化softmax损失函数的特征和权值向量,消除半径方差的影响,重构为余弦损失函数。基于此,提出了一个余弦边界项来更深地最大化角度空间地决策边界。结果是,通过正则化和余弦决策边界地最大化的优点,成功实现了类内间距的最小化和类之间距离的最大化。我们称自己的模型YMCL为cosFace。

2. 研究现状(前作的不足)

之前有很多基于角度进行训练优化的方法(1,3,5),但它们有一些缺点:

- 原文的loss函数定义在角度空间上,cos(mθ1) = cos(θ2), 由于余弦函数的非单调性,优化起来有难度。

- 不同分类的决策边界可能不同,即每个类的聚合程度不同,使得模型的分辨能力下降

3. 新的loss函数

3.1 推导过程

注意该函数与第5个loss函数之间的区别

第五个loss中m加在角度上,是做角度域上的变换

而这个公式是在cos域上进行了变换,解决了上述的第一个问题。

3.2 正则化的必要性

原来的函数同时包含欧几里得和余弦两个部分的损失需要优化,对余弦部分的学习会相对弱一些。

Particularly, the adaptive L2-norm of easy samples becomes much larger than hard samples to remedy the inferior performance of cosine metric.

特别的,简单样本的L2范数变得比困难样本大许多,以此弥补余弦空间的不良表现。

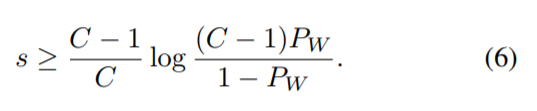

3.3 参数s的选择

在将W的长度归一化为1之后,||x|| = s。此时,所有的样本都在一个超球体上,s决定了超球体的半径。这个半径该如何选择呢?

s不能太小,直觉上的理解是,s太小了,超球体的表面积很小,挤不下这么多点。

其中,C是分类类别的数目,Pw期望的最小后验概率

3.4 关于margin控制变量m的选择

C表示分类类别的数目,K表示特征数目

m越大,类间距离也就越大。但是m的值是有上限的。m过大可能导致分类的结果不收敛,或者各个类的中心位置重叠。

1248

1248

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?