Quote:深度学习系统的质量导向测试

摘要:

一个流行的方向是深度学习测试——也就是说,给定测试的属性,通过模糊测试或借助某些测试指标的引导搜索来发现深度学习系统的缺陷。然而,最近的研究表明,大多数现有的DL测试方法通常使用的神经元覆盖度量并不一定与模型质量相关(例如,最常被研究的模型属性是鲁棒性),并且也不是测试后对模型质量的置信度的有效度量。在这项工作中,我们通过提出一种名为 QuoTe(即面向质量的测试)的新颖测试框架来解决这一差距。 QuoTe 的关键部分是对(1)每个测试用例在增强相关模型属性(通常通过再训练)方面的价值和(2)模型属性改进的收敛性的量化度量。 QuoTe利用提议的度量标准来自动选择或生成有价值的测试用例,以提高模型的鲁棒性和公平性。提议的度量标准也是一种轻量级但强大的指标,可以用来衡量改进的聚合程度。

介绍:

在测试DL系统的给定模型属性(如健壮性和公平性)时,有两个关键因素。第一个关键因素是测试充分性度量(为了简单,我们称之为测试度量),它用于评估测试用例或测试套件的质量。多种稳健性测试指标被提出,包括神经元覆盖率[55]、多粒度神经元覆盖率[45]、MC/DC覆盖率[64]、组合覆盖率[44]和惊喜充分性[35]。通常的思路是在基于神经元网络模型的不同抽象层次所定义的某个子空间中尽可能地探索多样性,如神经元激活[55]、神经元激活模式[45]、神经元激活条件[64]、神经元激活向量[35]。第二种方法是用于生成测试用例的方法,通常是在测试度量标准的指导下对一组种子输入进行突变。现有的测试用例生成技术,如DeepXplore[55]、DeepConcolic[64]、DeepHunter[81]、DeepCT[44]、ADAPT[40]等,大多是为了提高神经元覆盖率指标而设计的。虽然现有的测试方法在一定程度上有助于暴露DL系统的缺陷,但最近的研究却不幸地发现神经元覆盖度量不利于提高模型的鲁棒性[13,26,43]。因此,与传统的软件测试的情况不同,传统的软件测试在修复了测试中暴露的缺陷之后,软件质量肯定会得到提高,而使用生成的测试用例进行再训练之后,人们可能不容易提高DL系统的质量。

在本工作中,我们提出了一种新的DL测试框架QuoTe(即面向质量的测试)来解决现有DL测试方法的局限性,该框架设计时考虑了DL模型质量增强,旨在弥合测试和模型质量增强之间的差距。如图1所示,QuoTe与现有的神经元覆盖指导测试工作在以下几个重要方面有所不同。第一,以质量为导向。对于给定的属性(例如,健壮性或公平性),QuoTe将用户定义的关于该属性的需求作为输入,并将再训练过程集成到测试管道中。此要求在之前是为了保证质量而提供的。例如,用户可能要求“增强的模型应该减轻80%的对抗实例(可能来自独立验证)”。QuoTe然后通过生成测试用例和对模型进行再训练以满足需求,迭代地改进模型的质量。其次,在引用中,我们提出了一组新的轻量级度量标准,它们与用于测试的属性密切相关。度量标准可以定量地度量用于模型增强的每个测试用例的相关性,并被设计为有利于能够显著提高模型质量的测试用例。

背景:

测试用例选择:测试用例选择对于在有限的再训练预算下改善模型属性和减少标记工作至关重要 。选择的关键是定量衡量每个测试用例的价值。 DeepGini [17] 最近被提出选择最有可能被模型错误分类的信息最丰富的测试用例来指导模型再训练过程,这被证明比基于神经元覆盖的指标在提高模型鲁棒性方面更有效。 MCP [61] 是另一种基于不确定性的度量,它通过 top-2 概率选择接近决策边界的测试用例。利用包括 LSA(基于可能性)和 DSA(基于距离)在内的惊喜充分性 指标来选择具有较大惊喜值的测试用例 [7]。 PRIMA [75]被提出通过基于设计的变异规则的智能变异分析来选择测试用例。最近的一项工作 DAT [28] 对不同数据分布下模型增强的几种选择指标的性能进行了实证研究。

模型再训练被证明是提高模型质量的有效方法,通过修正模型对测试算法(例如DeepXplore [55] 和 DeepTest [66])生成的测试用例的预测结果。重新训练通常是通过将暴露漏洞的测试用例添加到原始训练数据集中来完成,而模型结构和损失函数等训练设置保持不变。例如重新训练 [3, 16, 17] 或修复 [42, 84]。这种改进是通过修补传统软件测试中发现的错误来保证的(假设回归错误并不常见)——也就是说,传统软件的错误揭示测试的有用性不需要任何理由,而对于深度学习系统来说,测试的有用性是必要的。只能通过考虑再训练步骤来判断情况。换句话说,每个测试用例通过再训练对质量改进的贡献可能有很大不同。

验证集的选择:Dv的选择对于模型质量的实际评估至关重要,并且如何形成Dv仍然是一个开放的研究问题。在实践中,用户经常采用不同的对抗性攻击(例如,用于鲁棒性的 PGD [48] 和用于公平性的 ADF [87])来使用对抗性/歧视性样本构建这样的验证集。这种经验观点易于测试,有助于 QuoTe 有效比较测试(重新训练)前后模型的质量。此外,它也很实用,因为它将评估与许多现有的对抗性攻击和测试技术联系起来。

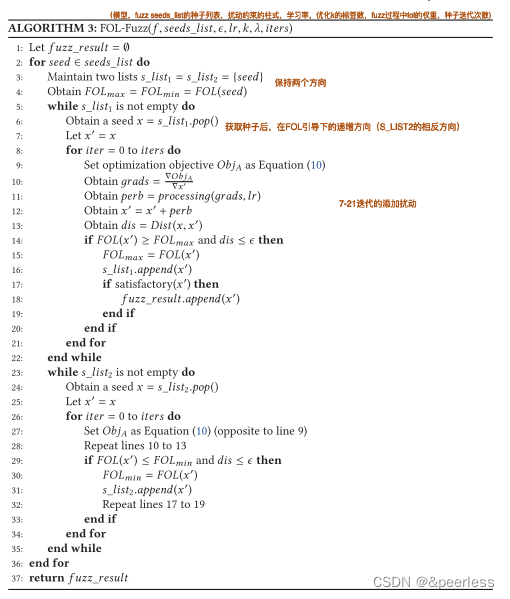

模糊算法:

3201

3201

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?