Generalist:解耦自然和鲁棒泛化

Code is available at https://github.com/PKU-ML/Generalist.

摘要:

通过标准训练得到的深度神经网络一直受到对抗性例子的困扰。虽然对抗性训练证明了它抵抗对抗性例子的能力,但不幸的是,它导致了自然泛化不可避免的下降。为了解决这一问题,我们将自然泛化和鲁棒泛化从联合训练中解耦,并为每一种方法制定不同的训练策略。具体来说,我们没有最小化这两个泛化错误的期望的全局损失,而是提出了一个双专家框架,称为Generalist。在这个框架中,我们同时用任务感知策略训练基础学习者,这样他们就可以专注于自己的领域。在训练过程中,每隔一段时间,对基础学习者的参数进行采集和组合,形成一个全局学习者。然后将全局学习器作为初始化参数分配给基本学习器进行持续训练。在理论上,我们证明了一旦基础学习者得到良好的训练,多面手的风险就会降低。大量的实验验证了Generalist算法的适用性,在对自然例子保持较高的准确性的同时,对对抗例子保持相当的鲁棒性。

对抗训练:对抗训练——终极数据增强? - 知乎

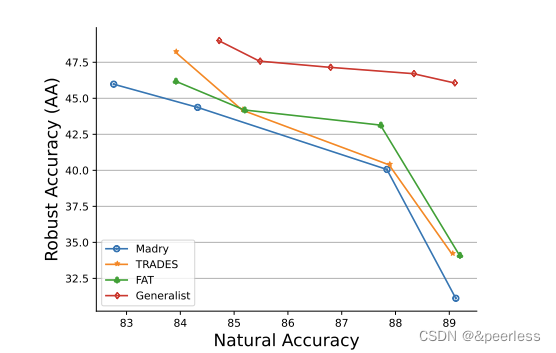

对比:由于DNN的脆弱性,人们提出了多种防御方法来保护其免受敌对性攻击。其中一种表示技术是对抗性训练(AT),它动态地注入扰动的示例,这些示例欺骗当前模型,但保留正确的标签到训练集中。尽管取得了这些成功,这种对抗性训练的尝试在自然精度和鲁棒精度之间找到了一种折衷,也就是说,当最坏情况下的受扰图像的误差减小时,未受扰图像的误差会出现不希望出现的增加,如图1所示。之前的研究甚至认为自然精度和鲁棒精度从根本上是不一致的,这表明只有在破坏自然泛化的情况下才能实现鲁棒分类器。然而,以下的研究发现,这种权衡可以通过一种迂回的方式来解决,例如合并额外的标记/未标记数据,或放松扰动的幅度,生成合适的对抗例子,以获得更好的优化。但这些工作都集中在用于训练的数据,而我们建议从本文的训练范式的角度来处理权衡问题。

框架:

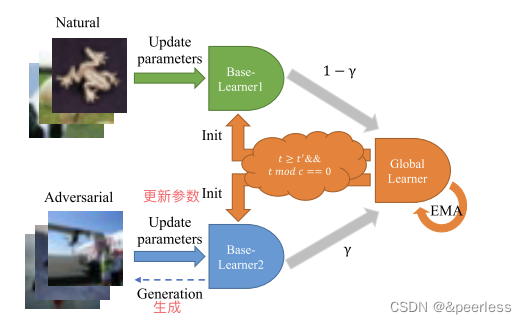

受分治法的启发,我们将对抗性训练的目标函数解耦为两个子任务:一个子任务用于自然示例分类,另一个子任务用于对抗性示例分类。具体来说,对于每个子任务,我们在共享相同的模型体系结构的同时,用任务特定配置训练一个基于自然/对抗数据集的基础学习者。在训练过程中,每隔一段时间收集并组合基础学习者的参数,形成一个全局学习者,作为初始化参数分配给基础学习者进行继续训练。我们将这个框架命名为Generalist。

上图,它由两个在各自领域内分别训练的基础学习器和一个全局学习器组成,该全局学习器通过训练过程聚合基础学习器的参数。全局学习器以固定的频率将其积累的知识分配给每个基学习器,基学习器以此为基础继续学习。

背景知识:

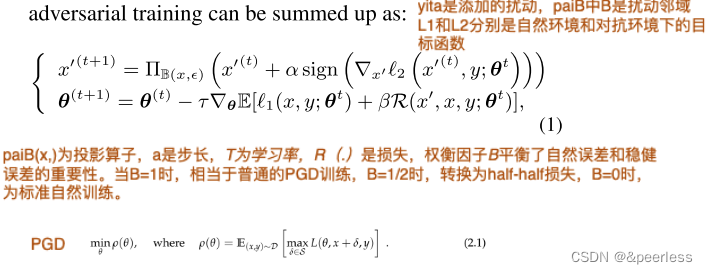

1、标准的对抗训练:是通过向 x 添加难以察觉的扰动 ε ∈ Rd 来生成恶性示例 x′。生成的对抗性示例 x' 应该位于 x 附近,这样它在视觉上看起来与原始示例相似。这个邻近区域 Bε(x) 锚定在 x 上,边心点为 ε,可以定义为 Bε(x) = {(x′, y) ε D2 | ∥x−x′∥∞≤ε}。对于对抗性训练,它首先生成对抗性示例,然后更新这些样本的参数。对抗训练的迭代过程可以总结为:

2、多任务学习和元初始化:

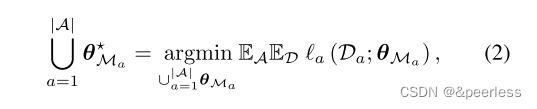

多任务学习(MTL)是通过不同模型的联合训练来提高跨任务的性能。 考虑一组包含数据分布和损失函数的赋值,定义为A={D,L},相应的模型{Ma}|a| a=1由可训练张量θma参数化。 在MTL中,这些集合具有非平凡的成对交集,并在一个联合模型中进行训练,以找到每个任务的最佳参数,

乍一看,我们的方法通才与MTL直接相关,因为它们都倾向于为不同的源学习特定的预测模型。 然而,通才与MTL有很大的不同,在MTL中,多个任务仍然是在一个统一的形式下联合学习的,而在通才中,每个任务都可以通过异构策略来优化。

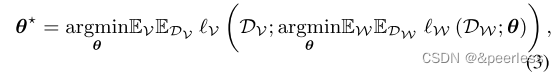

元学习是训练一种能够快速适应新任务的模型。假设A分为不重叠的分割V和W,首先在训练集上对模型进行训练,然后在一组任务上用一个小的验证集进行引导,使训练后的模型能够很好地适应新的任务:

元学习通常被设计为对不可见的任务进行泛化,而MTL的目标是处理一系列已知的任务。尽管如此,我们的通才方法使用元学习技术为基础学习者设置良好的初始化,以便在任务之间转移知识。

算法:

与物理世界的多面手一样,我们建议的多面手可以在测试期间处理自然和对抗样本。它由不同的基础学习者组成,逐渐专业化于各自脱节的领域。随着时间的推移,他们扩展了他们的专业知识,分别包含知识。从一个起点出发,通才带着装满广泛经验的手提箱走到任何地方(即全球学习者传播积累的知识,每个专家在某个时期后重新初始化学习)。

提出的算法的总体流程如算法1所示,主要包括两个步骤:在其分配的数据分布Da中优化基学习器θa的参数以及将全局学习器θg的参数分配给所有基学习器。基础学习器和全局学习器共享相同的架构,即 M1 =M2 = · · · =M|A|。由于我们只关注在我们的设置中识别自然示例和对抗性示例,因此任务 W 的总数设置为 2。

任务感知基础学习者:

给定权衡问题的全局数据分布 D,如第 2 节所示,D1、D2 服从训练数据 DW 的分布。自然图像 (x, y) ∼ D1 而对抗样本 (x', y) ∼ D2 由方程生成。所以基学习器的训练过程就是解决式(1)的内部最小化问题。以分布式的方式进行不同的分布:

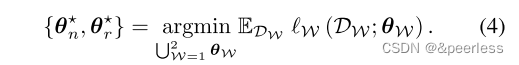

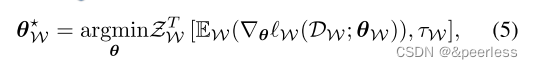

具体来说,在这个过程中,基学习器fθn和fθr被分配不同的子问题,只需要分别访问它们自己的数据分布。请注意,两个基础学习器以互补的方式工作,这意味着参数的更新在基础学习器之间是独立的,并且全局学习器始终收集两个基础学习器的参数。因此每个基学习器的子问题定义为:

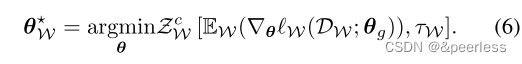

其中任务感知优化器 ZT W(·,·) 在 T 轮中搜索子问题 W 上的最优参数状态 θ⋆ W。损失函数也可以是特定于任务的,并分别应用于每个基础学习器。考虑最小化自然误差和鲁棒误差中的 0-1 损失是很自然的,然而,解决优化问题是 NP 困难的,因此在计算上很难处理。在实践中,我们选择交叉熵作为 ℓ1 和 ℓ2 的替代损失,因为它很简单但足够好。

来自全局学习器的初始化:

在最初的训练阶段,基础学习者是较少的工具,因为他们没有充分的学习。直接初始化基础学习者的参数可能会误导训练过程,并在混合过程中进一步积累偏差。因此,我们从一开始就留出t’epoch,对基类学习者进行充分的训练,并通过指数移动平均(EMA)优化,将基类学习者搜索轨迹上的状态累加起来,计算为:θg←α ' θg+(1−α ')(γθr+(1−γ)θt),其中α '为EMA的指数衰减率,γ为基础学习者的混合比。然后,当每一个基本学习者在其领域受过良好的训练时,他们就会从全局学习者的参数中学习初始化。因此,每个间隔的每个基学习器的优化可以表示为式6:

注意,θg同时包含θn和θr,这意味着始终存在一个由不同于当前子问题的分布梯度信息更新的项。这种机制可以在给定的任务中快速学习,提高泛化能力,并且加速只适用于给定的任务中相应的基础学习者(证明见附录B.1)。

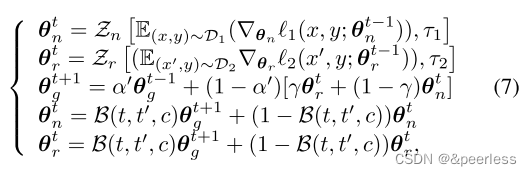

综上所述,通过降低θr、θn的梯度并混合它们,可以构造出通才的学习进度。算法1的计算步骤可概括为式7。其中B(t, t ', c)是一个布尔函数,只有当t≥t '且t mod c == 0时才返回1,否则返回0。Zn和Zr是自然训练和对抗性训练任务的优化器。

理论分析:

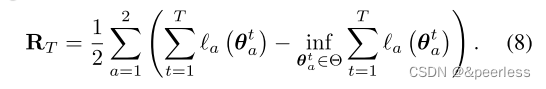

对于自然训练赋值a1和对抗性训练赋值a2,考虑一个算法为两个基值学习者生成状态为1和2的轨迹,两个基值学习者对其对应的损失函数1、2的遗憾为

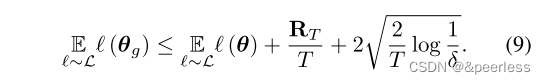

最后一项得到每个任务a的理论最优参数θ⋆a, RT为每个基学习器的参数与每个任务理论最优参数的差值之和。根据定义,我们可以给出Generalist训练的分类器对RT的期望误差的上界为: 考虑具有遗憾界RT的算法,对于任意参数状态θ∈Θ,给定凸代理求值函数序列ℓ,生成两个基学习器的状态轨迹:Θ 7→[0,1]a∈a从某个分布L中提取i.i.d.,两个任务上的全局学习器θg在测试集上的期望误差可至少以1−δ的概率有界:

因此,上述不等式表明,任何有利于减少每个任务误差的策略,只要使RT变小,就会降低全局学习者的误差范围。考虑到通才将权衡问题划分为两个独立的任务,定理1保证了通才训练的全局学习者给出的风险上界,当每个任务的错误降低时,会降低。在实践中,我们可以应用定制的学习率策略、优化器和加权平均来保证每个基学习者的误差减少。

实验:

实验设置:

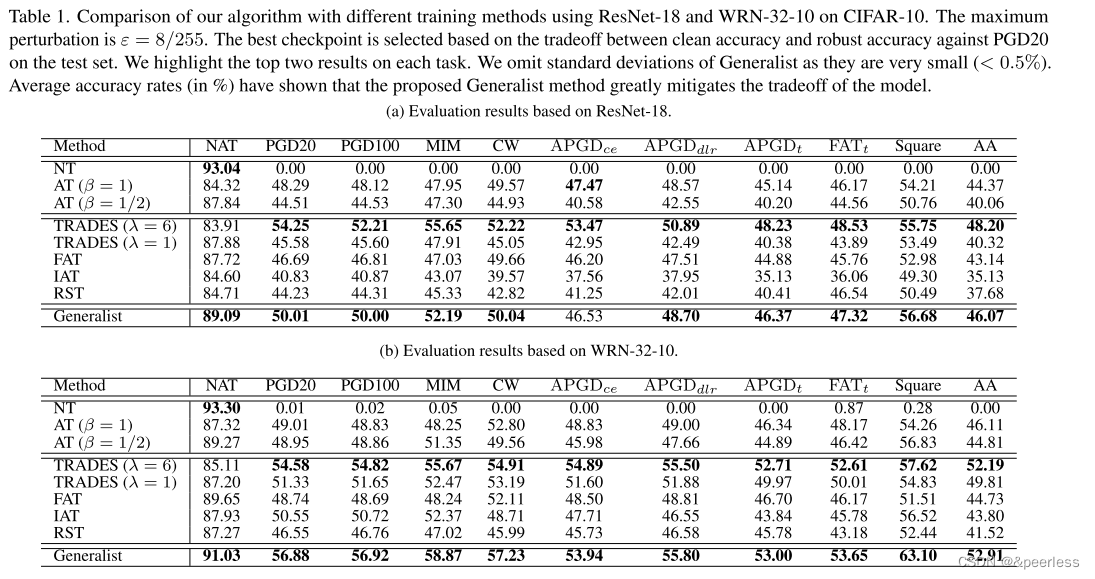

我们在 L∞ 范数下在基准数据集 MNIST、SVHN、CIFAR-10 和 CIFAR-100 上对 ResNet-18 [16] 和 WRN-32-10 [44] 进行了一系列实验。基线。我们选择六种方法进行比较:使用 PGD 的 AT(等式 1 中的 β = 1)[22]、使用 halfhalf 损失的 AT(等式 1 中的 β = 1/2)[15]、具有不同 λ 的交易 [45 ]、友好对抗训练(FAT)[46]、插值对抗训练(IAT)[19]和鲁棒自我训练(RST)[28]使用标记数据进行公平比较。对于 Generalist,我们设置 t′ = 75,最佳混合策略将在 4.2.2 节中讨论。评估。为了评估所提出方法的鲁棒性,我们应用了几种对抗性攻击,包括 PGD [22]、MIM [13]、CW [8]、AutoAttack (AA) [11] 及其所有组件(APGDce、APGDdlr、APGDt、FABt、和方形攻击)。

在基准数据集上权衡性能:

为了全面展示我们的多面手方法的威力,我们在表1中展示了ResNet-18和WRN32-10在CIFAR-10上的结果。在表1(a)中,与几种鲁棒方法训练的模型相比,通才不断提高标准测试误差,同时在相同水平上保持对抗鲁棒性。更具体地说,通才获得了第二高的标准准确度89.09%(仅低于自然训练(NT)获得的93.04%),与此同时,对AA的稳健准确度为46.07%,在交易中保持在48.2%。如果我们迫使TRADES达到和通才一样的清晰准确性水平(89%),那么TRADES对APGD的稳健性将下降到30%(见附录A.4中的TRADES),这比通才要差得多。这意味着在联合训练框架中,即使配备了先进的损失函数,也很难获得可接受的鲁棒性,但仍能保持89%以上的净准确度,而由于我们只使用了朴素的交叉熵损失,所以通才的改进是显著的。FAT通过自适应减小PGD步长来进行权衡,这对鲁棒性仍有很大影响。与FAT相反,通才是唯一一种具有89%以上的清晰精度和46%以上的鲁棒精度的方法。我们应该强调的是,通才最终得到的模型与其他训练模型的大小相同。就训练时间而言,多面手同时执行NT和naive,但NT的代价可以忽略不计,因此多面手的开销比交易要小,而且无论多面手的哪个串行和并行版本都比交易要快(见附录A.4)。

当谈到 WRN32-10 时,事情变得更加明显。在表1(b)中,Generalist和NT的测试自然准确率之间的差距缩小到2.27%,与FAT实现的第二高自然准确率(NT除外)相比,标准测试误差相对下降了3.65%。同样值得注意的是,准确性的提高并没有损害 Generalist 的鲁棒性,相反,Generalist 甚至在多种类型的对抗性攻击中表现优于 TRADES。特别是,我们发现 Generalist 的标准测试误差为 6.7%,而 TRADES with λ = 6 的标准测试误差仅为 14.89%。其中,Generalist 在 PGD20/100、MIM、CW、FATt 和 Square 中鲁棒性的提高非常显着。此外,AA(不同攻击的集合,也是迄今为止最强大的自适应对抗攻击)上的最佳性能证明了 Generalist 的可靠性。同样,只有 Generalist 能够获得高于 52% 的 AA 稳健准确度以及高于 90% 的干净准确度。需要强调的是,这些特征证实了Generalist的实用性。简而言之,Generalist 在不损失自然准确性的情况下不断提高鲁棒性。 MNIST、SVHN 和 CIFAR-100 基准数据集的更多结果参见附录 A.2 和 A.3。

消融实验:

在这一部分中,我们进行了一些消融来分析通才框架。如算法 1 所示,有两个因素控制全局学习器的准确性和鲁棒性之间的权衡:通信频率 c 和混合比 γ。在这里,我们研究这些参数如何影响性能。如无特殊说明,实验均在 CIFAR-10 上使用 ResNet-18 进行。

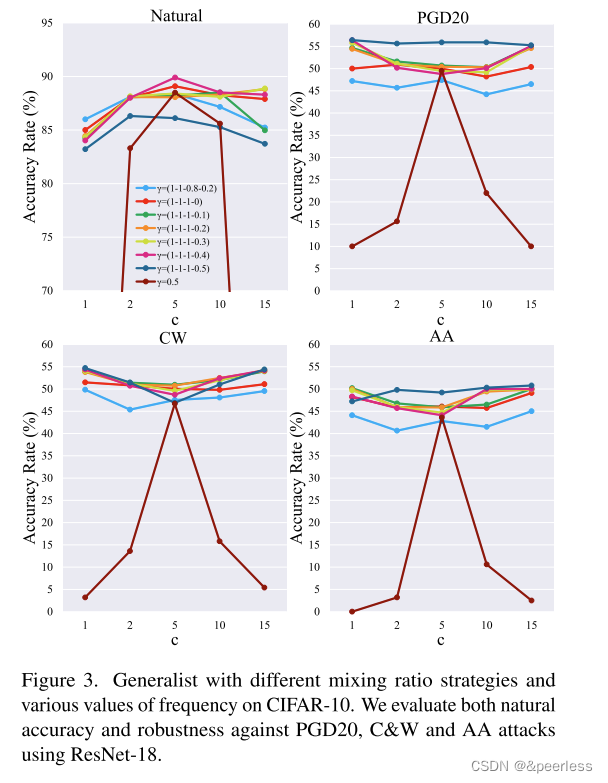

1、γ 的混合策略

在通才中,当基础学习器逐渐受到良好训练时,γ 通过平衡个体对全局学习器的贡献来控制权衡。请注意,γ 是一个标量,但我们没有明确为其分配固定值。相反,我们设置了几个断点,并使用分段线性函数在训练过程中动态调整值以减小。

结果如图3所示。括号中的数字是第0/40/80/120个epoch的值。如果 γ 变小,负责自然分类的基础学习器对全局学习器有显着的影响。在所有配置中,最好的一种是在第 75 个 epoch 之后将 γ = (1, 1, 1, 0) 和 c = 5 应用于全局学习器。与 γ 在后期衰减的策略相比,γ = (1, 1, 0.8, 0.2) 显示出较低的标准和鲁棒精度,证实更复杂的初始化可能对精度和鲁棒性都有用。随着动态策略最后一个断点的增加,鲁棒精度逐渐提高;而标准精度则略有下降。我们还研究了 γ 的静态/动态策略。通过观察 γ = 0.5 和 γ = (1, 1, 1, 0.5),预定的混合策略使 Generalist 对各种攻击更加鲁棒。

2、通讯频率c

在 Generalist 中,c 控制全局学习器和基础学习器之间的通信频率。因此,对于 c,采用固定混合比策略,我们将通信频率从 1 扫描到 15。结果如图 3 所示,我们得到以下观察结果。直观上,较大的 c 意味着基学习器与全局学习器进行初始化的通信频率较低,因此它们几乎没有机会交替转向两个最优解流形。但具体而言,自然准确率在达到峰值后会回落,而不同对抗环境中的鲁棒准确率则大致呈现出低谷。这样的观察表明,过多/过少的通信会对标准精度产生负面影响,但会导致相对较高的鲁棒性。它捕获了关于 c 的自然误差和鲁棒误差之间的权衡。

3、参数选择

在实践中,在不知道目标模型或数据集的情况下选择混合参数γ和通信频率c是很自然的。我们可以在特定的架构和数据集上找到最佳参数,然后将其转移到其他模型/数据集上,即在一个模型/数据集上选择最佳的 γ、c 及其策略,然后用于其他模型/数据集,这仍然有效。具体来说,对于附录 A.2 和 A.3 中所示的 MNIST/SVHN/CIFAR100 上的实验结果,我们只是在 CIFAR10 上找到最优参数和更新策略,并将类似的 γ 和 c 应用在目标数据集和架构上,而无需太多精细处理。调整。表现还是非常不错的。

为个人定制的政策:

如上所述,与标准联合训练框架相比,Generalist 的主要优点之一是每个基础学习器都可以为自己的任务自由定制相应的策略,而不是对所有任务使用相同的策略。在这一部分中,我们研究通才在与多种技术合作时是否表现更好。

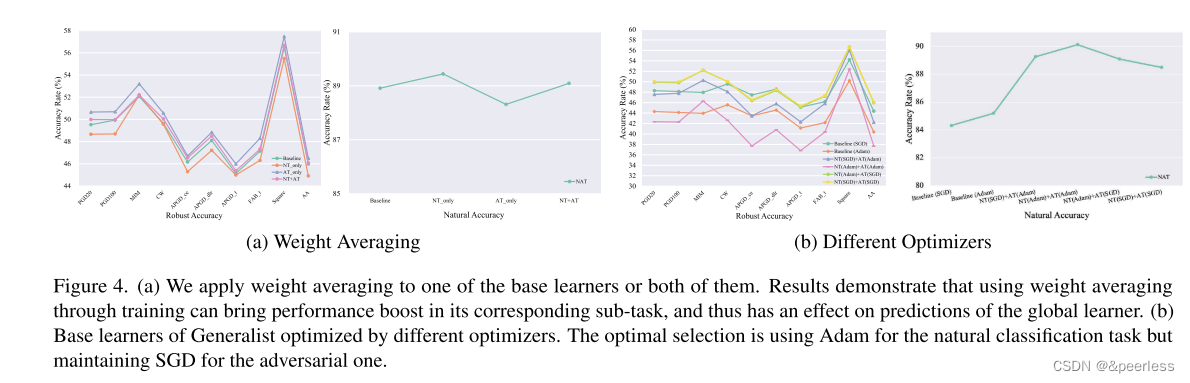

平均权重。最近的工作[17,29,37]表明,权重平均(WA)极大地提高了自然和鲁棒的泛化能力。通过训练过程快照所有历史模型的平均参数,以动态构建集成模型。然而,这种技术无法同时提高联合训练框架的准确性和鲁棒性。因此,我们将WA单独引入到基础学习器中。结果如图4(a)所示。我们在 NT (NT_only) 或 AT (AT_only) 或两者 (NT+AT) 中使用 WA。总体而言,结果证实,在两个基础学习器都利用 WA 后,全局学习器的性能可以进一步提高。但不幸的是,如果只有一个基础学习器配备了 WA,就会发生明显的权衡。例如,NT_only的标准测试准确率不断提高,但代价是防御攻击能力的下降。一个可能的原因是 WA 隐式控制基础学习器的学习速度。事实上,在子任务中,具有 WA 的基础学习器比没有 WA 的基础学习器成为专家要快得多,这意味着快的学习器与慢的学习器不一致。这个结果很重要,因为它不仅说明了通才的潜力来自其基础学习者,而且还确定了未来改进权衡的关键挑战。

不同的优化器。我们还研究了为不同任务设计的优化器的效果。我们选择 AT (β = 1),使用带有动量的 SGD 和 Adam,通过联合训练优化分段学习率计划作为基线。 Adam 的初始学习率为 0.0001。我们在每个子问题中交替应用这两个优化器。结果比较如图4(b)所示。我们可以看到,Adam 对抗训练的模型与 SGD 训练的模型之间的鲁棒精度差距很大。配备 Adam 的所有三种方案,即 NT (Adam)+AT (Adam)、NT (SGD)+AT (Adam) 和 Baseline (Adam),在对抗性攻击评估时都比使用 SGD 的方案表现更差。但另一方面,通过比较Baseline(Adam)和NT(Adam)+AT(SGD)的结果,证实了在数据分布方面适当的优化方案可以有效地提高相应的性能,同时又不会忽视对方。这不仅证明了 Generalist 将任务感知任务与联合训练脱钩的必要性,而且还表明使用 Adam 可能不是鲁棒性下降的主要原因。它只是不适合 AT 的外部和内部优化。此外,虽然最好的结果仍然来自使用SGD,但不同任务的学习率可以定制,这在联合框架中是不可行的,如附录A.5所示。

可视化:

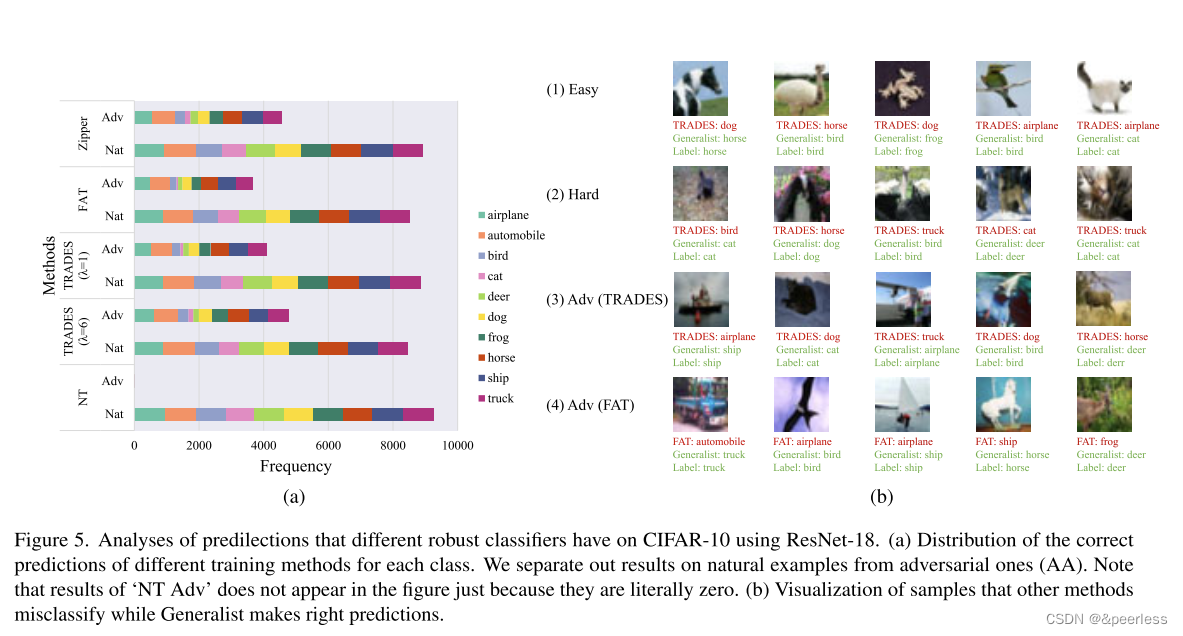

考虑到所提出的方法在鲁棒性没有严重下降的情况下实现了令人印象深刻的清洁精度,我们自然会问,与鲁棒方法相比,Generalist 获得了哪些详细改进。因此,我们进一步研究鲁棒分类器容易做出的预测。如图5所示,我们提供了两个视角来分析不同AT方法训练的分类器的差异。

为了广泛研究该案例,我们对具有不同 λ、FAT 和 Generalist 的 NT、TRADES 进行实验,然后在图 5(a) 中绘制每个类别的所有方法的正确预测的分布。乍一看,我们注意到动物更容易被错误分类,特别是自然场景中的猫/狗和对抗场景中的猫/鹿。此外,通过标准自然训练训练的分类器并不总是优于对抗性训练的分类器。事实上,他们在大多数类别上的技能是相同的,结果是由特定类别(例如鸟、猫和狗)决定的。通才在自然任务上与NT并驾齐驱,同时在对抗AA攻击的困难项目(例如猫和鹿)上促进了更高的改进。

在图 5(b) 中,我们显示了测试数据集中的特定样本,这些样本被鲁棒分类器(TRADES 和 FAT)错误分类,但被我们提出的方法识别,包括自然样本(前两行)和对抗样本(最后两行)行)。这里,第一行显示的图像是简单的图像,其中前景物体从清晰的背景中脱颖而出,而困难的样本是指那些具有混乱的背景和混乱的物体的图像。值得注意的是,TRADES 不仅在具有复杂背景或模糊对象的困难示例上表现不佳,而且在简单示例上也表现不佳。例如,第一行中的每个图像通常都是简单且规则的,但是 TRADES 无法将它们分类到正确的类别中。对于这个问题的一个合理的解释是,TRADES 与 Generalist 不同,缺乏一套专门为自然分类任务设计的支持措施,因此有必要强调子任务的设计差异化。

另一个有趣的发现是,尽管 TRADES 和 FAT 都可以构建强大的分类器,但它们仍然依赖于虚假的背景信息,因此在遇到背景相似但对象不同的图像时很容易被欺骗。这种现象可以从第一行第四张和第五张图像(以白色/蓝色背景为证据)和第四行第五张图像(被绿色背景混淆)的错误分类得到验证。但是,通才能够筛选前景对象的不变特征,同时忽略与自然和对抗环境中的类别虚假相关的背景信息。总体而言,Generalist 展示了其区分接近决策边界的困难样本的能力以及学习背景不变分类器的潜力。

总结:

在本文中,我们提出了一个名为 Generalist 的双专家框架,用于改善自然泛化和鲁棒泛化之间的权衡问题,该框架训练两个负责互补领域的基础学习器,并收集它们的参数来构建全局学习器。通过与联合训练范式解耦,每个基础学习器都可以根据数据分布运用定制策略。我们提供理论分析来证明任务感知策略的有效性,并且广泛的实验表明 Generalist 更好地减轻了准确性和鲁棒性的权衡。

5839

5839

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?