一、机器学习

简单讲就是:找函式

1.1 机器学习分类:

1、Regression:The function outputs a scalar.

2、Classification:Given options(classes), the function outputs the correct one.

选项可以是多个

3、Structured Learning:Creat something with structure (image, document)

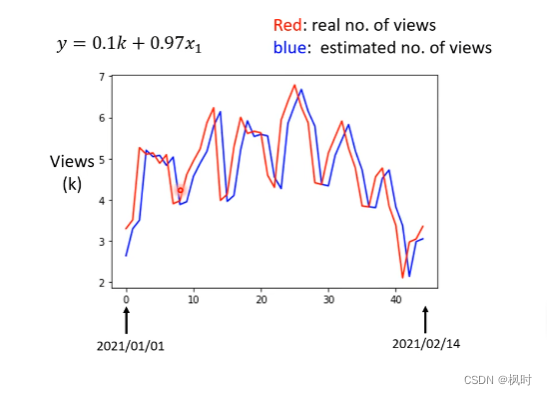

1.2 例子:推测油管点阅次数

第一步:根据已有的数据进行训练,求解假定的预测模型

step1: Function with unknown parameters

step2: Define loss from training data L(b,w):计算真实值和预测值的差距

可以采用绝对值误差mean absolute error(MAE)、均方误差mean square error (MSE)等等

step3: Optimization 找w*、b*使L(b,w)最小

step1+step2+step3=Training,使用2017-2020已知的数据

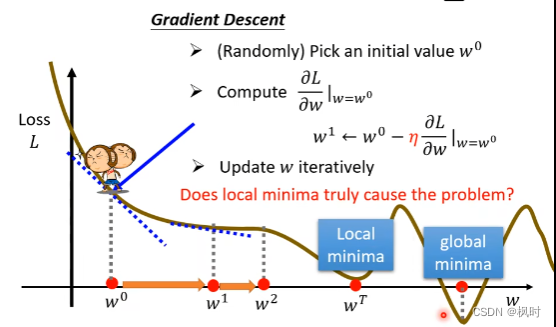

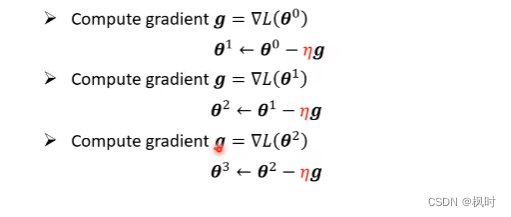

例如使用Gradient Descent梯度下降法:

首先,假设只考虑w:

1:(Randomly) Pick an initial value

2:Compute  ,大于0表示上升,小于0下降

,大于0表示上升,小于0下降

,

, :learning rate

:learning rate

得到:

3:Update w iteratively

什么时候停止?迭代到设定的次数/微分为0。

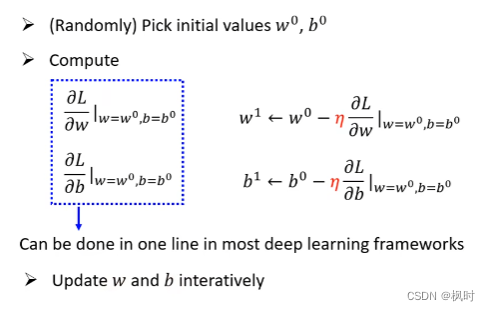

推广到两个参数w、b:

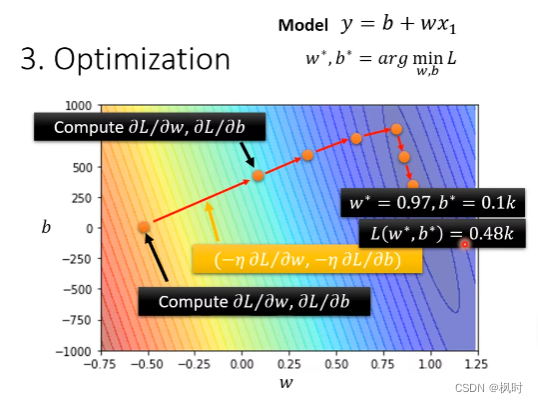

表示在下面的等高线图中,得到最佳的结果:

第二部:根据预测模型的结果,找到一定规律更新模型

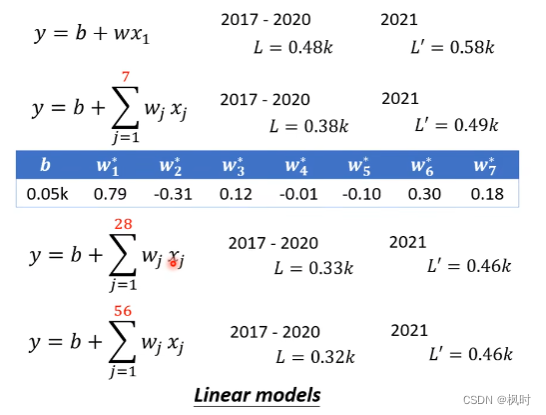

观察预测结果可以发现,点阅数大致成7天一个周期,因此,可以将模型优化,将前7天的数据也进行考虑,可以看到真实的L从0.48下降到0.38k,预测的L'从0.58k下降到0.49k,优化后的模型效果更好。同理,可以将更多天前的数据纳入考虑,但是发现,考虑56天的数据,其效果与考虑28天没有显著变化,预测值的误差仍为0.46k。

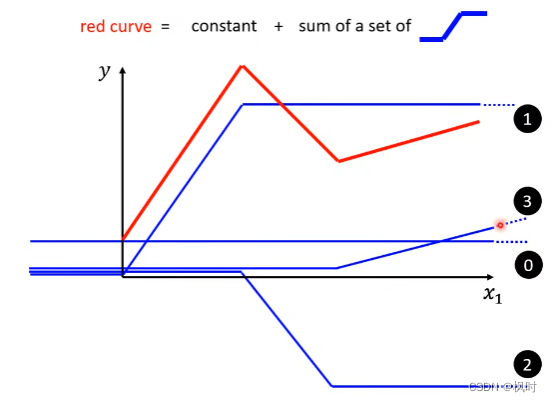

上述使用的是Linear model,在实际使用中会产生model bias的问题,所以当我们遇到更加复杂的模型时,可以使用Piecewise Linear Curves。

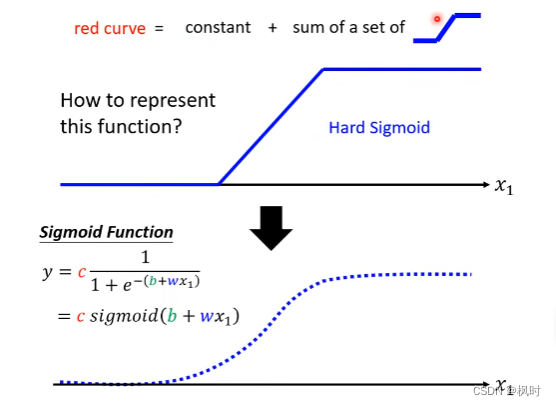

如下图所示,红色曲线可以表示为常数加上若干条不同的蓝色function。

1.3 蓝色曲线的两种表示形式(Activation function两种常见的表示)

1.3.1 Sigmoid Function

其表达式为

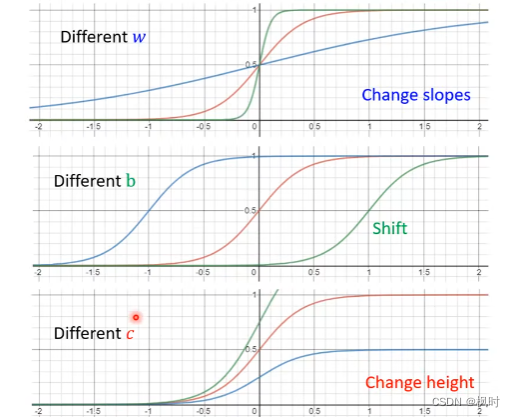

调整w,b和c的值,可以改变sigmoid的倾斜度、平移、幅度。

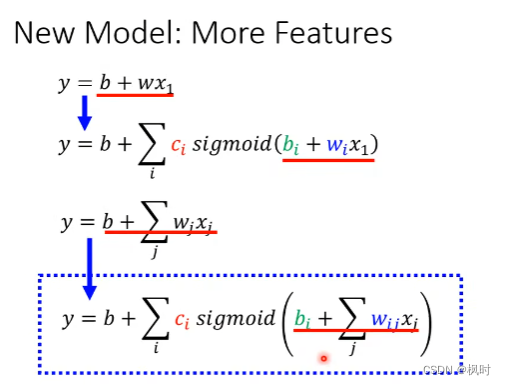

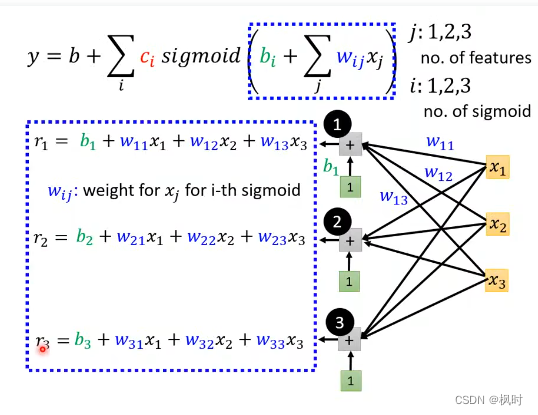

因此可以把上述例子中的模型进行更新,新模型的表达式为

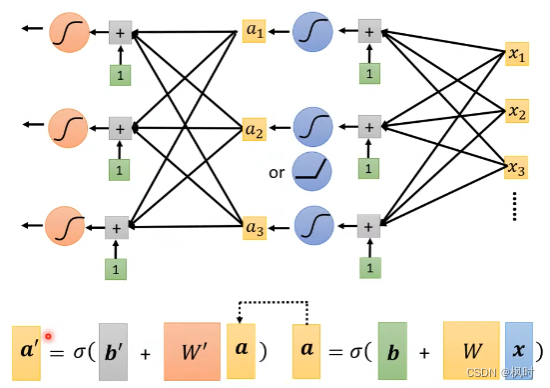

其中,i表示sigmoid的数目,j表示前j天的数据。为了更直观的显示虚线框中的公式,可以用图形表示。图像表示的是括弧中的公式,为了简化,称其为r。

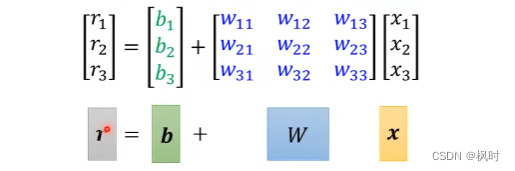

用矩阵的形式表示,

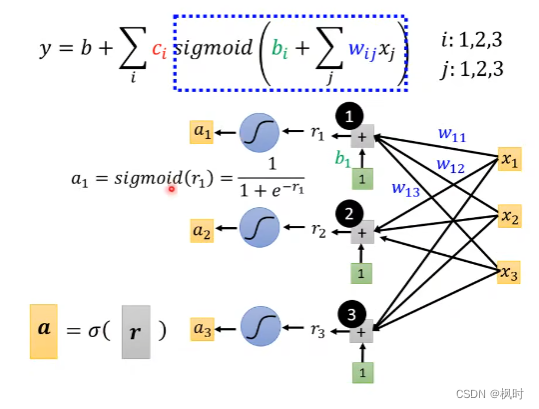

得到的r经过sigmoid function得到a,其实现的是下图中虚线框的功能

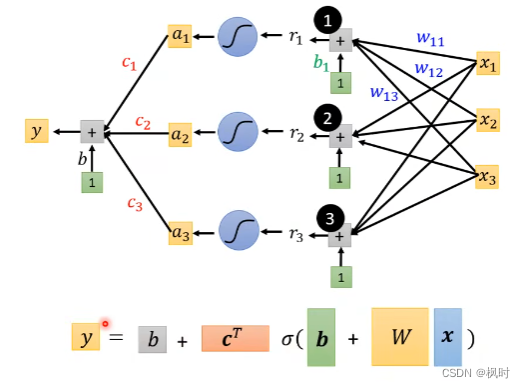

加上c和b,图形表示为:

同时得到新模型的矩阵表示:

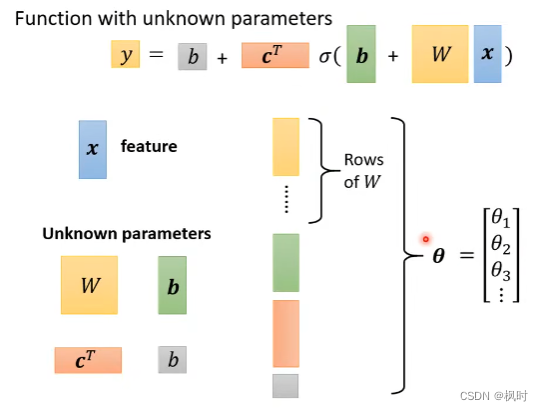

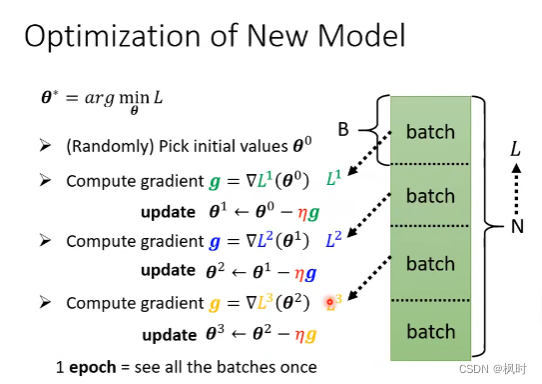

于是,原来的3个steps变为,

step1:

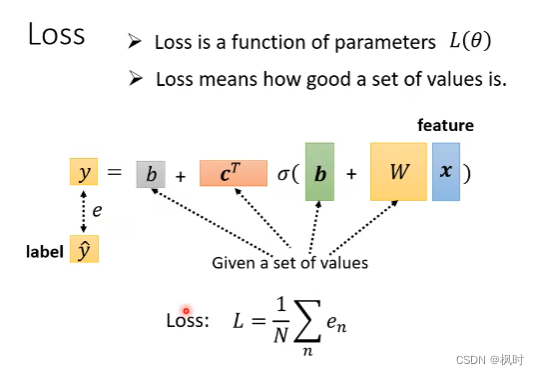

step2:

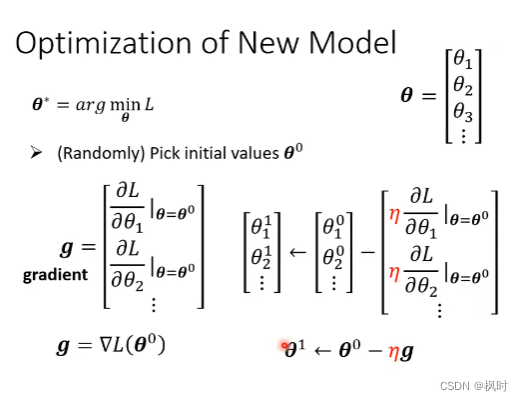

step3:

实际操作时,会分为几个batch,更新次数=总数除以batch size。

需要注意的是,这里的learning rate、sigmoid、batch size都是hypeparameter。

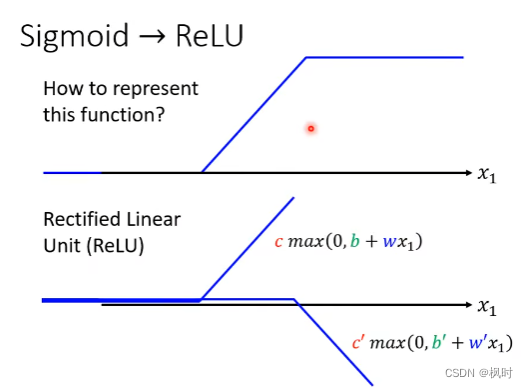

1.3.2 ReLU

可以用ReLU表示Hard Sigmoid,

其表达式为:

表达式中2i是因为两个ReLU才能合成一个Sigmoid。通过实践发现,ReLU效果由于Sigmoid。

二、深度学习

为了得到更好的结果,可以将Sigmoid或者ReLU多做几次,如下图所示:

需要注意的是,b’和W'多加了未知的参数,跟之前不是同一个。

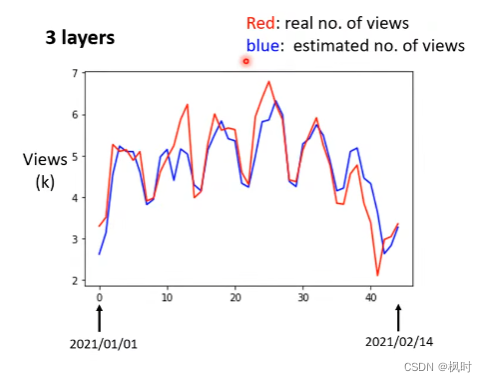

做几次ReLU就是几层layers,下图为三层的油管点阅数的结果图:

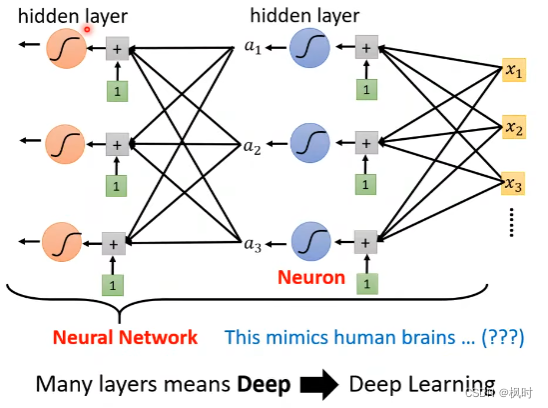

将Sigmoid或者ReLU称为Neuron,很多的Neuron称为Neural Network。

为了取一个好听的名字,就把Neuron称为hidden layer,有很多的hidden layer就叫Deep,这整套技术就叫做Deep Learning。

参考:

B站李宏毅机器学习与深度学习、B站刘二大人Pytorch入门、花书、西瓜书

136

136

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?