在机器学习领域,视觉变换器(Vision Transformers,ViT)是一种用于图像分类的模型类型。与传统的卷积神经网络不同,ViT使用了最初设计用于自然语言处理任务的变换器架构来处理图像。对这些模型进行微调以获得最佳性能可能是一个复杂的过程。

在先前的一篇文章中,我使用动画来演示在微调过程中embedding发生的变化。这是通过对embedding执行主成分分析(PCA)来实现的。这些embedding是从微调的各个阶段生成的模型和它们对应的检查点中获取的。

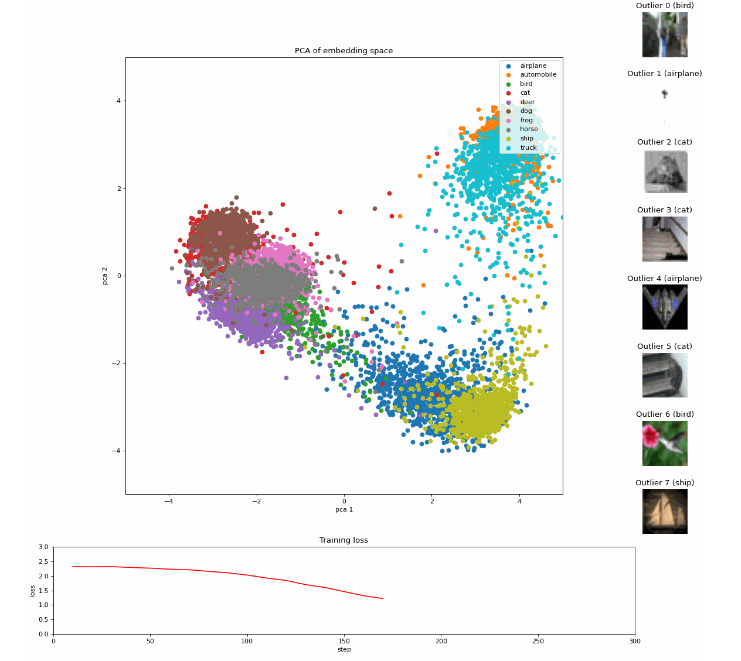

embedding在微调 Vision Transformer(ViT) 模型 [1] 在 CIFAR10 [3] 上的投影

这个动画获得了超过 200,000 次的点赞。它受到了好评,许多读者表达了对如何创建它的兴趣。本文旨在支持那些读者和任何对创建类似可视化效果感兴趣的人。

在本文中,我旨在提供一个详细的指南,介绍如何创建这样一个动画,详细说明所涉及的步骤:微调、embedding的创建、异常值检测、PCA、Procrustes、回顾以及动画的创建。动画的完整代码也在GitHub上的相关笔记本中提供。

准备工作:微调

首先,我们微调预先训练的 google/vit-base-patch16–224-in21k Vision Transformer(ViT) 模型,此处使用 CIFAR-10 数据集,其中包含 60,000 张图像,分为十个不同的类别:飞机、汽车、鸟类、猫、鹿、狗、青蛙、马、船舶和卡车。

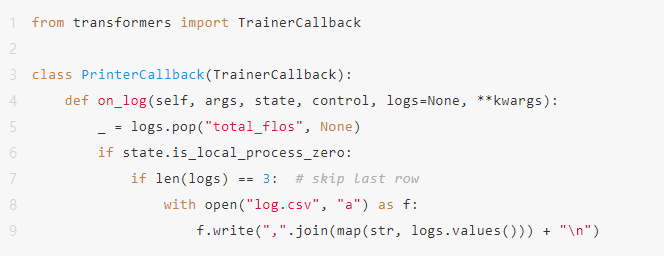

您可以按照 HuggingFace 的图像分类与 Transformer 教程中概述的步骤执行微调过程,也适用于 CIFAR-10。此外,我们使用 TrainerCallback 将训练期间的损失值存储到 CSV 文件中,以便稍后在动画中使用。

为了确保动画有足够的检查点,我们需要通过在TrainingArguments中设置save_strategy="step"和一个较低的save_step值来增加检查点的保存间隔。动画中的每一帧对应一个检查点。在训练过程中,会为每个检查点和CSV文件创建一个文件夹,并准备好供进一步使用。

embedding的创建

我们使用Transformers库中的AutoFeatureExtractor和AutoModel来使用不同的模型检查点从CIFAR-10数据集的测试集生成。每个embedding是一个表示一个模型检查点的10,000个测试图像中的一个的768维向量。这些embedding可以存储在与检查点相同的文件夹中,以保持良好的概览。

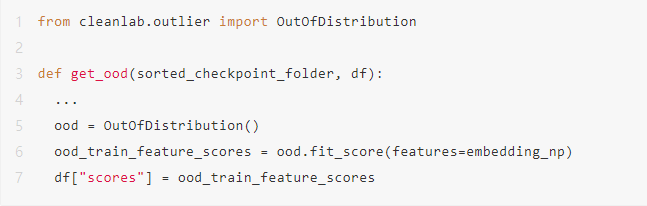

提取异常值

我们可以使用Cleanlab库提供的OutOfDistribution类,基于每个检查点的embedding来识别异常值。然后,生成的分数可以识别用于动画的前10个异常值。

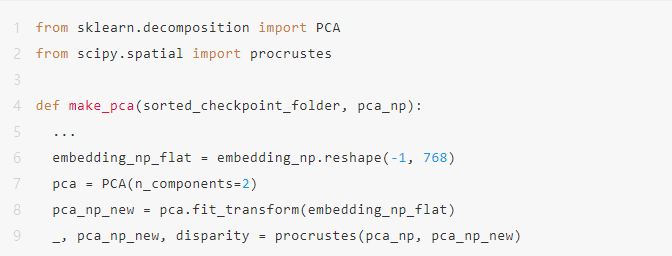

应用PCA和Procrustes分析

使用scikit-learn包进行主成分分析(PCA),我们将embedding在2D空间中可视化,通过将768维向量减少到2维。在每个时间步重新计算PCA时,由于轴翻转或旋转,动画可能会出现较大的跳跃。为了解决这个问题,我们应用了SciPy包中的额外Procrustes分析[3],将每一帧几何地变换到最后一帧,其中只涉及平移、旋转和均匀缩放。这使得动画中的过渡更加平滑。

在Spotlight中的复现

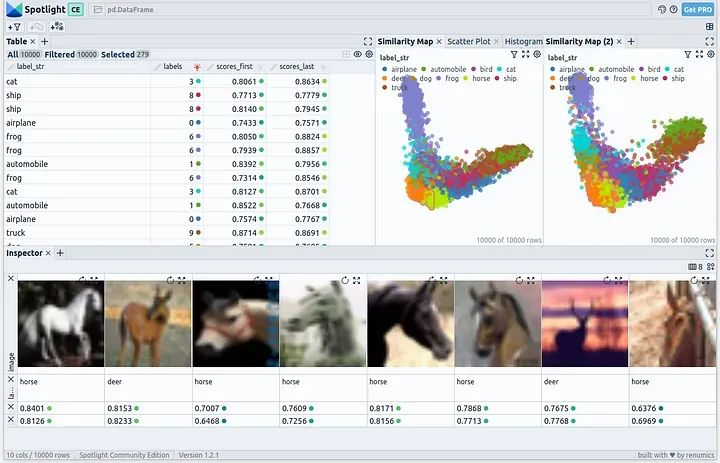

在最终完成整个动画之前,我们在Spotlight中进行审查。在这个过程中,我们使用第一个和最后一个检查点进行embedding生成、PCA和异常值检测。我们在Spotlight中加载生成的DataFrame:

CIFAR-10的embedding:通过PCA和短时微调的第一个和最后一个检查点的8个最差异常值

Spotlight在左上方提供了一张详尽的表格,展示了数据集中的所有字段。在右上方,显示了两个PCA表示:一个是使用第一个检查点生成的embedding,另一个是使用最后一个检查点生成的embedding。最后,在底部部分,呈现了所选的图像。

创建动画

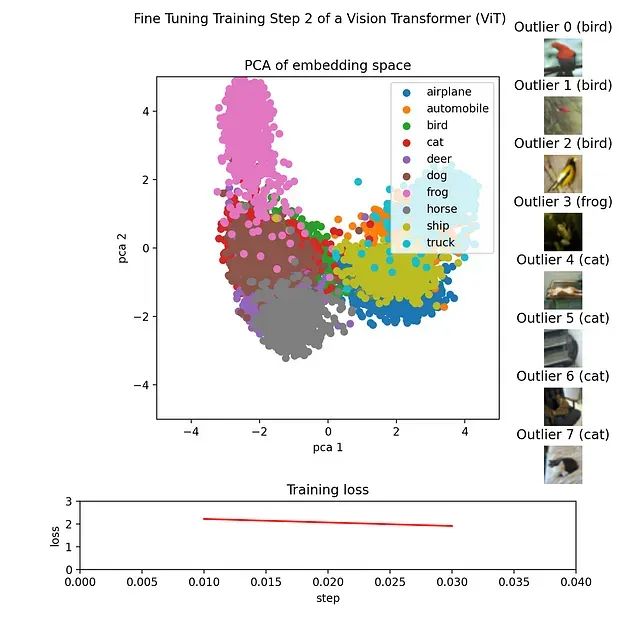

对于每个检查点,我们创建一幅图像,并将其存储在其相应的检查点旁边。通过使用make_pca(…)和get_ood(…)函数实现这一目标,这些函数分别生成表示embedding的2D点并提取前8个异常值。2D点以颜色表示其各自的类别。异常值根据其分数排序,并将其对应的图像显示在高分排行榜中。训练损失从CSV文件中加载,并绘制为折线图。最后,所有图像可以使用诸如imageio或类似的库编译成GIF。

从微调过程的前三个检查点生成的三个帧显示出轻微的聚类,预计在后续步骤中将会出现更为明显的聚类

从微调过程的前三个检查点生成的三个帧显示出轻微的聚类,预计在后续步骤中将会出现更为明显的聚类

结论

本文详细介绍了如何创建一个动画,展示了Vision Transformer(ViT)模型微调过程的过程。我们走过了生成和分析embedding、可视化结果以及创建将这些元素结合在一起的动画的步骤。创建这样一个动画不仅有助于理解微调ViT模型的复杂过程,而且还作为向他人传达这些概念的强大工具。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

720

720

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?