当我们谈论大模型时,通常指的是模型拥有庞大的参数数量和强大的数据处理能力。

在这篇文章中,我们将探讨神经网络中的模型参数——这些看似简单的数值如何决定着神经网络的行为。

模型参数的作用

在机器学习模型中,参数扮演着至关重要的角色,它们犹如幕后操盘手,指引着模型如何将输入数据转化为预期的输出结果。

通俗地讲,可以把模型想象成一个复杂的计算器,它会对输入数据进行一系列的数学运算,最终得出输出结果。而在这个运算过程中所使用的各种数值,就构成了模型的参数。

可以说模型参数是模型的精髓,她们的数量和质量直接决定了模型的性能和能力。

参数数量越多,模型越复杂,能够学习到的模式也就越复杂,但同时也意味着更高的计算成本和训练难度。高质量的参数能够使模型更好地拟合训练数据,从而在实际应用中取得更好的效果。

大模型就是通过庞大的参数量来实现复杂模式的学习,并最终将输入数据映射到输出结果。

具体来说,模型参数的作用主要包括特征提取、模式学习以及预测输出。

特征提取

特征提取是从原始数据中提取有价值信息的过程。通过特征提取,可以将原始数据转换成更易于分析和识别的特征。

自然语言处理:

在自然语言处理任务中,模型可以从文本中提取出不同层次的特征。例如,使用BERT模型时,早期的模型网络层可能会学习到单词的基本含义和语法关系,而后期层则会学习到更复杂的句子结构和上下文语义。对于输入的句子“猫坐在垫子上”,模型可以提取出“猫”是主体,“坐”是动作,“垫子”是位置等信息,从而理解整个句子的含义。

计算机视觉:

在卷积神经网络(CNN)中,模型可以从输入图像中提取出不同层次的特征。例如,输入一张猫的图片,早期卷积层可能会学习到边缘和颜色等低级特征,而后期卷积层则会学习到猫的耳朵、眼睛和胡须等高级特征。

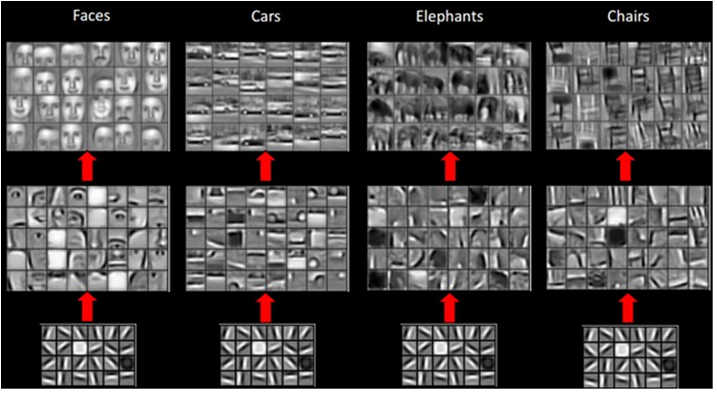

下面这张图是模型在不同的卷积网络层,所提取到的不同级别的特征。下面是最低级的特征,上面是最抽象、最综合和最高级的特征。

Image Source: https://stats.stackexchange.com/questions/146413/why-convolutional-neural-networks-belong-to-deep-learning

图中每一列代表不同类别的图像(人脸、汽车、大象和椅子),而每一行代表神经网络中不同层次的特征激活。

首先原始输入图像被输入到神经网络中,用于训练或测试模型。

最下面的一行展示了神经网络较浅层的特征激活。在这一层,你可以看到特征图主要关注于图像中的一些基本形状和边缘,如线条和简单的纹理。这些是构建更复杂特征的基础。

中间一行展示了较深层的特征激活。在这里,特征开始变得更加复杂和抽象,可以看到更具体的形状和结构,例如汽车的窗户格局和大象的身体轮廓。

最上面一行展示了最深层的特征激活。这些激活非常抽象,是对输入图像高级语义的表示,这些特征直接用于分类任务。在这一层,模型已经能够从高层次理解图像内容,辨别出各种不同的对象。

模式学习

模式学习是基于提取到的特征,建立特征与目标之间映射的过程。即模型在训练过程中,通过对大量数据的分析和学习,形成对输入数据与输出结果之间关系的理解。

所以特征学习主要是将输入信息转化成模型能够理解和处理的形式。模式学习则进一步从特征信息中发现蕴藏的规律和模式。

自然语言处理:

文本情感分析任务中,特征学习可以提取文本中的词语、句子的情绪倾向等特征。

模式学习可以学习到不同情感类别文本之间的模式,例如积极情感的文本中通常包含“快乐”、“喜欢”等词语,消极情感的文本中通常包含“悲伤”、“愤怒”等词语。

计算机视觉:

图像识别任务中,特征提取可以提取图像中的边缘、纹理、颜色等特征。

模式学习可以学习到不同类别物体之间的模式,例如猫的耳朵、眼睛、鼻子等特征与“猫”类别的关联程度,狗的毛色、体型等特征与“狗”类别的关联程度。

例如模型根据一些特征组合,如耳朵为三角形,眼睛细长,有可能判断这只动物是猫。

预测输出

预测输出是指模型利用提取到的特征和学到的模式,对输入数据进行处理并生成相应的预测结果。也就是将模型投入实际应用,对新的数据进行预测,这也是我们整模型训练的最终目的。

自然语言处理:

在情感分析的任务中,用户输入一条评论,模型通过提取文本特征(如情感词汇、语气等)和模式学习,预测这条评论的情感倾向(如“正面”或“负面”)。

计算机视觉:

在图像识别任务中,输入一张图片,模型通过提取图像特征(如边缘、颜色、形状等)和模式学习,预测图片中包含的物体类别。例如,输入一张猫的图片,输出预测类别“Cat”(猫)。

在目标检测任务中,输入一张复杂场景的图片,模型通过学习到的目标特征,在图片中检测并标记出目标物体的位置。例如,输入一张街景图片,输出标记出行人和车辆的位置。

在上述三个过程中,模型的参数起到了决定性的作用。通过这些参数的运算和调整,模型能够从原始数据中提取特征、学习模式,并最终生成准确的预测输出。

神经网络中结构、运算及参数

神经网络是由许多相互连接的神经元(也称为节点或单元)构成的计算模型,模仿了生物神经系统的工作原理。每个神经元接收来自其他神经元的输入信号,并通过连接(也称为边或权重)传递信号。

神经元:神经网络的基本计算单元

神经元(Neurons) 是神经网络的基本计算单元。每个神经元接收一个或多个输入信号,通过内部计算生成输出信号,并将该输出传递给下一个神经元或下一层。

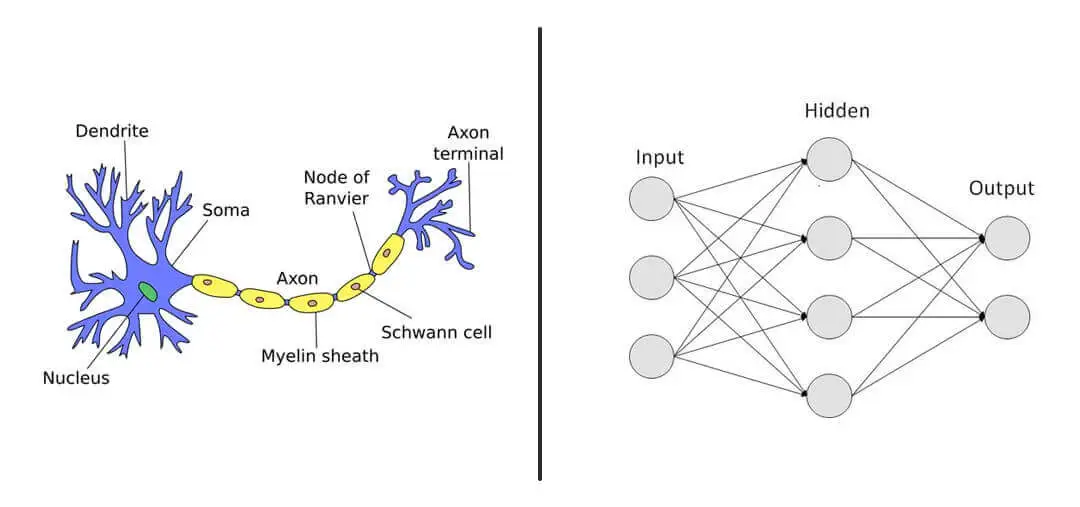

下面这张图展示了生物神经元的结构与人工神经网络架构之间的类比。图的左半部分描绘了一个生物神经元的详细结构,而右半部分则展示了一个简化的人工神经网络模型。

生物神经元(左侧图示)包括:

- 树突(Dendrite):接收来自其他神经元的信号。

- 细胞体(Soma):包含核心(Nucleus),是处理信号的中心。

- 轴突(Axon):传导电信号到其他神经元。

- 轴突终端(Axon terminal):与其他神经元的树突形成连接,传递信号。

人工神经网络(右侧图示)包括:

- 输入层(Input):接收输入数据,类似于神经元的树突。

- 隐藏层(Hidden):处理数据,可以有多层,类似于神经元细胞体中的信号处理机制。

- 输出层(Output):产生最终结果,类似于神经元的轴突终端,向其他神经元发送信号。

可以看出人工神经网络的设计灵感来自于生物学上的神经元。

在人工神经网络中,每个“神经元”或节点都接收来自前一层的输入,通过某种数学函数处理后传递给下一层,这一过程模仿了生物神经元信号的接收、处理和传递。在生物神经元中,信号的传递依赖于电化学过程,而在人工神经网络中,则是通过数学函数和多层处理实现复杂的非线性映射。

Image Source: https://clevertap.com/blog/neural-networks/

神经元之间连接的强度:权重

神经元之间的连接通过一个数值来表示,这个数值反映了两个神经元之间连接的强度。这个数值被称为权重,决定了一个神经元对另一个神经元的输入信号的影响程度。权重可以是正值(表示激励)或负值(表示抑制)。

在训练过程中,这些权重会被不断调整,以最小化预测输出与实际结果之间的误差。通俗而言,就是让模型的预测结果尽可能吻合实际情况。

连接权重表示信息在神经元之间传递的强度,偏差则表示每个神经元的偏好。

神经元的线性运算:加权求和

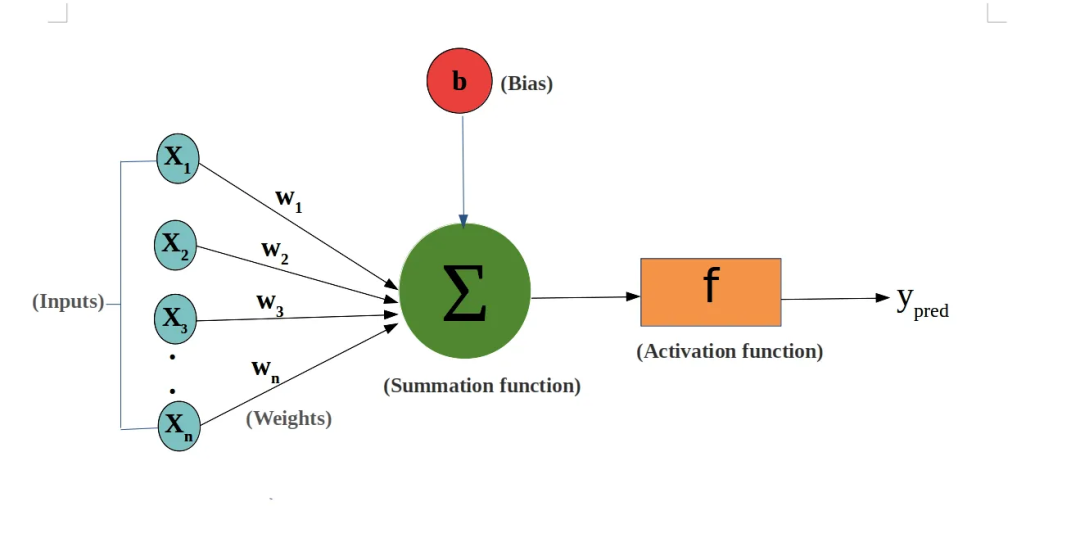

在神经网络中,每个神经元就像一个计算器,负责接收多个输入信号,并将它们进行加权求和。 每个输入信号都乘以一个权重,然后将所有乘积相加,最后再加一个偏差值,得到最终的输出。

举个例子,假设一个神经元有两个输入信号,它们的权重分别为 w1 和 w2,偏差值为 b。 那么,该神经元的输出 y 可以表示为:

y = w1 * x1 + w2 * x2 + b

其中,x1 和 x2 代表两个输入信号的值。

可见,权重越大,表示输入信息对于结果的影响就越大,也就是对于最终结果有更多的话语权。因此权重代表着输入信号的重要性,它决定了该信号对最终结果的影响程度。 权重的值可以为正、负或零,正值表示激励,负值表示抑制,零值表示无影响。

偏差值则相当于一个基准,它决定了神经元在没有输入信号的情况下会产生什么样的输出。 偏差的值通常为实数,可以为正、负或零。

下面这张图展示了上述所讲的神经网络单元的工作原理。每个输入都通过一个权重(W1, W2, … Wn)进行加权。权重决定了相应输入的重要性和影响力。在训练过程中,这些权重会被调整以帮助模型更好地学习和预测。偏差(b)是神经元一个额外的输入,独立于实际的输入数据。

求和函数(Summation function)将所有的加权输入求和,再加上偏差。求和后的结果是一个单一的数值,它将被传送到激活函数。

激活函数(Activation function)f 处理求和函数的输出,转换成神经元的最终输出。

Image Source: https://towardsdatascience.com/whats-the-role-of-weights-and-bias-in-a-neural-network-4cf7e9888a0f

通过调整权重和偏差,我们可以控制神经元的输出,使其更好地拟合训练数据。 这就是神经网络学习的过程。

总而言之,权重与输入相乘,并累加的过程,是神经网络进行信息处理和学习的基础。 它就像一个简单的数学运算,却蕴含着强大的功能,使神经网络能够从大量数据中学习复杂的模式,并做出准确的预测或决策。

神经网络中非线性计算

在神经网络中,计算其实包括两部分。一部分是我们刚才讲到的线性计算,即将输入信号与权重相乘,并累加,再加上偏差值。

另一部分是非线性计算,是使用激活函数对线性计算的结果进行处理。

线性计算就像是简单的数学运算,例如加减乘除。它可以将多个输入信号组合成一个输出信号,但它无法表达复杂的非线性关系。

非线性计算则引入了非线性因素,使神经网络能够学习更复杂的模式。模式指的是事物之间存在的一种规律或联系。简单的模式通常是线性的,即可以用简单的数学公式来表示。例如,身高和体重之间的关系通常可以用线性回归模型来表示。但是对于图像识别和自然语言处理,这些物体、场景、语言的模式是无法用简单的线性关系来表示的。

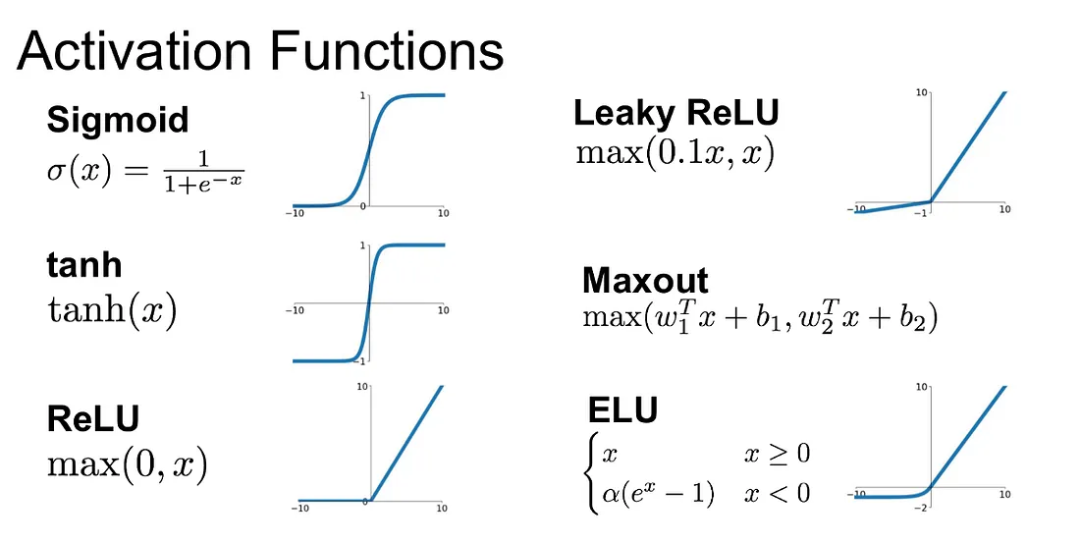

因此,我们在神经网络中引入了非线性计算元素,通常是通过使用非线性激活函数来实现。这些激活函数,如ReLU(修正线性单元)、sigmoid或tanh函数,使神经网络能够捕捉并学习复杂的、非线性的模式。这种非线性特性是神经网络在各种复杂任务中表现出色的关键因素。

常用的激活函数包括:

- Sigmoid 函数: 将输入映射到 0 到 1 的范围内。

- Tanh 函数: 将输入映射到 -1 到 1 的范围内。

- ReLU 函数: 将输入置为 0 或保持原样。

- Leaky ReLU 函数: 将输入置为 0 或以较小的斜率保持原样。

不同的激活函数具有不同的特性,适合不同的任务。在实际应用中,通常需要通过实验来选择最合适的激活函数。

总而言之,神经网络中的计算包含线性计算和非线性计算两个部分。 线性计算负责将输入信号组合成一个输出信号,而非线性计算则引入非线性因素,使神经网络能够学习更复杂的模式。激活函数是实现非线性计算的关键工具,它在神经网络中发挥着重要的作用。

偏差的重要性

我们说偏差是加到每个神经元计算中的一个常数项,它允许模型在所有输入均为零的情况下仍能产生非零输出。那么,为什么我们需要非零输出呢?

这是因为在没有偏差的情况下,当所有输入均为零时,零乘以任何权重的结果仍为零,从而导致神经元的总输出也为零。

在使用ReLU这样的激活函数时,如果输入为零或负值,输出也将持续为零,这可能导致神经元在训练过程中“死亡”,即永久失去活性。

Image Source: https://medium.com/@shrutijadon/survey-on-activation-functions-for-deep-learning-9689331ba092

偏差项的加入可以确保即使在输入较小的情况下神经元也能够激活,这里的激活指的是神经元通过激活函数将输入信号转换为输出信号,参与后续的计算和信息传递,从而避免神经元“死亡”。

此外,偏差项增加了模型的表达能力,使其能够拟合更多样化的函数关系。例如,在实际数据集中,输入特征可能存在偏移或不均衡。偏差项帮助模型更好地适应这些偏移,使得神经网络能够更准确地拟合数据分布。

在图像识别任务中,由于不同图像的亮度和对比度可能有所差异,偏差项可以调整神经元的响应,使模型能够有效地处理这些变化并提取关键特征。

在自然语言处理任务中,如在Transformer模型中,权重决定了如何捕捉和表示词语之间的关联,例如句子中词语之间的依赖关系。偏差项则确保无论句子的长短,注意力机制的头部都能被正确激活,并有效地提取特征。

模型参数的数量

模型参数的数量是衡量模型大小的一个重要指标。一般来说,参数越多,模型越复杂,能够学习到的模式也就越复杂。当然,参数数量的增加也意味着更高的计算成本和训练难度。

这是因为,参数数量增加意味着需要更多的计算资源(如CPU、GPU、内存)来处理模型的计算任务。

在大模型中,模型参数通常指的是数十亿甚至数千亿级别的参数数量。如此庞大的参数量使得大模型能够学习到极为复杂的模式和规律,从而在自然语言处理、计算机视觉等领域取得了突破性的进展。

下面是关于GPT系列模型的主要信息及参数数量。

| 模型名称 | 模型参数数量 | 发布时间 | 发布论文标题 |

|---|---|---|---|

| GPT-1 | 1.17亿个参数 | 2018年6月 | Improving Language Understanding by Generative Pre-Training |

| GPT-2 | 最大版本15亿个参数 | 2019年2月 | Language Models are Unsupervised Multitask Learners |

| GPT-3 | 1750亿个参数 | 2020年6月 | Language Models are Few-Shot Learners |

| GPT-3.5 | 1750亿个参数 | 2022年1月 | (未明确论文标题) |

| GPT-4 | 约1.76万亿个参数 | 2023年3月14日 | (未明确论文标题) |

这个表格概括了GPT系列各个版本的关键信息,包括参数数量和发布时间,以及相关的发布论文。可以看到,从GPT-1到GPT-4,参数数量逐渐增加,模型复杂度和能力都在逐步提升。

模型参数的不可解释性

深度学习模型的参数代表了神经元之间的连接强度,是理解模型如何从输入到输出进行转换的关键。

然而,直接通过参数解释模型的工作原理却极具挑战性,特别是在复杂的模型和大规模数据集上。

其原因可以归纳为下面几点:

1. 高维参数空间: 深度学习模型通常包含大量的参数,例如权重和偏差。在如此高维的参数空间中,每个参数的具体作用难以直观理解和解释。在上万亿参数的模型中,我们无法一一去解读每个权重的意义,以及这些权重组合所代表的精确含义。

2. 参数与特征的非线性关系: 深度学习模型,尤其是使用了非线性激活函数的模型,处理的是非线性关系。参数对于输出的影响难以被明显地观察和衡量。模型的每层可能进行复杂的转换,这使得单个参数的影响难以单独识别。

3. 相互作用: 参数之间存在着复杂的相互作用,难以分离和量化每个参数的独立贡献。

由于难以解释其内部机制,深度学习模型通常被称作“黑盒子”。 就像我们无法直观地理解一个复杂的黑盒子是如何工作的,我们也难以完全理解深度学习模型是如何将输入数据转换为输出结果的。

正因为神经网络和深度学习模型的“黑盒子”本质,即其不可解释性,让许多人对这些技术的透明度和可靠性引起了担忧。

首先我们无法直观地理解模型如何决策。因此难以评估其结果的可靠性,也无法对模型的潜在偏见或错误进行解释。

当神经网络出现错误时,我们很难找到错误的原因并进行修复。因为我们无法像理解传统算法一样理解神经网络内部的运作机制,因此难以排查问题所在。

一些基于神经网络应用可能会引发伦理问题,例如歧视或偏见。然而,我们很难评估模型是否存在这些问题,也难以对其进行纠正。

为了解决这些问题,研究人员正在积极开发可解释的人工智能技术。随着技术的不断发展,我们有望能够更好地理解和解释神经网络和深度学习模型,从而使这些技术更加可靠和透明。

结语

我们今天讨论了模型参数的本质、作用及其重要性。

模型参数,无论是权重还是偏差,都是定义神经网络行为的核心因素,它们如同是模型的神经系统,通过调节和学习,使得模型能够捕捉复杂的数据模式,从而执行如分类、预测等任务。

然而,正如本文所述,尽管参数的数量和复杂度为模型提供了学习深层模式的能力,它们也带来了不可解释性和计算负担。

每一个进步,特别是接二连三的大模型技术的突破,无论是参数的增加还是模型结构的优化,都让我们离“理解”模型的真正工作原理更远一步。

高性能要追求,但是模型的透明度和可解释性始终是悬在人工智能领域之上的达摩克里斯之剑。

这把剑时刻提醒我们,技术进步的同时,也伴随着潜在的风险和挑战。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

76

76

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?