TCR在许多靶向肿瘤细胞的免疫疗法中发挥着至关重要的作用。然而,它们的获取和优化带来了重大挑战,涉及费力且耗时的湿实验资源。深度生成模型在功能性蛋白质序列生成方面表现出显著的能力,为增强特异性TCR序列的获取提供了有前途的解决方案。在这里,上海交通大学熊毅研究团队**提出GRATCR,这是一个通过新型“嫁接”策略整合了两个预先训练的模块的框架,以从头生成靶向特定表位的TCR序列。**实验结果表明,与最先进的模型相比,通过使用明显更少的训练数据,GRATCR生成的TCR对所需表位表现出更高的特异性,并且具有更强的生物学功能。此外,与天然序列相比,生成的序列显示出新颖性,可解释性评估进一步证实了该模型能够捕获重要的结合模式。GRATCR可在https://github.com/zhzhou23/GRATCR 上免费获取。

T细胞是免疫系统不可或缺的一部分,通过识别各种抗原在适应性免疫中发挥关键作用。TCR促进了这种识别,这是一种对抗原识别和T细胞激活至关重要的特殊细胞表面蛋白。通常,TCR是由α链和β链组成的异源二聚体,抗原的特异性识别主要通过TCR的CDR实现。在CDR内,高变CDR3环主要与抗原肽相互作用,即MHC分子呈现的表位。由于TCR在免疫过程中发挥重要作用,目前有许多基于TCR的有前途的疗法用于对抗肿瘤。TCR-T是目前治疗多种适应症的最新、最有效的免疫疗法之一,包括大B细胞淋巴瘤、黑色素瘤和其他肿瘤。该疗法利用基因编辑技术来工程化T细胞表达靶向特定抗原的TCR,从而能够识别和清除肿瘤细胞。然而,目前基于TCR的疗法仍然面临重大挑战,建立可靠的靶向特定肿瘤细胞的TCR库仍然是一个主要障碍。此外,湿实验方法需要大量时间和财力。

之前许多基于深度学习的模型已被应用于与TCR相关的问题,主要旨在阐明TCR和表位之间的识别机制。这些模型的重点是确定给定的TCR和表位是否可以特异性地识别彼此。例如,ImRex从图像分类任务中汲取灵感,并利用卷积神经网络(CNN)作为模型的核心,因为CNN能够从序列中提取多尺度特征。TEINet、pMTnet和ERGO采用预先训练的模型从包括表位和TCR在内的输入序列中提取嵌入。TEPCAM和TITAN利用注意机制来捕捉序列之间的相互作用。尽管这些模型在各自的任务中表现出值得赞扬的性能,但它们的普遍性都较差,严重限制了它们的实际应用。而且,理论上,V(D)J重组可以产生的TCR数量远远超过目前可用的数量。因此,这些模型不足以探索更大的TCR空间来扩展当前的TCR库。

生成模型的快速发展和基于这些模型的某些生物序列设计的成功为识别与特定表位结合的TCR提供了新的策略。此外,研究人员正在进行创新尝试来发现合适的TCR。例如,TCRPPO是基于强化学习的框架,用于突变现有的TCR序列以增强其对给定表位的亲和力。然而,这种优化方法引入分类模型的预测结果作为优化指标,可能会由于分类模型的泛化性较差而导致模型最终性能不稳定。ERTransformer利用两个预先训练的BERT与给定的新表位组合生成TCR。尽管ERTransformer在几项特定任务中表现出令人满意的性能,但由于缺乏用于基准测试的可比模型,其有效性仍有待充分验证。除了上述模型之外,还没有关于生成TCR的进一步重要研究,这与TCR在免疫中的关键作用不一致。**这里提出GRATCR,这是一种新的从头序列生成框架,用于端到端生成给定表位的TCR的CDR3-β。**由于CDR3区在识别中的关键作用以及目前缺乏有关α序列的信息,该研究特别关注TCRβ序列的CDR3区。总体而言,GRATCR由Epitope-BERT和TCR-GPT组成。**GRATCR的进步可以概括为两个方面:首先,通过集成表位编码器和GPT衍生的TCR发生器,无需额外的发生头,GRATCR的预训练分别仅涉及150万个表位和300万个TCR,显示了其对数据的高效利用。其次,采用了一种更有效的方法“嫁接”来在预训练后整合Epitope-BERT和TCR-GPT。**在这项研究中,为了评估GRATCR的性能,采用ERTransformer作为基准,对相同的数据集进行了微调,并生成了相同表位的TCR。利用了3个善于预测TCR-表位结合特异性的分类模型来评估模型生成的TCR是否与相应的表位特异性结合。实验结果表明,GRATCR模型优于ERTransformer,结合概率增加了20%。将生成的TCR与天然TCR进行了比较,发现GRATCR产生的序列表现出更好的生物学功能。通过序列水平和结构水平分析,发现生成的序列覆盖了更大的TCR序列空间,同时保持了较高的可靠性。此外,检验了GRATCR的交叉注意分数,报告了关键结合位点的显着一致性。

1

用于端到端序列生成的GRATCR框架

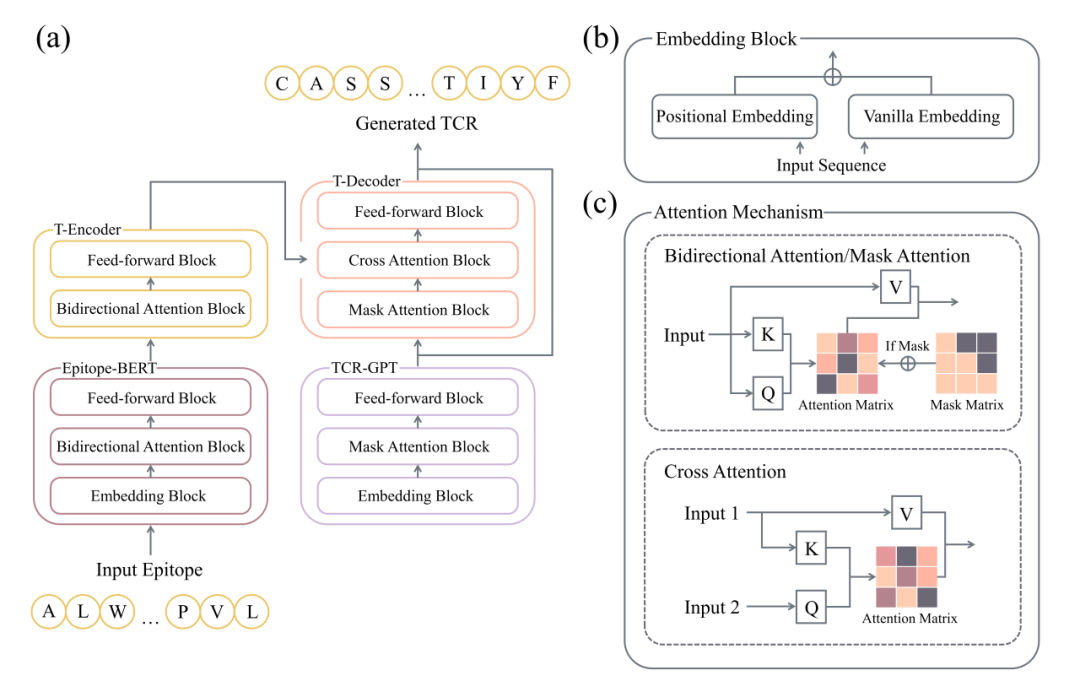

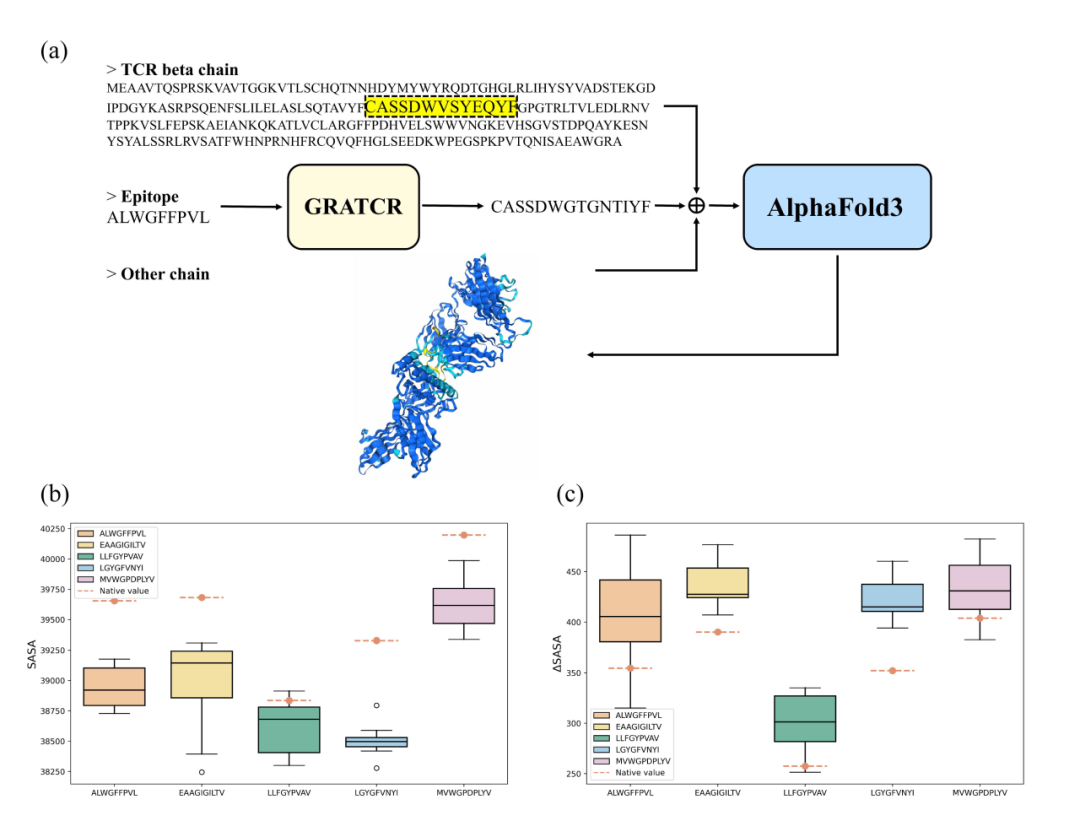

为了能够针对给定表位端到端生成TCR序列,提出了GRATCR的深度学习框架。受ERTransformer的启发,GRATCR采用了一种混合策略,涉及两个预训练的转换器衍生模块,如图1所示。然而,GRATCR在两个关键方面进行了优化。首先,基于GPT而不是BERT的架构预训练了TCR模型,因为GPT的解码器本质上更适合序列生成。其次,在重新评估和探索两个预训练模型之间不同沟通策略的影响后,采用了Epitope-BERT和TCR-GPT之间的嫁接联动策略。**与ERTransformer通过Receptor-BERT内随机初始化的“交叉注意”模块连接两个预训练的编码器(Epitope-BERT和Receptor-BERT)相比,这种嫁接框架可以保持预训练模型的嵌入能力并生成高质量的TCR,具有与所需表位的强大交互能力。**假设这些改进保证了 GRATCR 尽管预训练规模较小但仍具有卓越的性能。之前研究过ERTransformer架构是否可以在明显较小的预训练规模的情况下保持高性能。然而,结果表明生成的序列的质量下降,表明ERTransformer缺乏数据效率。此外,尝试用BERT模型取代GRATCR中的TCR-GPT,但结果不满意,因为该模型未能正确生成序列。所有这些发现都支持GRATCR框架背后的原理。

GRATCR的训练分为两个阶段:① Epitope-BERT和TCR-GPT的预训练,② SeqToSeq微调。在预训练阶段,利用了几个公共数据集,其中包含大量表位和TCR序列。Epitope-BERT和TCR-GPT的预训练过程是不同的。对于Epitope-BERT,来自输入序列的标记按照标准BERT的训练方案以一定的概率随机掩蔽。该模型经过训练以准确地恢复被掩蔽的标记,使其能够学习氨基酸与有助于表位免疫原性的生物特征之间的内在关系。对于TCR-GPT,采用了“预测下一个标记”目标。这种自回归策略的目的是在给定之前的标记的情况下,最大限度地减少预测的下一个标记与基本事实之间的差异。该任务使TCR-GPT能够学习TCR序列的特征并尽早适应序列生成,而无需在微调之前附加线性生成头。

然后,使用SeqToSeq任务微调预训练模型。为了生成靶向特定表位的TCR,编码器和解码器应该连接起来形成一个端到端的框架。在ERTransformer中,两个编码器通过一个额外的带有随机初始化参数的交叉注意模块连接在一起。具体来说,Epitope-BERT的输出嵌入作为预训练Receptor-BERT的输入,提供表位信息作为先验知识。然而,这种策略在微调阶段会破坏解码器的架构。这种架构扰动会导致模型忘记与预训练阶段学习的TCR特性相关的有价值的信息,从而限制其有效生成TCR序列的能力。为了解决这个问题,利用了一种“嫁接”的连接策略来连接Epitope-BERT和TCR-GPT。直觉是保持预训练模型的不变性。为了实现这一目标,将Transformer的编码器(T-Encoder)堆叠在Epitope-BERT上,将Transformer解码器(T-Decoder)堆叠在TCR-GPT上,将这两个部分链接在一起。这种嫁接方案可防止通过模块内机制(即 TCR-GPT 的交叉注意)直接传递消息。因此,微调模型充当端到端的TCR生成器。为了生成与特定表位结合的各种TCR,在序列生成过程中采用了射束搜索算法。

●图1 GRATCR框架。

2

GRATCR产生的TCR表现出更高的表位特异性比ERTransformer

GRATCR的主要目标是在SeqToSeq微调后产生能够结合特定表位的TCR。在抗原-MHC复合物呈现的表位的TCR识别任务中,重点明显转向提高预测TCR-表位结合的准确性,而不是重新产生TCR。已经提出了许多深度学习模型来预测TCR与给定表位的特异性结合。这些模型在各自任务中表现出色,为评估生成的TCR序列的质量提供了宝贵的工具。

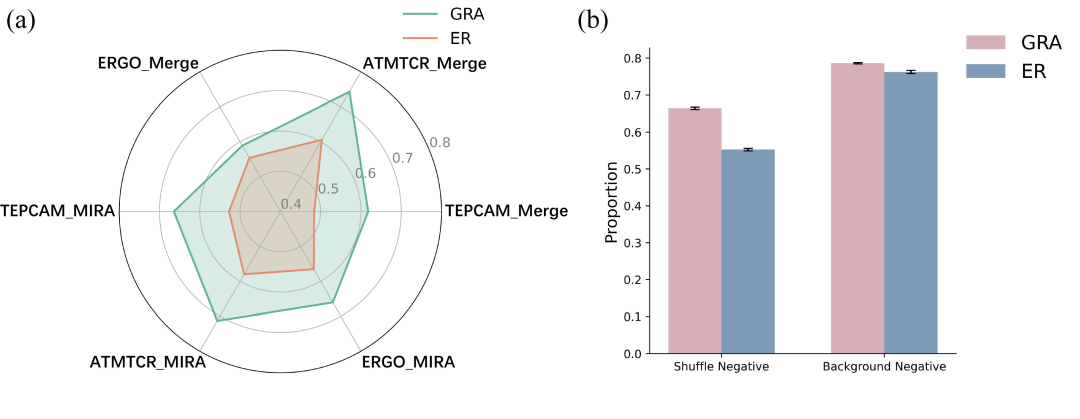

首先,使用MIRA数据集的表位对GRATCR和ERTransformer生成的TCR的质量进行了基准测试。由于湿实验评估的资源需求极高,使用基于机器学习的鉴别器对生成质量进行评分。选择了ATMTCR、ERGO和TEPCAM,因为这些鉴别器基于不同的架构,并在确定 TCR 和表位之间的结合方面表现出最先进的性能。在精心策划的MIRA数据集上训练它们,其中包含通过洗牌生成的阴性对,然后利用它们来评估生成的TCR。ATMTCR预测的结果显示,GRATCR产生的71.3%的TCR可以特异性靶向相应的表位,而ERTransformer达到了58.0%(图2a)。根据ERGO,ERTransformer和GRATCR生成的序列的结合概率分别为56.6%和66.1%(图2a)。TEPCAM结果显示,平均而言,ERTransformer产生的TCR序列中有52.7%可以与相应的表位结合,而GRATCR达到了66.4%(图2a)。此外,为了确保鉴别器评分的客观性,选择使用由VDJdb、McPAS和IEDB组成的额外合并数据集重新训练它们,以减轻因分布偏差而产生的不准确性。与ERTransformer相比,结果继续证实GRATCR的稳定性和卓越性能(图2a)。值得注意的是,与原始论文中报道的相比,这里观察到ERTransformer的性能显着下降,这可能归因于两个因素。首先,原始论文中ERTransformer的性能依赖于ER-BERT-BSP的预测结果,该结果源自ERTransformer本身,这种“相似”设置可能会高估ERTransformer的性能,因为在预训练期间捕获序列模式偏差,从而需要其他鉴别器进一步验证生成序列的质量。同时,在ER-BERT-BSP使用的训练过程中引入外来的TCR和表位作为阴性对是一种不可靠的做法。事实证明,将背景TCR与现有表位作为阴性数据进行配对可能会导致捷径学习,其中鉴别器捕捉数据分布的差异,导致其在训练中支持标记为阳性样本的表位。为此,还重新训练了ATMTCR、ERGO和TEPCAM,这些鉴别器的实现细节与ER-BERT-BSP的实现细节相当。如图2b所示,鉴别器因此会给出更有吸引力但具有欺骗性的结果,这是一个陷阱。

总之,GRATCR产生的TCR对相应表位表现出更高的特异性。

●图2 通过不同鉴别器生成的序列质量基准测试。

3

与天然序列相比,GRATCR产生的TCR表现出更高的生物学保守性

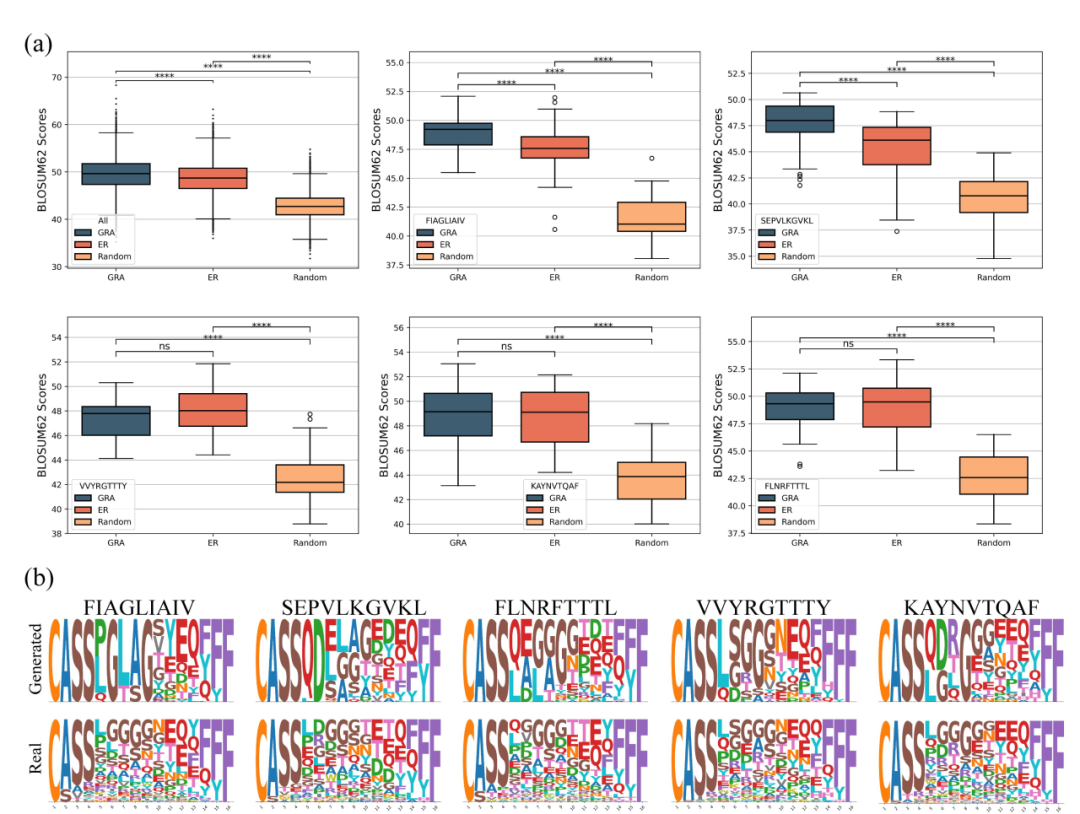

现实环境中免疫疗法的发展要求TCR表现出高水平的免疫原性和生物活性。特定基序在维持生物学活性方面发挥着至关重要的作用;因此,生物学一致性至关重要,可以通过BLOSUM评分矩阵值来计算,这已被证明在抗体设计中有效。为了进一步评估生成的TCR序列,采用BLOSUM62评分矩阵来量化它们与天然TCR相比的生物学倾向。更高的BLOSUM62评分表明生物学上更有利的取代,有助于识别蛋白质序列中的保守区域和功能结构域。与之前一样,使用ERTransformer和GRATCR在MIRA数据集中生成表位的TCR序列,并计算其BLOSUM62评分。为了比较,也为相同表位生成随机氨基酸序列作为对照。考虑到在TCRβ链CDR3区的前几个残基(“CASS”)和后两个残基(“YF”)中观察到的相对固定的模式,随机序列产生过程被缩小到TCR的中间部分。此外,将随机生成序列的长度限制在14-16个氨基酸的范围内,使它们在基本氨基酸模式方面类似于天然序列。使用天然TCR作为参考序列来计算平均置换分数。结果显示,随机生成序列的BLOSUM62平均得分为42.77,标准偏差为2.70。相比之下,ERTransformer生成的序列平均得分为48.67,标准差为3.35,而GRATCR生成的序列平均得分为49.56,标准差为3.53(图3a)。这表明ERTransformer和GRATCR产生TCR具有显著的生物学相关性(p<0.0001),GRATCR产生的序列在进化方面比ERTransformer产生的序列更有利。

然后分析了生成序列的特征,并在数据集中选择了5个具有足够天然TCR配对的表位进行具体分析。总体而言,这些表位的结果与人群水平的发现一致(图3a)。GRATCR为表位FIAGLIAIV和SEPVLKGVKL生成的序列优于ERTransformer生成的序列。对于表位FLNRFTTTL、KAYNVTQAF和VVYRGTTTY,GRATCR产生的序列与ERTransformer的序列相当。无论表位如何,随机生成的序列的评分都显着低于ERTransformer和GRATCR生成的序列。随后,重点研究了GRATCR产生的TCR序列。对于5个选择的表位,鉴定了天然和生成的TCR,长度从14-16个氨基酸不等,然后利用Logomarker可视化来评估生成序列的保守性(图3b)。一般来说,生成的CDR3序列非常类似于天然序列。例如,所有生成的序列都以“CASS”开头,以“YF”或“F”结尾,与TCRβ序列的常见模式一致。虽然GRATCR似乎已经捕捉到了这些模式,但令人担忧的是,生成的序列比天然序列更加保守,并表现出更少的多样性。假设生成的序列多样性减少的一个原因可能归因于预训练数据的规模相对较小,这限制了模型学习和整合低频氨基酸的能力。例如,在为FIAGLIAIV表位生成的TCR中,甘氨酸(G)固定在第6位,而天然序列中的各种氨基酸占据了该位置。分析了300万个预训练TCR序列的氨基酸组成,发现甘氨酸是TCRβ链CDR3第6位最常见的氨基酸。同样,甘氨酸经常出现在FIAGLIAIV表位生成序列的第9位和KAYNVTQAF表位生成序列的第8位,这与训练前数据中这些位置中甘氨酸的高频率一致。这些发现支持了该假设,即训练前数据规模限制了生成序列的多样性。一般来说,虽然GRATCR生成的序列具有生物功能,但它们仍然比天然序列更保守。

●图3 TCR的生物学和序列水平保守性分析。

4

与天然TCR相比,GRATCR产生的TCR表现出新颖性

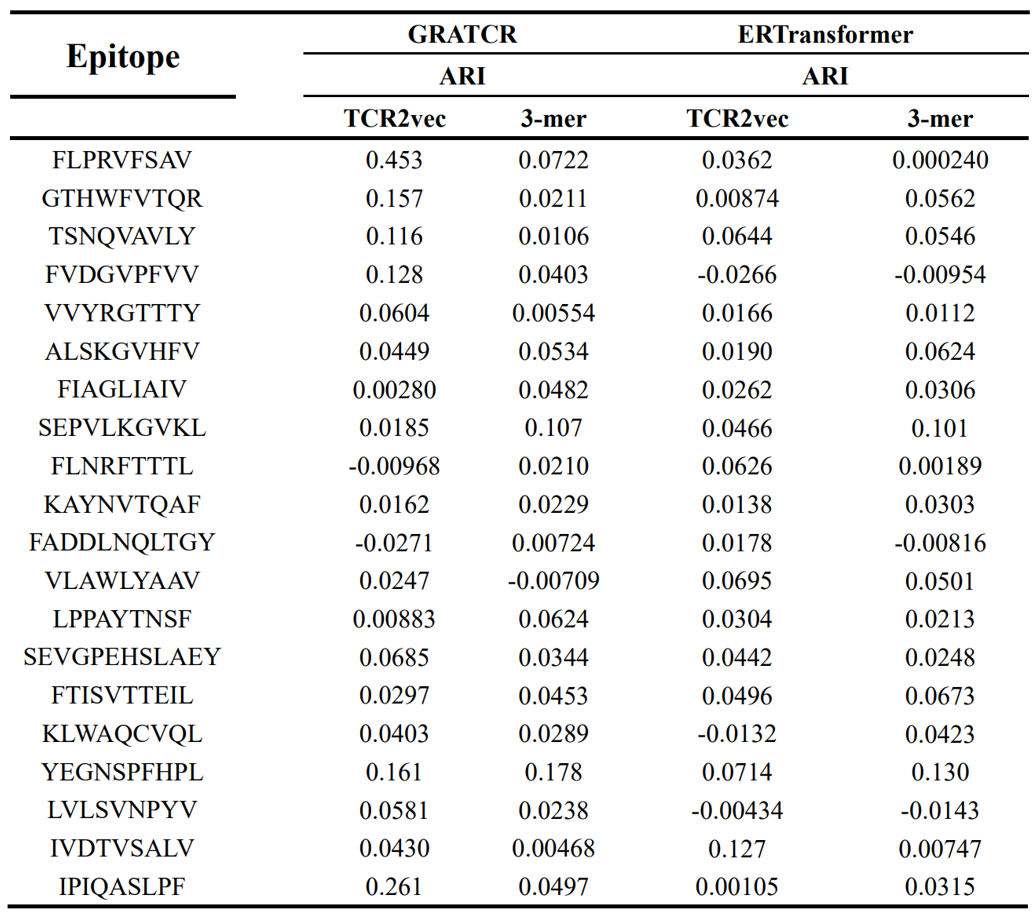

提取TCR的内涵特征对于了解其旋转偏好和对配体表位的高敏感性具有重大意义。在巨大的序列库上进行预训练有助于模型学习有关进化和功能相似性的知识,而不是序列模式。丰富的先验知识是生成器发现更大序列空间能力的基础。在这里,提取生成序列和天然序列的内在特征,以便进行比较分析。首先引入了TCR2vec作为特征提取器,这是一种预训练的基于变换器的模型,可将TCR序列编码为多维载体。在获得生成和天然TCR的序列级表示后,采用调整兰德指数(ARI)来评估天然和生成起源的序列集群之间的相似性。ARI是评估两个数据集群之间相似性的统计指标,范围从-1到1,其中接近1的分数表示高度一致,接近0的分数表示随机聚集,负分数表示不同意。选择了20个表位并计算了生成序列和天然序列之间的ARI值(表1)。总体而言,基于源自TCR2vec的特征,推断GRATCR产生的序列和ERTransformer产生的序列都与天然序列都不太相似,尽管对于某些表位GRATCR产生的TCR与天然TCR序列表现出更大的相似性比ERTransformer产生的序列。训练深度模型中使用的大量数据可能会引入显着的偏差,影响特征提取的代表性和准确性。为了减轻这种影响,然后通过专门计算3-mer氨基酸组成来使用基于序列的特征。统计结果与TCR2vec的发现一致,表明生成的序列与天然序列的相似性较低,这意味着从头蛋白质序列生成器能够探索更大的序列空间,同时保持足够的生物相关性。

表1 使用两种不同的特征提取方法调整后天然TCR和生成的TCR之间的ARI值

5

GRATCR产生的TCR促进TCR-peptide-HLA复合物的组装

为了研究产生的TCR序列是否可以特异性地结合给定表位,对这些序列进行了结构分析。从PDB数据库中选择了5种具有不同表位的TCR-pMHC复合物。表位序列和相关的PDB代码是“ALWGFFPVL”(2J8U)、“EAAGIGILTV”(4QOK)、“LLFGYPVAV”(1QSF)、“LGYGFVNYI”(3PWP)和“MVWGPDPLYV”(5C0A)。对于5个选择的表位,使用GRATCR来生成相应的TCR。然后用生成的TCR序列替换天然TCR中的CDR3区的序列(图4a)。为了获得有关这些修饰序列的结构信息,采用了AlphaFold3,它在预测生物分子结构和相互作用方面取得了重大突破,特别是在免疫学相关序列(例如抗体-抗原复合物)中,它已经证明了实质性的改进。为了评估预测的复杂结构及其相互作用,计算了溶剂可接触表面积(SASA)以评估蛋白质结构和功能。首先,计算了用生成的序列替换CDR3区域后,TCR-肽-HLA复合物的SASA值(图4b)。令人惊讶的是,**与天然CDR3相比,观察到SASA显着减少,这表明产生的TCR产生了结合更紧密的复合物,从而确保了折叠后蛋白质序列的结构稳定性。**接下来,通过计算TCRβ区和表位组合前后SASA的变化,重点关注TCR序列和表位之间的相互作用(图4c)。具有产生的CDR3的复合物比天然复合物表现出更高的价值,反映了产生的TCR和表位之间更大的相互作用界面和更紧密的结合。这一发现与之前探索中鉴别器的结合预测一致。总体而言,预测结果表明,生成的TCR序列有助于稳定复杂结构,验证GRATCR产生的序列的结构完整性和结合潜力。

●图4 用于量化结合潜力的结构分析。

6

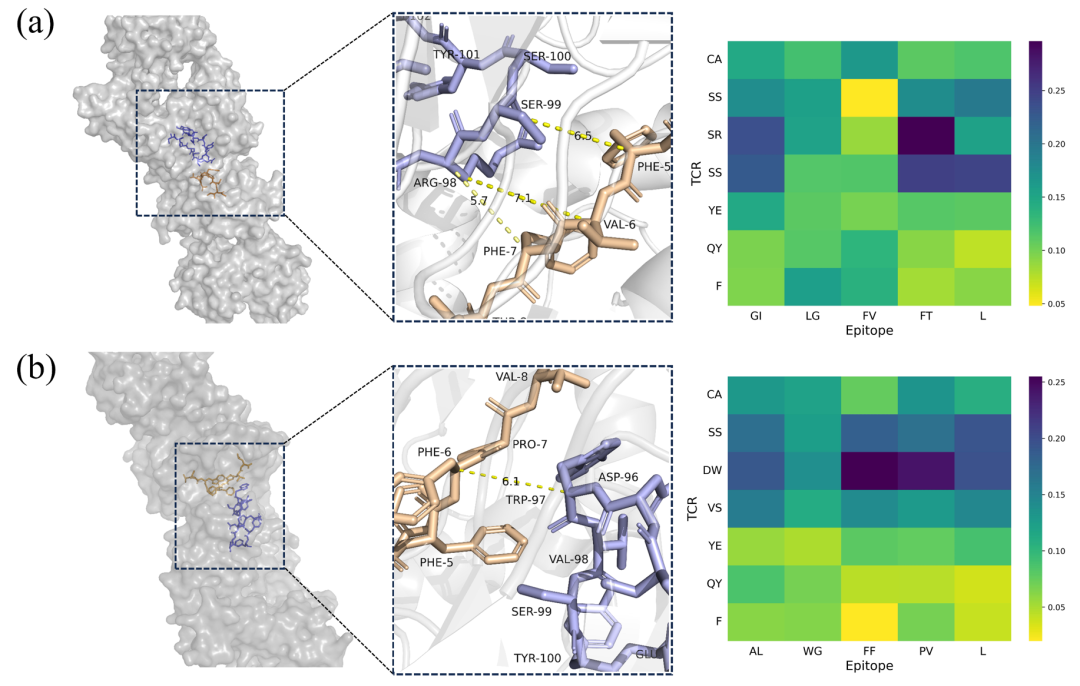

GRATCR可以捕获对结合至关重要的氨基酸残基

除了生成具有与给定表位相互作用的高潜力的TCR外,GRATCR还可以通过其可解释模块提供物理上有意义的见解。该模型融入了注意机制,能够阐明模型在训练期间获得的知识。从T-Encoder和T-Decoder之间的交叉注意层中提取特征,以确定这些特征是否揭示了生物学意义的见解。选择了2个TCR-表位对,分别是PDB ID 1OGA和1LP9作为示例。值得注意的是,这两者都没有出现在训练集中。在1OGA复合物中,表位的Phe-7和CDR3的Arg-98非常接近(<6Å),表明TCR和表位识别的关键位点。注意矩阵的可视化显示,序列“SR”和“FT”具有最高的注意分数(图5a),这表明该模型认识到了这种交互的重要性。类似地,在1LP9复合物中,Phe-5、Phe-6和Trp-97在3D空间中非常接近,Phe-5的芳香环朝向Trp。视觉矩阵中“DW”和“FF”的最高注意分数与这一观察结果一致(图5b),表明该模型还捕捉到了对特定识别至关重要的区域。这些发现表明,模型学习了一些控制TCR和表位结合机制的知识,使GRATCR能够产生具有令人满意的生物学功能和结合能力的TCR序列。

●图5 三维结构分析和相应的注意得分。

各工具的GitHub链接

GRATCR:https://github.com/zhzhou23/GRATCR

ERTransformer:https://github.com/TencentAILabHealthcare/ER-BERT

ATMTCR:https://github.com/hliulab/atmtcr

ERGO:https://github.com/IdoSpringer/ERGO-II

TEPCAM:https://github.com/Chenjw99/TEPCAM

ImRex:https://github.com/pmoris/ImRex

TEINet:https://github.com/jiangdada1221/TEINet

pMTnet:https://github.com/tianshilu/pMTnet

TITAN:https://github.com/PaccMann/TITAN

TCRPPO:https://github.com/ninglab/TCRPPO

TCR2vec:https://github.com/jiangdada1221/TCR2vec

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

613

613

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?