目录

3.3 对数几率回归

在上一节中使用线性模型进行回归学习,如果要做分类任务,则需找一个单调函数将分类任务的真实标记y与线性回归模型的预测值联系起来。

首先我们考虑一个简单的分类任务,其y值仅包含两个值0和1,即,由于线性回归产生的

是连续值,所以我们需要将连续值转换为0和1,最理想的函数就是单位阶跃函数。

如果线性回归的z值为正,则分类为1;如果线性回归的z值为负,则分类为0;如果z值为0,则分类任意判别。

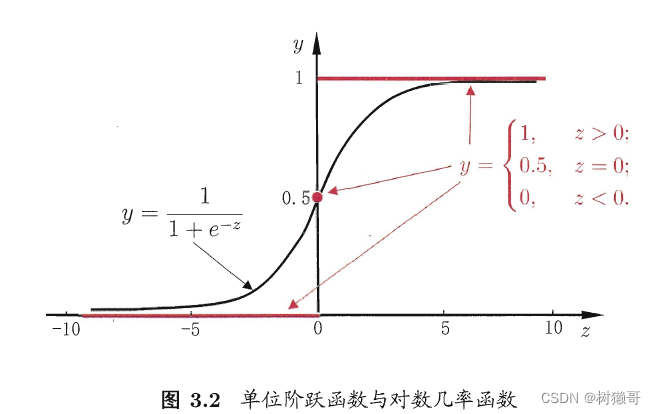

但单位阶跃函数的缺点是不连续,所以很不方便,因此我们需要找到一个单调可微的性质和单位阶跃函数类似的函数。对数几率函数就是一个常见的替代函数。

对数几率函数如下图所示:

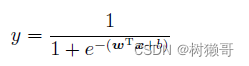

将线性回归中的因变量带入对数几率函数中的自变量,即

将线性回归中的因变量带入对数几率函数中的自变量,即

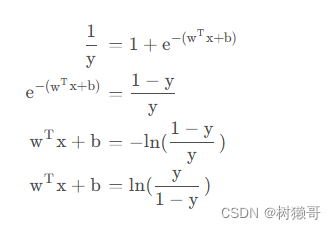

上式变换,即

若将y视作样本值为正例的可能性,那么1-y就是其为反例的可能性,两者的比值即为

,称为几率,反映了样本为正例的相对可能性,对其取对数就称为对数几率。

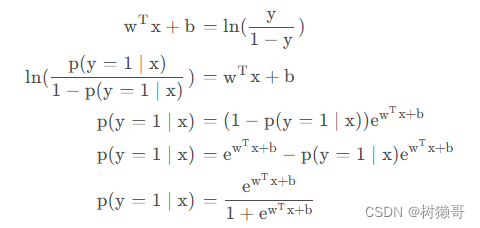

接下来需要确定w和b,将y视作为正例的可能性,变换得:

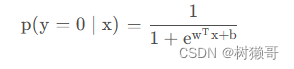

由于y仅有两种情况0和1,因此

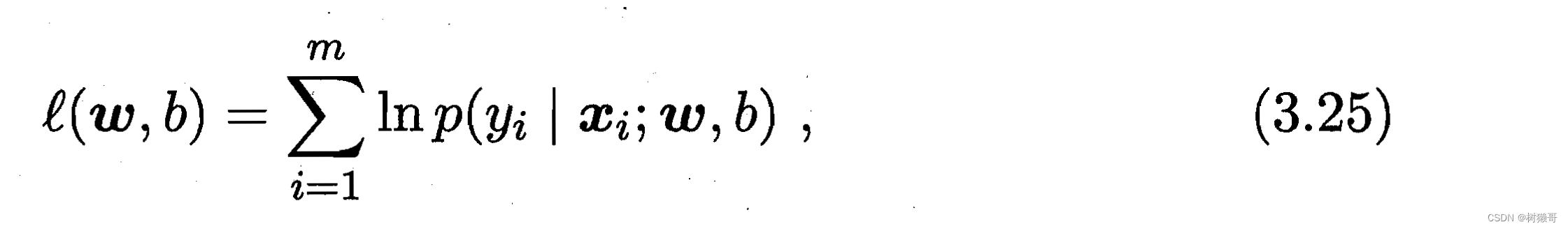

使用极大似然法对w和b进行估计(其思想为:已知某个参数能使得这个样本出现的概率最大,那么我们就将这个参数作为估计的真实值)

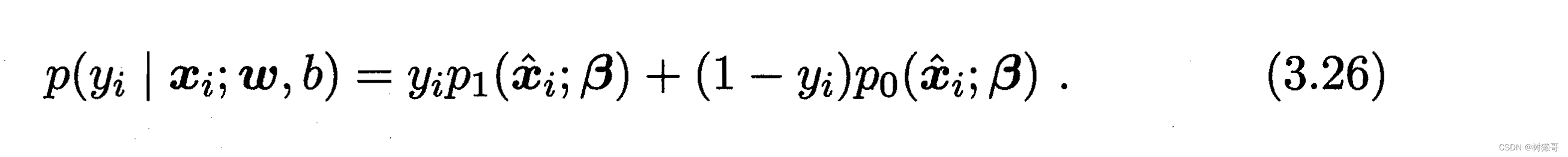

令 ,那么

可以简写为

;令

![]()

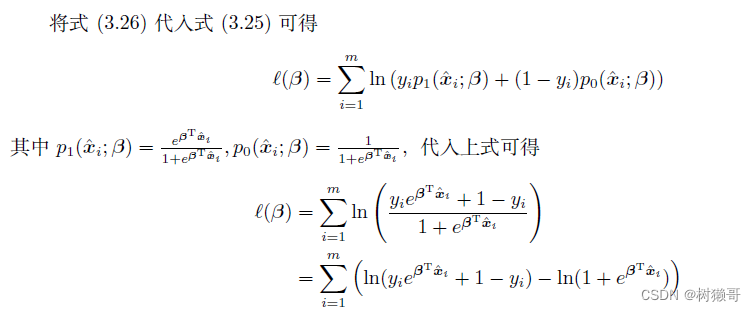

似然项可改写为

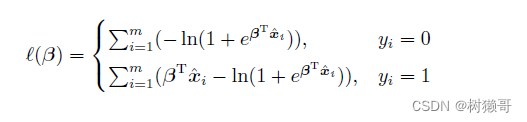

可以看到,当=1时,式子为

;当

=0时,式子为

只要使得这个式子组合的所有样本的函数最大,即可找到最优的w和b值.

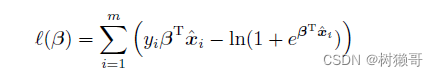

由于=0 或1,则

两式综合可得

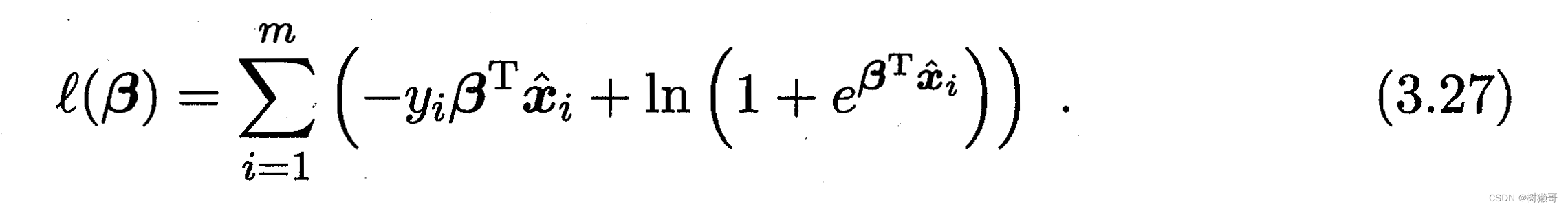

由于此式仍为极大似然估计的似然函数,所以最大化似然函数等价于最小化似然函数的相反数,即在似然函数前添加负号,即

311

311

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?