1.PCA简介

遭遇维度危机的时候,进行特征选择有两种方法,即特征选择和特征抽取。特征选择即经过某种法则直接扔掉某些特征,特征抽取即利用映射的方法,将高维度的样本映射至低维度。PCA(或者K-L变换),即Principal Component Analysis是特征抽取的主要方法之一。

PCA适用于非监督的学习的不带标签(带标签的样本,往往用LDA降维)的样本降维,特别是小样本问题。广义认为,这类样本属性之间的相关性很大,通过映射,将高维样本向量映射成属性不相关的样本向量。PCA的步骤是: 1.特征中心化。即每一维的数据都减去该维的均值。 2.计算协方差矩阵. 3.计算协方差矩阵的特征值和特征向量。 4.选取从大到小依次选取若干个的特征值对应的特征向量,映射得到新的样本集。

实际上,大的特征值表征这个映射向量——或者映射方向,能够使得样本在映射后,具有最大的方差。样本在这个方向最发散(stretched out)通常情况下,有用信息具有较大的方差,或者说较大的能量。反而言之,小的特征值对应的特征向量方向,样本映射后方差较小,也就是说噪声往往方差小(如高斯白噪声)。这是基于通常的情况,当然也可能说,高频信号往往类似于噪音(比如说图像噪声和边缘),也有小方差现象,此时可以利用到独立成分分析(Independent Component Analysis)。

可以证明,PCA映射过程满足一定最优性: 1.重建误差最小理论(reconstruction error)。误差的2范数等于未使用(剩下)的映射向量对应的协方差特征值之和。 2.最大方差理论。在信号处理中认为信号具有较大的方差,噪声有较小的方差,信噪比(信号与噪声的方差比)越大越好。 3.最小平方误差理论。简单理解,利用2范数求导可以得到样本中心最能代表所有的样本点,倘若从样本中心画出一条直线,在高维空间拟合样本集(即所有的样本离这条直线的垂直距离之和最短)。求出来的直线的方向,也是映射向量的方向,且大特征向量对应的方向所得到的直线,该平方误差最小。

2.Kernel-PCA

可以认为,PCA是一个去属性相关性的过程,这里的相关性主要指的是线性相关性,那么对于非线性的情况,怎么办,那这就涉及到Kernel—PCA即所谓的核PCA(KPCA)。直观来说,核PCA就是将原样本通过核映射后,在核空间基础上做PCA降维。自然而然,考虑用于分解的协方差矩阵,也应该变化。

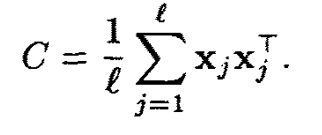

PCA的协方差矩阵为

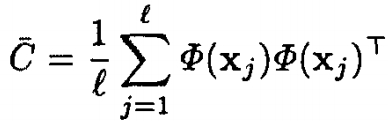

KPCA的协方差矩阵为

l为样本总数。我们先假设样本在核映射Φ(x)后也是中心化的——样本集经过Φ(x)一一映射后,均值仍然为0,即

但是,存在这样的一个问题,核函数是定义2个向量之间的关系,即 K(x,y)=(Φ(x)•

本文介绍了PCA的基本原理和作用,指出PCA在处理线性相关性时的效果。接着详细阐述了核PCA(KPCA),它是PCA在非线性情况下的扩展,通过核函数实现映射到高维空间后再降维。文章讨论了KPCA的映射样本中心化问题,并介绍了常见的核函数,特别是多项式核的显式映射机制。最后,总结了KPCA的关键步骤,强调了其在去除非线性相关性和降维中的应用。

本文介绍了PCA的基本原理和作用,指出PCA在处理线性相关性时的效果。接着详细阐述了核PCA(KPCA),它是PCA在非线性情况下的扩展,通过核函数实现映射到高维空间后再降维。文章讨论了KPCA的映射样本中心化问题,并介绍了常见的核函数,特别是多项式核的显式映射机制。最后,总结了KPCA的关键步骤,强调了其在去除非线性相关性和降维中的应用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1911

1911

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?