论文信息

标题:DRL-VO: Learning to Navigate Through Crowded Dynamic Scenes Using Velocity Obstacles

作者:Zhanteng Xie, Student Member, IEEE, and Philip Dames, Member, IEEE

时间:2023

来源:IEEE Transactions on Robotics

代码:https://github.com/TempleRAIL/drl_vo_nav

Abstract

本文提出了一种新颖的基于学习的控制策略,该策略对新环境具有很强的通用性,使移动机器人能够在充满静态障碍物和密集行人的空间中自主导航。

该策略使用输入数据的独特组合来生成所需的转向角度和前进速度:激光雷达数据的简短历史记录、附近行人的运动学数据以及子目标点。

该策略在强化学习环境中使用奖励函数进行训练,该函数包含一个基于速度障碍的新术语,以引导机器人主动避开行人并朝着目标移动。

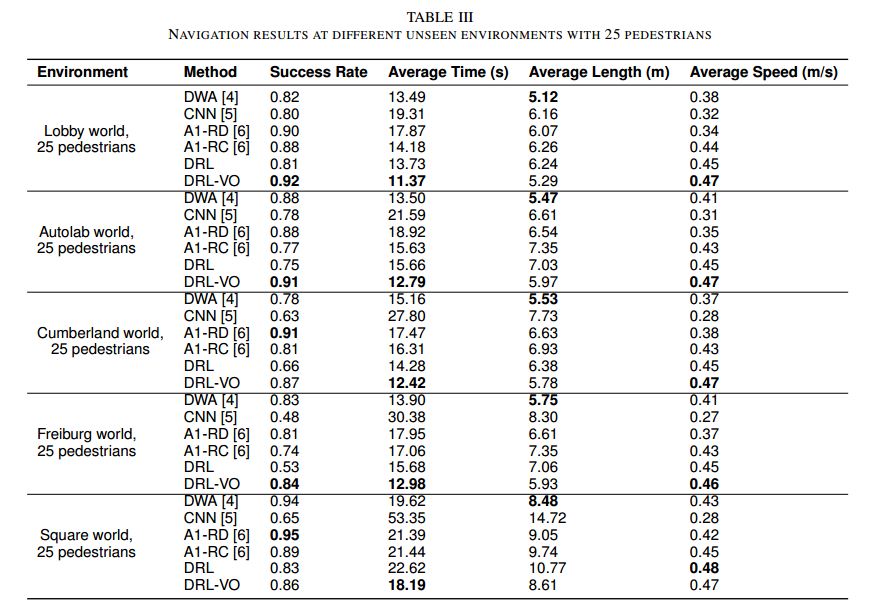

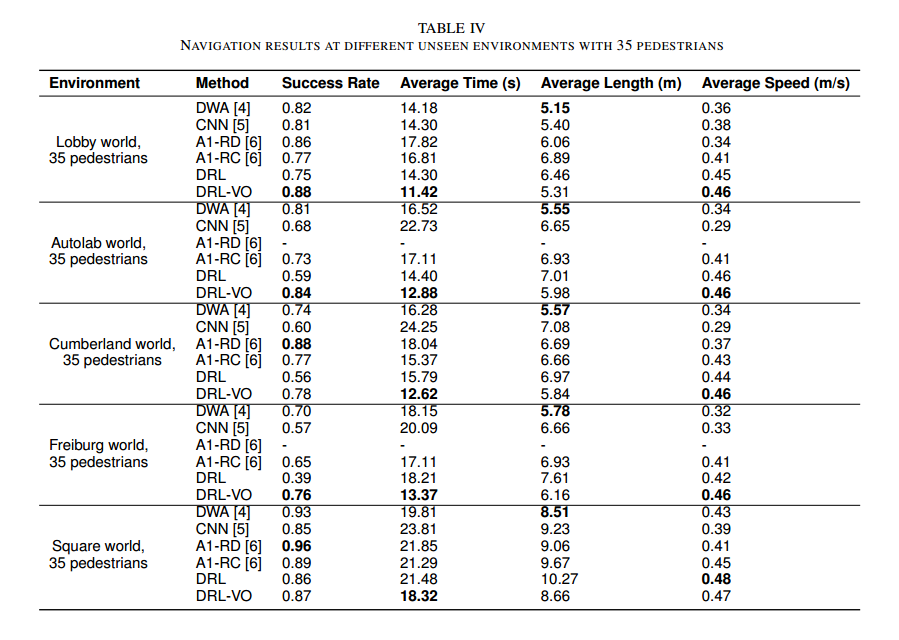

通过对多达 55 名行人的一系列 3D 模拟实验,与最先进的基于模型和和基于学习的控制策略相比,该控制策略能够在避免碰撞和速度之间实现更好的平衡(即更高的成功率和更快的平均速度),并且它还可以更好地推广到不同的人群规模和看不见的环境。

一系列广泛的硬件实验证明了该策略能够直接在具有不同人群规模的不同现实环境中工作且零再训练的能力。此外,一系列模拟和硬件实验表明,该控制策略也可以在不同机器人平台上的高度约束的静态环境中工作,而无需任何额外的训练。

Introduction

移动机器人面临的主要挑战是感知复杂的环境,尤其是未知和动态的行人;提取有用的信息;并制定一项可实现自主导航的政策.

在本文中,我们使用了一种新颖的基于深度强化学习(DRL)的方法,因为我们希望机器人运行的环境非常复杂,有数十名行人在密集的人群中移动,这使得在传统的机器人中设计清晰的规则变得困难基于模型的框架或收集足够代表性的训练数据以应用监督学习技术。虽然使用 DRL 来生成控制策略变得越来越普遍,但本文提出了八个主要贡献:

1)我们使用汇集激光雷达数据的简短历史记录,为基于神经网络的控制策略的输入创建了一种新颖的数据表示组合、附近行人的当前运动学以及子目标点。我们通过将所有数据放入机器人的局部坐标系中来设计这些表示,以对定位错误具有鲁棒性,并通过根据原始传感器数据手工制作更高级别的表示来提高对新环境的通用性。

2)我们应用速度障碍理论为 DRL 框架创建一个新的奖励函数,鼓励机器人主动避免碰撞。

3) 我们在多个模拟 3D 环境中验证导航性能,并证明所提出的控制策略在避免碰撞和速度之间实现了更好的权衡,并更好地推广到不同的人群规模和新的看不见的环境比最先进的方法,包括基于模型的控制器[4]、基于监督学习的方法[5]和两种基于DRL的方法[6]。

4)我们证明,我们的策略仅在具有单一人群规模的单一模拟环境中进行训练,可以直接在看不见的环境中用于现实世界的机器人,包括天普大学校园的室内和室外位置以及不同的人群密度无需任何再培训。

5)我们证明了我们提出的控制策略在高度受限的静态环境和不同的机器人平台上有效工作,无需任何重新训练。为此,我们参加了 2022 年 IEEE 国际机器人与自动化会议 (ICRA) 的基准自主机器人导航 (BARN) 挑战赛,在模拟竞赛中获得第一名,在硬件竞赛中获得第三名 [7]。

6) 我们将代码和 3D 人机交互模拟器开源:https://github.com/TempleRAIL/drl_vo_nav。

7)我们对从基于模型到基于学习的方法等最密切相关的工作进行了详细的文献综述。

8)我们从我们的工作中总结了几个可以应用于其他机器人学习系统的重要设计原则。

Related Work

Model-based Approaches

典型的基于模型的方法是 ROS [8] 导航堆栈,它使用成本图来存储障碍物信息,并使用动态窗口方法(DWA)规划器 [4] 进行局部规划。基于 ROS 导航堆栈,[9] 最近将人类安全和可见性成本图添加到全局和本地规划器中,以处理人类感知的导航问题。另一类基于模型的方法是基于速度障碍的算法[10]-[12],它将动态环境映射到机器人速度空间,并根据这些速度约束生成安全控制速度。

类似地,Arul 等人 [13] 将相互速度障碍与缓冲 Voronoi 单元相结合来解决多智能体导航问题。第三类基于模型的方法使用模型预测控制[14]、[15],它可以将碰撞避免和障碍物动力学集成到机器人约束中。

其他基于模型的方法尝试使用社会力[16]、[17]、高斯混合模型(GMM)[18]或势函数和极限环的组合来直接模拟人类和机器人如何交互[19]。所有这些基于模型的方法都需要行人运动学知识,利用多阶段程序来处理传感器数据,并且通常需要从业者仔细手动调整模型参数,这使得它们难以实施和推广到新场景

Supervised Learning-based Approaches

最近的几项工作使用深度神经网络来学习直接从原始传感器数据生成转向命令的端到端控制策略。

Pfeiffer 等人 [20] 创建了一个数据驱动的端到端运动规划器,它使用卷积神经网络 (CNN) 从原始激光雷达数据生成线速度和角速度。 Tai 等人 [21] 还使用 CNN,使用原始深度相机数据作为输入,从五个离散机器人控制命令之一中进行选择。 Loquercio 等人[22]使用类似的方法与原始相机图像数据来训练控制策略,使无人机能够在街道上安全行驶。同样,Kahn 等人 [23] 也使用原始相机图像数据来训练基于端到端学习的移动机器人导航系统,该系统可以在具有几何干扰障碍物的现实环境中导航。然而,这些端到端方法大多数只关注静态环境。

对于动态环境,Pokle 等人 [24] 使用多个 CNN 网络从原始传感器数据中学习多模态高级特征。基于 CNN 的局部规划器融合这些特征来生成速度命令。然而,他们学习到的基于特征的策略仅在相对开放的模拟环境中进行了测试,且移动行人不超过 3 个。对于多达 50 名移动行人的高度拥挤的动态环境,我们之前的工作 [5] 提出了一种基于 CNN 的策略,该策略将激光雷达数据的简短历史记录与附近行人的运动学数据相结合。 然而,正如我们将展示的,以监督方式训练的策略并不像本文的方法那么有效,特别是当应用于新的环境或人群规模时。

Reinforcement Learning-based Approaches

与基于监督学习的方法相比,基于 DRL 的方法更常用于动态环境中的导航。使用近端策略优化(PPO)算法[25],Long等人[26]、[27]首先提出了一个使用2D原始激光雷达距离数据的完全去中心化的多机器人防撞框架。沿着这个思路,Guldenring等人[6]研究了2D激光雷达数据的不同状态表示,并使用PPO训练算法来训练人类感知的导航策略。 Arpino 等人[28]提出了一种多布局训练机制,该机制使用原始激光雷达数据作为输入来训练室内导航策略。Huang等人[29]构建了一个多模态后期融合网络来融合原始激光雷达数据和原始相机图像数据。尽管这些传感器级方法可以快速轻松地生成控制策略,但它们无法区分静态或动态障碍物,也无法利用障碍物的位置和速度等高级信息。

为了解决仅使用原始传感器数据的局限性,许多其他工作利用有关行人运动的信息来实现动态环境中的安全导航。 Everett 等人[30]-[32]直接将行人的相对位置和速度输入神经网络,并为行人丰富的环境生成社会意识的防撞策略。 Chen 等人[33]专注于通过自注意力机制联合建模人与机器人以及人与人的交互。紧接着,他们还提出了一个关系图学习网络来推断机器人与人类的交互并预测他们的轨迹[34]。类似地,另一项工作[35]使用图卷积网络(GCN)对人群状态进行编码并预测人类注意力。最近,Liu等人[36]使用分散结构循环神经网络(RNN)来模拟机器人和行人之间的交互。这些代理级方法的一个主要缺点是它们仅适用于解决开放空间中的拥挤导航问题,而忽略了布局中的静态障碍物和几何约束。为了解决这个问题,Liu等人[37]通过添加额外的静态障碍物图来扩展[33]的工作,但他们需要两个并行网络模型来处理行人的存在/不存在。 Sathyamoorthy 等人 [38] 通过使用后期融合网络将原始激光雷达数据与行人轨迹预测相结合,扩展了 [26] 的 PPO 训练策略。 Dugas 等人 [39] 使用无监督学习架构来预测和重建未来的激光雷达潜在状态。然而,上述大多数工作只关注于利用传感器感知信息及其数据表示,而忽略了奖励函数的设计。

为此,Xu等人[40]提出了一个知识蒸馏奖励项来鼓励机器人学习专家行为。Patel 等人[41]提出了一种基于方形警告区域的奖励函数,以鼓励机器人沿着与障碍物前进方向相反的方向导航。然而,知识蒸馏奖励的效果很大程度上取决于专家数据集的质量,并且基于方形警戒区域的奖励函数过于保守,导致行动缓慢。

Comparative Analysis

有大量研究关注机器人导航问题,其解决方案从传统的基于模型的方法到基于监督学习的方法再到基于强化学习的方法。典型的基于模型的方法计算有效路径,参数易于解释,但需要针对不同场景手动调整模型参数[4]、[9]-[19]。基于监督学习的方法纯粹是数据驱动的且易于使用,但需要费力地收集一组有代表性的专家演示来训练网络[5]、[20]-[24]。基于强化学习的方法是经验驱动的,类似于人类学习,但需要仔细设计奖励函数[6]、[26]-[41]。尽管每种方法都有自己的优点和缺点,但我们选择基于强化学习的框架,因为在不受控制和充满人类的环境中很难手动设计通用模型或收集有效的训练数据。

对于任何不同的自主导航方法,一组关键问题是使用哪些传感器数据、如何处理它以及使用哪些数据表示。

基于模型的方法通常预处理原始传感器数据并使用提取的高级信息,例如障碍物成本图[4]、[9]、障碍物的相对速度[10]-[13]和环境动态[ 14],[15]。另一方面,专注于静态环境的端到端学习方法直接将原始传感器数据(例如激光雷达[20]或摄像机[21]-[23])和目标信息输入CNN。基于 DRL 的方法更加多样化,其中一些还将原始激光雷达扫描(和目标点)输入 CNN [6]、[26]–[29],而另一些则提取和利用行人的位置和速度 [30]–[32]、模型机器人与人类的交互[33],[35]-[37],预测行人轨迹[34],[38],预测潜在状态[39],或构建障碍成本矩阵[41]。

基于模型的方法的长期成功和最近的 DRL 研究结果证明了预处理数据表示相对于原始传感器数据的实用性,因为它们包含有关行人运动的更多有用信息,从而提高了动态环境中的安全性。

基于这些趋势,我们还将利用预处理的传感器数据,即激光雷达数据的简短历史和行人的当前运动学,我们之前证明这些数据能够在监督环境中提高导航安全性[5]。

这种数据表示的一个显着优点是,它比其他基于 DRL 的作品中使用的复杂行人预测或交互更简单、更容易解释 [33]-[38]。此外,所有数据都完全在机器人的局部坐标系内表示,使得解决方案对定位错误具有鲁棒性,这在密集拥挤的动态环境中很常见。

使用 DRL 的最大挑战之一是设计适当的奖励函数。大多数方法包括两项,一项是奖励实现目标的进展,一项是惩罚冲突[6]、[26]-[39]。虽然这种简单的奖励函数设计可以很好地发挥作用,但它们的稀疏避碰奖励函数只给出了较大的负奖励来惩罚碰撞,并没有给出直接有效的奖励信号来引导机器人主动避开障碍物。事实上,被动避碰奖励函数是一个零阶函数,这意味着它假设碰撞风险仅取决于与障碍物的距离。我们认为,行人(和其他物体)的相对运动更为重要,因为人们经常在密集的人群中紧密跟随,并在相反方向行走时留出更多空间。对此的一种尝试是[41]中的反向奖励函数,它优先考虑安全,但会导致动作缓慢,并可能在密集人群中导致僵局。

我们提出了一种新颖的奖励函数,它使用一阶速度障碍来惩罚可能导致碰撞的航向,从而引导机器人不断调整其航向方向,在朝着目标前进的同时主动避开人群。请注意,Han 等人[42]同时开发了一种用于分布式多机器人导航的基于倒数速度障碍(RVO)的奖励函数。这与我们的速度障碍概念相似,但有两个主要区别。首先,我们的工作和他们的工作解决了两个不同但相关的问题。我们试图通过使用 VO 来防止机器人与人类发生碰撞,这将避免碰撞的负担完全放在了机器人身上,因为我们无法直接建模或控制人类行为。另一方面,Han 等人 [42] 试图通过使用 RVO 来防止机器人与机器人之间的碰撞,RVO 假设两个智能体都运行相似的控制策略,从而在智能体之间分担避免碰撞的负担。其次,我们的方法鼓励机器人主动转向目标,同时避免未来潜在的人机碰撞,而他们的方法则鼓励机器人仅关注潜在的机器人与机器人碰撞(根据预期碰撞时间来判断),而忽略目标。 Sun 等人 [43] 还将 RVO 与基于 DRL 的控制策略结合使用以进行多机器人导航。然而,他们没有在 DRL 奖励函数中使用 RVO,而是将其用作并行控制策略,在碰撞即将发生时从 DRL 切换到 RVO。

受上述问题和方法的启发,本文从传感器数据表示和奖励函数设计两个核心问题入手,解决动态人群中的自主导航问题。我们使用预处理传感器数据的独特组合作为控制策略的输入。具体来说,我们**从激光雷达数据的简短历史中获得有关静态障碍物和环境几何布局的信息,从多目标跟踪器获得有关动态障碍物的运动学信息,以及有关如何从子目标点到达目的地的信息。**在设计我们新颖的奖励函数时,我们利用基于模型的方法(即速度障碍)的实用性来创建一个导航策略,该策略不具有与速度障碍相同的缺点。具体来说,我们的政策并不要求机器人拥有有关行人运动学的完美信息。这个新术语将使我们的机器人能够学习强大的导航策略,并在避免碰撞和速度之间取得良好的平衡。

Navigation Policy

Problem

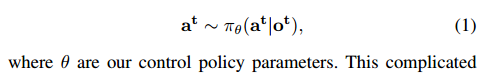

从传感器中提取和处理有用信息以获得对环境的部分观察是机器人在复杂且有人的环境中自主快速导航的第一步。然后,机器人将部分观察结果 t 馈送到控制策略

π

θ

π_θ

πθ 中,以计算合适的转向动作

a

t

a^t

at ,其定义为

这个复杂的导航决策过程可以表述为部分可观察马尔可夫决策过程(POMDP),用6元组表示<S, A, T, R, Ω, O>, 其中 S 是状态空间,A 是动作空间,T 是状态转移模型,R 是奖励函数,Ω 是观察空间,O 是观察概率分布。

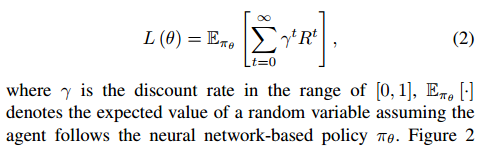

DRL 的总体目标 L(θ) 是通过优化基于神经网络的策略 πθ 来最大化预期贴现收益:

图 2 概述了我们的 DRL 网络,它由四个模块组成:特征生成、特征提取器、actir和critic。特征生成模块从原始传感器数据生成我们的中间特征,即部分观察 ot 。然后,特征提取器模块从 o t 中提取高级特征,critic 模块生成状态值,actor 模块生成转向动作 a t 。

我们使用相同的部分观察 o t = [ l t ; P t ; g t ] o^t = [l^t ; P^t ; g^t ] ot=[lt;Pt;gt]作为我们之前使用监督学习的工作[5],它由三个预处理组件组成:激光雷达历史(lt)、行人运动学(pt)和子目标位置(gt)。观察 t 中的所有数据都在机器人的局部参考系中表示。这使得我们的方法能够对机器人定位相对于全局参考系的错误具有鲁棒性,这种情况在密集的动态环境中更频繁地发生,因为机器人用于定位自身的固定地标较少。此外,相对数据对于规划目的来说更自然,因为在密集的人群中导航更多的是顺应交通流,而不是满足某些绝对速度限制。

我们将简要总结下面从原始传感器数据中提取观测数据的过程。先前工作的关键特征之一是使用手工制作的中间特征,这使我们能够设置控制策略的大小。我们通过对所有输入类型使用一致的数据格式来实现这一点,在我们的例子中是 80 × 80 网格

-

行人运动学(Pedestrian Kinematics):与用于人群流量预测的复杂 CAGE 表示[46]不同,它仅对人群位置信息进行编码,我们提出的简单的行人运动学地图表示对检测到的行人的位置和速度信息进行编码。具体来说,我们将行人运动学编码在一对 80 × 80 网格中,其中包含有关机器人前面 20 × 20 m 区域中所有行人的相对位置和速度的信息。为了创建这些网格,我们首先将来自深度相机(即 ZED 相机)的 RGB 图像和 3D 点云输入 YOLOv3 [47] 检测器,以检测行人并提取他们的相对位置。一旦我们提取了这些瞬时估计,我们就使用多重假设跟踪器(MHT)[48]来跟踪行人的相对位置和速度。速度值存储在网格中,使用位置值来确定单元索引,如图 2 的特征生成块中的 ZED 相机轨迹所示。

-

激光雷达历史记录(Lidar History):激光雷达数据 l t 由 0.5 s 数据的历史记录(即 10 次扫描)组成,其中我们对每次扫描应用最小池化和平均池化的组合。将生成的池数据堆叠 4 次以创建 80×80 阵列,如图 2 的特征生成块中的 Hokuyo 激光雷达轨迹所示。这种数据格式与我们之前的工作[5]相同,但在这里我们展示了用于选择这种数据格式和相应参数(例如历史长度)的消融研究的结果。

首先,受[49]中激光雷达数据下采样操作的启发,我们探索了不同激光雷达预处理操作的使用,包括重塑原始激光雷达数据、将扫描点投影到占用网格图中以及池化(最小值、平均值、中值和最大限度)。我们使用这些不同操作中的每一个及其几种组合,使用[5]中的数据集以监督方式训练我们的导航策略。图 3(a) 显示了所得的均方误差 (MSE),即每个所得控制策略的学习速度和专家速度之间的损失。我们发现,如图 3(a) 所示,结合使用最小池化和平均池化来提取每个扫描区域的两个单独的距离测量值,可以获得最佳性能。

一旦我们确定了构建激光雷达数据的信息最丰富的方式,我们就会研究扫描历史记录要保留多长时间。我们考虑了 0、0.25、0.5、1 和 2 秒的时间窗口2,使用与研究不同激光雷达预处理操作时相同的训练和验证程序。图 3(b) 显示了每个最终控制策略的 MSE 损失曲线。我们看到,激光雷达数据的简短历史记录比仅当前扫描(即 0 秒)包含更多有用的信息,而保留超过特定时间段的数据会导致性能没有改善甚至下降。我们发现最佳时间窗口为 0.5 秒(即 10 次激光雷达扫描),我们从概念上将其视为行人信息的有效时间常数。 -

目标位置(Goal Position):最后,机器人需要知道目标的相对位置。我们不是将最终目标点输入到我们的 DRL 网络中,而是沿着标称路径使用子目标点到达最终目标,因为这允许机器人在复杂的非凸环境中遍历长路径,并避免归一化问题,因为到子目标的距离是恒定的。为了选择子目标 g t ,我们使用纯追踪算法 [50],该算法计算沿完整路径位于机器人前方指定距离(在我们的例子中为 2 m)的点。通过调整这个距离,机器人可以看远处或近处。图 2 说明了特征生成块的目标点轨道中的此过程。我们假设这个子目标信息将使机器人能够更准确地导航到最终目标位置。

Action Space

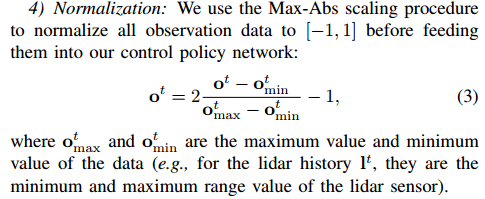

我们的 DRL 控制策略的动作 a t = [ v x t ; ω z t ] a^t = [v^ t_x ; \omega ^t_z ] at=[vxt;ωzt] 有两项,即本地机器人坐标系中的前向速度 ( v x t v^ t_x vxt ) 和旋转速度 ( ω z t \omega ^t_z ωzt )。请注意,我们使用连续的动作空间,因为我们相信这可以使机器人获得更准确的控制。

我们将前向速度 v x t v^ t_x vxt 的范围限制为 [0; 0:5] m/s 和旋转速度 ω z t \omega ^t_z ωzt 到 [−2; 2] rad/s 基于我们的目标硬件平台 Turtlebot2 的限制。

请注意,与观察空间类似,我们还使用 Max-Abs 缩放过程将动作空间标准化为 [-1, 1]。

Network Architecture

特征提取器网络与我们之前的工作 [5] 的主干 CNN 网络相同,它融合了激光雷达历史观测 l t 和行人运动学观测 p t 。提取高级特征后,使用单个全连接层将这些高级特征与子目标信息融合。演员模块和评论家模块都是由两个完全连接的层简单构建的。请注意,我们的特征提取器模块中的每个卷积层后面都有一个批量归一化层和一个修正线性单元(ReLU)动作层。此外,我们的特征提取器中的最后一个全连接层后面是 ReLU 动作层,而 actor 和 Critic 模块的最后一个全连接层没有 ReLU 动作层。

我们的架构是中间融合网络的示例,因为来自不同输入流的数据在原始数据输入和输出之间的链的中间融合。 Feng等人[51]提供了关于不同融合架构(在一般情况下)的详细讨论,这些架构通常被分类为早期、中期或晚期融合。他们指出,没有确凿的证据支持哪种融合网络是最佳选择,尽管神经网络的计算负载与其结构之间存在联系,因为层数及其大小都会影响必须进行的计算数量。完成产生和输出以及存储神经网络参数所需的存储器。为了检查这一点,我们使用与之前的工作[5]相同的数据集和监督训练方式来训练两个网络。第一个,我们称为“中间”,将行人运动学和激光雷达数据融合到特征提取器块的输入处,就像我们上面所做的那样;第二个称为“后期”,在特征提取器块的输出之前融合所有数据。从表一可以看出,Early 网络的大小约为 Late 网络结构的一半,处理速度几乎翻倍,回归性能稍好,均方根误差 (RMSE) 和解释方差比 (EVA) 更小。 )。

与我们的网络一样,大多数其他基于神经网络的控制策略 [24]、[28]、[29]、[38] 也使用后期或中期融合架构,因为这允许灵活的设计,因为不同的输入源各自产生一些学习的中间结果全部在下游组合的表示。这些与我们的架构之间的主要区别在于,我们使用手工制作的特征作为中间表示,就像传统的基于模型的算法一样,而不是基于学习的算法中典型的学习特征。这种方法的一个好处是我们的数据表示(即行人地图)独立于所使用的特定对象检测和跟踪工具。这使我们能够轻松地将 YOLO 和 MHT 替换为不同的方法,而无需重新训练

Reward Function

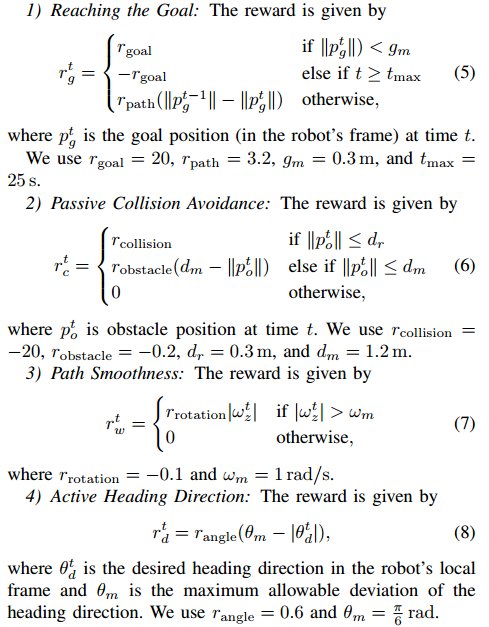

强化学习方法的一个本质问题是如何设计一个好的奖励函数来引导智能体学习期望的行为。导航任务有两个相互竞争的目标,我们希望机器人尽快移动以在最短的时间内到达目标,同时又安全地避免与任何静止或移动的物体碰撞。因此,我们设计了一个多目标奖励函数:

请注意,大多数先前的工作[6]、[26]-[39]仅使用这种零阶被动避碰奖励

r

c

t

r^t_c

rct (一种基于位置的启发式方法)来引导机器人被动避开障碍物。

虽然这些标准术语对于学习良好的导航行为很有用,但我们希望允许机器人间接地从成功的基于模型的导航策略中学习。为此,我们引入了一个新的奖励项 r d t r^t_d rdt,它使用速度障碍物 [10] 来设置所需的导航方向。该术语允许机器人使用一阶运动学信息(即速度)主动避免碰撞,同时朝着目标前进。

该奖励项的关键是找到朝着目标移动且无碰撞的所需方向

θ

d

t

θ^t_d

θdt 。为此,我们扩展了速度障碍的概念[10]。

速度障碍物

V

O

A

,

B

VO_{A,B}

VOA,B 是机器人A当前速度在未来某个时间会与障碍物B发生碰撞的速度空间,如图4所示。为了定义速度障碍V

V

O

A

,

B

VO_{A,B}

VOA,B,我们首先需要定义特殊占用区域:

使用碰撞锥 C C A , B CC_{A,B} CCA,B,机器人可以知道哪些前进方向角度会导致与 MHT 跟踪的所有移动行人发生碰撞。然后,机器人使用这些碰撞锥和子目标 (θg) 的方向,通过算法 1 找到所需的航向角 θ d t θ^t_d θdt。

Deep Reinforcement Learning Algorithm

虽然有许多深度强化学习算法,但我们使用近端策略优化(PPO)算法[25]来训练我们的DRL网络。 PPO 算法的一个主要优点是它实现起来更简单,并且可以比其他最先进的算法(例如 A2C [52]、TRPO [53] 和 ACER [54])获得可比或更好的结果。 。此外,许多其他机器人导航工作[6]、[26]、[27]、[41]都使用PPO,并发现它在导航问题上效果很好。正如[25]所建议的,我们使用Adam优化器[55],一种随机梯度下降方法,来寻找最优策略参数θ*。

Experiment

Conclusion

在本文中,我们提出了 DRL-VO 控制策略,使机器人能够在具有静态障碍物和动态行人的拥挤动态环境以及高度受限的静态环境中进行自主导航。

从详细的背景材料分析来看,我们的 DRLVO 控制政策有两个关键的创新点。首先,我们提出了一种新的预处理数据表示组合,它可以在最多 55 名行人的拥挤动态环境中很好地工作,并弥合了不完美的模拟与现实之间的外观差距。具体来说,机器人融合了激光雷达数据的简短历史记录、当前行人运动学(即存储在两个网格中的位置和速度)和子目标点。所有这些数据都在机器人的本地坐标系内表示,这使得我们的导航策略对于拥挤、动态环境中常见的定位错误具有鲁棒性。其次,我们设计了一种新颖的基于速度障碍的奖励函数,用于训练策略,可以轻松应用于多机器人导航策略。该奖励使用有关行人的一阶信息来引导机器人主动转向目标,同时避免未来潜在的碰撞。

我们证明,与其他最先进的基于模型、基于监督学习和基于 DRL 的策略相比,我们的 DRL-VO 策略能够更好地泛化,并在不同人群规模和不同未见环境的碰撞避免和速度之间保持更好的平衡政策,实现了几乎恒定的平均速度,但在一系列 3D 模拟实验中具有更高的成功率。我们还通过大量的硬件实验证明,我们的 DRL-VO 策略克服了模拟与真实的差距,并且在具有不同人群规模的现实室内和室外环境中可靠地工作,并且无需任何微调即可做到这一点或修改。此外,通过参加 ICRA 2022 BARN 模拟和现实世界挑战赛并分别获得第一和第三,我们证明了我们的 DRL-VO 策略也可以很好地推广到高度受限的环境、不同的输入传感器和不同类型的机器人。最后,我们总结了从我们的工作中吸取的一些经验教训,以帮助其他研究人员提高基于学习的算法的通用性,选择用于移动机器人平台的网络架构,弥合模拟与现实之间的差距,并设计适当的奖励函数。

850

850

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?