深度学习离不开最基本的BP神经网络,这里把公式推一遍

目录:

一、正向传播

二、反向传播

三、迭代过程

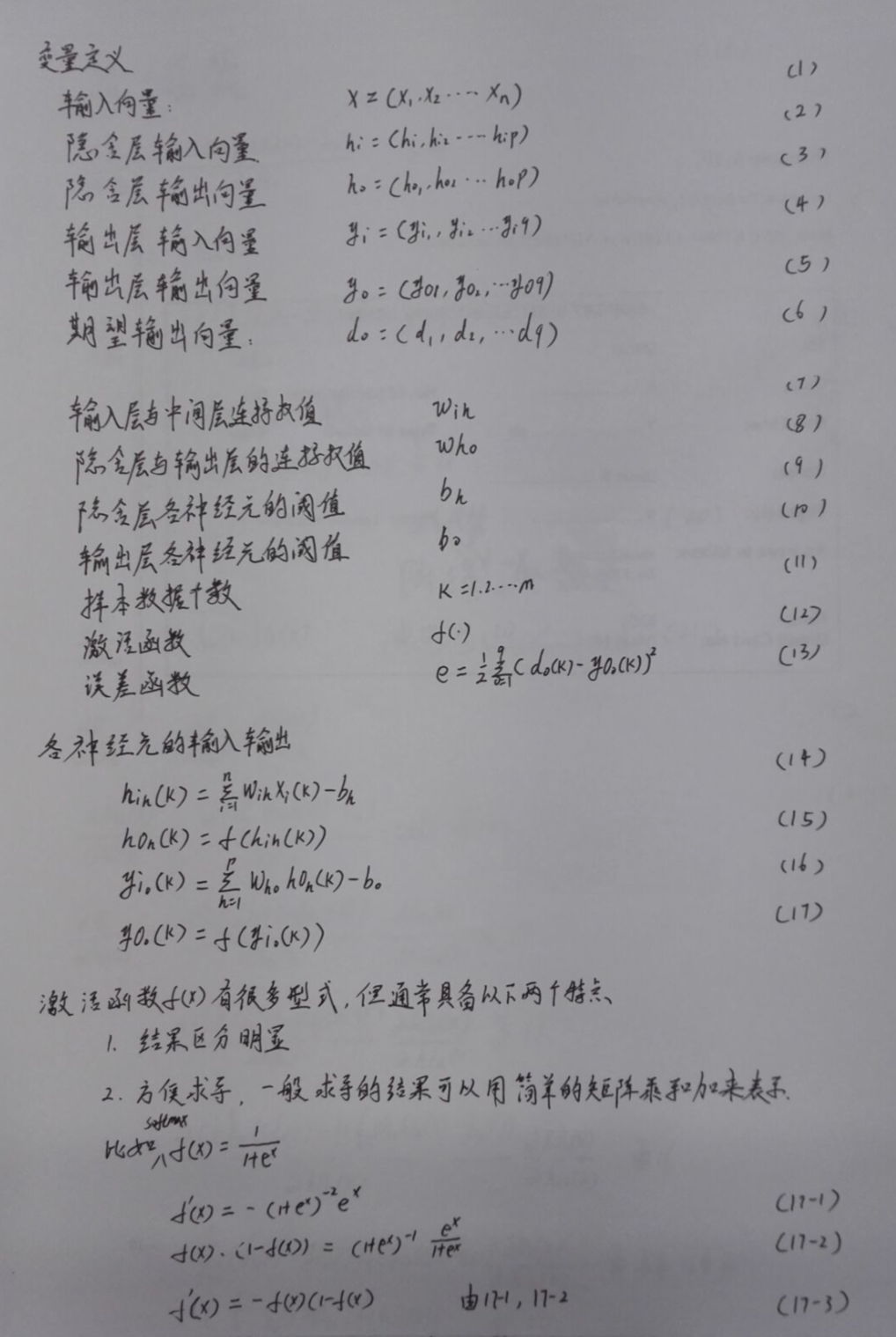

神经网络的核心在BP网络,其主要分为正向传播和方向传播两个过程。

一、正向传播过程

公式见图,14~17,从输入xi得到输出yo

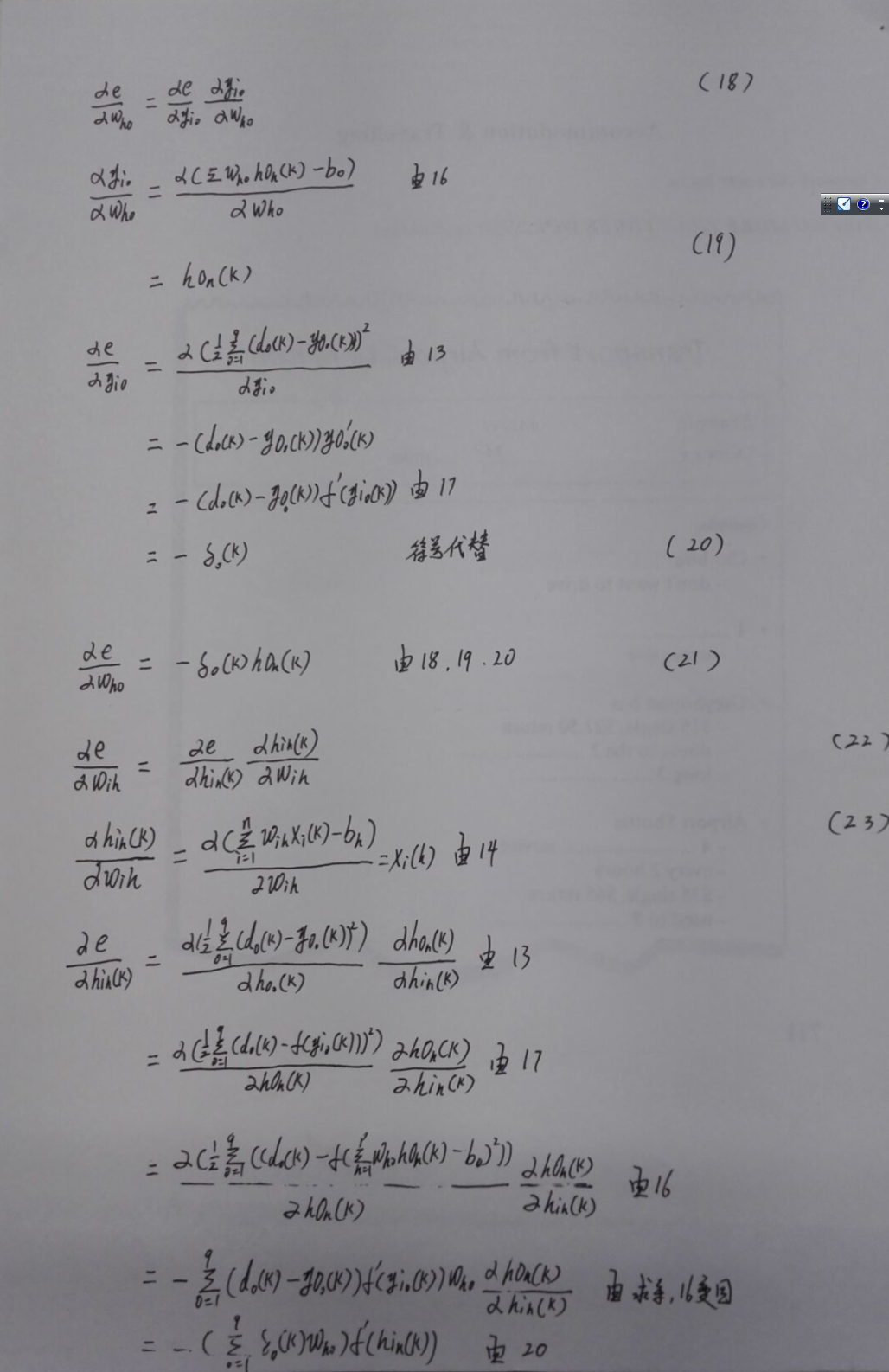

二、反向传播过程,

反向传播主要是为了调整各传播层的W值

公式推导见图18~26

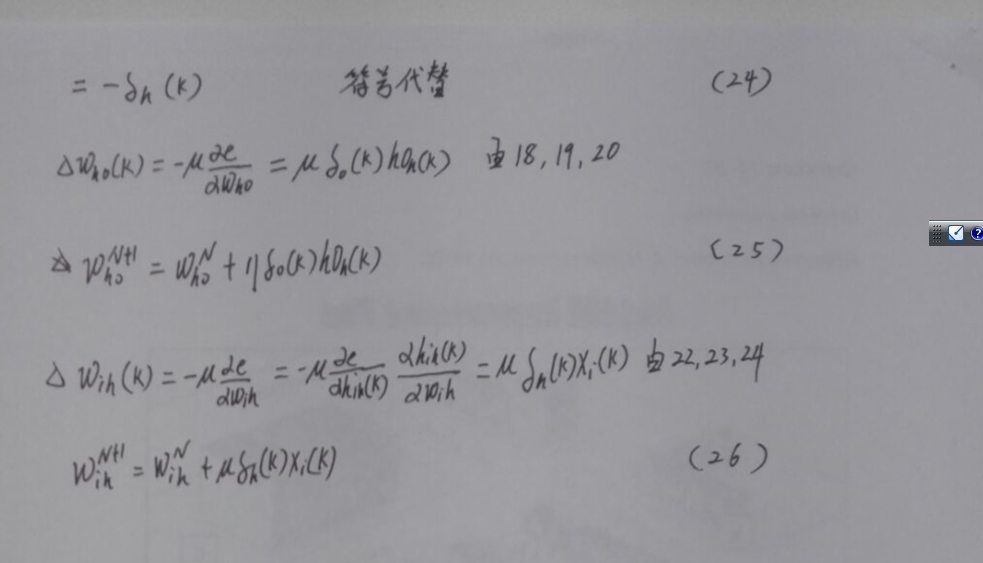

三、迭代过程

1、我们希望知道在每一个w向哪个方向调整才能减少误差,于是我们根据误差对w求偏导,偏导数的方向就是我们要调整的方向:见公式18,21

2、得到偏导数后,我们知道了在每一个w方向上我们应该调整的方向,那每次在这个方向上调整多少呢,一般我们可以设一个固定值,或者一个不断变小的值,就是一步步试(参看梯度下降和数值优化,

http://blog.csdn.net/qjzcy/article/details/51946304):在公式25,26步中我们得到了w的迭代公式。u为我们设置的迭代步长。

3、之所以公式我们衍化了半天,是因为我们希望在计算过程中能得到简化。

由于激活函数的导数可以由简单的乘和加来获得(见公式17-3),结合20,24代入25,26步我们发现只需要用每层的输入输出简单的加减乘除计算就可以完成,是不是很有数学上的美感。

761

761

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?