1

大模型镜像地址:https://aifasthub.com/models/baichuan-inc/Baichuan2-7B-Chat

modelscope:

https://www.modelscope.cn/docs/%E6%A8%A1%E5%9E%8B%E7%9A%84%E4%B8%8B%E8%BD%BD

wget https://aifasthub.com/models/baichuan-inc/Baichuan2-7B-Chat/pytorch_model.bin?download=true --no-check-certificate

参考:https://developer.aliyun.com/ask/485416

在阿里云计算机视觉中,ModelScope Cache环境变量用于指定缓存模型的路径。当您使用 ModelScope 进行模型推理时,如果本地没有相应的模型文件,则会从缓存中加载模型。因此,设置正确的缓存路径非常重要,以确保您的推理请求能够快速地得到响应。

要设置 ModelScope Cache 环境变量,请按照以下步骤操作:

打开终端或命令提示符窗口。

输入以下命令来设置 ModelScope Cache 环境变量:

export MODELSCOPE_CACHE=/path/to/cache/directory

其中,/path/to/cache/directory 是您希望将模型缓存到的目录路径。请确保该目录已经存在并且具有适当的权限。

保存并关闭命令提示符窗口。

现在,当您使用 ModelScope 进行模型推理时,它将自动从指定的缓存目录中加载模型。如果您需要更改缓存目录,只需重新运行上述命令即可。

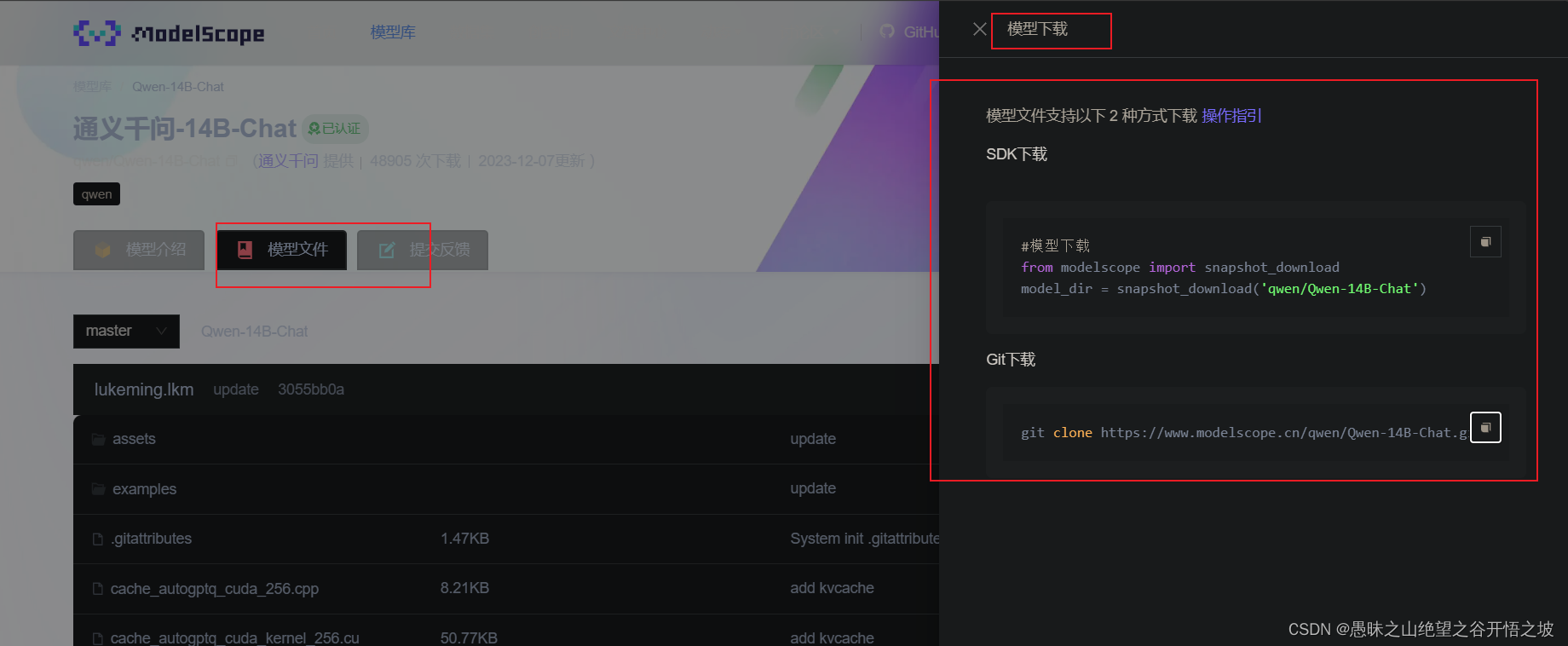

2 modelscope下载

from modelscope.models import Model

model = Model.from_pretrained('ZhipuAI/chatglm3-6b', revision='master', trust_remote_code=True)

# revision为可选参数,不指定版本会取模型默认版本,默认版本,默认版本为ModelScope library发布前最后一个版本

# 如何得到发布时间

# import modelscope

# print(modelscope.version.__release_datetime__)

#model = Model.from_pretrained('damo/nlp_structbert_word-segmentation_chinese-base')

348

348

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?