nn.Dropout

During training, randomly zeroes some of the elements of the input tensor with probability p.

在训练期间,以概率 p 将输入张量的一些元素随机归零。

Dropout Layers漏失层

nn.Dropoutnn.辍学

During training, randomly zeroes some of the elements of the input tensor with probability p.

在训练期间,以概率 p 将输入张量的一些元素随机归零。

nn.Dropout1dnn.Dropout1d

Randomly zero out entire channels.

随机将整个通道归零。

nn.Dropout2dnn.Dropout2d

Randomly zero out entire channels.

随机将整个通道归零。

nn.Dropout3dnn.Dropout3d

Randomly zero out entire channels.

随机将整个通道归零。

nn.AlphaDropoutnn.AlphaDropout

Applies Alpha Dropout over the input.

对输入应用 Alpha Dropout。

nn.FeatureAlphaDropout

nn.FeatureAlphaDropout

Randomly masks out entire channels.

随机屏蔽整个通道。Parameters p (float, optional) – probability of an element to be zero-ed. inplace (bool, optional) – If set to True, will do this operation in-place

参数 p(float,可选) - 元素被清零的概率。 inplace(布尔值,可选) - 如果设置为True,将就地执行此操作

Shape:

-

Input: (𝑁,𝐶,𝐻,𝑊)(N,C,H,W) or (𝑁,𝐶,𝐿)(N,C,L).

-

Output: (𝑁,𝐶,𝐻,𝑊)(N,C,H,W) or (𝑁,𝐶,𝐿)(N,C,L) (same shape as input).

Examples:

m = nn.Dropout2d(p=0.2) input = torch.randn(20, 16, 32, 32) output = m(input)

import torchvision.datasets

from torch import nn

import torch

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

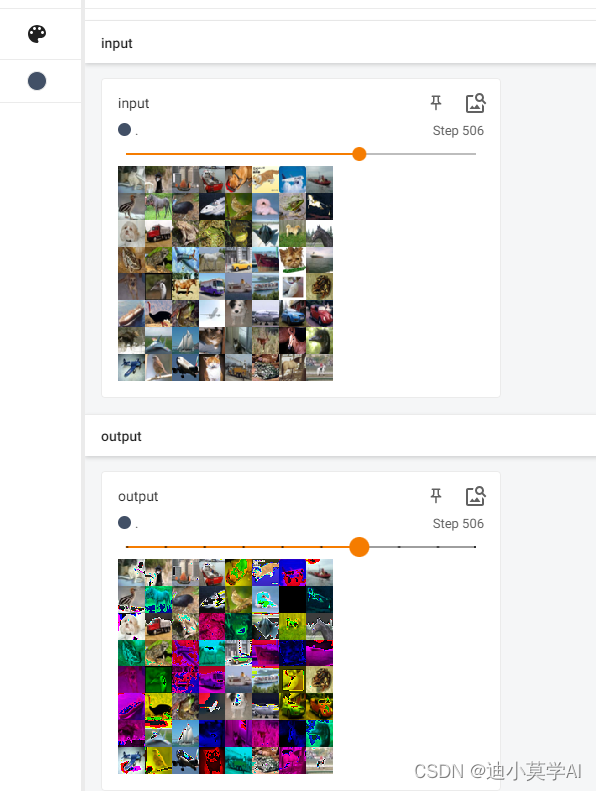

dataset= torchvision.datasets.CIFAR10("./data",train=True,transform=torchvision.transforms.ToTensor(),download=True)

dataloader=DataLoader(dataset,batch_size=64)

writer=SummaryWriter("./logs_Dropout",)

class Aoxiang(nn.Module):

def __init__(self):

super(Aoxiang, self).__init__()

self.Dropout=nn.Dropout2d(p=0.2)

def forward(self,x):

x=self.Dropout(x)

return x

aoxiang=Aoxiang()

step=1

for data in dataloader:

imgs,target=data

input=imgs

print(input)

writer.add_images("input",input,step)

output=aoxiang.forward(imgs)

# output=torch.reshape(output,(20,16,32,32))

print(output)

writer.add_images("output", output, step)

step=step+1

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?